Abstract

본 논문에서는 새로운 Transformer 구조를 제안: 인코더와 디코더로 구성된 복잡한 합성곱 신경망을 대신할 수 있는 네트워크 구조임. 순환/합성곱을 배제하고 오직 📢 어텐션 메커니즘에만 의존함. Machine Translation 작업에서의 실험 결과는 해당 모델이 품질 면에서 더 우수하고, 병렬화 또한 가능하며 훈련 시간이 크게 줄어듦을 보임. 본 연구의 모델은 WMT 2014 영어-독일어 번역 작업에서 28.4 BLEU 스코어를 달성하였음(2.5일간, 8개의 GPU 사용). 추가적으로 제한된 훈련 데이터로 영어 구문 분석에도 성공적으로 잘 일반화됨을 확인함.

1. Introduction

RNN, LSTM, 게이트 RNN은 언어 모델링 및 기계 번역과 같은 sequence 모델링과 변환 문제에서 최첨단 접근 방식으로 확립되어 왔음. Sequence 모델의 인코더/디코더 구조의 성능을 끌어올리는 노력은 계속되고 있음.

=> Sequence 모델은 일반적으로 input과 output 시퀀스 symbol의 포지션에 따라 계산함. 계산 시간 단계에 위치를 정렬하면, 이전의 hidden state hy-1 및 위치 t의 입력에 따라 숨겨진 상태 ht의 시퀀스를 생성함.

=> 최근에는 factorization trick이나 조건부 computation으로 상당한 성과를 보였음.

🚨 그러나 근본적인 제약은 여전히 남아있음.

💡 Attention Mechanism은 입력/출력 sequence의 거리와 상관없이 종속성을 모델링할 수 있도록 하여 다양한 작업에서 매력적인 시퀀스 모델의 필수 요소가 되었음.

🚨 그러나 소수의 경우를 제외하고는 이러한 어텐션 메커니즘은 RNN과 함께 사용됨.

✅ 본 연구에서는 Transformer를 제안하여, '반복'을 빼고 입력과 출력 간의 전역 종속성을 그릴 수 있는 어텐션 매커니즘에 의존함.

=> Transformer는 훈련된 후 12시간만에 8대의 GPU에서 최첨단 번역 품질에 도달할 수 있는 병렬화가 가능한 모델!

2. Background

Sequential computation을 줄이는 목표 => CNN을 기본 베이스로 하여 hidden representation을 계산함.

-> 🚨 ConvS2S는 선형적으로, ByteNet은 로그로 증가하게 되어 먼 위치 간의 종속성을 학습하는 것이 어려움.

🚨 Transformer에서는 이를 일정한 작업 수로 줄였으나 주의를 분산시켜 resolution이 떨어짐 => 💡 Multi-head Attention으로 상쇄시킴.

Self Attention은 하나의 시퀀스 내에서 서로 다른 위치를 관련시켜 표현을 계산하여 다양한 작업에서 성공적으로 사용이 되었음.

🐱 Transformer는 이러한 Self Attention에 완전히 의존하는 첫 번째 변환 모델임.

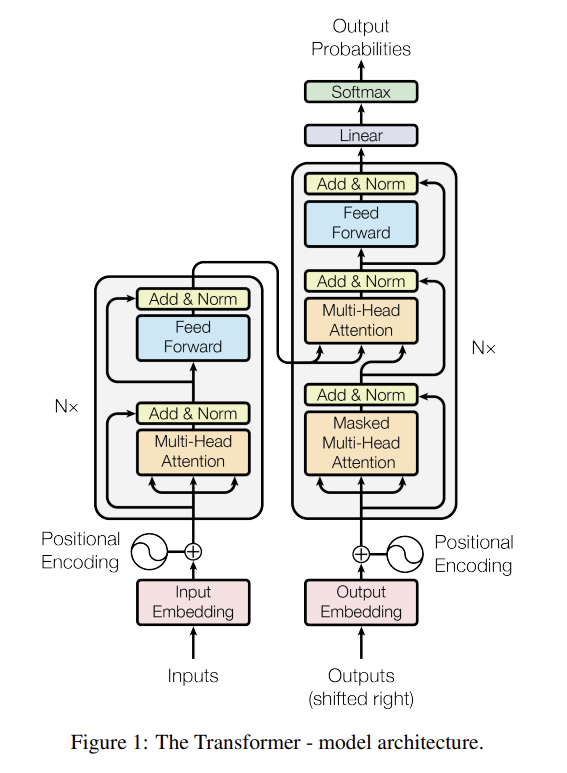

3. Model Architecture

3.1 Encoder and Decoder Stacks

대부분의 Sequence transduction 모델은 인코더-디코더 구조를 가짐.

=> 인코더는 symbol representation x를 연속적인 representation z로 매핑함. 이후에 디코더는 z를 사용하여 한 번에 하나씩 출력 시퀀스 y를 생성함.

- 각 단계에서 모델은 auto regressive하며, 다음 요소를 생성할 때는 이전에 생성된 symbol을 추가 입력으로 사용함.

Transformer는 이러한 아키텍처를 따르며 인코더-디코더 모두에 대해 self-attention과 point-wise, FC layer를 사용함.

🐵 Auto-regressive: 시퀀스 데이터를 처리하는 모델에서 현재 시점 이전의 출력이 이전 시점의 출력에 의존하는 특성을 말함.

Encoder

✅ 인코더는 N = 6개의 동일한 Layer와 2개의 sublayer로 구성되어 있음.

1) multihead self-attention 메커니즘

2) position-wise FC feed-forward 네트워크

- 각각의 sub-layer 주위에 residual connection 연결을 사용하고, 출력은 layer 정규화를 거치게 됨.

따라서 각 sub-layer의 출력은 LayerNorm(x + Sublayer(x))로 나타나며 출력 차원은 dmodel=512임.

Decoder

✅ 디코더도 N=6개의 레이어로 구성되어 있으며 2개의 하위 레이어 + 인코더 스택의 출력에 대한 multi-head attention을 수행하는 3번째 레이어

- 인코더와 마찬가지로 residual connection, layer normalization을 수행함.

+) 디코더 스택의 self-attention의 하위 레이어를 수정하여 위치가 '다음 위치'에만 관심을 가지도록 함.

💡 해당 마스킹은 출력 임베딩이 포지션 하나만큼 offset되어 있으므로 위치 i의 예측이 i보다 작은 위치의 알려진 출력에만 의존하도록 하기 위함임.

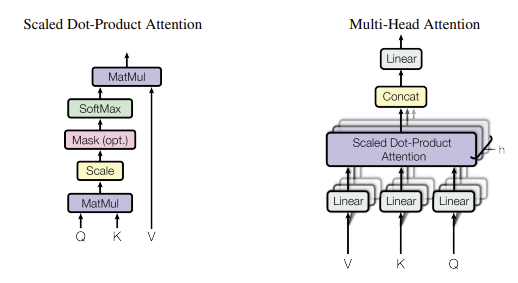

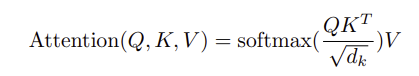

3.2 Attention

- 주어진 쿼리, 키-값 쌍(모두 벡터 형태)을 출력으로 매핑하는 함수를 Attention 함수라고 함.

=> 출력은 각 값에 가중치를 할당하여 계산되며, 이 가중치는 해당 키와의 compatibility funcion에 의해 쿼리와 계산됨.

3.2.1 Scaled Dot-Product Attention

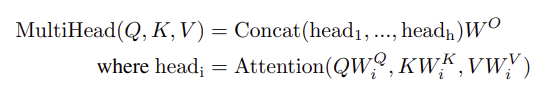

3.2.2 Multi-Head Attention

- 하나의 Attention 기능 대신, 쿼리, 키, 값을 여러 번 선형 투영하여 병렬로 Attention mechanism을 수행한 후, 최종 출력을 얻음. 이는 모델이 서로 다른 위치에서 다양한 표현 하위 공간의 정보를 공동으로 주목할 수 있게 함.

📌 Single head Attention에서는 평균화가 이러한 기능을 방해함.

3.3 Position-wise Feed-Forward Networks

✅ 본 연구에서는 인코더와 디코더의 각 레이어는 각각의 위치에 동일하게 적용되는 FC feedforward 네트워크를 포함

- 두 개의 선형 변환과 그 사이의 ReLU 활성화를 포함하며, 위치마다 동일하지만 레이어마다 다른 매개변수를 사용

=> 커널 크기 1인 두 개의 합성곱으로 설명 가능 (입력과 출력의 차원은 512이고, 내부 레이어의 차원은 2048)

3.4 Embeddings and Softmax

✅ 다른 시퀀스 변환 모델과 마찬가지로, 입력 토큰과 출력 토큰을 dmodel 차원의 벡터로 변환하기 위해 학습된 임베딩을 사용

- 디코더 출력을 토큰 확률로 변환하기 위해 학습된 선형 변환과 소프트맥스 함수도 사용

=> 본 모델에서는 두 임베딩 레이어와 소프트맥스 전 선형 변환 간에 동일한 가중치 행렬을 공유 + 임베딩 레이어에서는 이 가중치를 루트dmodel로 곱함

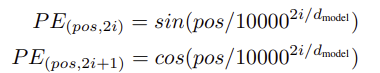

3.5 Positional Encoding

✅ 본 모델은 순환이나 합성곱을 포함하지 않기 때문에 시퀀스의 순서를 활용하려면 토큰의 상대적 또는 절대적 위치 정보를 주입해야 함!

- 이를 위해 인코더와 디코더 스택의 입력 임베딩에 "위치 인코딩"을 추가

=> 임베딩과 동일한 차원 dmodel을 가지며, 다양한 주파수의 사인 및 코사인 함수로 구성됨

- 각 차원은 사인파에 대응하며, 파장은 기하급수적으로 증가 => 모델이 상대적 위치를 쉽게 학습하도록 도움.

+) 학습된 위치 임베딩도 실험했지만 결과는 거의 동일했음.

💡 사인파 버전을 선택한 이유는 모델이 훈련 중 마주한 길이보다 더 긴 시퀀스에 대해 일반화할 수 있을 것이라 가정했기 때문임.

4. Why Self-Attention

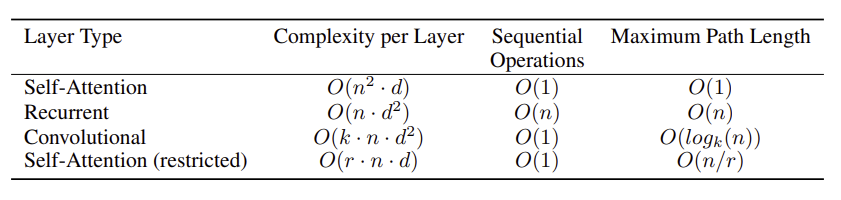

✅ Self attention 층을 일반적인 순환 및 합성곱 층과 비교하여 여러 가지 측면을 평가함.

1) 층당 총 계산 복잡도

2) 병렬화할 수 있는 계산량

- 필요한 최소 순차 연산 수로 계산함.

3) 네트워크에서 장거리 의존성 간의 경로 길이

- 시퀀스 변환 작업에서 중요한 요소로, 입력과 출력 시퀀스 간의 경로가 짧을수록 장거리 의존성을 학습하기 쉬움.

💡 Self attention 층은 일정한 수의 순차 연산으로 모든 위치를 연결하는 반면, 순환층은 O(n) 순차 연산을 필요로 함.

=> 계산 복잡도 측면에서, 시퀀스 길이 n이 표현 차원 d보다 작을 때 self attention 층이 더 빠름. 긴 시퀀스를 다룰 때는 self attention을 제한하여 최대 경로 길이를 O(n/r)로 줄일 수 있음.

📌 Self attention은 모델의 해석 가능성 또한 높일 수 있음!

- self attention 분포를 검사한 결과, 개별 attention 헤드가 다양한 작업을 수행하며 문장의 구문 및 의미 구조와 관련된 행동을 보였음.

5. Training

Abstract에서 소개한 데이터셋을 8개의 GPU, Adam Optimizer를 사용하여 훈련함.

6. Results

6.1 Machine Translation

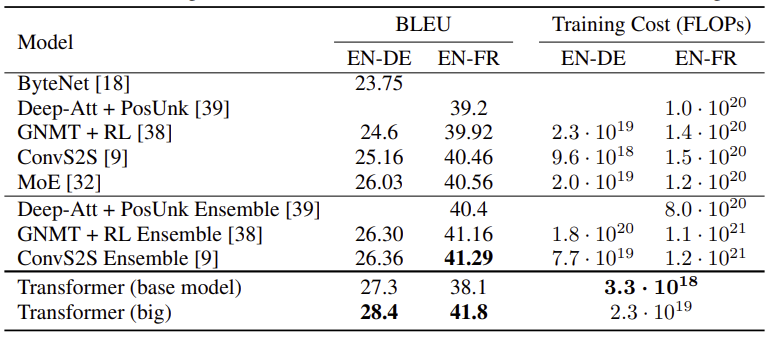

✅ WMT 2014 영어-독일어 번역 작업에서, 큰 Transformer 모델은 BLEU 점수 28.4로 이전 최고 모델들을 2.0 BLEU 이상 초과하여 새로운 최고 기록을 세움.

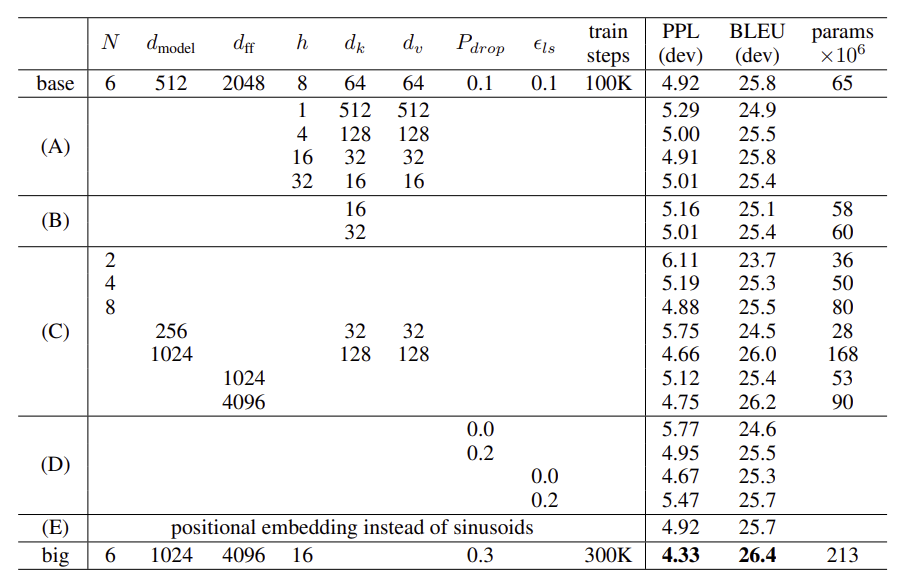

6.2 Model Variations

모델의 variation을 측정하기

위해 아래 표와 같은 실험을 진행함.

💡헤드 수와 Attention 키 및 값 차원을 변경한 결과

-

키 크기 dk를 줄이면 모델 품질이 떨어짐

-

더 큰 모델이 더 좋았고, 드롭아웃이 과적합을 피하는 데 매우 유용함을 확인

+) 사인파 위치 인코딩을 학습된 위치 임베딩으로 교체했을 때 기본 모델과 거의 동일한 결과를 보임.

7. Conclusion

뵤 연구에서는 완전히 attention에 기반한 첫 번째 시퀀스 변환 모델인 Transformer를 소개함.

Transformer는 인코더-디코더 아키텍처에서 흔히 사용되는 순환층을 다중 헤드 self-attention으로 대체하여 번역 작업에서 Transformer는 순환층이나 합성곱층 기반 아키텍처보다 훨씬 빠르게 훈련됨.

영어-독일어 작업에서는 이전의 모든 보고된 앙상블 모델들을 능가함.

Transformer를 확장하고, 이미지, 오디오, 비디오와 같은 큰 입력과 출력을 효율적으로 처리하기 위해 attention 메커니즘을 연구할 것임.