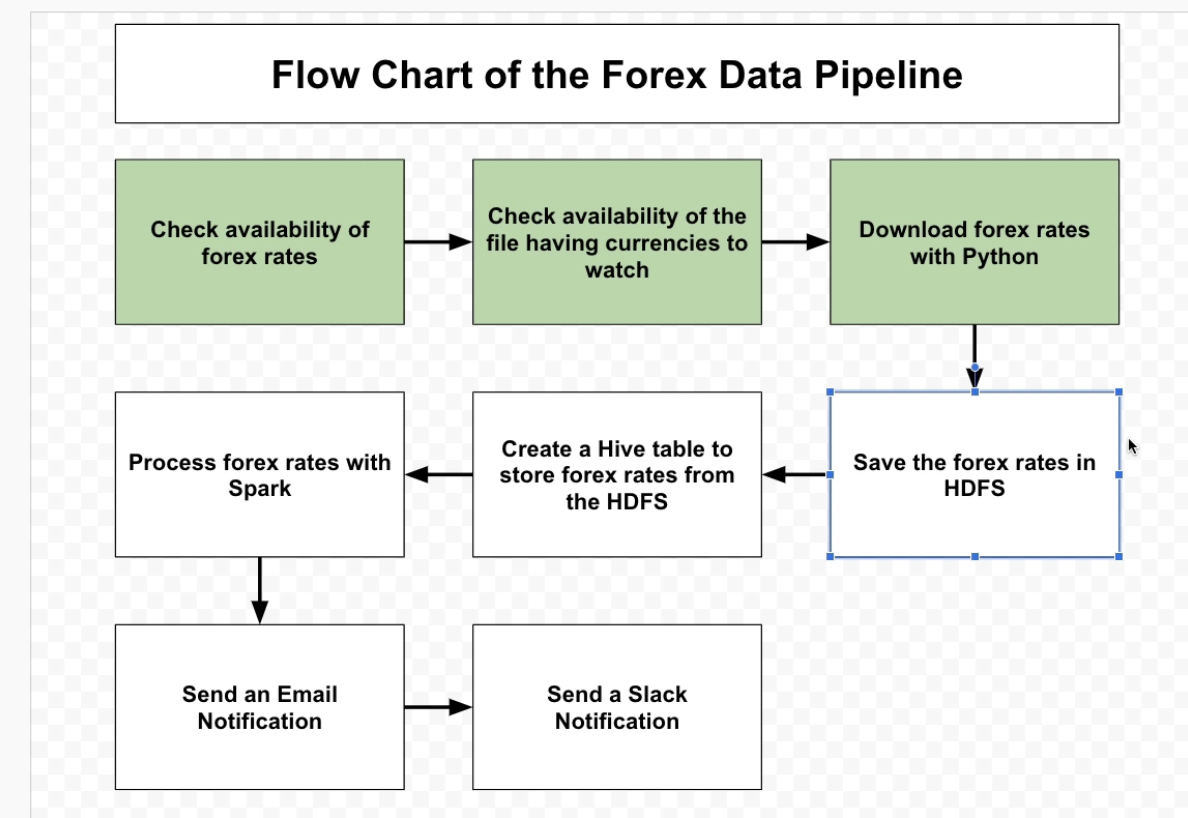

만약 파일이 기가바이트, 테라바이트 단위라면, 해당 파일을 분산 파일 시스템에 저장하고 싶을 것입니다. 분명 로컬 PC로는 한계가 있습니다.

Local to HDFS

- 코드 작성

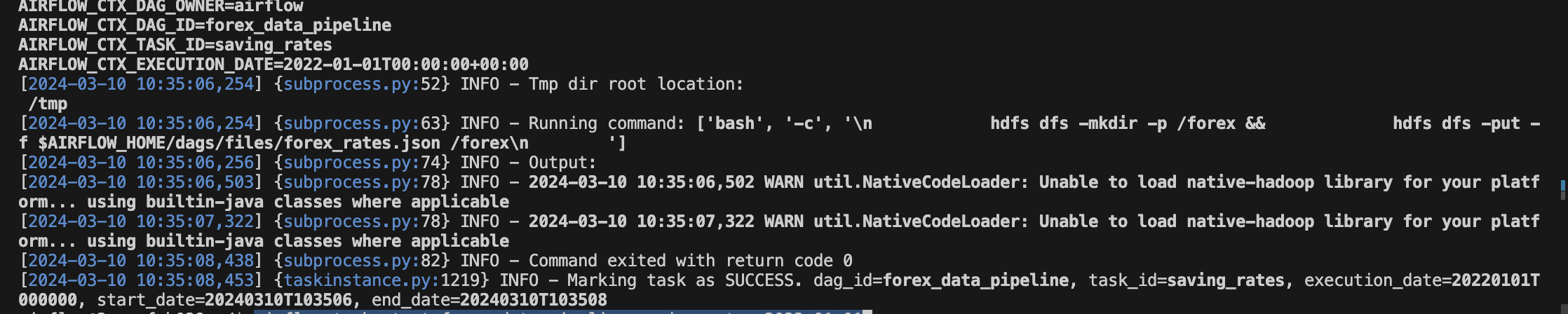

from airflow.operators.bash import BashOperator

# 로컬 폴더의 파일을, HDFS의 forex 폴더에 넣습니다.

saving_rates = BashOperator(

task_id="saving_rates",

bash_command="""

hdfs dfs -mkdir -p /forex && \

hdfs dfs -put -f $AIRFLOW_HOME/dags/files/forex_rates.json /forex

""",

)- 에어플로우 컨테이너 접속 후 테스트

airflow tasks test forex_data_pipeline saving_rates 2022-01-01

HUE

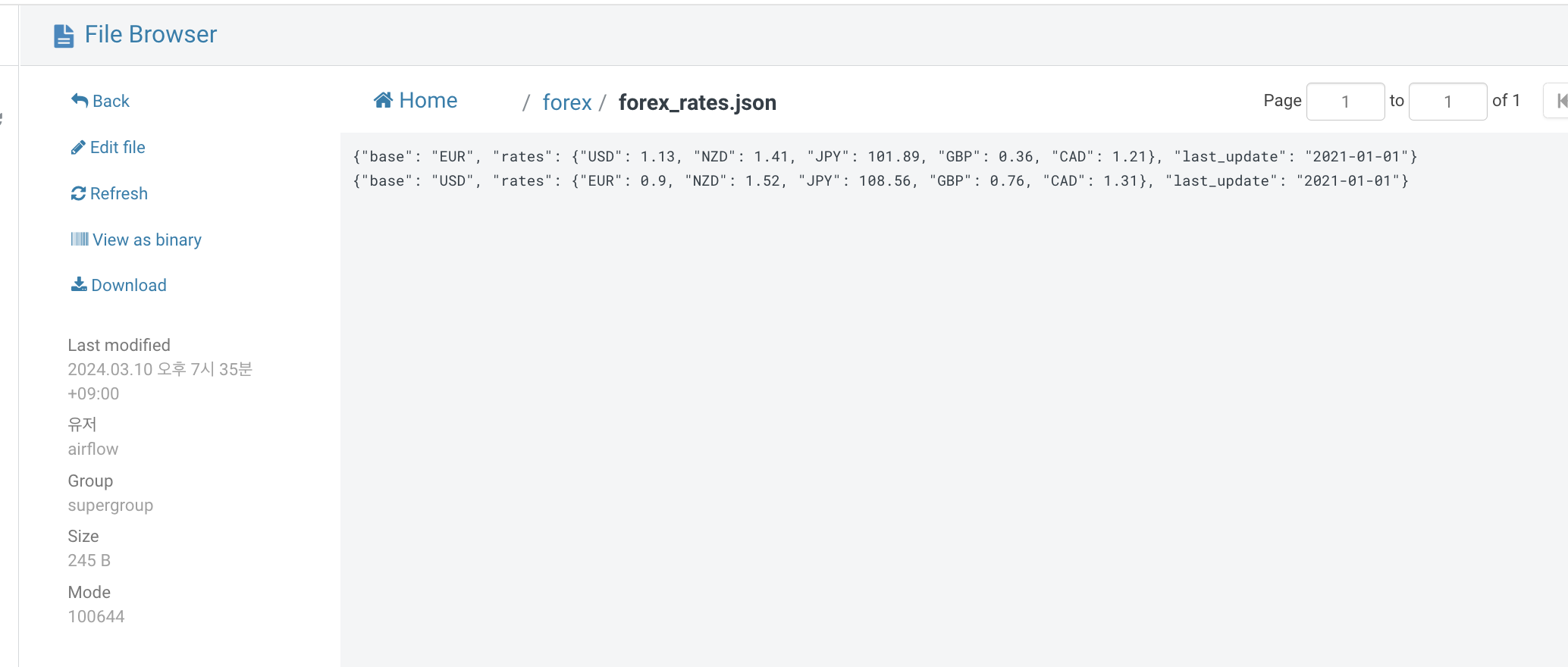

Hue는 HDFS에 있는 파일에 쿼리 요청을 할 수 있고, 또한 HDFS의 파일을 UI로 편리하게 볼 수 있습니다.

localhost:32762

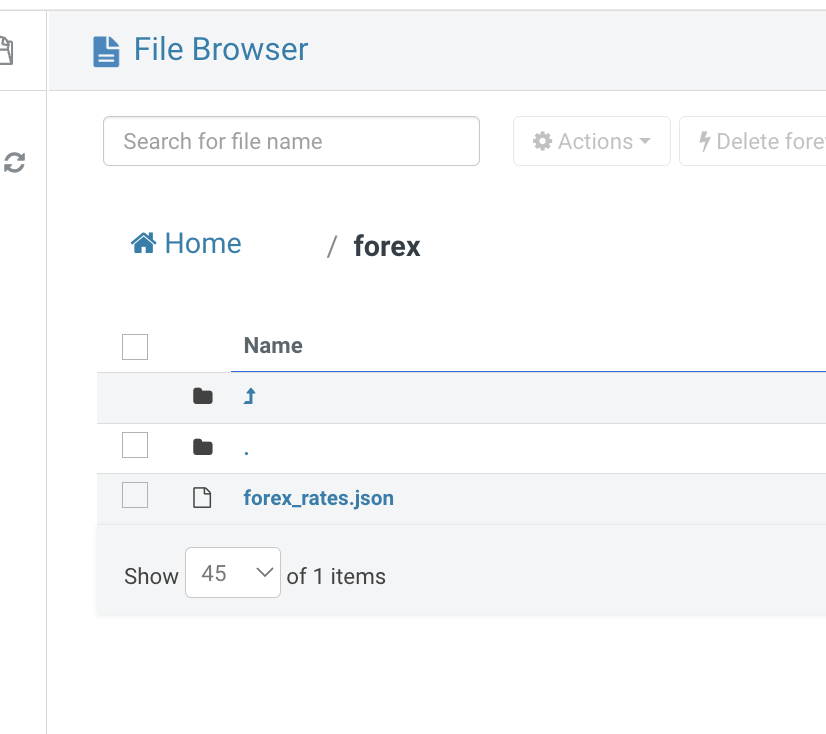

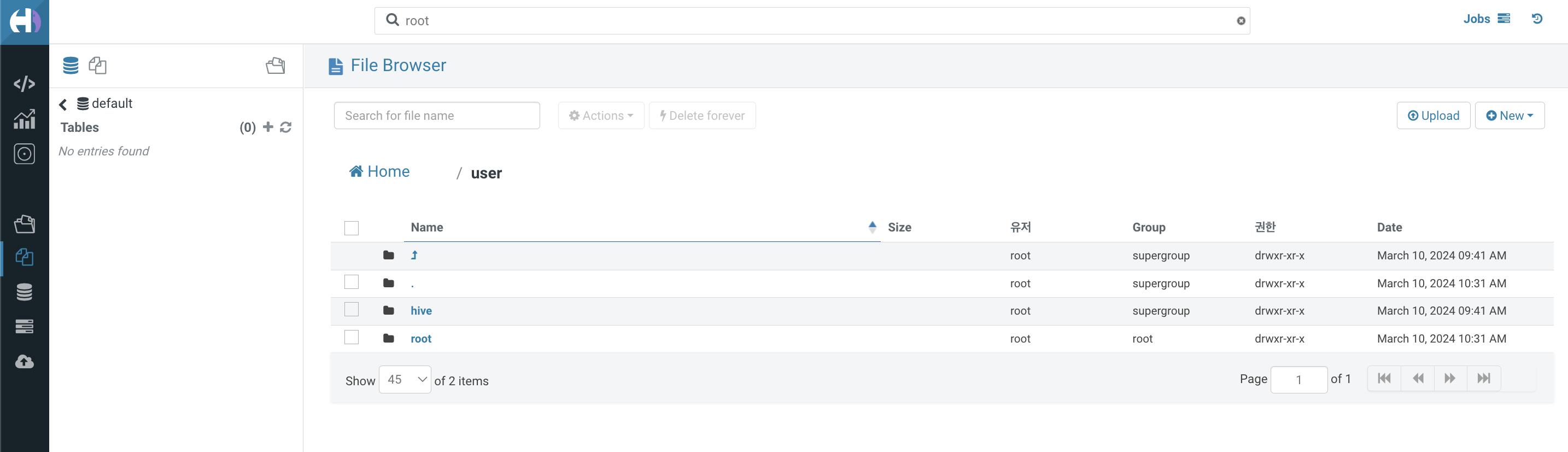

HDFS에 있는 파일을 확인해봅니다.