Gaussian Process

Recent Uncertainty Study

-

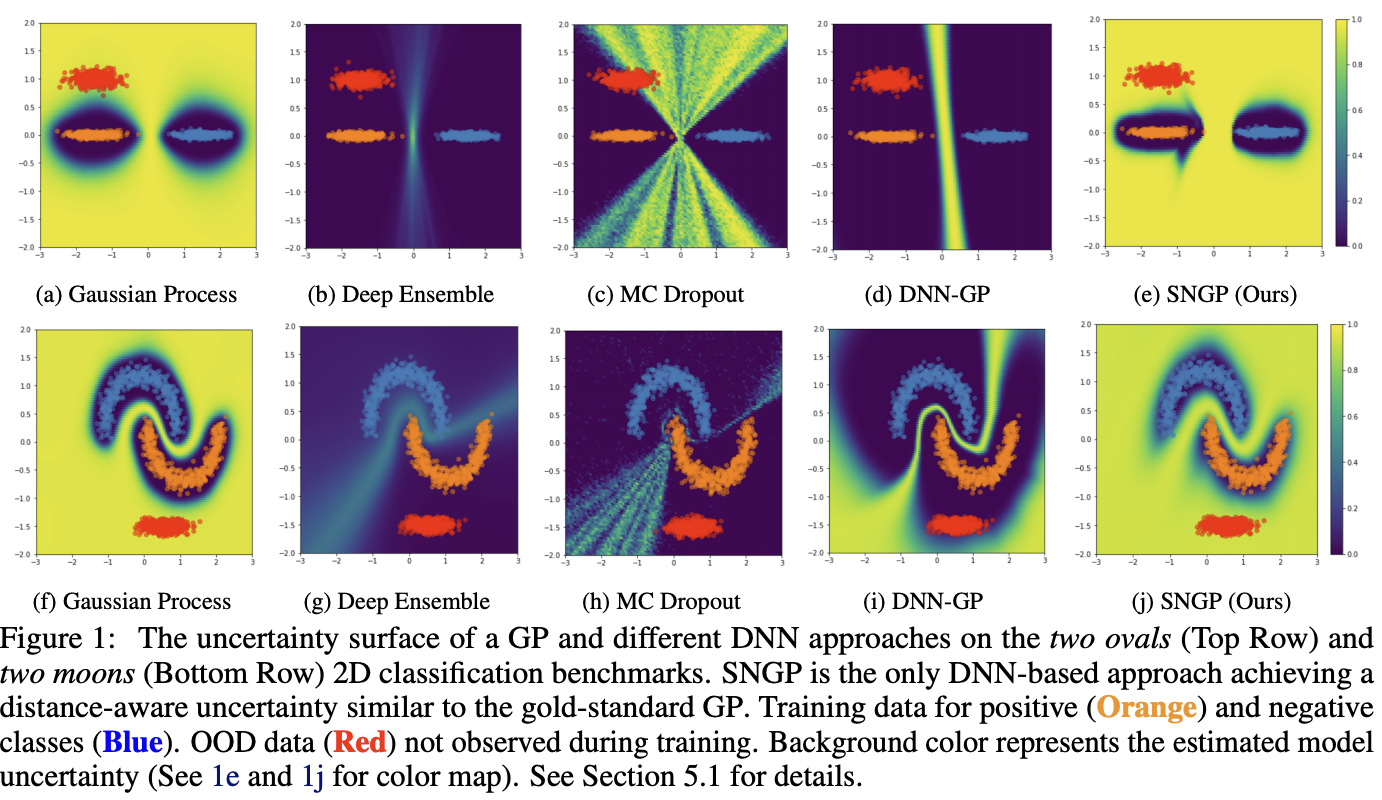

single forward pass에서 uncertainty를 예측하는 Deep Deterministic Uncertainty가 (비교적) 최근의 uncertainty (혁신적인) 트렌드라고 하더라.

-

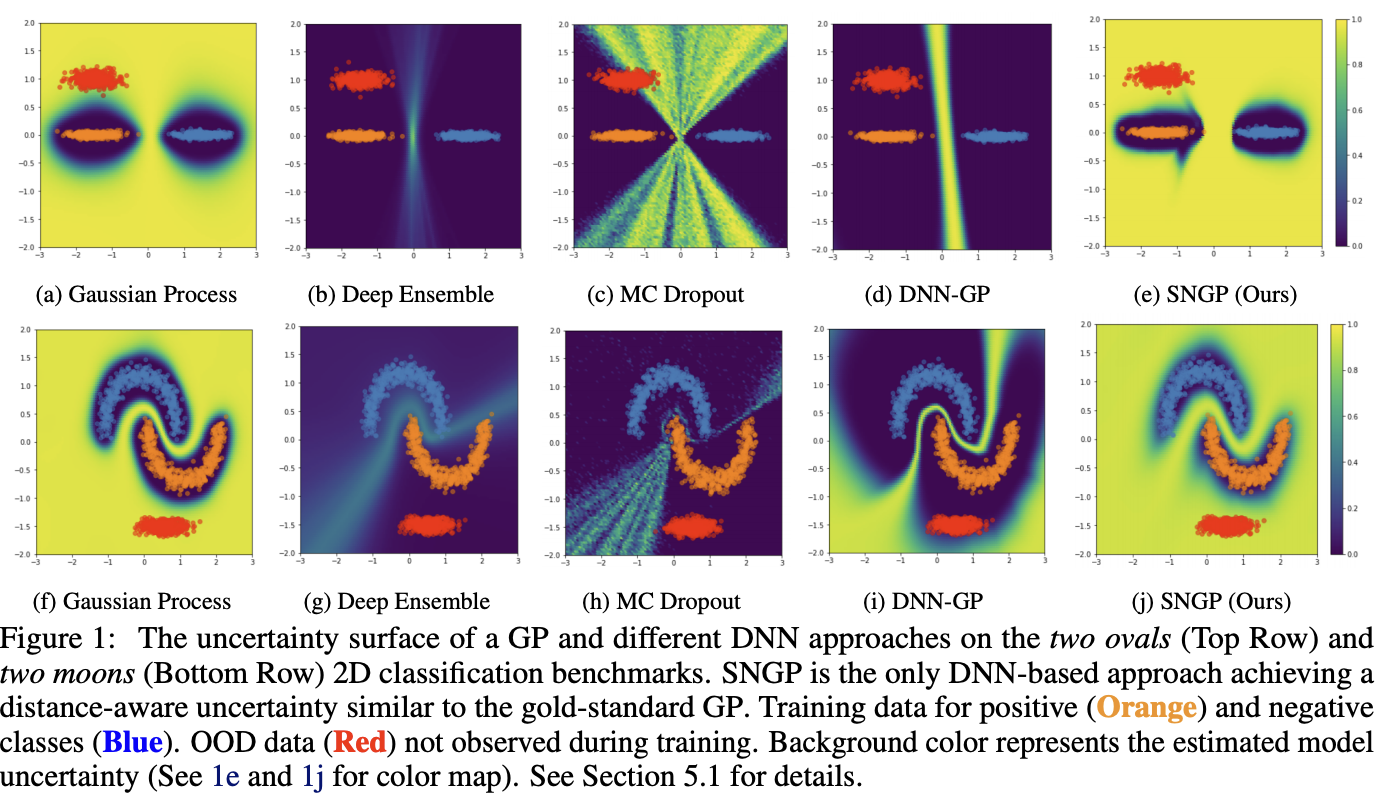

Deep Ensemble, MC Dropout, Bayesian 방식에 비해 OOD Detection을 잘한다는 특징들이 있음.

-

논문 리스트

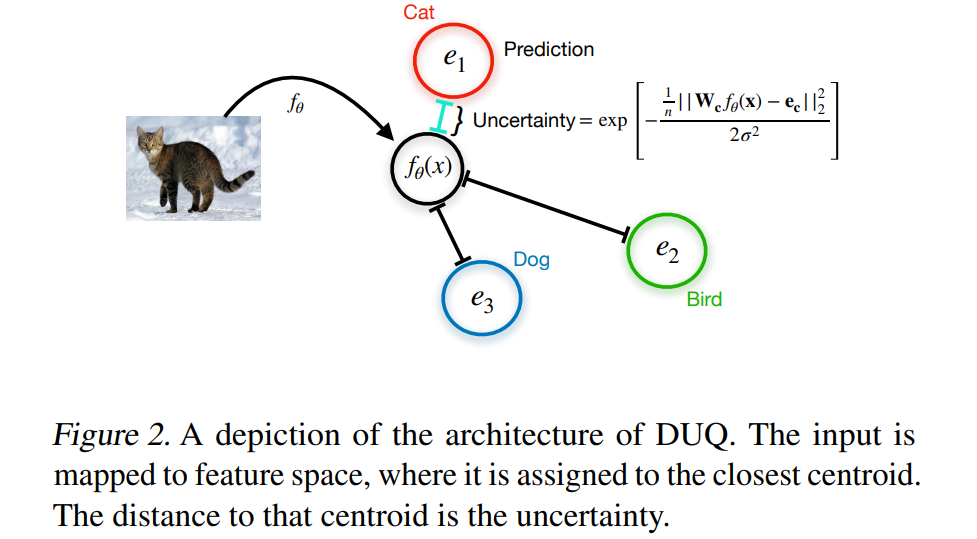

- DUQ: Uncertainty Estimation Using a Single Deep Deterministic Neural Network (ICML 2020/463 cite)

- SNGP: Simple and Principled Uncertainty Estimation with

Deterministic Deep Learning via Distance Awareness (NIPS 2020/ 425 cite)

- DDU: Deep Deterministic Uncertainty: A New Simple Baseline (CVPR2023/42 cite/21년 2월 아카이빙..?) -

DUQ, DDU는 Yarin Gal 논문임.

-

인용수만 봐도 좀 처참한듯? 다들 CIFAR10 같은 데이터셋에서 큰 개선이 있었지만 다른 분야로의 확장이 더 많이 연구되지 더 깊이있게는 잘 안하는거 같기두. (태스크별 domain knowledge가 중요한거 같긴함). 물론 저 논문들을 인용한 GS논문은 전혀 없음.

-

DUQ:

- DUQ는 classification을 학습하면서 각 class의 feature vector (centroids) 들을 저장함. (EMA update)

- 모델을 RBF model(1998, LeCun)으로 설계; 모델의 output (feature vector)와 centroid사이의 distance를 RBF kernel distance로 정의해서 distance를 minimize하게 함.

- 그럼, uncertainty를 output인 feature vector와 가장 가까운 centroid의 distance로 측정가능하며, 기존 방식들(softmax)보다 OOD를 잘 인지한다고 함.

- 추가적으로 input 변화에 대한 민감도(sensitivity)를 보정하기 위해 그래디언트 페널티 (regualrization)을 적용. Feature collapse - OOD sample이 ID feature space로 mapping 되는 현상- 를 보정하기 위해 gradient가 너무 커지거나 작아지지 않도록 하는 normalization

- epistemic aleatoric 둘다 포함하는 uncertainty이며, formal하게 disentangle하기 어렵다고 함. 다만, data point가 feature space상에서 모든 centroid랑 멀다면 epistemic이라고 볼 수 있고(OOD느낌), centroid들 사이에서 여러 centroid와 모두 가깝다면(ambiguaty) aleatoric이라고 볼 수 있음.

-

SNGP:

- 위 그림처럼, Gaussian Process는 In-distribution data와 멀어지면 uncertainty가 증가하나 MC dropout/Deep Ensemble은 그렇지 않음.

- DNN의 마지막 layer를 Fully connected layer 대신 GP로 교체 & GP의 covariance matrix는 RBF kernel을 이용

- http://dsba.korea.ac.kr/review/?mod=document&uid=1413 <- 참고

- 가우시안 프로세스 잘 설명 : https://aistory4u.tistory.com/entry/%EA%B0%80%EC%9A%B0%EC%8B%9C%EC%95%88-%ED%94%84%EB%A1%9C%EC%84%B8%EC%8A%A4-%ED%9A%8C%EA%B7%80

-

DDU

https://stopspoon.tistory.com/78

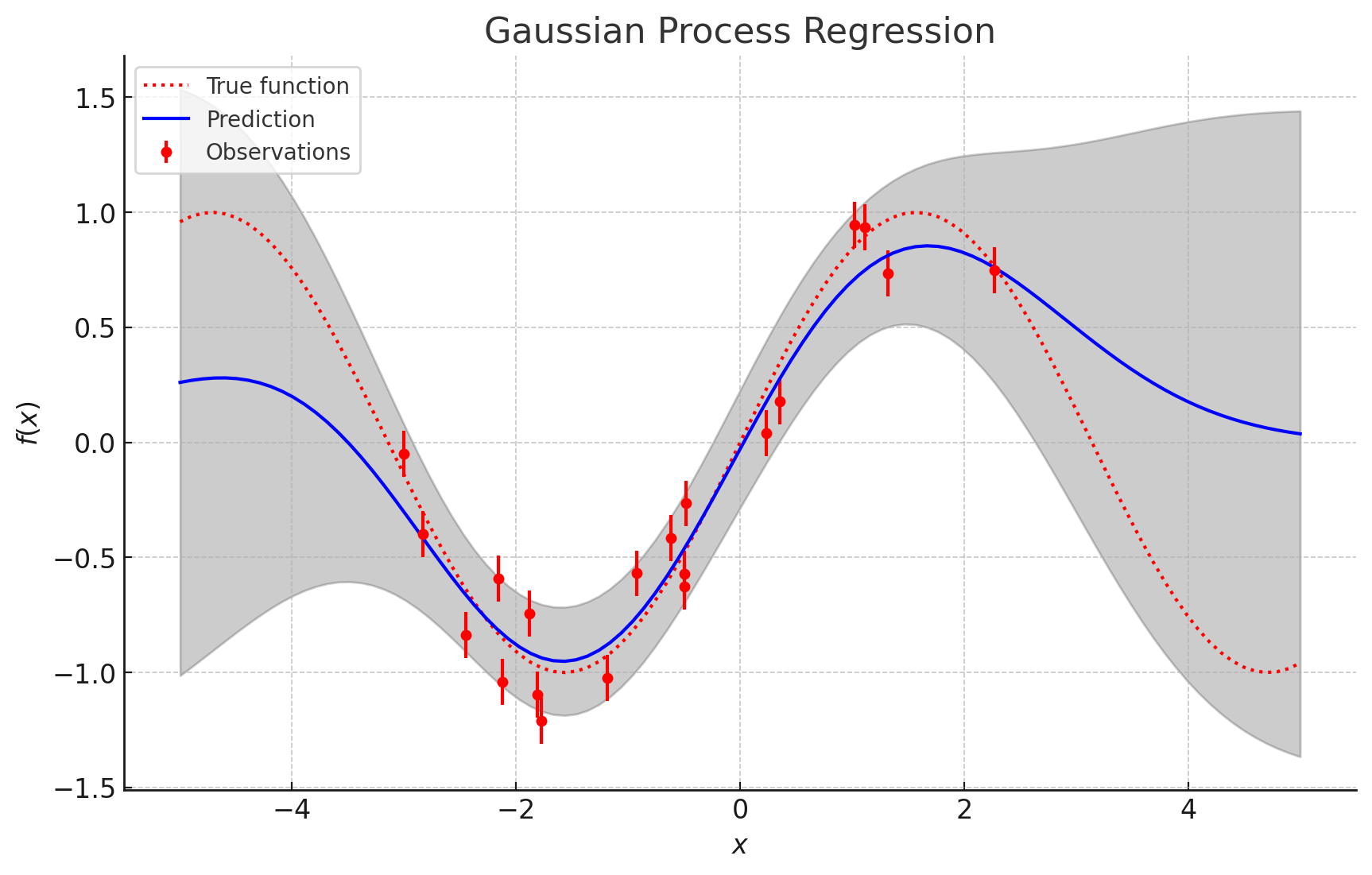

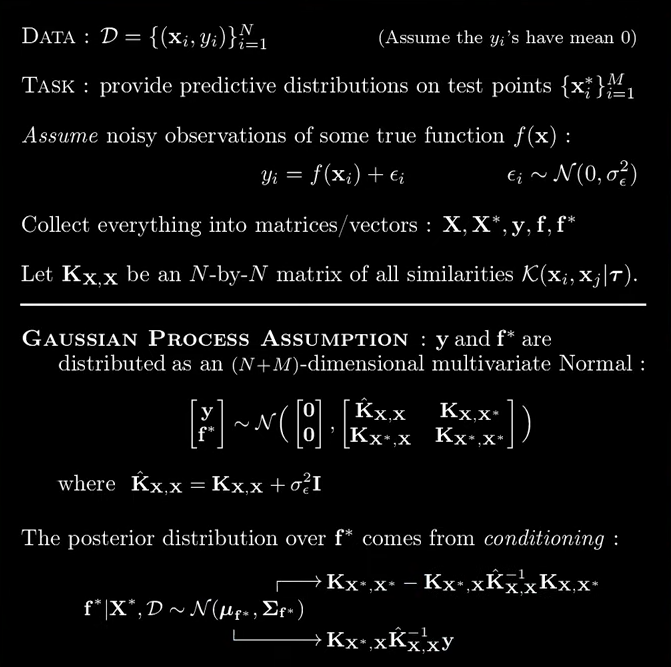

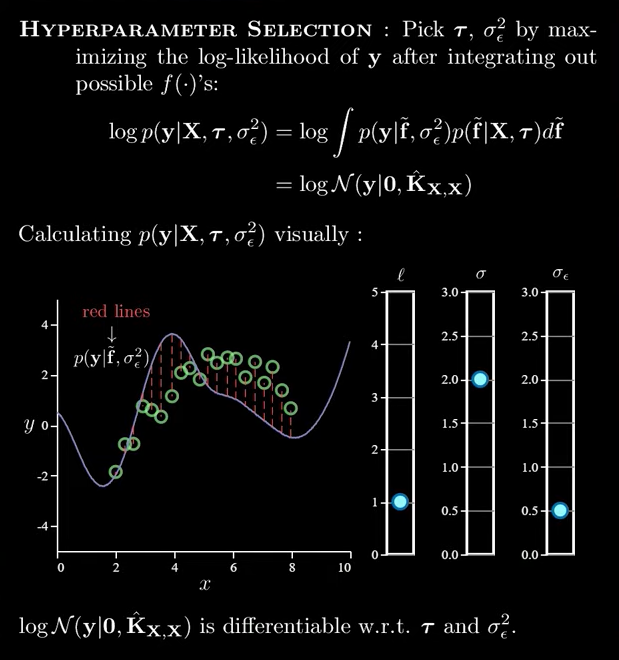

Gaussian Process (GP)

참고자료들

GP

- 과거 SVM같은 기술들 나올때 나온 오래된 traditional machine learning 기법임

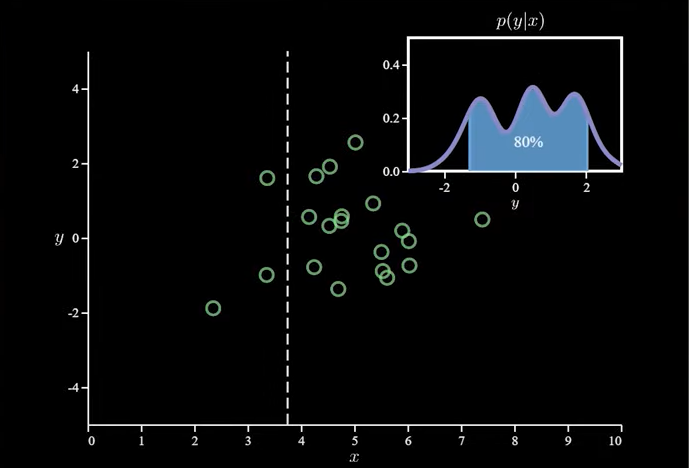

- given x에 대한 y의 예측이 point estimation이 아니고 distribution estimation임. 즉, 모델 예측 뿐만 아니라 uncertainty도 동시에 추정함

- Gaussian Process는 여러 개의 가우시안 분포를 합쳐서, 함수 형태를 추정하는 방법. 관찰된 데이터들로부터 전체적인 함수의 모양을 예측

- 중요한가정: 두 input x와 x'이 굉장히 가깝다면, output y와 y'또한 굉장히 가까울것이다 (smoothness)

- kernel function: 두 input x와 x'사이의 유사도를 측정하는 function , hyperparameters 에 의해서 결정됨. 보통 RBF kernel를 씀

- GP의 학습과정은 observed data로 kernel function의 hyperparameter를 MLE로 fitting하는 과정

- train dataset으로 kernel이 학습되면, test data points에 대해서 Y의 mean과 variance 예측가능

|  |

|---|

- RBF등의 kernel들은 high-dimensional에서는 잘 동작하지 않을 수 있다고 함 -> deep network

SNGP (NIPS2020)

- Bayesian이나 Deep Ensemble은 학습 및 추론이 복잡하고 오래걸리거나 많은 메모리를 요구함. 따라서 single DNN으로만 uncertainty를 추정하는 방법이 필요하다고 함.

- 'training data와 멀어지면 uncertainty가 높아져야 한다.' : distance awareness가 메인

- Spectral-normalized Neural Gaussian Process (SNGP) 방법 제안; DNN의 마지막 layer를 MLP 대신에 Gaussian Process (RBF kernel)를 적용함. 동시에 DNN이 distance awareness하도록 weight normalization 등을 사용;

- Wide-ResNet 이나 BERT 처럼 최근의 vision, language모델에 적용했을때, ECE, accuracy, OOD detection 등에서 다른 single model approach를 뛰어넘으며, Deep Ensemble이랑 견줄만함.

3DGS + Gaussian Process

- Touch-GS

: Optical tactile sensors를 추가적으로 활용해서 3DGS 수행

: 저 센서로 SDF를 할때 GPIS(Gaussian Process Implicit Surface)라는 방식을 활용하는듯

: gaussian process implicit surface (GPIS) models have been used in robotics as probabilistic representations for both object shape estimation as well as environmental mapping. - 3D Uncertain Implicit Surface Mapping using GMM and GP (2024.03)

: We map uncertain 3D continuous signed-distance fields in urban areas with probabilistic inferences using laser scanning point clouds, which can be applied in various downstream tasks and can be updated probabilistically.

: The experimental results demonstrate the value of the uncertainty measures, showing that estimations with lower uncertainty lead to superior surface reconstruction outcomes.