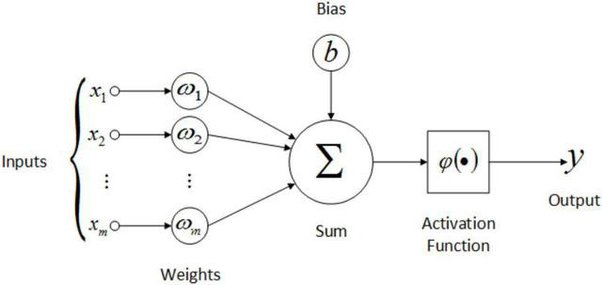

활성화 함수(Activation Function)

- 활성화 함수는 이전 layer에 있는 노드 값이 다음 layer에 있는 노드값으로 전달될 때, non-linear한 형태로 변환해 주는 역할을 함.

https://www.quora.com/What-is-activation-function-and-how-many-types-of-it-Which-one-is-the-best

- 활성화 함수를 사용하는 이유: 딥러닝 모델의 표현력을 향상시켜주기 위해

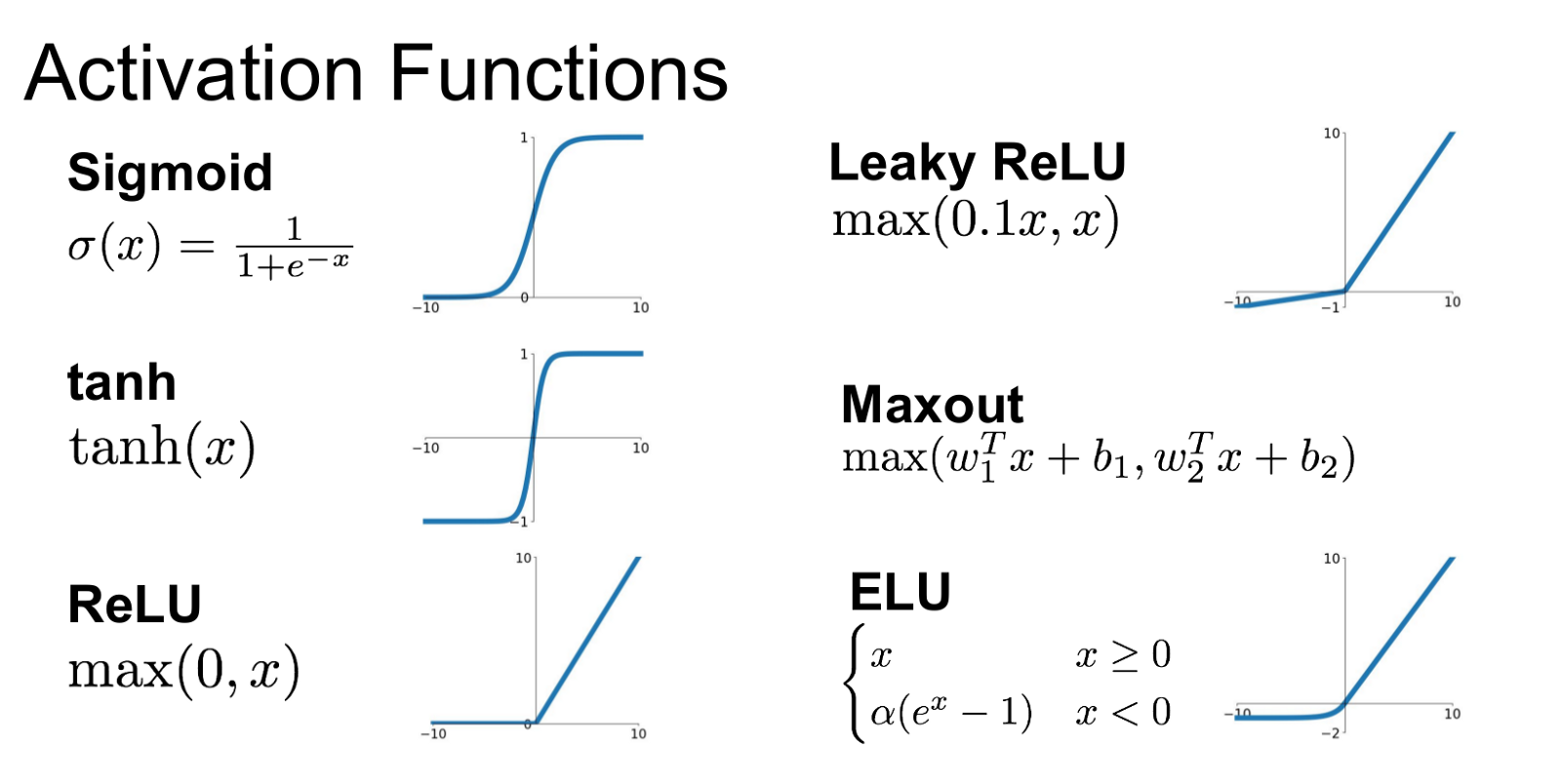

신경망의 활성화 함수는 '비선형 함수'를 사용함

비선형 함수를 사용하는 이유

- 1) 신경망의 표현성을 높이기 위해(현실에서의 대부분의 문제는 비선형 문제)

- 2) 선형 함수 자체가 심층 신경망에 큰 도움이 되지 않음(신경망을 깊게 쌓는 의미가 희석됨)

https://analyticsindiamag.com/what-are-activation-functions-and-when-to-use-them/

-

대표적인 활성화 함수는 'sigmoid function'인데, Layer가 깊어질 수록 Gradient Vanishing 현상 발생 문제가 발생할 수 있어 잘 사용되지 않음.

-

ReLU는 sigmoid function의 문제를 어느정도 해결한 활성화 함수로 Gradient Vanishing가 일어나는 것을 일부 완화시켜줌