학습률 감소/계획법(Learning rate Decay/Scheduling)

학습률(Learning rate)

- 학습률이란 매 가중치에 대해 구해진 기울기 값을 얼마나 경사 하강법에 적용할 지를 결정하는 하이퍼파라미터

학습률 감소(Learning rate Decay)

- Adagrad, RMSprop, Adam 과 같은 주요 옵티마이저에 이미 구현되어 있기 때문에 쉽게 적용가능

학습률 계획법(Learning rate Scheduling)

- .experimental 내부의 함수를 사용하여 설계 가능

가중치 초기화(Weight Initialization)

Sigmoid ⇒ Xavier 초기화를 사용하는 것이 유리ReLU ⇒ He 초기화사용하는 것이 유리

머신러닝으로서의 딥러닝

- 과적합(Overfitting)

- 가중치 감소(Weight Decay)

- 라쏘, 릿지

- Dropout (드롭아웃)

- 이터레이션 마다 레이어 노드 중 일부 x- 매번 다른 노드 사용

- Early Stopping (조기 종료)

- 가중치 감소(Weight Decay)

커널 - 레이어 가중치에 패널티

액티비티 - 레이어 출력에 패널티

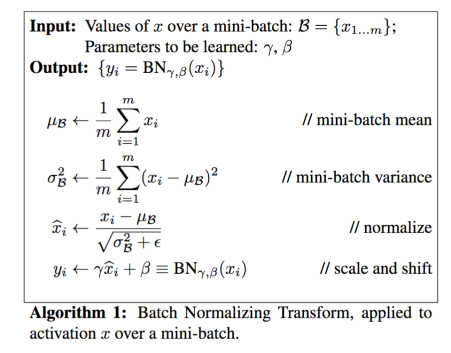

배치정규화(Batch normalization)

- https://arxiv.org/pdf/1502.03167.pdf (배치정규화 논문)

배치 정규화는 학습 시의 미니배치를 한 단위로 정규화를 하는 것으로 분포의 평균이 0, 분산이 1이 되도록 정규화하는 것- 학습 속도가 개선된다 (학습률을 높게 설정할 수 있기 때문)

- 가중치 초깃값 선택의 의존성이 적어진다 (학습을 할 때마다 출력값을 정규화하기 때문)

- 과적합(overfitting) 위험을 줄일 수 있다 (드롭아웃 같은 기법 대체 가능)

- Gradient Vanishing 문제 해결

- Input으로 사용된 미니배치의 평균과 분산을 계산

- hidden layer의 활성화값/출력값에 대해서 평균이 0, 분산이 1이 되도록 정규화

- 그럼으로써 데이터 분포가 덜 치우치게 되고 배치 정규화 단계마다 확대scale와 이동shift 변환(transform)을 수행