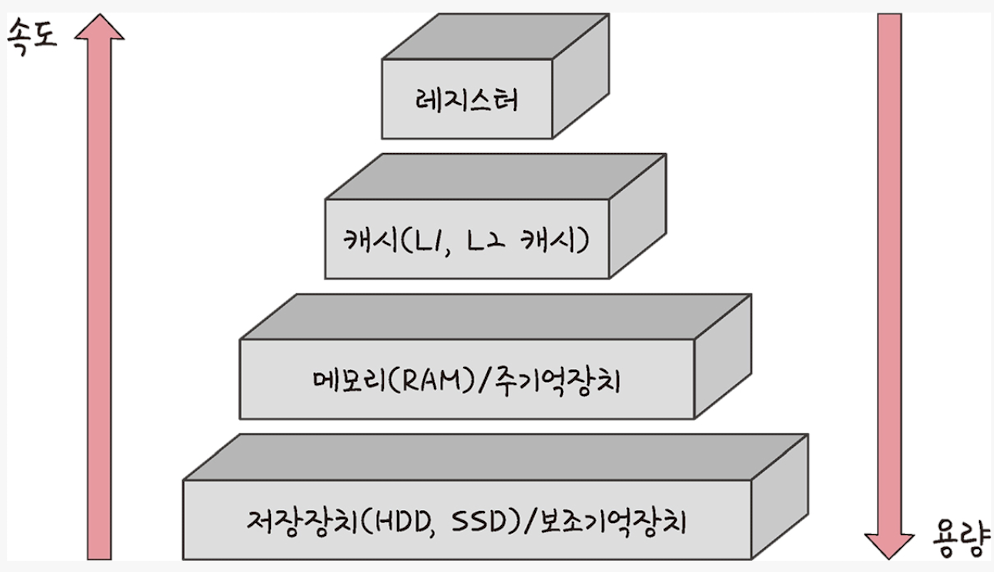

메모리 계층

레지스터, 캐시, 메모리, 저장장치로 구성

- 레지스터: CPU 안에 있는 작은 메모리. 휘발성, 가장 빠른 속도, 가장 적은 기억 용량

- 캐시: L1, L2 캐시를 지칭. 휘발성, 빠른 속도, 적은 기억 용량 (L3 캐시도 있음)

- 주기억장치: RAM 지칭. 휘발성, 보통 속도, 보통 기억 용량

- 보조기억장치: HDD, SSD 지칭. 비휘발성, 낮은 속도, 많은 기억 용량

계층 위로 올라갈수록 가격이 비싸지고 용량이 작아지고 속도가 빨라짐

RAM

램은 하드디스크로부터 일정량의 데이터를 복사해서 이를 저장하고 필요시마다 CPU에 빠르게 전달

캐시

데이터를 미리 복사해놓는 임시 저장소이자 빠른 장치와 느린 장치에서 속도 차이에 따른 병목 현상을 줄이기 위한 메모리

캐싱 계층: 속도 차이를 해결하기 위해 계층과 계층 사이에 있는 계층

지역성의 원리

캐시를 직접 설정할 때는 지역성에 따라 자주 사용하는 데이터를 기반으로 함

시간 지역성

최근 사용한 데이터에 다시 접근하려는 특성

공간 지역성

최근 접근한 데이터를 이루고 있는 공간이나 그 가까운 공간에 접근하는 특성

캐시히트와 캐시미스

캐시히트: 캐시에서 원하는 데이터를 찾은 것

캐시미스: 캐시에 해당 데이터가 없어 주메모리에서 데이터를 찾아오는 것

캐시매핑

캐시가 히트되기 위해 매핑하는 방법

- 직접 매핑: 처리가 빠르지만 충돌 발생이 잦음

- 연관 매핑: 관련 있는 캐시와 메모리를 매핑함. 충돌이 적지만 속도가 느림

- 집합 연관 매핑: 직접 매핑과 연관 매핑을 합침. 검색이 효율적

웹 브라우저의 캐시

대표적인 소프트웨어 캐시: 쿠키, 로컬 스토리지, 세션 스토리지

→ 사용자의 커스텀한 정보나 인증 모듈 관련 사항들을 웹 브라우저에 저장해서 추후 서버에 요청할 때 자신을 나타내는 아이덴티티나 중복 요청 방지를 위해 사용되며, origin에 종속됨

| 저장 용량 | 만료기한 여부 | 만료기한 지정 주체 | 수정 주체 | HTML5 지원 브라우저 필수 | |

|---|---|---|---|---|---|

| 쿠키 | 4KB | O | 둘다(보통 서버) | ||

| 로컬 스토리지 | 5MB | X | 클라이언트 | O | |

| 세션 스토리지 | 5MB | X | 클라이언트 | O |

데이터베이스의 캐싱 계층

데이터베이스 시스템을 구축할 때도 메인 데이터베이스 위에 Redis 데이터베이스 계층을 캐칭 계층으로 둬서 성능을 향상시키기도 함

메모리 관리

가상 메모리

컴퓨터가 실제로 이용 가능한 메모리 자원을 추상화하여 사용자들에게 매우 큰 메모리로 보이게 만드는 것

- 실제 주소(physical address): 실제 메모리상에 있는 주소

- 가상 주소(logical address): 메모리관리장치에 의해 실제 주소로 변환됨

가상 주소와 실제 주소가 매핑되어있고 프로세스의 주소 정보가 들어있는 '페이지 테이블'로 관리됨

속도 향상을 위해 TLB 사용

*TLB: 메모리와 CPU 사이에 있는 주소 변환을 위한 캐시로, 페이지 테이블에 있는 리스트를 보관하며 CPU가 페이지 테이블까지 가지 않도록 하여 속도를 향상

스와핑

가상 메모리에는 존재하지만 실제 메모리인 RAM에는 없는 데이터나 코드에 접근할 경우 페이지 폴트 발생

-> 이때 메모리에서 당장 사용하지 않는 영역을 하드디스크로 옮기고, 하드디스크의 일부분을 메모리처럼 불러와 쓰는 것을 스와핑이라고 함

페이지 폴트

프로세스의 주소 공간에는 존재하지만 지금 이 컴퓨터의 RAM에는 없는 데이터에 접근했을 때 발생

- 어떤 명령어가 유효한 가상 주소에 접근했으나 해당 페이지가 없다면 트랩이 발생되어 운영체제에 알림

- 운영체제는 실제 디스크로부터 사용하지 않은 프레임을 찾음

- 해당 프레임을 실제 메모리에 가져와서 페이지 교체 알고리즘을 기반으로 특정 페이지와 교체 (이때 스와핑)

- 페이지 테이블을 갱신시킨 후 해당 명령어를 재시작

*페이지: 가상 메모리를 사용하는 최소 크기 단위

*프레임: 실제 메모리를 사용하는 최소 크기 단위

스레싱

- 메모리의 페이지 폴트율이 높은 것을 의미

- 컴퓨터의 심각한 성능 저하를 초래함

- 메모리에 너무 많은 프로세스가 동시에 올라가게 되면 스와핑이 많이 일어나서 스레싱이 발생함

- 페이지 폴트 발생

- CPU 이용률 낮아짐

- 운영체제는 가용성을 높이기 위해 더 많은 프로세스를 메모리에 올림

-> 악순환 반복으로 스레싱 발생

해결 방법: HDD를 SSD로 교체, 작업 세트, PFF

작업 세트

프로세스의 과거 사용 이력인 지역성을 통해 결정된 페이지 집합을 만들어서 미리 메모리에 로드

-> 탐색에 드는 비용과 스와핑을 줄일 수 있음

PFF(Page Fault Frequency)

페이지 폴트 빈도를 조절하는 방법으로, 상한선과 하한선을 만듦

상한선에 도달하면 프레임을 늘리고, 하한선에 도달하면 프레임을 줄임

메모리 할당

시작 메모리 위치, 메모리의 할당 크기를 기반으로 프로그램에 메모리를 할당함

연속 할당

메모리에 연속적으로 공간을 할당하는 방식

고정 분할 방식

메모리를 미리 나누어 관리하는 방식

융통성이 없고, 내부 단편화 발생

가변 분할 방식

매 시점 프로그램의 크기에 맞게 동적으로 메모리를 나눠 사용

내부 단편화는 발생하지 않고, 외부 단편화는 발생할 수 있음

| 이름 | 설명 |

|---|---|

| 최초적합 | 위쪽이나 아래쪽부터 시작해서 홀을 찾으면 바로 할당 |

| 최적적합 | 프로세스의 크기 이상인 공간 중 가장 작은 홀부터 할당 |

| 최악적합 | 프로세스의 크기와 가장 많이 차이가 나는 홀에 할당 |

*내부 단편화: 메모리를 나눈 크기보다 프로그램이 작아서 들어가지 못하는 공간이 많이 발생하는 현상

*외부 단편화: 메모리를 나눈 크기보다 프로그램이 커서 들어가지 못하는 공간이 많이 발생하는 현상

*홀: 할당할 수 있는 비어 있는 메모리 공간

불연속 할당

현대 운영체제가 쓰는 방법

페이징

동일한 크기의 페이지 단위로 나누어 메모리의 서로 다른 위치에 프로세스를 할당함

주소 변환이 복잡함

세그멘테이션

페이지 단위가 아닌 의미 단위 '세그먼트'로 나눔

공유와 보안 측면에서 장점을 가지지만, 홀 크기가 균일하지 않음

페이지드 세그멘테이션

프로그램을 세그먼트로 나눠 공유나 보안 측면에 강점을 두고, 동일한 크기의 페이지 단위로 나눔

페이지 교체 알고리즘

메모리가 한정되어 있기 때문에 스와핑이 일어나는데, 스와핑이 많이 일어나지 않도록 설계해야 함

-> 페이지 교체 알고리즘 기반

오프라인 알고리즘

먼 미래에 참조되는 페이지와 현재 할당하는 페이지를 바꾸는 알고리즘

-> 사용할 수 없으나 가장 좋은 알고리즘이므로 다른 알고리즘과의 성능 비교에서 상한 기준을 제공

FIFO

가장 먼저 온 페이지를 교체 영역에 가장 먼저 놓는 방법

LRU (Least Recently Used)

참조가 가장 오래된 페이지를 교체

각 페이지마다 계수기, 스택을 두어야 하는 문제점이 있음

NUR (Not Used Recently)

LRU에서 발전하였으며, clock 알고리즘이라고 함

시계방향으로 0(참조되지 않음)과 1(최근에 참조됨)을 가진 비트를 확인하여 0을 찾은 순간 해당 프로세스를 교체하고 1로 바꿈

LFU (Least Frequently Used)

가장 참조 횟수가 적은 페이지를 교체