Overview

Classification Problem

Linear Regression으로 학습해보자

f(x)=−2.4507508832597606+0.00227488∗RPM+0.00379006∗Vibration

기존 접근의 문제점들

- 1 이상 또는 0 이하의 수들이 나오는 걸 어떻게 해석해야 하는가?

- 1 또는 0으로 정확히 표현 가능한가?

Status={10if f(x)≥0otherwise

- 변수가 Y에 영향을 주는 정도가 비례하는가?

- 확률로 발생할 사건의 가능성을 표현해야 한다.

Solution

→ 확률로 나타내자

logit(x)=1+e−x1

Sigmoid function

어떤 사건이 일어날 확률

P(X)일어날확률

1−P(X)일어나지않을확률

0≤P(X)≤1

- 어떤 사건이 일어날 확률과 일어나지 않은 확률의 비율을 가지고 구하게 되는 것이다.

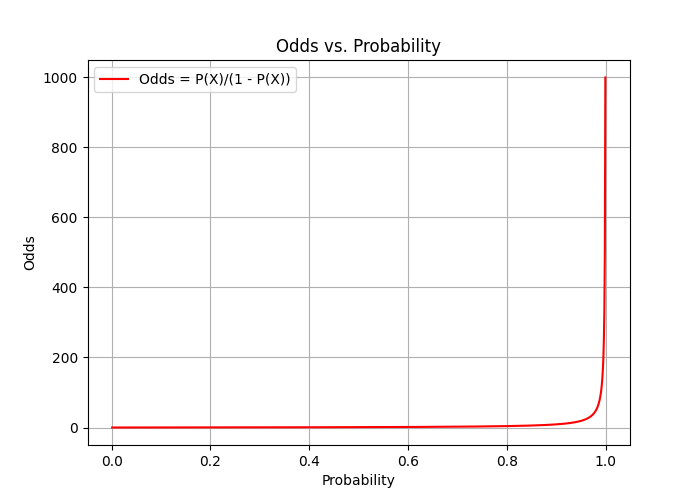

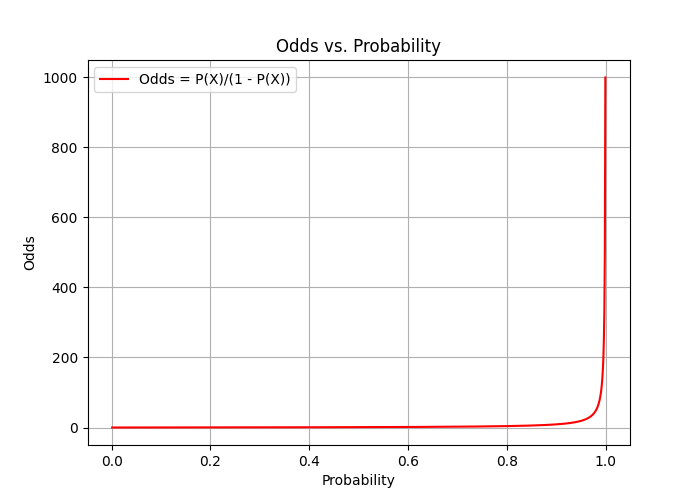

Odds Ratio

해당 사건이 일어날 확률과 일어나지 않을 확률

일어나지 않을 확률1−P(X)일어날 확률P(X)

Logit function

X의 값이 주어졌을 때 y의 확률을 이용한 log odds

logit(p(y=1∣x))=loge(1−pp)=loge(p)−loge(1−p)=−loge(p1−1)

Sigmoid(=Logistic) Function

- Logit 함수의 역함수로 z에 관한 확률을 산출해주는 것이다.

f(z)=y=−loge(z1−1)z=−loge(y1−1)

- 로지스틱 함수의 역함수로, logit 변환과 역변환 관계를 설명한다.

- 역함수로 바꾸면 y에 관한 정리가 된다.

z=−loge(y1−1)

e−z=y1−y

y⋅e−z+y=1

y(e−z+1)=1

y=1+e−z1

- logit 함수의 역함수가 sigmoid 함수임을 증명하는 과정이다.

- Logistic Function = Inverse of logit function

- 미분 가능한 연속구간으로 변환

- S형태로 닮았다고 하여 sigmoid function이라고 칭한다.

p=σ(z)=1+e−z1,1−pp=1+e−ze−z1+e−z1=e−z1=ezloge(1−pp)=zloge(1−pp)=z=w0x0+w1x1+⋯+wnxn

Cost function

가설함수

hθ(x)=g(z)=1+e−z1where:z=w0x0+w1x1+⋯+wnxn=θTx

0≤hθ(x)≤1

위의 수식에서 우리가 구하고자 하는 것은 z값이다.

z값은 w와 x의 linear combination으로 이루어져 있다.

z값에 따른 확률값 hθ(x)을 구할 수 있다.

Cost function

Cost Function을 구하는 방법은 크게 두가지가 있다.

MLE라는 방식으로 구하는 것이고, 다른 하나는 그래프를 그려 보면 알 수 있다.

Cost(hθ(x),y)={−log(hθ(x))−log(1−hθ(x))if y=1if y=0

1. MLE(Maximum Likelihood Estimation) 로 비용 함수 유도

로지스틱 회귀는 각 데이터에 대해 확률을 예측한다.

모델 파라미터 θ가 주어졌을 때, 전체 데이터가 관측될 확률을 최대화하고자 한다.

이 확률을 likelihood라고 부르고, 이를 최대화하는 것이 MLE이다.

2. 비용함수 그래프의 형태

Cost 함수는 아래와 같은 특징을 가진다.

- y=1일 때, hθ(x)가 1에 가까울 수록 비용 ↓

- y=0일 때, hθ(x)가 0에 가까울 수록 비용 ↓

- 예측이 틀릴수록 비용이 급격히 증가한다.

ex.

- y=1:−log(hθ(x))→0에 가까워지면 비용 급상승

- y=0:−log(1−hθ(x))→1에 가까워지면 비용 급상승

비용함수 평균 J(θ)

J(θ)=m1i=1∑mCost(hθ(x(i)),y(i))

- J(θ): 전체 데이터셋에 대한 평균 비용 (로스 함수)

- m: 전체 데이터 수

- Cost(hθ(x(i)),y(i)) : 앞서 본 이진 분류용 비용 함수

=−m1i=1∑m[y(i)loghθ(x(i))+(1−y(i))log(1−hθ(x(i)))]

- Cross-Entropy 형태로 전개

- 개별 비용 함수를 전개한 형태이다.

- y(i)=1일 때: 첫 항만 살아남아 −loghθ(x(i))

- y(i)=0일 때: 두 번째 항만 살아남아 −log(1−hθ(x(i)))

- 위의 두 경우를 모두 커버할 수 있는 하나의 식으로 만든 것이다.

find θ, where θminJ(θ)

- 이 비용 함수 J(θ)를 최소화하는 최적의 파라미터 θ를 찾는 것이 목표이다.

- 이를 위해 경사하강법(Gradient Descent) 등을 사용한다.

시그모이드 함수 hθ(x)

hθ(x)=1+e−θTx1

- 로지스틱 회귀의 가설 함수(Hypothesis Function)이며, 입력값에 대해 확률 출력을 반환한다.

- 출력값은 항상 0~1 사이이다.

Partial derivation of cost function

J(θ)=−m1i=1∑m[−y(i)log(1+e−θx(i))+(1−y(i))(−θx(i)−log(1+e−θx(i)))]

- 로지스틱 회귀의 비용 함수에서 시작하여 각 항을 시그모이드 정의로 치환했다.

- hθ(x)=1+e−θTx1 이 식을 비용 함수에 대입하면 로그 함수와 지수 함수가 결합된 형태가 된다.

J(θ)=−m1i=1∑m[yiθxi−log(1+e−θxi)]=−m1i=1∑m[yiθxi−log(1+eθxi)]

−θxi−log(1+e−θxi)=−[log(eθxi)+log(1+e−θxi)]=−log(1+eθxi)

- 복잡한 로그 표현을 단일 로그로 변환하여 계산을 간단하게 해줄 수 있다.

Partial derivation of cost function

로지스틱 회귀의 비용 함수 J(θ)를 파라미터 θj에 대해 편미분 하는 과정이다.

−m1i=1∑m[yiθxi−log(1+eθxi)]

여기서 z=θTx 이며, θxi=∑j=1nθjxji

θ에 관하여 편미분하면:

∂θj∂(yiθxi)=yixji

기초 미분 성질 예시

dxdln(2x)=2x2=x1,dxde2x=2e2x

로그 항 미분

∂θj∂log(1+eθxi)=1+eθxixjieθxi=xji⋅hθ(xi)

로지스틱 회귀의 비용 함수 미분 중 유도 과정

∂θj∂log(1+eθxi)=1+eθxixjieθxi=xjihθ(xi),

여기서 hθ(xi)=1+e−θxi1

1+eθxixjieθxi=e−θxixji∗1+eθxi1=e−θxi+1xji=1+e−θxixji=xji⋅hθ(xi)

where hθ(xi)=1+e−θxi1