Neural Style Transfer

1. Image Style Transfer using CNN (2016)

처음으로 Neural Network을 style transfer에 접목시켰다.

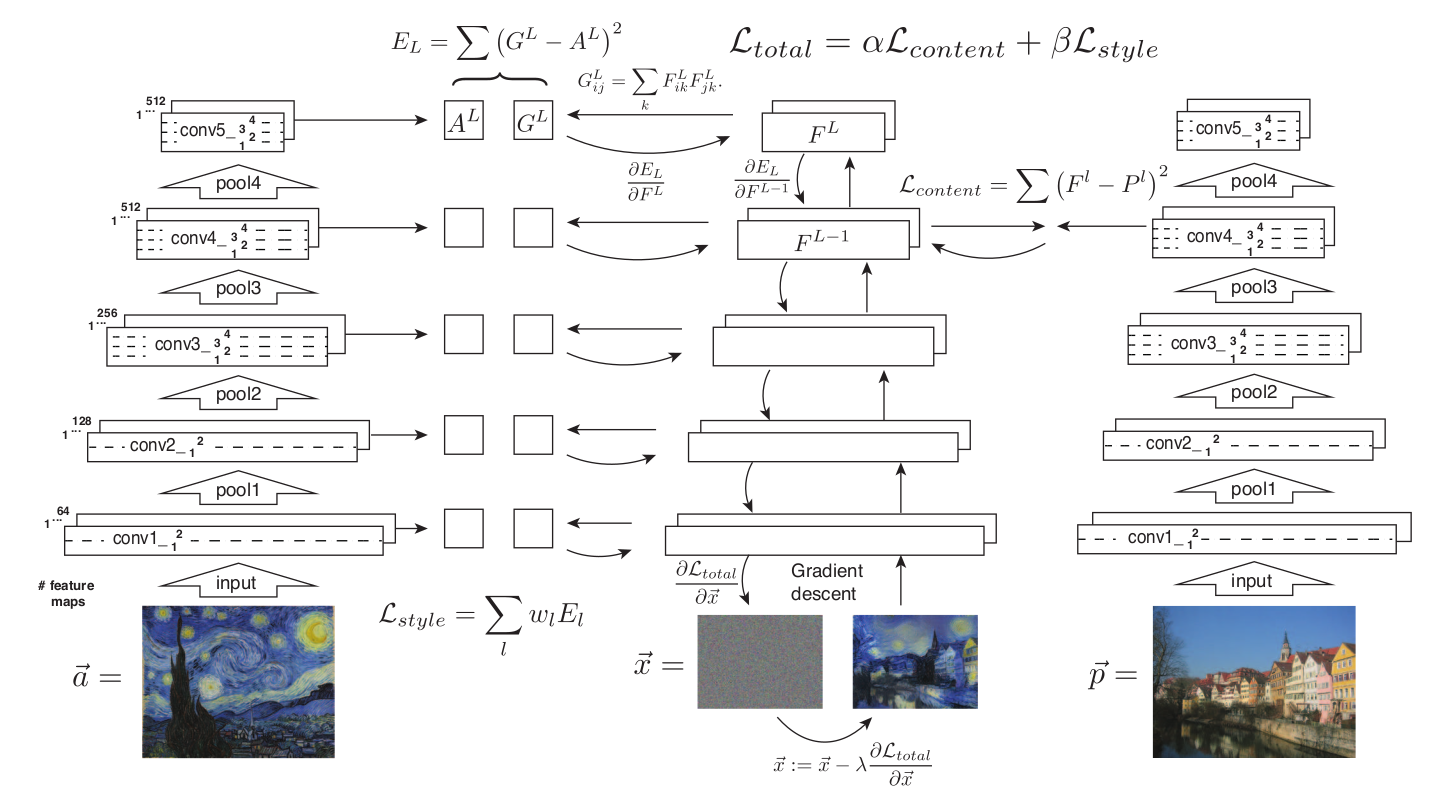

2014년 이미지 인식 대회에서 우승한 vggnet을 사용하여 이미지의 content 와 style representation 을 나타냈고, feature values를 통해 style transfer method를 제안했다.

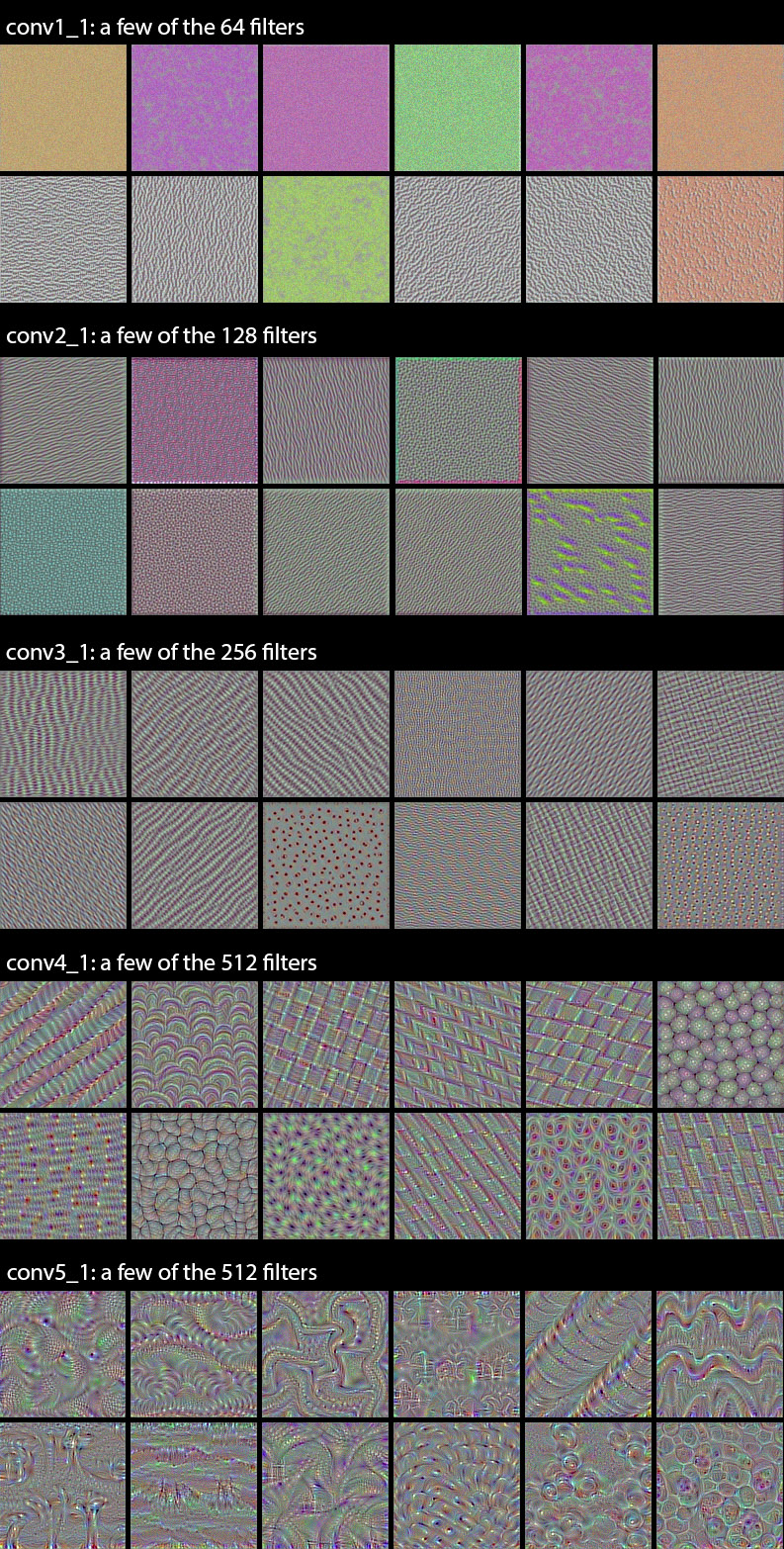

아래 그림은 vggnet의 layer별 feature representation을 시각화한 예시이다.

style representation

(Gram matrix가 왜 image의 style 정보를 함축하고 있는지에 대한 설명)

vggnet의 feature representation을 보면 알 수 있듯이, 각각의 filter들은 특정 패턴에 대한 정보를 갖고있다. 이미지의 style은 바로 각각의 패턴들의 조합으로 이루어졌다고 생각하면, 각 패턴들의 correlation matrix인 Gram matrix가 이미지의 style representation으로 생각 할 수 있다.

이 모델의 시사점은

1. 처음으로 neural network를 사용해 style transfer을 시도. 즉 image의 style이 DNN에 녹아져있다는 것을 보여줬다.

이 모델의 한계는

1. slow iterative optimization process.

2. style 마다 gram matrix를 계산해야 한다.

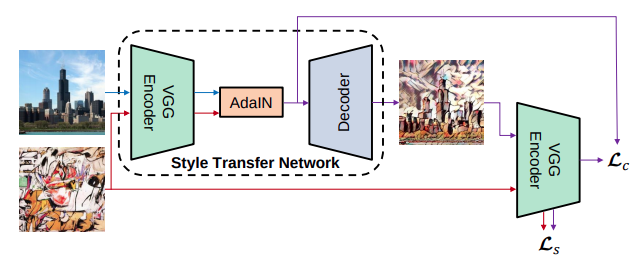

2. Arbitrary style transfer in real-time with adapative instance normalization (2017)

(1) 의 한계를 보완한 방법들이 제시됐지만, 제한된 style만 사용할 수 있다는 또 다른 한계가 있었다. [flexibility-speed dilema]

AdaIN은 Instance Normalization을 응용해 이를 해결했다.

we propose a new interpretation that instance normalization performs style normalization by normalizing feature statistics, which have been found to carry the style information of an image

Demystifying Neural Style Transfer - Li (2017)

Matching the Gram matrices of feature maps is equivalent to minimize the Maximum Mean Discrepancy (MMD) with the second order polynomial kernel.

Neural style transfer 은 feature distribution을 matching 하는 것. batch-normalization의 mean과 variance도 style information을 갖고 있음을 추측할 수 있다.

iterative한 방식대신 vgg Encoder-Decover로 구성된 feed-forward 구조를 제안.

Encoder은 pretrained. Decoder만 학습됨.

style loss를 Gram matrix loss 대신 Demystifying Neural style transfer에서 제시된 loss를 사용.