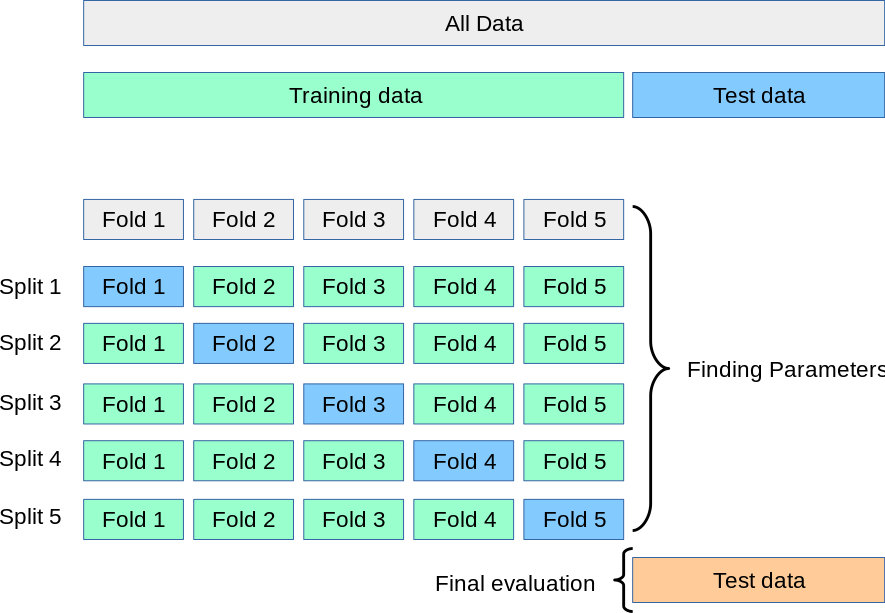

K-fold

데이터들이 독립적이고 동일한 분포를 가진 경우

KFold

모델의 학습 과정에서 모델 생성을 위한 데이터셋을 Train / Validation 데이터를 나눌 때

K개의 데이터 셋을 만든 후 K번만큼 학습과 검증을 수행하는 방법

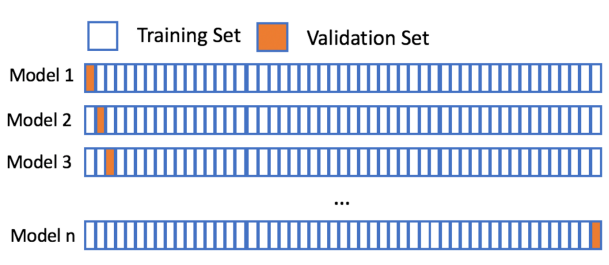

LeaveOneOut(LOO)

Validation set을 한 개로 하고, 나머지를 Train set으로 해서 하나씩 모두 검증하는 방식

LeavePOutLeaveOneOut(LPO)

LOO와 유사한 방법론

Validation set 중 P의 개수만큼 Validation set으로 사용

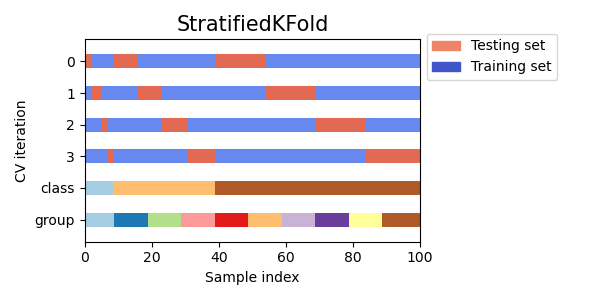

데이터의 분포가 다른 경우

StratifiedKFold

Stratified K-Fold는 층화된 folds를 반환하는 기존 K-Fold의 변형된 방식

각 집합에는 전체 집합과 거의 동일하게 클래스의 표본 비율이 포함

데이터가 그룹화되어 있는 경우

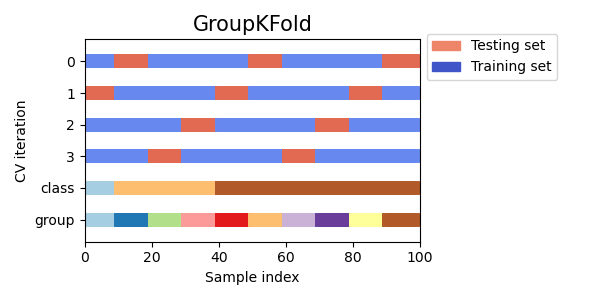

GroupKFold

GroupKFold는 train, test data에서 동일한 그룹이 표시되지 않도록 하는 KFold의 변형 방식

LeaveOneGroupOut

LOO : 하나의 데이터를 검증 데이터로 남겨두고 나머지 데이터로 학습 데이터를 구성

LOGO : 하나의 그룹을 남겨두고 나머지 그룹으로 학습 데이터를 구성

LeavePGroupsOut

LOGO와 유사한 방법론.

P개의 그룹을 남겨두고 나머지 그룹을 훈련 데이터로 구성

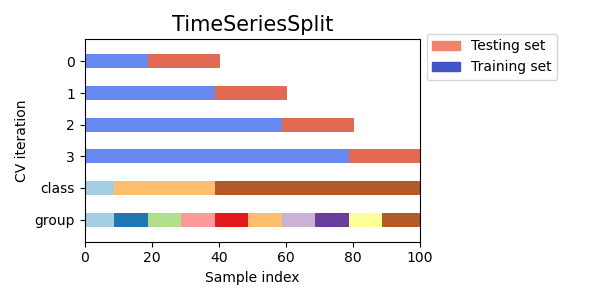

데이터가 시계열 데이터인 경우

TimeSeriesSplit

첫 번째 fold는 훈련 데이터 세트로, 두 번째 fold는 검증 데이터 세트로 분할

기존의 교차 검증 방법과 달리, 연속적 훈련 데이터 세트는 그 이전의 훈련 및 검증 데이터를 포함한 상위 집합