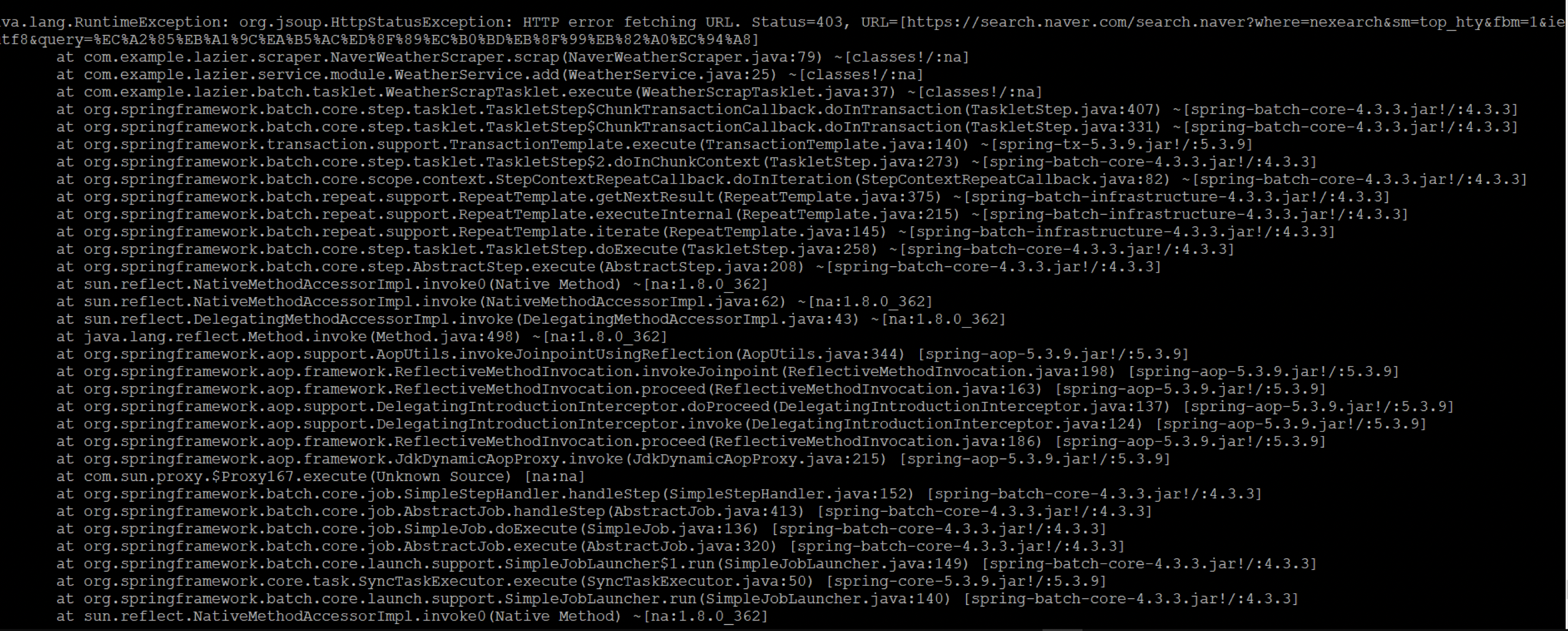

JSoup 을 이용하여 네이버 날씨 scraping 을 하던 중 발생한 에러이다.

URL Status 403 에러가 발생하였다.

서버에서 봇으로 인식하고 차단을 하였을 경우 발생하는 에러였다.

해결방법은 아래와 같이 Header 에 값을 넣어 해결하였다.

doc = Jsoup.connect(url) .userAgent("Mozilla/5.0 (Windows NT 6.2; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/32.0.1667.0 Safari/537.36") .header("scheme", "https") .header("accept", "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8") .header("accept-encoding", "gzip, deflate, br") .header("accept-language", "ko-KR,ko;q=0.9,en-US;q=0.8,en;q=0.7,es;q=0.6") .header("cache-control", "no-cache") .header("pragma", "no-cache") .header("upgrade-insecure-requests", "1") .get();

에러 젭알 그만 ㅠㅠ

참고

https://ktko.tistory.com/entry/JSOUP%EB%A1%9C-%EC%9E%90%EB%B0%94%EB%8F%84-%ED%81%AC%EB%A1%A4%EB%A7%81%EC%9D%B4-%EA%B0%80%EB%8A%A5%ED%95%98%EB%8B%A4

https://ktko.tistory.com/entry/robotstxt-%EC%86%8C%EA%B0%9C%EC%99%80-%EC%9E%91%EC%84%B1%EB%B2%95%EC%9D%84-%EC%95%8C%EC%95%84%EB%B3%B4%EC%9E%90 (- robots.txt 작성법)