LSTM 모델 : LSTM Model

LSTM : Long Short Term Memory

RNN에서 time step이 길어질수록 학습능력이 떨어진다.

RNN을 변형해 LSTM을 개발

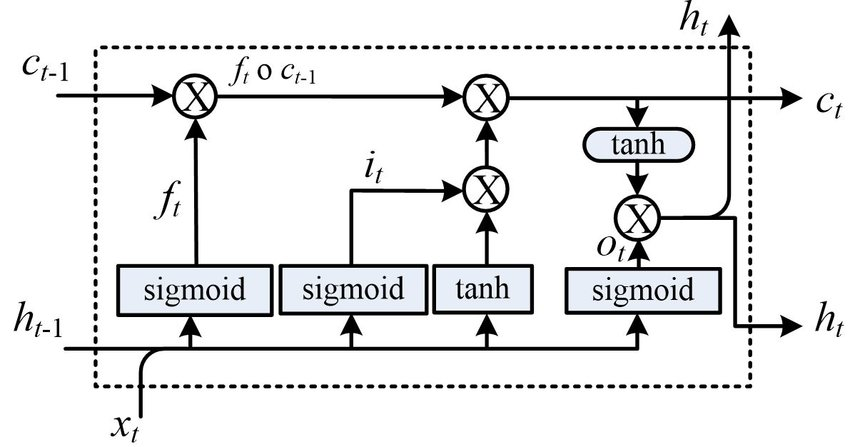

내부 구조

RNN 모델에서 은닉 상탯값 이외에 셀 상탯값 추가

3 개의 게이트Gate 추가

LSTM의 구성요소는

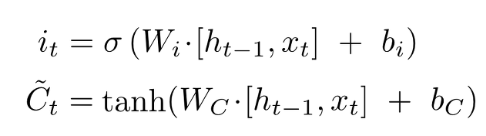

- 입력 게이트 Input Gate: 정보의 기억량을 결정

입력값(x)과 이전의 은닉 상탯값(ht-1)을 연관된 가중치로 곱해 2개의 활성화 함수로 계산

현재 시점의 입력 반영도

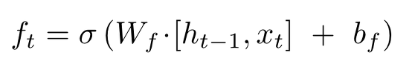

- 삭제 게이트 Forget Gate

입력값(x)과 이전의 은닉 상태값(hi-1)을 시그모이드 함수를 통해 출력 => 이전 상탯값 삭제

이전 시점의 입력 반영도

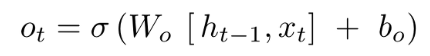

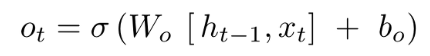

- 출력 게이트 Output Gate

출력 게이트의 결과값(ot)은 현재 시점의 은닉 상태(ht)를 결정

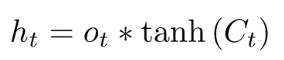

양방향 LSTM

RNN과 LSTM은 은닉층에서 과거의 정보를 기억할 수 있다.

하지만 이전 시점의 정보만 활용할 수 있다.

문장이 길어질수록 성능이 저하된다.

문장의 앞부분보다 뒷부분이 중요한 정보가 존재할 때도 있다.

그래서 역방향 처리도 중요하다.

양방향 LSTM은 기존 LSTM 계층에 역방향으로 처리하는 계층을 추가해서 양방향 문장의 패턴을 분석할 수 있도록 구성되어 있다.

시퀀스가 길어지더라도 정보 손실 없이 처리가 가능하다.

양방향 LSTM = 정방향 LSTM + 역방향 LSTM

당신의 시간이 헛되지 않는 글이 되겠습니다.

I'll write something that won't waste your time.

너무 유용한 글이네요 18살이 이런 공부를 한다니 정말 멋져요 화이팅!!