BERT (Bidirectional Encoder Representations from Transformers)

- 2019년 10월 25일 구글 리서치 팀에 의해 공개된 자연어처리 사전 훈련 모델

- BERT은 사전 학습된 언어모델로서 파인튜닝을 통해, 원하는 작업을 수행

cf.파인튜닝이란?!

- 기존에 학습되어져 있는 모델을 기반으로 아키텍처를 새로운 목적에 맞게 변형하고 이미 학습된 모델의 가중치를 미세하게 조정

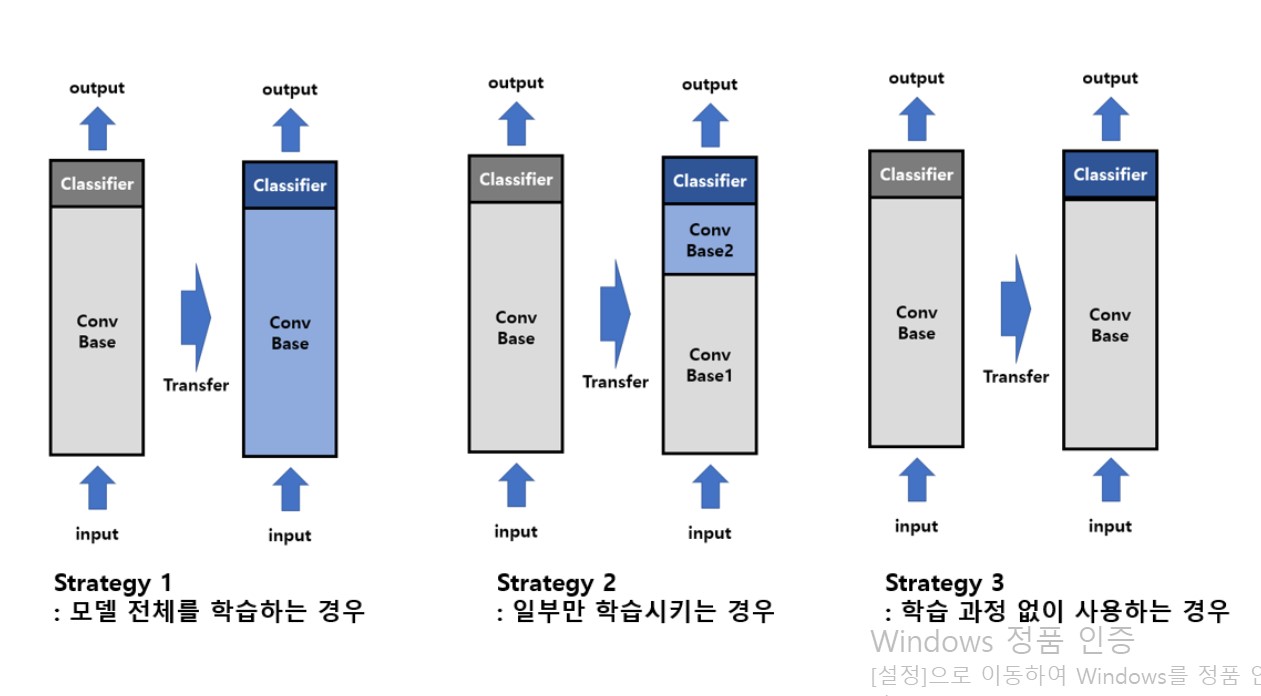

1) 모델 전체를 새로 학습 --> 사전 학습 모델의 구조만 사용하면서, 자신의 데이터셋에 맞게 모델을 전부 새롭게 학습

2) ConvBase는 고정 Classifier만 새로 학습 -->

Convase은 합성곱 층과 풀링 층이 여러 겹 쌓여있는 부분으로, 특징을 추출하는 부분.

낮은 레벨 계층(layer가 적은) 은 일반적으로 독립적인 특징을 추추하고, 높은 레벨(layer가 많은)의 계층은 보다 구체적이고 명확한 특징(형상)을 추출한다.

3) ConvBase 일부문만 고정 나머지 ConvBase계층과 Calssifier를 새로 학습 --> 컴퓨팅 연산능력이 부족하거나, 데이터 셋이 너무 작을 때, 혹은 적용하려는 task가 학습 모델이 pretrained