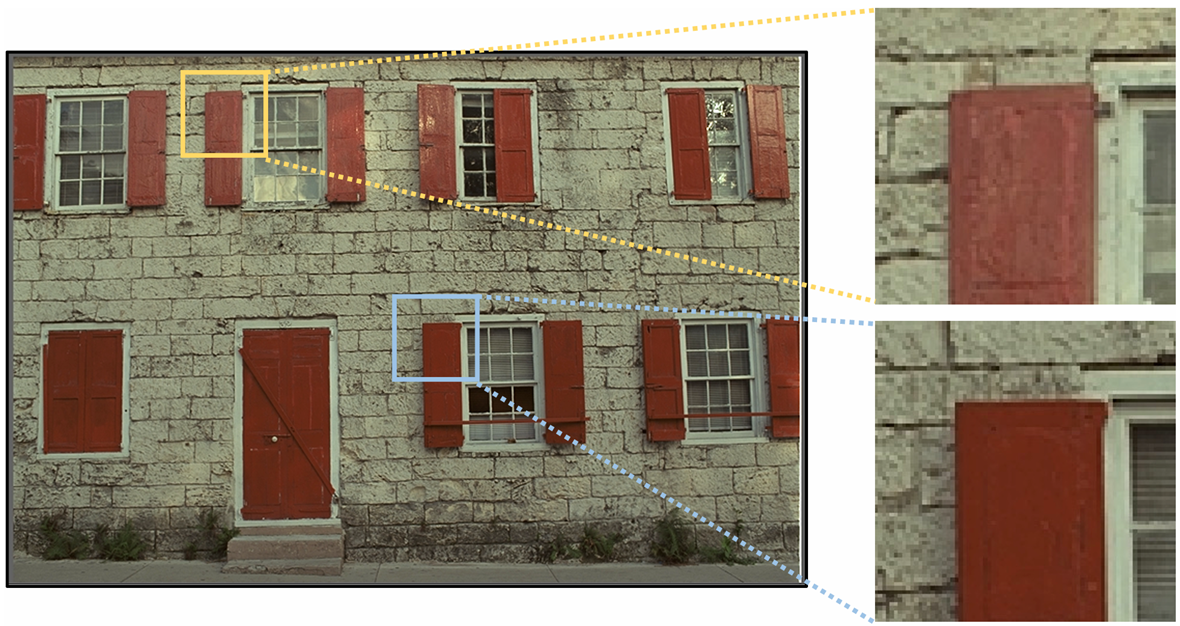

[논문 리뷰] Learning Accurate Entropy Model with Global Reference for Image Compression (ICLR 2021)

Compression

해당 논문 이전의 Entropy model들은 모두 CNN 기반의 구조여서 local한 redundancy만 고려하고, global redundancy를 고려하지 못한다는 문제의식에서 시작한다.

CNN 구조였던 Entropy model에 global 처리를 추가하는 첫 논문이 되겠다.

인코더 디코더는 별로 안중요해서 Entropy model 내부만 봐보자

Overview

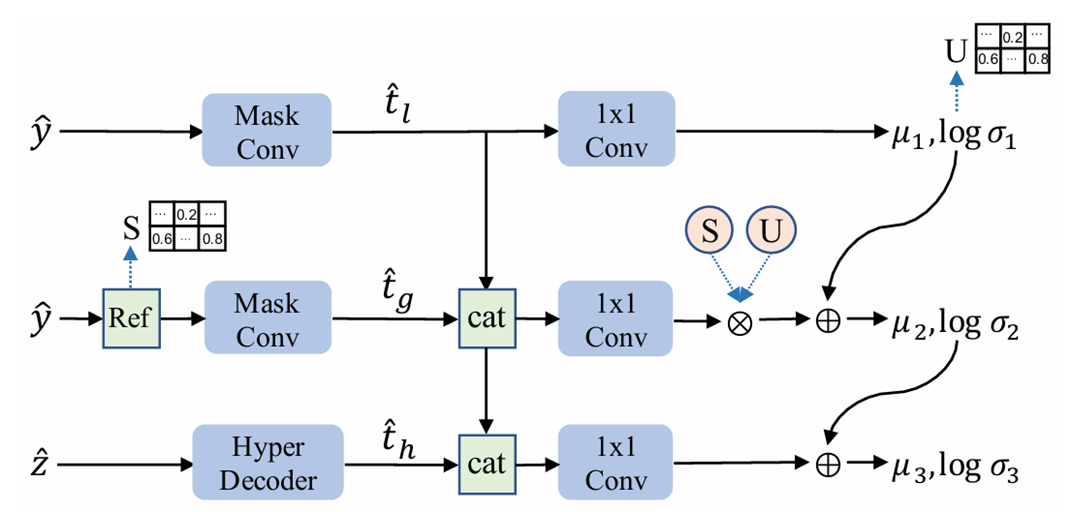

그림과 같이 세줄 구조로 되어있다.

위에서부터 Local, Global, Hyperprior path이다.

오른쪽과 아랫줄을 가리는 Mask convolution으로 Autoregressive를 구현하였다.

3x3 conv라면,

000

00X

XXX

이런식으로 가리는 커널을 사용한다.

첫째줄 Local

Confidence map U를 얻는 과정이다.

U는 latent 각 픽셀의 quality 정보를 담은 matrix다. CxHxW 형태일텐데, C방향으로 평균내서 쓴다.

이후 확률 파라미터 을 예측한다.

약간 디테일로 를 바로 예측하는 것에 비해 를 예측하는게 더 안정적이라고 한다.

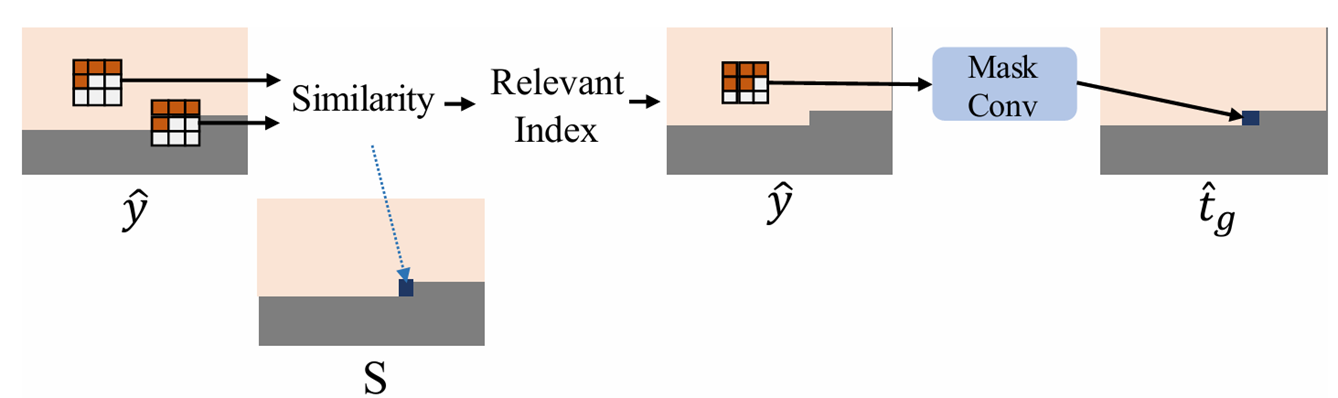

둘째줄 Global

Similarity map S를 얻고, U,S를 활용한다.

Cosine similarity로 하는데, mask convolution 하는 것 처럼 윗줄과 왼쪽 픽셀까지 4개 픽셀들을 사용해서 cosine similarity를 측정한다.

이렇게 얻은 S와 U로 Local path에서 얻은 를 업데이트 한다 ->

셋쨰줄 Hyperprior

다른 모델과 같이 z에서부터 위에서 얻은 를 업데이트해서 최종 을 얻어서 각 latents의 확률을 예측한다.