[AI스쿨 7기, 10주차] Ch4. 경사하강법(stochastic, global minimum, momentum) / Ch5. Support Vector Machine(scaler, hard margin, soft margin, nonlinear SVM Classification, SVM Regression)

멋쟁이사자처럼

목록 보기

33/51

K-MOOC '실습으로 배우는 머신러닝' 김영훈 교수님

Ch4. 경사하강법(Gradient Descent)

Iterative Algorithm-based Optimization

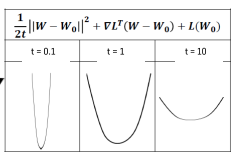

Gradient Descent의 수학적 background : Quadratic approximation(2차 다항식)

- Wc : 현재 위치

- W - Wc : 현재 위치에서 떨어진 지점

tc: stepsize ==learning rate:Hyperparameter- ▽L : w의 Gradient

Global optimum을 구한다는 것은 장담하지 못하지만, 지엽적인 opmimum을 구하는 것만으로도 성능에 큰 영향이 있다.

Stochastic Gradient Descent

batch로 여러 개를 쪼개서 추정

샘플링 느낌(Stochastic - 확률)

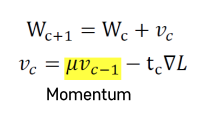

Global vs Local Minimum

Global minimum : local minimum 중 가장 작은 것

- 랜덤하게 initializing 하고 local minimum에 도달해서 빠져 나오지 못하는 문제점

momentum이 적용된다. 하강하던 관성을 유지해서 saddle point, local minimum에서 빠져나올 수 있도록.

Ch5-1. Support Vector Machine

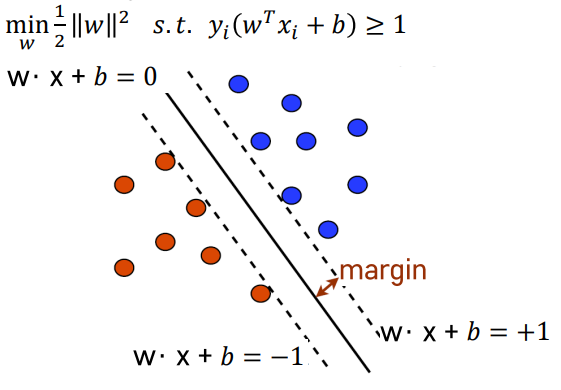

large margin classification : 두 클래스 사이 가장 넓이가 큰 분류 경계선

support vector : 각각의 클래스에서 분류 경계선을 지지하는 관측치들

- 선형, 비선형 분류, 회귀, 이상치 탐색에 사용

- 딥러닝(2013년) 이전까지 널리 사용

- 상대적으로 작거나 중간 크기의 데이터에 적합

- 최적의 분류 경계 탐색

- 스케일에 민감하기 때문에 변수들의 스케일을 맞추는 것이 중요

- Sklearn의

StandardScaler를 사용하면 스케일을 잘 맞출 수 있다.

Hard Margin, Soft Margin

wx+b

Hard Margin : 두 클래스가 하나의 선으로 완벽하게 나뉨

- 목적식 : 1/2||W||^2 : w를 제곱해서 1/2로 최소화하면 margin이 최대화된다.

- 제약식

- yi = +1, -1 : 두 개 클래스를 구분

- 모든 관측치에 해당

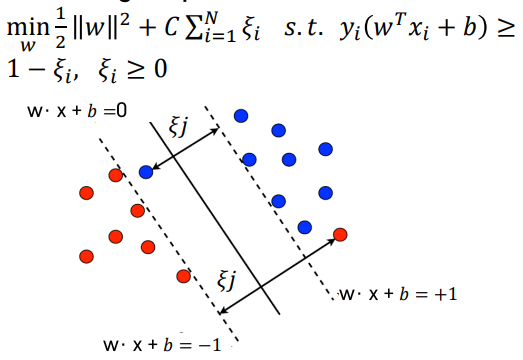

Soft Margin : 일부 샘플들이 분류 경계선의 결과에 반하는 경우를 일정 수준 허용

- C 패널티 파라미터로 조정<- SVM의 Hyperparameter

Trade-off- 제약식 : 넘어가면 패널티를 더해주는 식이 들어가있음.

- 목적식: 하이퍼파라미터 C를 곱해줘서 조절

Ch5-2. Nonlinear SVM Classification

다항식 변수들을 추가해 직선으로 분류할 수 있는 형태로 데이터를 만들기

polynomial kernel

다항식의 차수를 조절하는 효율적인 계산 방법

데이터의 차원을 효과적으로 늘려줌.

dimension과 같은 차수를 변경해준다.

Gaussian RBF Kernel

무한대 차수를 갖는 다항식으로 차원을 확장

gamma라는 고차항 차수에 대한 가중 정도를 변경해준다. == 복잡도 조절

Ch5-3. SVM Regression

선형 회귀식을 중심으로 오차 한계선을 넘어가는 관측치들에 패널틸르 부여하는 선형 회귀식 추정