ROC, AUROC는 분류모델의 평가지표입니다. 이 분류지표는 어떤 원리로 작동하는 것일까요? 이를 이해하기 위해서는 Classification의 y^, 즉 예측값이 정확히 무엇인지 먼저 알아야 합니다.

[Classification model의 y값은 ○○값이다. 모델의 결과물을 binary한 결과값 y^로 제시하기 위해서 0과 1 사이의 일정한 기준값(Threshold)를 지정한다.]

위 문장의 ○○값에 들어갈 단어를 찾아 답변해 주세요.

또한, 민감도(Sensitivity)와 특이도(Specificity)가 tradeoff 관계인 이유에 대해 적어주시길 바랍니다.

ROC는 모든 threshold(임계값)에서 분류모델의 성능을 보여주는 지표이며, AUROC는 ROC곡선의 아래 영역을 말합니다.

(ROC의 경우, 아래 confusion matrix로 예를 들어봤습니다.)

[Classification model의 y값은 sigmoid function(확률)값이다. 모델의 결과물을 binary한 결과값 y^로 제시하기 위해서 0과 1 사이의 일정한 기준값(Threshold)를 지정한다.]

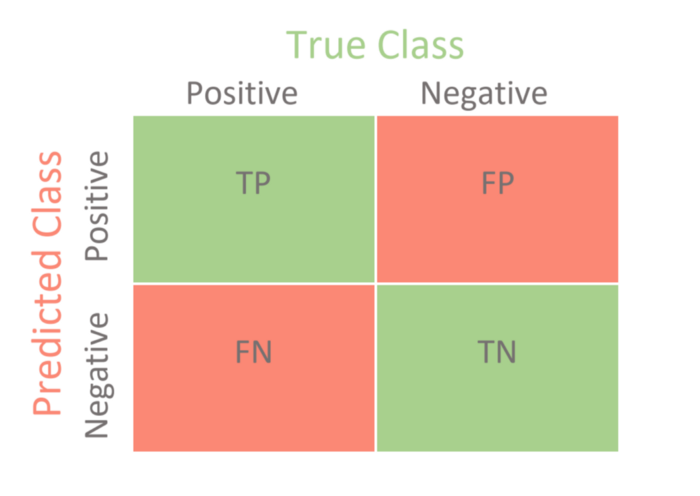

sensitivity와 specificity가 tradeoff 관계인 이유를 알기전에 먼저, sensitivity와 specificity를 이해하기 위해 confusion matrix를 알아보는것이 좋습니다.

(출처:https://towardsdatascience.com/confusion-matrix-for-your-multi-class-machine-learning-model-ff9aa3bf7826)

TP(True Positive), FP(False Positive)

FN(False Negative), TN(True Negative)

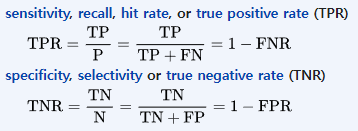

Sensitivity(민감도: 질병이 있는 환자를 정확하게 식별하는 검사의 능력) (TPR)

specificity(특이성: 질병이 없는 사람을 정확하게 식별하는 검사의 능력) (TNR)

TPR(True Positive Rate) = Sensitivity

FPR(False Positive Rate) = 1-Specificity

위 수식에서 알 수 있듯이 서로 반비례하기 때문입니다.

TruePositive(질병이 있는 환자)

FalseNegative(질병이 있으나 없다고 식별된 환자)

sensiticity(TPR) = TruePositive/TruePositive + FalseNegative = 1 - FalseNegative

예를 들어 보건소에서 코로나 검사를 진행할 경우 sensitivity(민감도)하게 검사를 해야 하기 때문입니다.