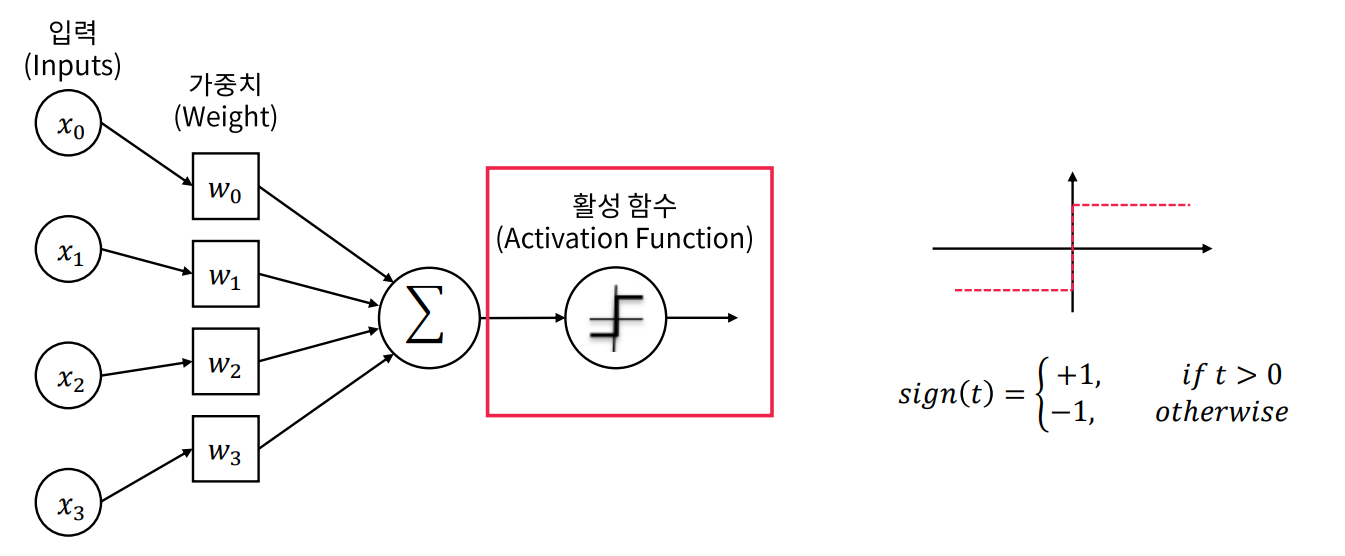

활성함수란?

활성함수(Activation Function)는 퍼셉트론의 출력에 의미를 부여해주며, 일반적으로 비선형(Non-linear)함수이다.

Decision Boundary의 결정

.png)

그 전 퍼셉트론 파트의 마지막 부분과 비교, 직관적으로 우측과 같은 결정경계(Decision Boundary)가 좋다는 걸 알 수 있다.

Sign 함수의 문제점

.png)

.png)

우측 점에 비해 좌측점은 지나치게 결정 경계(Decision Boundary)에 가깝다. 결정경계로부터 거리를 신경쓰지 않은 탓이다.

Tanh와 Soft decision

.png)

.png)

- 값이 작아질수록 -1, 커질수록 1에 수렴

- 모든 실수 입력값에 대해 출력이 정의됨

- 출력이 실수값으로, Soft decision

- 입력값이 0에 가까울 수록 출력이 빠르게 변함

- 모든점에서 미분 가능

Sigmoid function

.png)

.png)

- 값이 작아질수록 0, 커질수록 1에 수렴

- 모든 실수 입력값에 대해 출력이 정의

- 출력이 0~1사이로, 확률을 표현할 수 있음

- 입력값이 0에 가까울 수록 출력이 빠르게 변함

- 모든점에서 미분 가능

Softmax function

softmax는 최종출력 단에서 N가지 범주로 분류하는 Multi-class classification에 쓰임

.png)

.png)

- 각 입력의 지수함수를 정규화한 것

- 각 출력은 0~1사이의 값을 가짐

- 모든 출력의 합이 반드시 1이 됨

- 여러 경우의 수 중 한가지에 속할 확률을 표현

Softmax vs Sigmoid

.png)

Sigmoid는 하나의 입력을 0으로 강제한 2-Class Softmax 함수와 동일하다.

2가지 클래스를 구분하기 위해 1개의 입력을 받는다는 점이 중요하다.

ReLU function

.png)

.png)

- 0보다 작은 값을 0으로 강제로 변환

- 딥러닝에서 가장 많이 사용됨

- 미분값이 일정(0또는 1)이라 학습이 잘됨

- 단순한 구현으로 매우 빠른 연산가능