L1/L2 Norm, Loss, Regularization 세가지가 헛갈릴 수 있다.

Norm은 벡터의 크기, 두 벡터 사이의 거리

Loss는 오차

Regularization은 가중치가 너무 커지는 것을 규제, 즉 오버피팅 방지하는 것

L1은 절댓값

L2는 제곱 으로 기억하면 된다.

L1 Regularization(Lasso)

loss + |w|를 비용함수로 하여 최소화한다.

이를 편미분하면

이고, 이는 weight의 크기와 상관없이 규제정도와 w의 부호에 따라 상수값을 빼주는 것이다.

단순히 상수값을 빼는 것이기에 몇몇 가중치만 살아남는다. -> sparse한 상황에서 사용

명시해 없음

L2 Regularization(Ridge)

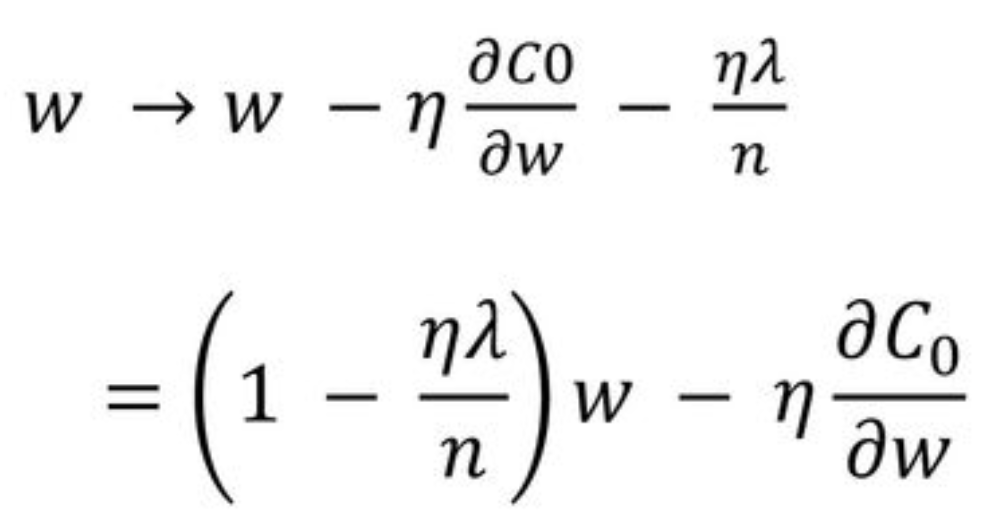

loss + w^2를 비용함수로 하여 최소화한다.

이를 편미분하면

가중치에 규제정도를 고려한 값을 곱한다.

가중치를 전체적으로 줄이는 것

closed form