batch size

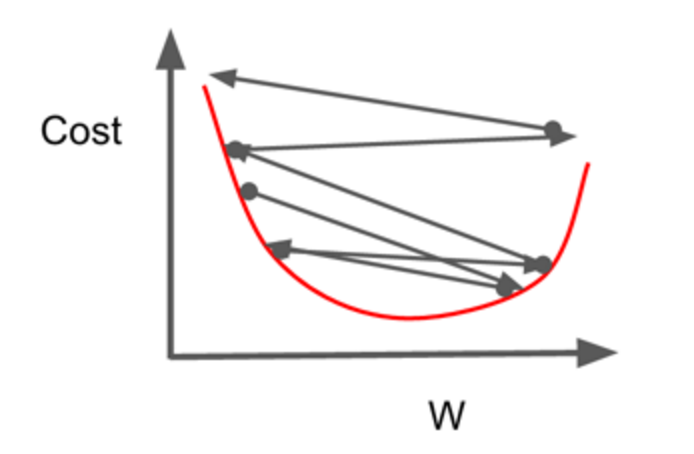

큰 배치 사이즈

- gpu를 효율적으로 사용가능하다. 학습 시간이 빠르다.

- 학습 데이터의 분포와 유사해지기 때문에 noise가 적어진다.

- 안정된 수렴을 한다.(local minima에 빠질 수 있다.)

- 과적합이 일어날 수 있다

작은 배치 사이즈

- 큰 noise를 가진다.

- 적당한 noise는 regularization효과를 하여 과적합을 방지할 수도 있고

- 너무 큰 noise는 성능에 악역향을 줄 수 있다.

- 많은 학습 시간 소요

- local minima에 빠질 수 있다.(작은 sample로 여러 step을 학습하기에)

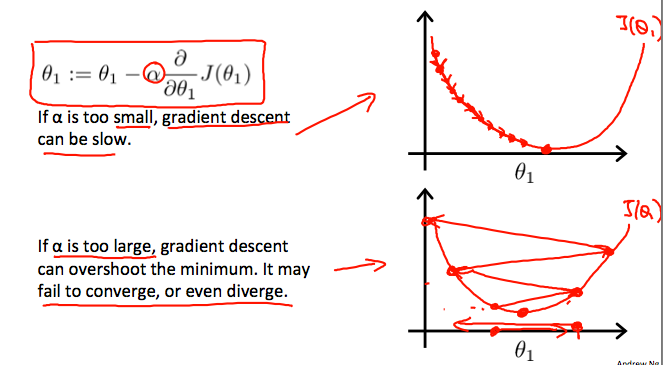

learning rate

큰 학습률

- 큰 보폭을 가지기에 빠른 수렴이 가능

- 오버슈팅 문제가 발생할 수 있다.

작은 학습률

- 작은 보폭을 가지기에 학습 속도가 느리다.

- local minima에 빠질 수 있다.

batch size와 learning rate

큰 배치사이즈, 큰 학습률(👍)

- 많은 데이터를 적용한 결과를 큰 lr을 적용해 반영

- 과적합 문제 발생할 수 있음

작은 배치사이즈, 작은 학습률(👍)

- 작은 배치 사이즈는 노이즈가 크기에 이러한 결과를 높은 학습률로 적용하기보다 작은 학습률을 적용하는 것이 적절할 것이다.

- local minima의 문제 있을 수 있음

- 학습 오래 걸릴 것이다.

큰 배치사이즈, 작은 학습률(👎)

- 많은 데이터로 보폭을 작게 학습하기에 과적합 문제 발생할 확률이 높다.

작은 배치사이즈, 큰 학습률(👎)

- noise가 많이 존재하는데 큰 학습률을 적용하여 수렴이 어려울 수 있다.

작다 크다의 기준이 애매하고 이미지 특성에 따라 너무 많이 결과가 달라서...