RNN

-

다른 모델의 인풋과 다르게 i.i.d한 입력이 아니다.

-

시퀀스 데이터가 인풋이다.

-

시퀀스 데이터의 분포

-

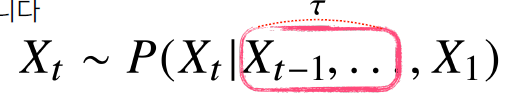

AR(Auto Regressive) 모델

고정된 크기의 과거 데이터를 본다.

-

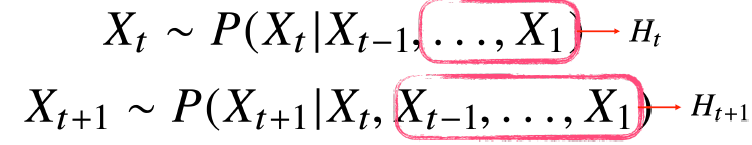

잠재AR(Auto Regressive) 모델

바로 이전의 데이터 + 더 과거의 데이터를 고정된 크기로 인코딩해서 미래를 예측하는 방법

-

RNN

잠재 AR모델에서 더 과거의 데이터를 신경망을 이용해서 인코딩하는 것 -

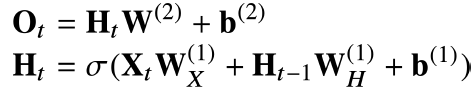

이전 Hidden의 가중치, 현재 입력의 가중치, output 가중치 3종류의 가중치가 존재

-

RNN의 가중치 소실 문제

RNN은 BPTT(Backpropagation Through Time)로 가중치 갱신

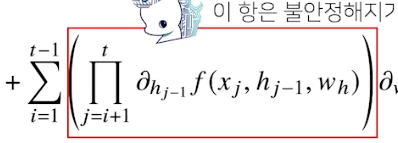

가중치 행렬 미분해보면 아래와 같은 term이 포함된다.

이는 과거부터 지금까지의 미분값을 다 곱하는 것. 0보다 작은 미분값들을 계속 곱하다보면 gradient vanishing , 0보다 큰 미분값을 곱하다보면 gradient exploding 문제가 발생할 것이다.

이를 해결하기 위해 truncated BPTT(:모든 역전파를 사용하지않고 중간중간 끊어주는 것)를 사용하기는 하지만 역부족이다.

그래서 LSTM, GRU가 등장한다.