MLP

질문

- 파이토치에서 모델 불러졌을때 init_param은 자동으로되나?

nn.init.kaiming_normal_(self.lin_1.weight)의 의미%matplotlib inline의미

알게된 것

- torch 모델, 모델에 넣을 데이터 모두 to(device)

%matplotlib inline %config InlineBackend.figure_format='retina'좋은 화질의 plt가능

Opimization

keywords

opimazation keywords

- generalization 일반화

- under-fitting , over-fitting 과대적합 과소적합

- cross validation

- bias-variance tradeoff 편향-분산 tradeoff

- bootstapping

- bagging and boosting

Gradient Descent Method

- SGD

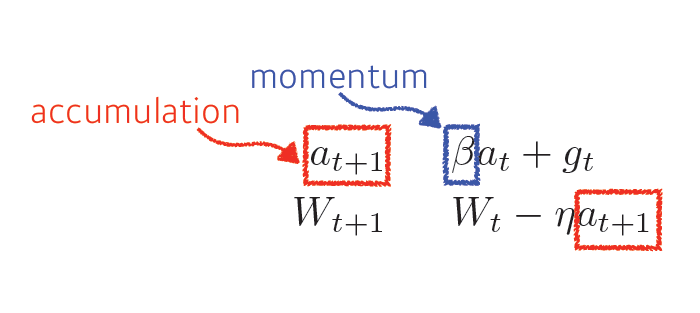

- Momentum

- Nesterov accelerated gradient

- Adagrad

- Adadelta

- RMSprop

- Adam

Regularization

- Early stopping

- Paramter norm penalty

- Data augmentation

- Noise robustness

- Label smoothing

- Dropout

- Batch normalization

아주 많은 개념들이 있었다.

generalization 일반화

train data에만 오버피팅되는 것이아니라 test data에서도 성능을 잘내는 것

under-fitting , over-fitting 과대적합 과소적합

train data에만 치중 -> over fitting, 학습이 덜된것 -> under-fitting

cross validation

train data, test data있으면 train data를 kfold로 나눠서 랜덤하게 fold 골라서 validatation data만들고 나머지 폴드는 train data사용

질문

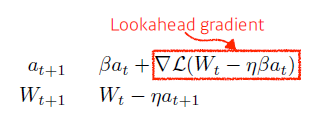

- NAG의 원리가 무엇인지?

모멘텀쪽으로 이동했다고 가정할때 Loss가 줄어드는 방향의 gradient만 momentum값에 더해줘서 조정해주는게 momentum과의 차이

momentum

nag

- Batch normalization이 무엇인지?

https://wdprogrammer.tistory.com/67