📄Paper : Abstract Meaning Representation

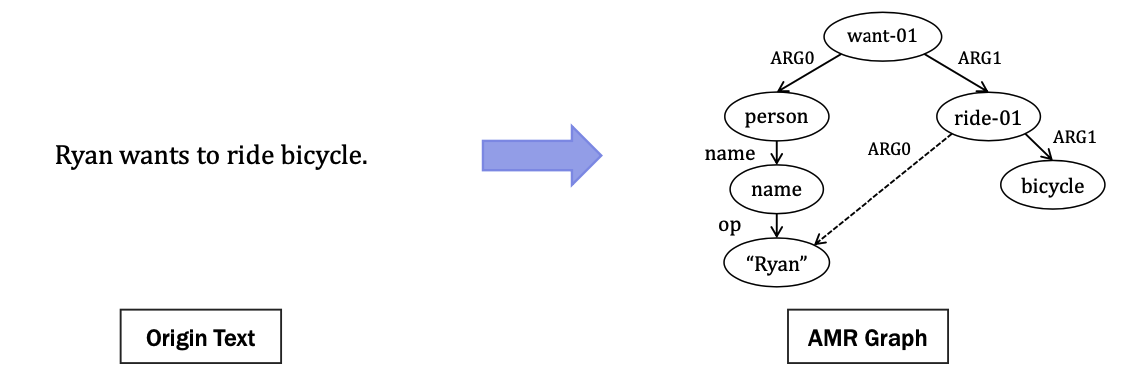

AMR이란?

Banarescu, L., et al.의 연구에서 제안된 개념으로, 문장의 의미 구조를 그래프로 표현한 것이다.

AMR의 단점 🔥

-

보편 양화사(universal quantifier)를 고려하지 못함

all, for all, given any과 같은 보편 양화사는 문장의 주요 개념(Head concept)을 변경할 수 있지만, AMR은 그를 표현할 수 없다. -

시제 및 수 표현에 따른 접사 및 모음의 변화를 포함하지 않음

예시 : -ed, -ing, -s -

실제로 일어난 일과 미래, 가정, 소망을 구별하지 못함

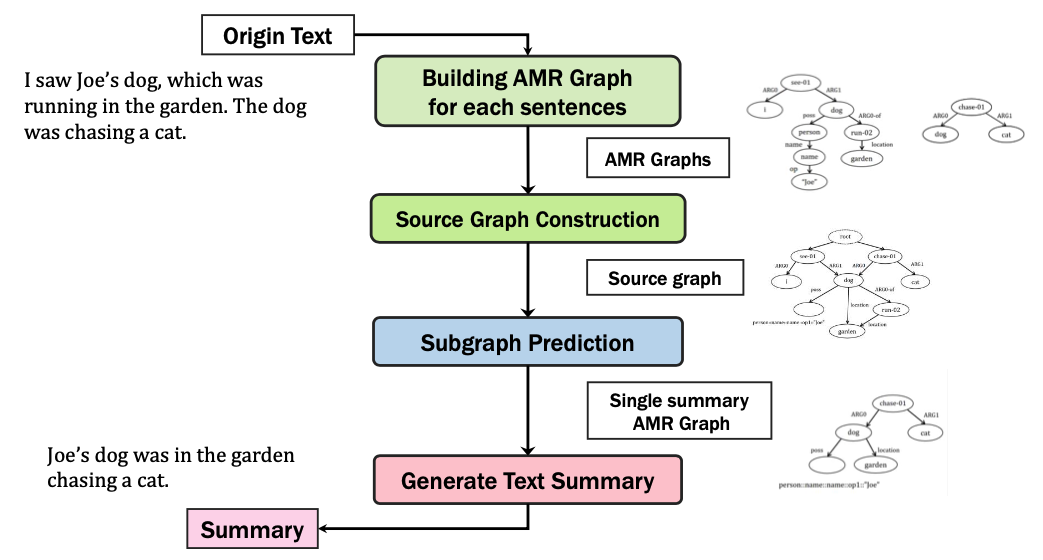

📄Paper : Toward abstractive summarization using semantic representations

💡 Contribution: AMR을 이용한 추상 요약 프레임워크 제안

문장별로 AMR 그래프를 그린 후 그래프를 병합한다.

병합된 그래프의 하위 그래프 중에서 요약 그래프를 예측한다.

요약 그래프를 바탕으로 요약문을 생성한다.

📄Paper : Neural headline generation on abstract meaning representation

💡 Contribution: AMR을 이용한 제목 생성 프레임워크 제안

주어진 텍스트를 AMR 그래프로 변환한 후, Headline Generator를 사용함으로써 제목을 생성하였다.

Headline Generator는 Rush et al.의 연구에서 제안된 Attention Based Summarization (ABS) 모델과 Tree-LSTM 기반 encAMR 모델을 사용하였다.

⭐️ 텍스트와 텍스트로부터 생성된 AMR 그래프를 기반으로 제목을 생성함으로써

문법적이고 의미적으로도 적합한 제목이 생성될 수 있다.

🌱 세미나 자료

✨ 리뷰한 논문

Banarescu, L., et al. "Abstract meaning representation for sembanking." Proc. of the 7th linguistic annotation workshop and interoperability with discourse, Sofia, Bulgaria, 2013.

✨ 참고 문헌

-

Liu, F., et al. "Toward abstractive summarization using semantic representations." Proc. of the 2015 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Denver, Colorado, 2015.

-

Choe, H., Han, J., Park, H., Oh, T. H., and Kim, H. "Building korean abstract meaning representation corpus." _Proc. of the Second International Workshop on Designing Meaning Representations, Barcelona Spain (online), 2020.

-

Takase, S., Suzuki, J., Okazaki, N., Hirao, T., and Nagata, M. "Neural headline generation on abstract meaning representation." Proc. of the 2016 Conference on Empirical Methods in Natural Language Processing, Austin, Texas, pp. 1054-1059, 2016.

-

Rush, A. M., Harvard, S. E. A. S., Chopra, S., and Weston, J. "A neural attention model for abstractive sentence summarization." Proc. of the 2015 Conference on Empirical Methods in Natural Language Processing, Lisbon, Portugal, pp. 379-389, 2015.

-

Tai, K. S., Socher, R., and Manning, C. D. "Improved semantic representations from tree-structured long short-term memory networks." Proc. of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), Beijing, China, pp. 1556-1566, 2015.