Spark 써보기

설치하는 것은 그렇게 어렵지 않지만, 버전이 워낙 빠르게 업데이트 되어 3.* 버전 설치에 대한 포스팅이 필요할 것 같아 해두겠다. 정말 간단하다👌

📌STEP

1️⃣ Phthon 설치

2️⃣ JAVA 설치

3️⃣ Spark 설치

4️⃣ winutils 설치(윈도우만)

5️⃣ 환경 변수 설정

내가 사용한 버전들은 아래와 같다. (2022.09.26일 기준)

Python = 3.8.6

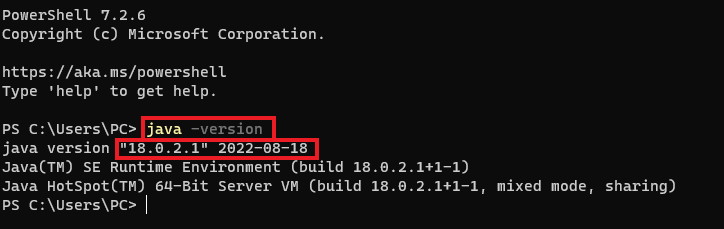

JAVA = 18.0.2.1

Spark = 3.3

STEP1. Python 설치

만약 설치되어있다면 냅두고 아니라면 아래에 가서 본인의 운영체제에 맞게 다운로드 받는다.

ANACONDA3

STEP2. JAVA 설치

spark는 scala로 구현되어 jvm 기반으로 동작하기 때문에 java를 깔아줘야 한다.

아래에 가서 본인의 운영체제에 맞게 다운로드 받는다.

홈페이지에 들어가보면 두 개의 버전이 있는 걸 알 수 있는데, 어디까지나 취향과 진행할 프로젝트의 기능에 따라 선택해주면 된다. 최신이라고 다 좋은 게 아니고 오래 전 버전이라고 다 안 좋은 게 아니다.

🛑그리고 정말 중요한 것!!!(Windows 한정)🛑

Window기반이라면 JAVA가 처음에 C:\Program Files\Java\어쩌구에 저장될 것이다. 이 때, Spark 2.1.1 이상의 버전을 사용하면 저 경로의 (스페이스) 가 문제가 된다(Program Files)!!

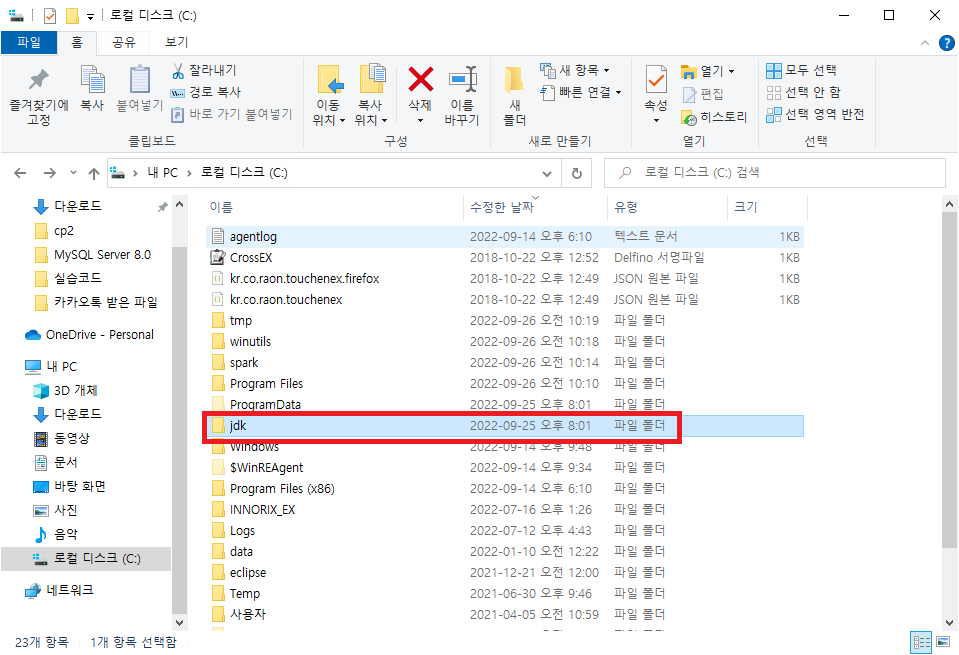

따라서, 경로를 바꿔줘야 하는데, 나는 C:\jdk\로 따로 폴더를 만들고 거기에 다 넣어줬다.

모두 마쳤다면, 터미널(명령 프롬프트)을 열어 java -version을 쳐서 잘 깔렸는지 확인한다.

STEP3. Spark 설치

Spark를 설치하기 전에 가장 중요한 건 python 버전과의 호환이다.

spark 2.3 이상의 버전은 python 3.4 이상을 깔아야 하고, spark 3.0 이상의 버전은 python 3.6 이상의 버전을 써야한다.

본인이 다운받은 python 버전을 확인했다면 아래 링크를 통해 Spark를 다운 받으면 된다.

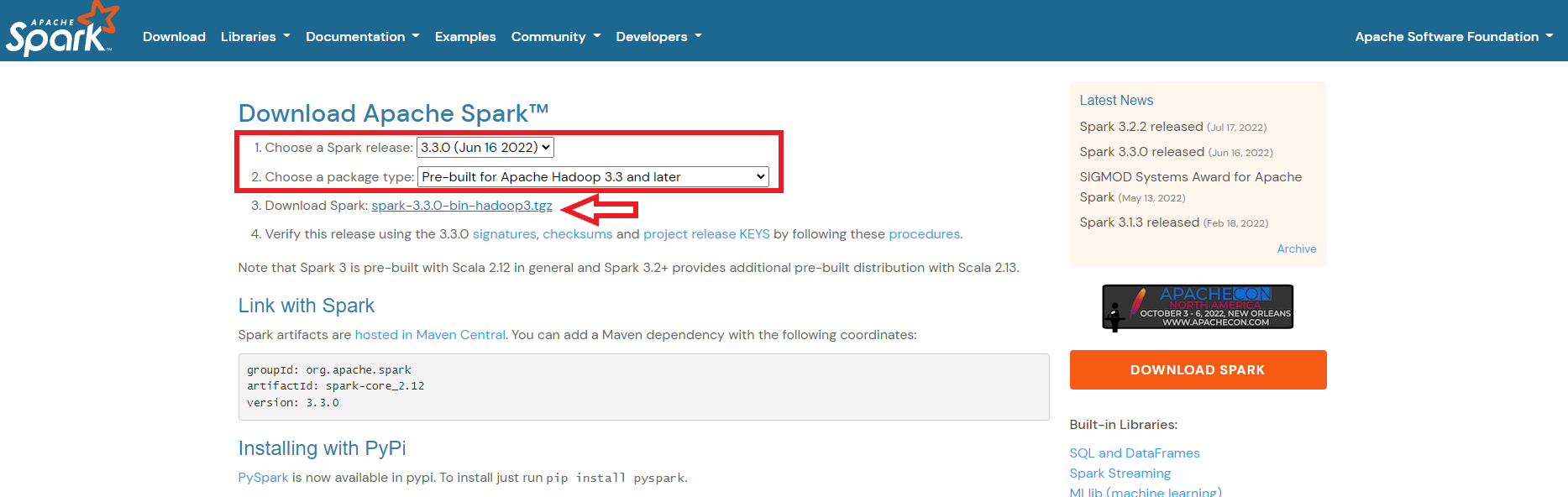

Apache

네모 박스 안에는 본인이 원하는 버전을 선택하면 되는데 나는 그냥 가장 최신 버전을 선택했다(package type은 꼭 pre-built를 고를것).

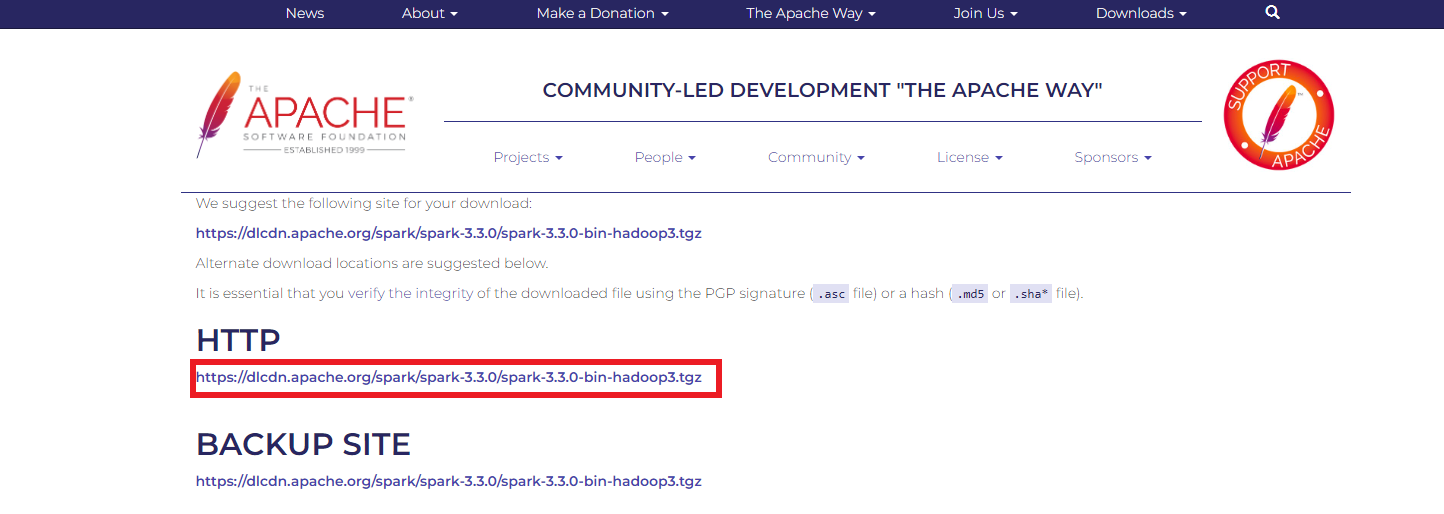

그리고 아래 화살표를 눌러 다운을 받으면 되는데, 어떤 링크가 나올 것이다. 그 페이지에서 아래 링크를 또 눌러 다운 받으면 된다. 나는 저장경로를 C:\spark\ 에 넣어주었다.

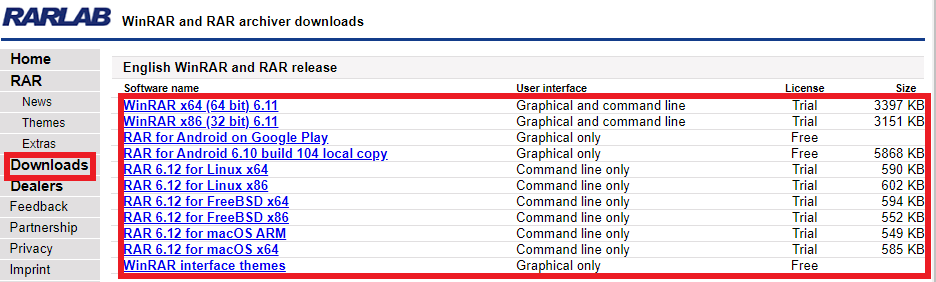

이 때, 다운로드 받은 폴더로 가면 .tgz로 파일이 압축되어 있는 걸 볼 수 있는데 요게 window 기반에서는 열기 어렵다. 따라서 여기로 가서 본인 운영체제에 맞는 RAR를 깔아주면된다.

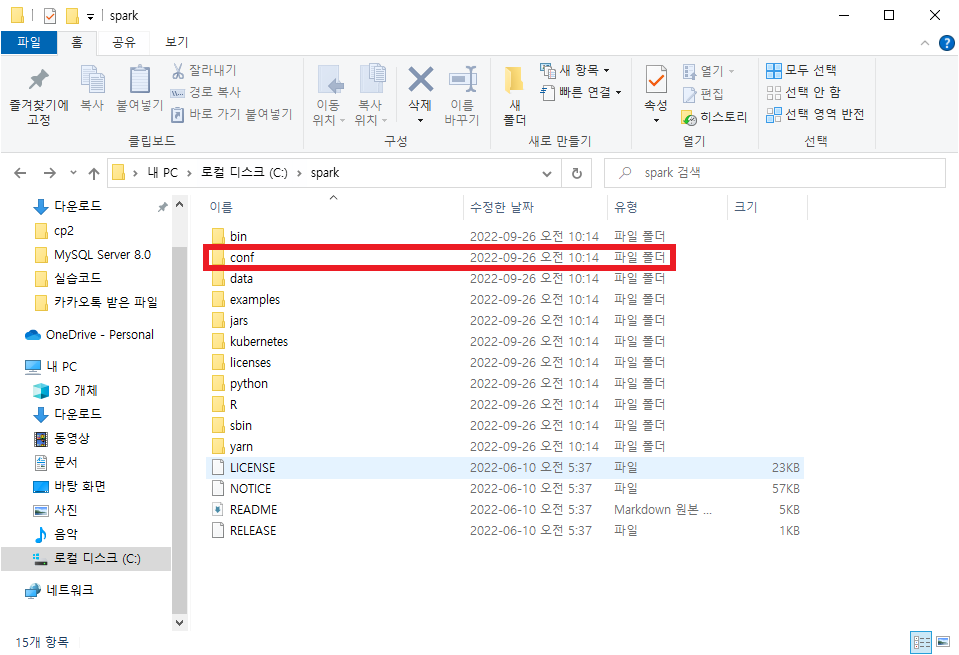

그리고 중요한 설정이 남아있다. Spark를 다운받은 폴더에 들어가면 conf라는 폴더가 있고

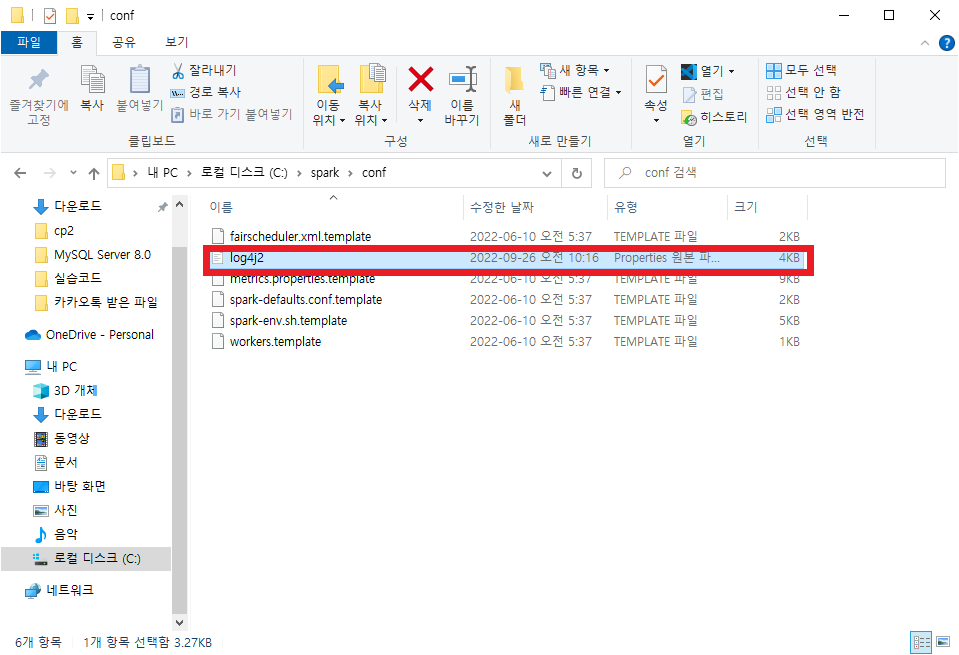

그 안에 log4.properties.template라는 파일이 있는데 이 파일을 log4.properties로 바꿔준다.

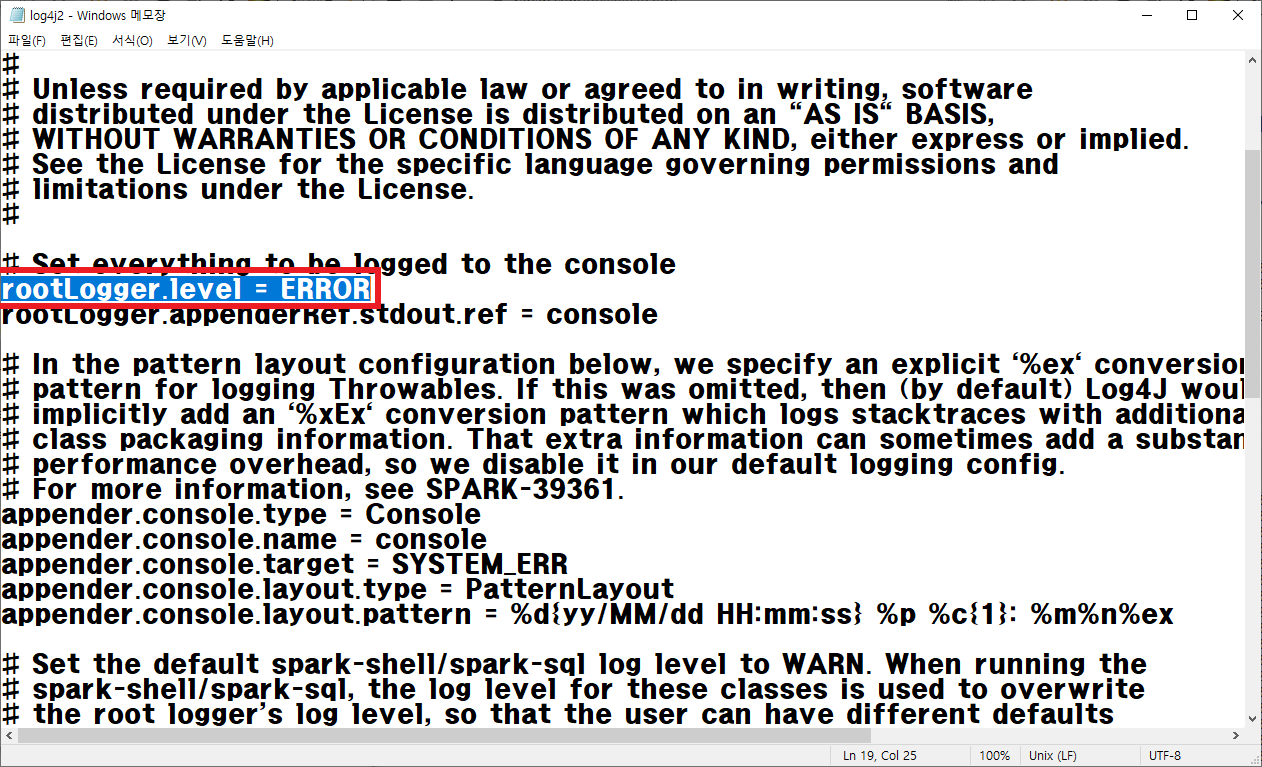

그리고 아래와 같이 내용을 바꿔준다.

이렇게 하면, 작업을 실행할 때 출력하는 모든 'logs span'의 클러터를 없앨 수 있다.

STEP4. winutils 설치(윈도우만)

C:\winutils\bin 폴더를 만들고 브라우저에 아래와 같이 입력 후 다운로드 받은 파일을 넣어준다.

sundog

이건 컴퓨터가 Hadoop이 있다고 착각하게 만드는 프로그램이라고 한다. Spark만 쓸 때는 굳이 Hadoop 전체를 깔 필요가 없어서 이걸 사용한다고 한다.

그 다음, 명령 프롬프트를 키고 아래와 같이 명령어를 입력한다.

mkdir c:\tmp\hive

cd c:\winutils\bin

winutils.exe chmod 777 c:\tmp\hive이렇게 입력해주면 Spark를 사용할 때 오류 없이 모든 작업을 수행할 수 있도록 파일의 사용권한을 얻은 것이다.

STEP5. 환경 변수 설정

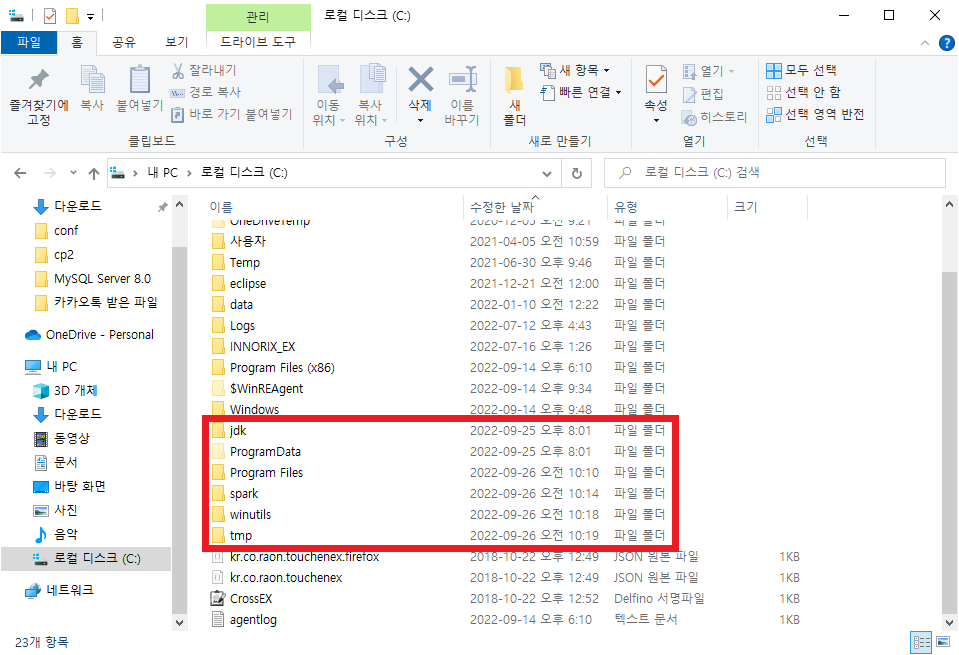

위의 STEP들을 모두 수행하고 나면, 나의 C드라이브에는 아래와 같은 폴더들이 잘 들어가있는 것을 확인할 수 있다.

그럼 정리해보면

JAVA는 C:\jdk\에

Spark는 C:\spark\에

winutils는 C:\winutils\에 들어가있다.

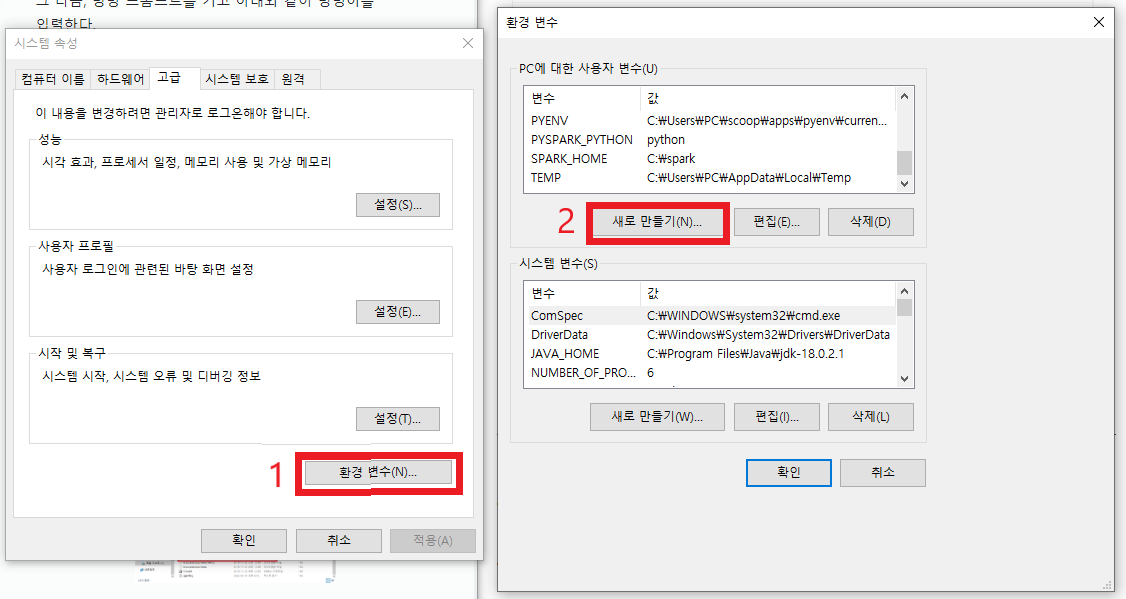

자 이제 이 주소들을 가지고 환경 변수 설정만 하면 완료이다. 제어판에서 시작 메뉴에서 시스템 환경 변수 편집(Window10 기준)을 눌러 켜준다.

그 다음 아래와 같이 눌러주고

이렇게 뜬 창에

본인이 java와 spark, winutils를 넣은 폴더의 경로를 넣어준다. 나의 경우

# jdk

변수 이름 : JAVA_HOME

변수 값 : C:\jdk\

# spark

변수 이름 : SPARK_HOME

변수 값 : C:\spark\

# spark를 사용할 수 있는 python 인터페이스(spark 안에 깔려있음)

# spark 3.* 이상 버전 사용자는 이걸 설정해줘야 한다.

변수 이름 : PYSPARK_PYTHON

변수 값 : python이렇게 입력해주었다.

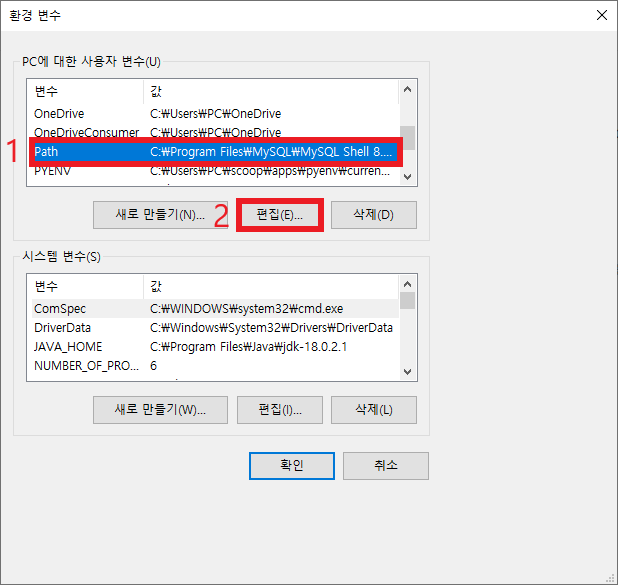

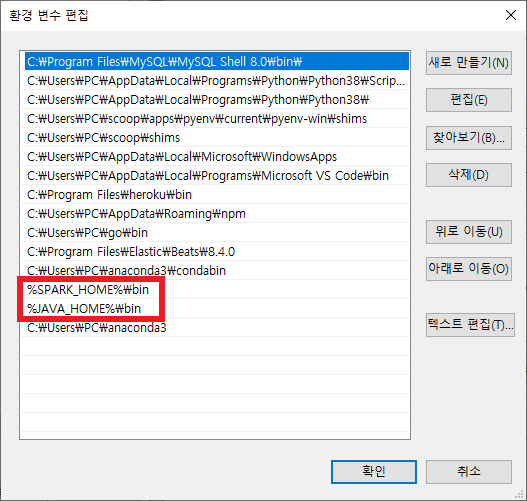

이 다음, 경로만 지정해주면 된다.

편집하기를 눌러 아래와 같이 추가해준다.

그럼 끝!!!

이제 확인해보자✅

나는 anaconda를 사용했기 때문에 anaconda 프롬프트를 열어주었지만 아닌 사람은 그냥 명령 프롬프트를 열면 된다.

그 다음 아래 명령어를 통해 pyspark를 실행해보자.

cd c:\spark\ # spark가 들어있는 폴더로 이동

ls # 어떤 파일이 있는지 확인

pyspark # pyspark 실행이랬을 때, 만약 잘 성공했다면 아래와 같은 화면이 뜰 것이다.

이 다음, 잘 사용하면 되는데 가끔 python 경로를 못 찾아 에러가 날 때가 있다. 이 때는 꼭 step5에서 이 부분을 시행해주자.

# spark를 사용할 수 있는 python 인터페이스(spark 안에 깔려있음)

# spark 3.* 이상 버전 사용자는 이걸 설정해줘야 한다.

변수 이름 : PYSPARK_PYTHON

변수 값 : python