1. 개요

- 가정 환경에서 로봇이 청소나 정리(tidying)와 같은 작업을 수행할 때, 사용자마다 다른 물건 정리 선호도를 빠르고 정확하게 학습하고 적용하도록 하는 방법을 제안

- 개인화(personalization)된 로봇 보조 시스템을 효율적으로 구축하기 위해, LLM의 요약(summarization) 능력을 활용하는 방법 제시

2. 연구 목적

- 개인화된 정리 규칙 학습

사람마다 다르게 정의된 규칙을 소수의 예제(’노란 셔츠는 서랍’, ‘검정 티셔츠는 옷장’..)만으로 빠르게 학습 → 보지 못한(unseen) 물건에 대해서도 일반화(generalization)하여 규칙을 적용할 수 있어야 함

- 로봇의 완전 자동화

LLM의 상식지식(commonsense knowledge) 및 요약 능력을 활용 → 추가 학습 없이 사용자 맞춤형 로봇 정리 시스템 구축

3. Method

3.1 Personalized receptacle selection

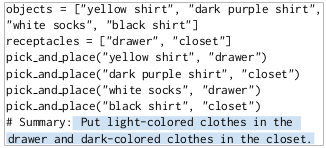

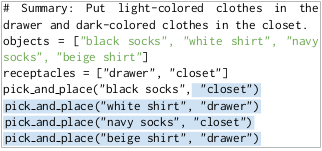

- 사용자의 입력(소수의 예제) → LLM 요약 → 일반화된 규칙 도출

- 사용자 입력: “노란 셔츠는 서랍에, 어두운 보라색 셔츠는 옷장에, 흰 양말은 서랍에”처럼 몇 가지만 제시

- LLM 요약(Summarization): LLM에게 위 예시들을 코드 형태로 주고, “이 규칙을 요약하라”고 요청하면, LLM이 일반화된 텍스트 요약(ex. 밝은색 옷은 서랍, 어두운색 옷은 옷장)을 제안

- 요약 규칙으로 새 물건 정리: 요약을 바탕으로 이전에 본 적 없는 새 물건에 대해서도 LLM이 어디에 둘지 추론

3.3 Real-world robotic system

- Object Detection: 오버헤드 카메라로 바닥에 흩어진 물건 위치 파악.

- 로봇 이동 및 카메라 인식: 가장 가까운 물건에 이동 후, 로봇 카메라로 물건을 클로즈업 촬영

- CLIP 모델로 물체 인식: CLIP 모델을 활용하여 해당 물건의 카테고리를 추출.

- CLIP: 이미지-텍스트 임베딩을 이용하는 모델로, 미리 학습된 거대한 텍스트·이미지 쌍 데이터로 범용 분류하는 모델

- LLM으로부터의 배치 위치·조작 결정: 요약 규칙(ex.과일은 검정 박스, 음료 캔은 재활용통)에 따라 해당 카테고리를 어디에 둘지, 어떤 동작(예: pick and place, pick and toss 등)을 쓸지 결정

- 로봇 동작: 로봇이 물건을 집고(reaching & grasp) 해당 위치로 이동하여 내려놓거나(tidy) 던져 넣는(toss) 행위를 수행

4. Experiments

4.1 Benchmark dataset

- 벤치마크 시나리오: 저자들은 텍스트 기반의 96개 시나리오를 만들어서, 각 시나리오마다 “학습용 예제(Seen)”와 “테스트용 예제(Unseen)”를 구분

- 기준 성능: 예제에 보이지 않은 물건(Unseen)을 올바른 수납 장소로 분류할 수 있는지(정확도)로 평가

- 결과: 단순히 예시만 외워서 그대로 적용하는 방식, WordNet 기반, 텍스트 임베딩(RoBERTa, CLIP) 등을 활용한 일반화 기법에 비해, LLM 요약 방식을 썼을 때가 91.2%로 높은 정확도를 보임

4.2 ~ 4.5 Results

- 벤치마크 전반 성능

- LLM 요약 기법은 91.2%로 최고 성능

- 사용자들이 실제로 선호하는 정리 규칙에 대해, LLM이 중간 요약을 거쳐 일반화가 더 잘 된다는 점을 보여줌.

- 실제 로봇 실험

- 실내 환경에서 85.0%의 성공률로 의도한 장소에 물건 배치 성공.

- 물체 분류 단계(CLIP) 정확도는 약 95.5% 수준(LLM이 요약한 카테고리 기준). 다른 시각언어 모델(ViLD, OWL-ViT 등) 대비 나은 결과를 보임.

- 사람 대상 비교

- 사용자에게 정리 결과를 보여주었을 때, LLM 요약 기반 정리가 더 자연스럽고 선호된다고 응답.

- 사람들의 주관적 평가 역시 벤치마크 정답과 82~95% 이상 일치함.

4.6 Limitations

- 한계

- LLM 요약이 가끔 요약에 실패해 특정 객체만 그대로 열거하는 경우가 있으며, 이때는 일반화가 안됨.

- 로봇 쪽 구현에서도 더 복잡한 조작이 필요할 수 있으나 pick and place/pick and toss에 집중되어 있음.

- 과도하게 지저분한(excessive clutter)환경에서는 로봇이 대상 물건에 접근하기 어려움

- 의의

- 로봇에게 개인화된 작업 수행 능력을 부여한다는 점.

- 광범위한 언어 사전 지식을 갖춘 LLM을 추가 학습 없이 바로 활용해도, 실제 로봇 작업에 큰 도움이 된다는 점.

- 향후 가정용 로봇이 사람과 자연스럽게 협력하고, 사용자마다 다른 취향/규칙에 빠르게 적응하도록 하는 기초가 될 수 있음.

5. Conclusion

- 소수의 사용자 예시 → LLM을 이용해 요약 → 일반화된 규칙 도출 → 처음 보는 물건에 대해서도 같은 기준으로 정리 위치를 결정

- 요약은 CLIP모델에게 전달되어 카메라에서 물건을 해당 기준에 맞춰 분류해 배치

- 벤치마크 실험 결과

- LLM 요약 방식은 이전 방식(온톨로지 활용, 텍스트 임베딩 유사도 등)보다 훨씬 높은 정확도(91.2%)로 새 물체의 배치를 예측

- TidyBot을 통해 약 85%의 정리 성공률을 기록

- LLM이 내재한 요약/추론 능력이 실제 로봇 조작에서도 큰 도움이 될 수 있음을 보여주며, 개인화된 로봇 어시스턴트를 구현하는데 효과적인 접근임을 입증.