해당 내용은 Andrew NG의 Machine Learning 강의를 참고하였습니다.

강의 슬라이드는 해당 강의에 포함되어 있습니다.

Backpropagation

"Backpropagation"은 logistic 및 linear regression에서 gradient descent를 했던 것처럼 cost function을 최소화하기 위한 neural network의 용어입니다.

cost function을 최소화하기 위해 Θ에서 optimal parameter를 구하고 싶고, 이를 위해 편미분 과정을 보여줍니다.

Backpropagation Algorithm은 total error에 대해 각각의 weight들이 얼마만큼의 비중을 차지하는지 편미분을 통해 구한 다음 거꾸로 빼주면서 성능을 개선하는 방식이기 때문입니다.

-

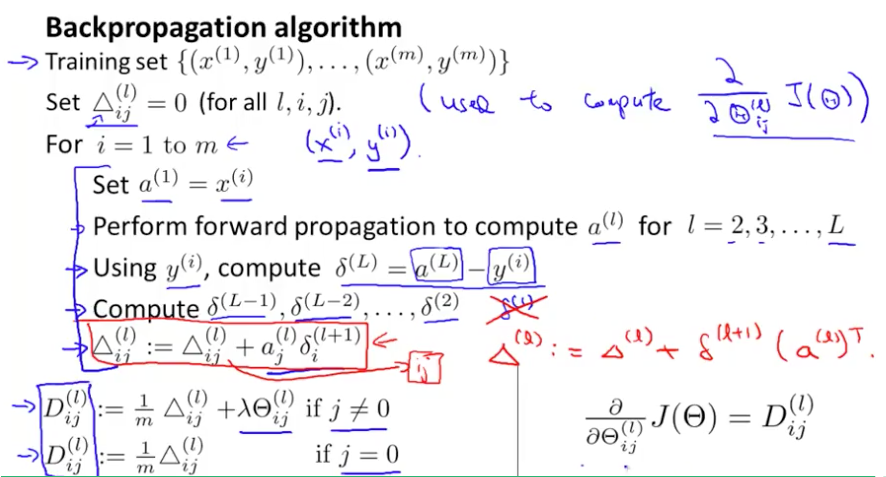

delta vector를 도입하여 모든 값을 0으로 초기화합니다.

이 delta vector는 갱신될 weight을 축적하는 역할 (cost function의 gradient 값으로 사용합니다.)

-

모든 parameter에 대해 Forward Propagation을 수행합니다. 그래야 Total error를 구할 수 있고, Total error로부터 Backpropagation이 시작하기 때문에

-

가설함수 결과에서 y값을 뺀 오류를 계산한다.

-

vector 성질을 이용해 delta를 계산한다.