Hyperparameter Tuning

: 딥러닝 학습을 할 때 사람이 지정해야 되는 여러가지 parameter들

성능을 높이는법

- 데이터를 추가하거나 바꾸기

- 모델 바꾸기

- 하이퍼파라미터 튜닝

Hyperparameter Tuning

- 모델 스스로 학습하지 않는 값은 사람이 지정(learning rate, 모델의 크기, optimizer 등)

- 하이퍼 파라메터에 의해서 값이 크게 좌우 될 때도 있음(요즘은 그렇지 않음)

- 마지막 0.01을 쥐어짜야 할 때 도전해볼만하다!

- 최근에는 베이지안 기반 기법들이 주도한다.(BOHD)

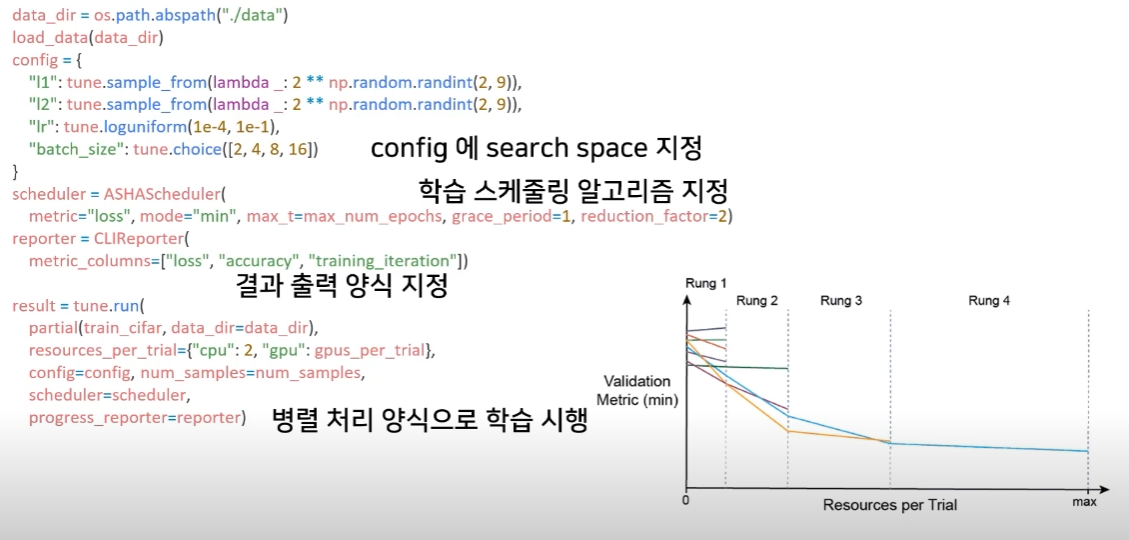

Ray

- multi-node multi processing 지원 모듈

- ML/DL의 병렬 처리를 위해 개발된 모듈

- 기본적으로 현재의 분산병렬 ML/DL 모듈의 표준

- Hyperparameter Search를 위한 다양한 모듈 제공