checkpoints

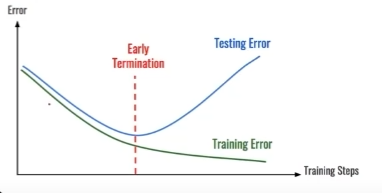

- 학습의 중간 결과를 저장하여 최선의 결과를 선택

- earlystopping 기법 사용시 이전 학습의 결과물을 저장(epoch가 100인데 50번째 값이 가장 좋다면 50번째 값이 저장이 되어있어야한다. 이때 필요한 것이다.)

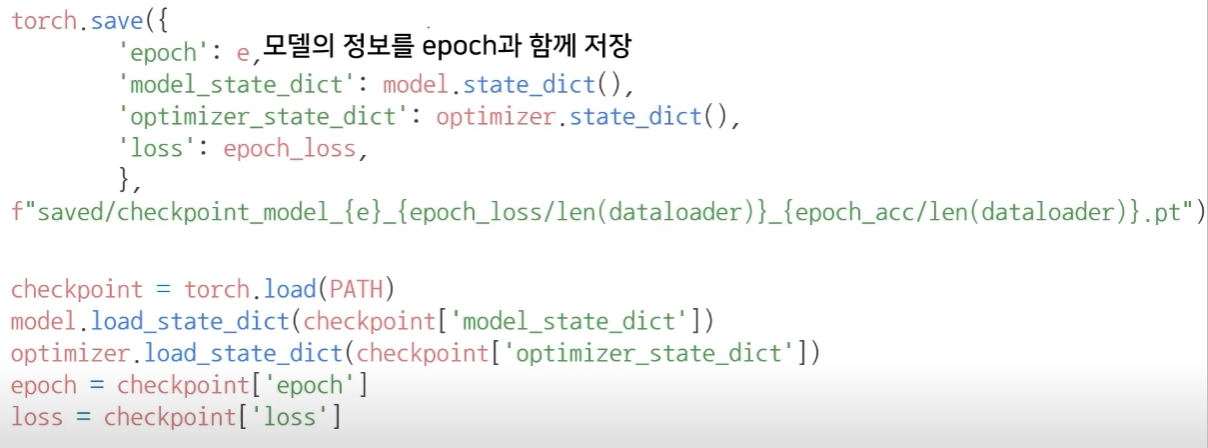

- loss와 metric 값을 지속적으로 확인 저장

- 일반적으로 epoch, loss, metric을 함께 저장하여 확인

- colab에서 지속적인 학습을 위해 필요

- dict 타입으로 저장

f'saved/checkpoint_model_{e}_{epoch_loss/len(dataloader)}/_{epoch_acc/len(dataloader)}.pt'- 파일 저장을 이런식으로 하면 loss와 accuracy를 한번에 볼 수 있어서 파일명만으로도 성능을 알 수 있다.