Abstract

GAN(Generative Adversarial Networks)은 컴퓨터 비전, 그래픽, 머신러닝의 광범위한 문제에서 뛰어난 성능을 보여주지만 대부분 대량의 훈련 데이터와 막대한 컴퓨팅 리소스를 필요로 한다.

이러한 문제를 해결하기 위해 Transfer learning을 도입하는데, transfer learning은 overfitting되기 쉽거나 small distribution 이동을 학습하는데에 있어 제한적이라는 문제점이 존재한다.

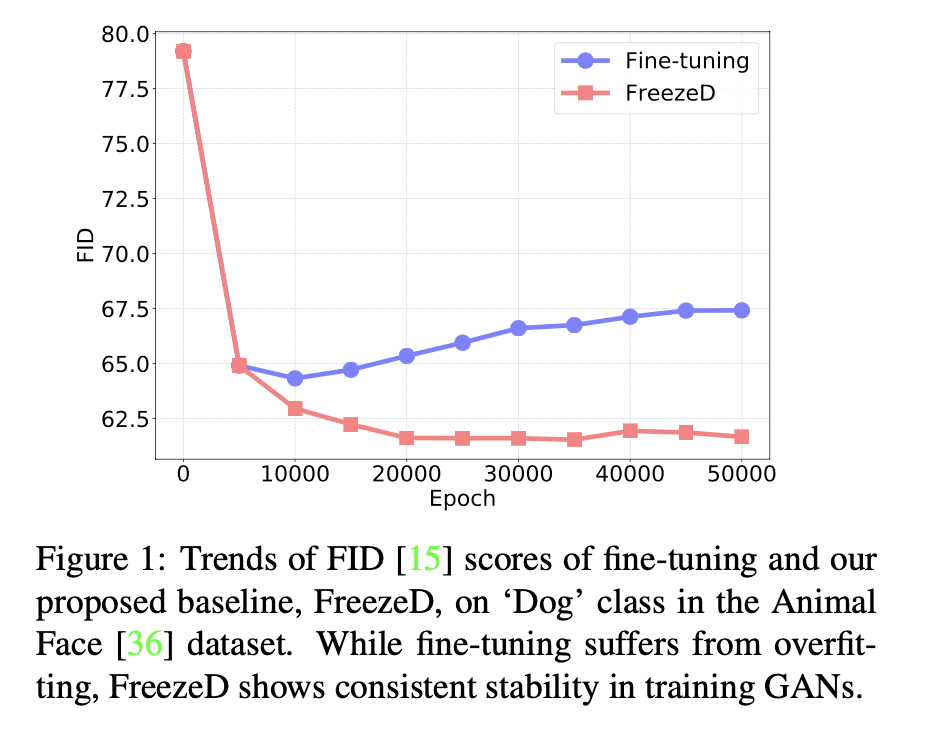

이 논문에서 제안하고 있는 것은 Discriminator의 lower layer를 고정한 상태에서의 간단한 fine-tuning이다. 이를 FreezeD라고 칭하고 있고, 이전에 제안된 기술보다 좋은 성능을 보인다고 말한다.

Introduction

Abstract에서 서술한 바와 유사한 맥락이다. GAN은 컴퓨터 비전, 그래픽, 머신러닝의 광범위한 문제에서 뛰어난 성능을 보이지만, 대량의 훈련 데이터와 막대한 컴퓨팅 리소스를 필요로 하기 때문에 적용 가능성이 제한되는 한계가 존재한다. 이러한 한계를 극복하기 위해 다음과 같은 기술들이 제안되었다.

- transferring knowledge of a well- trained source model

- learning meta-knowledge for quick adaptation to a target domain

- using an auxiliary task to facilitate training

- improving an inference procedure of suboptimal models

- using an expressive prior distribution, actively choosing samples to give supervision for conditional generation

- actively sampling mini-batches for training

- transfer learning

위와 같은 접근 방식 중 transfer learning은 제한된 데이터와 리소스에서 모델을 훈련하는 가장 좋은 방법 중 하나라 할 수 있다. 실제로 최근의 딥러닝 성공의 대부분은 supervised 또는 self-supervised 방식으로 대규모 데이터셋에 대해 pre-training된 강력한 backbone을 기반으로 한다.

여러 방법이 GAN 훈련에 대한 transfer learning 접근을 제안하지만, 이는 제한된 훈련 데이터로 overfitting되거나 significant distribution을 학습하는데 robust하지 않은 경우가 있다.

이 논문에서는 Discriminator의 low layer가 freeze된 GAN의 fine-tuning이 높은 성능을 보인다고 말한다.

직관적으로 Discriminator의 하위 계층은 이미지의 일반적 특징을 학습하고, 상위 계층은 추출된 특징을 기반으로 이미지가 real인지 fake인지 분류하는 방법을 학습한다.

feature extractor와 classifier에 대한 이분법적 관점은 training classifiers에서 널리 사용되어왔던 방법이다. 논문 저자는 이 방법이 GAN에도 유의미하게 작동함을 확인하였고, 적절한 기준선을 제안하고 있다.

Method

GAN의 fine tuning을 위해 사용되었던 transfer learning의 방법은 다음과 같다.

- Fine tuning

- 초기 가중치를 pre-trained model의 가중치로 설정하여 학습 진행

- 직관적이고 효과적이지만, overfitting에 취약함

*** 기존 방법들에 한계가 있다는 이야기인데 지금 과제에선 안 중요해서 일단 생략

Conclusion

GAN의 transfer learning을 위해 FreezeD를 도입하였는데, FreezeD는 Discriminator를 feature extractor와 classifier로 분할한 다음 classifier만 미세 조정하는 방법이다.

- Discriminator의 feature extractor의 전이성은 생성된 이미지의 universal detector로 사용할 수 있다.

- 이것보다 더 좋은 방법: feature distillation

결론은 Discriminator의 lower layer를 고정한 상태에서 파인튜닝한 것이 기존의 파인튜닝보다 더 좋은 성능을 낸다는 것이다.