Focus, Pinhole and Lens

이번에는 카메라에 대해서 자세하게 살펴보고자 한다. 먼저 우리가 흔히 사용하는 디지털 카메라가 아니라 좀 더 원시적인 pinhole 카메라에 대해서 알아볼 것이다. 그래서 가장 먼저 focus와 pinhole, 그리고 lens 사이의 관계에 대해서 알아볼 것이다. Pinhole 카메라는 생각보다 역사가 오래되었다. 중국의 기록에 따르면 약 2400년 정도 되었다. Pinhole 카메라는 박스 형태의 구조에 카메라 모델을 실제로 사용을 하기도 하지만, 그 전에는 건물을 카메라로 사용했었다. 바깥 장면을 구멍을 pinhole만큼 뚫어서 상이 맺히도록 카메라를 사용했다.

Pinhole 카메라는 빛이 들어오는 방향을 pinhole을 투과하는 것을 반대편의 벽에 쏴서 image를 투사하는 것이다. 빛이 광원에서부터 물체에 부딪히고나서 빛이 나가는 방향은 모든 방향에 대해서 튕겨져 나가게 된다. 그렇기 때문에 특정 point에 맺혀져야 하는 상은 하나의 광원에서 오는 것이 아닌 여러 곳에서 광자가 오게 된다. Object의 한 위치에서 오는 빛뿐만 아니라 다른 위치에서 오는 빛들이 모두 뭉치게 되면서 상이 이상하게 맺히게 된다. 그래서 결국 우리 눈에는 분명하게 보이지 않을 것이다.

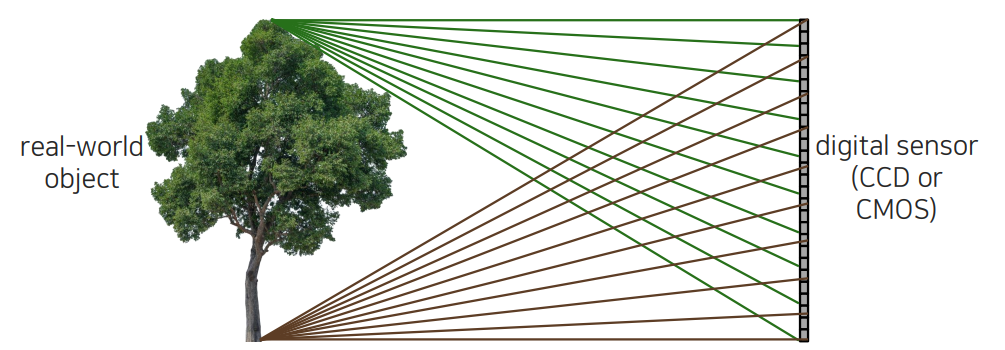

Bare-sensor imaging

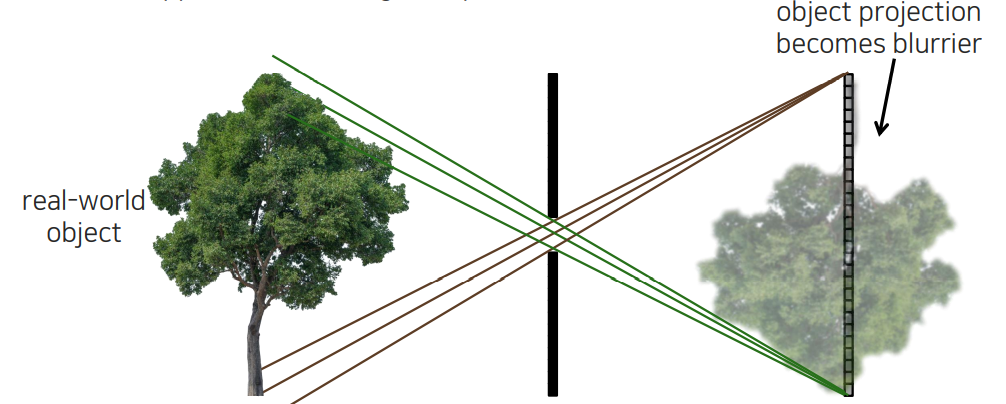

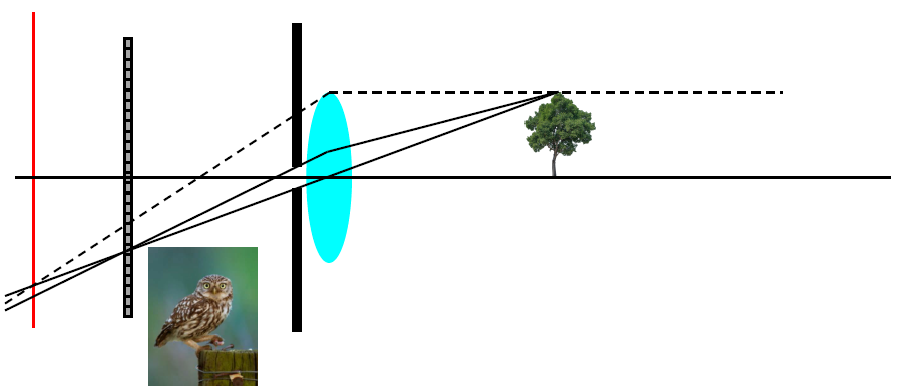

디지털 센서가 있을 때, 우리는 위와 같은 image를 찍고자 한다. 그냥 이 나무를 찍는다고 하면 광원이 위와 같이 여러 방향으로 튕겨져 나갈 것이다. 디지털 센서에 하나의 빛만 도달하여 하나의 색상만 결정되면 좋을 것이다. 하지만 실제로는 여러 빛이 도달하여 하나의 pixel 값을 결정하는 것이 어려울 것이다.

디지털 센서가 있을 때, 우리는 위와 같은 image를 찍고자 한다. 그냥 이 나무를 찍는다고 하면 광원이 위와 같이 여러 방향으로 튕겨져 나갈 것이다. 디지털 센서에 하나의 빛만 도달하여 하나의 색상만 결정되면 좋을 것이다. 하지만 실제로는 여러 빛이 도달하여 하나의 pixel 값을 결정하는 것이 어려울 것이다.

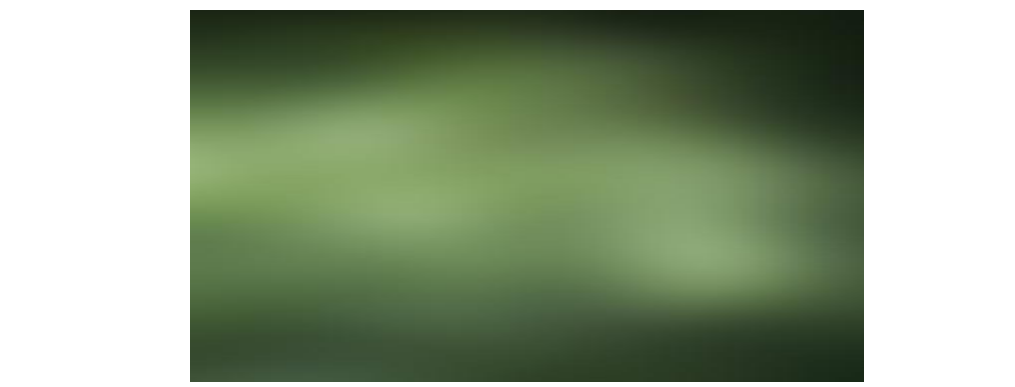

그래서 우리가 눈으로 관찰하고자 하는 결과가 전부 섞여서 제대로 볼 수 없는 것이다. 모든 장면으로부터 빛이 들어오기 때문에 위와 같이 이상한 결과가 만들어지게 된다. 어디서부터 도달한 값인지 위치를 특정할 수 없어서 상이 맺혀지지 않게 된다.

그래서 우리가 눈으로 관찰하고자 하는 결과가 전부 섞여서 제대로 볼 수 없는 것이다. 모든 장면으로부터 빛이 들어오기 때문에 위와 같이 이상한 결과가 만들어지게 된다. 어디서부터 도달한 값인지 위치를 특정할 수 없어서 상이 맺혀지지 않게 된다.

Pinhole imaging

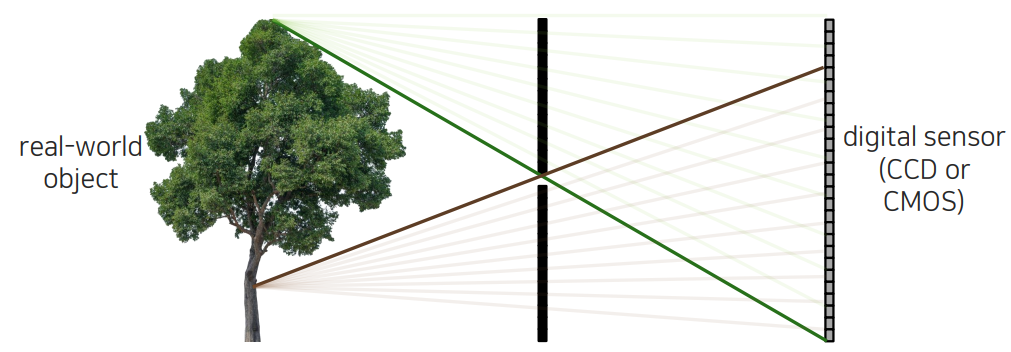

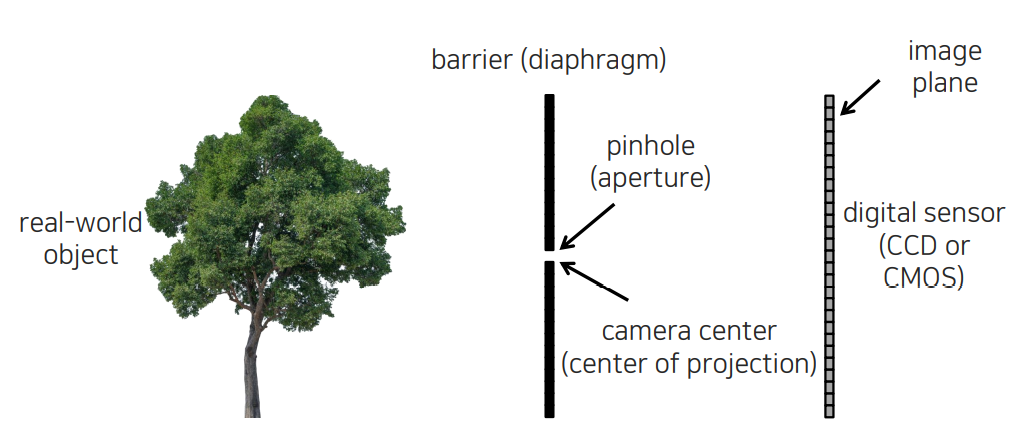

그렇다면 상을 만들어주게 되는 pinhole 카메라의 원리는 우선 위와 같이 barrier를 하나 세워두고 가운데 pinhole을 뚫어놓을 것이다. 이 구멍을 우리는 aperture라고 부를 것이다. 센서와 object 사이에 aperture를 두게 됨으로써 생기는 효과는 먼저 빛이 튕겼을 때 아직까지는 사방으로 튕겨져 나가겠지만 pinhole을 통과하는 빛은 소수로 정해져있을 것이다. Barrier가 나머지 빛을 막아주기 때문이다. 이러한 식으로 여러 곳에서 튕긴 빛의 대다수는 barrier에 의해서 막히게 될 것이다. 이렇게 되면 특정 pixel에는 특정 위치의 색상만 저장하게 될 것이다. 하나의 pixel에 하나의 색상이 정해지면서 다음과 같이 상이 맺히게 될 것이다.

그렇다면 상을 만들어주게 되는 pinhole 카메라의 원리는 우선 위와 같이 barrier를 하나 세워두고 가운데 pinhole을 뚫어놓을 것이다. 이 구멍을 우리는 aperture라고 부를 것이다. 센서와 object 사이에 aperture를 두게 됨으로써 생기는 효과는 먼저 빛이 튕겼을 때 아직까지는 사방으로 튕겨져 나가겠지만 pinhole을 통과하는 빛은 소수로 정해져있을 것이다. Barrier가 나머지 빛을 막아주기 때문이다. 이러한 식으로 여러 곳에서 튕긴 빛의 대다수는 barrier에 의해서 막히게 될 것이다. 이렇게 되면 특정 pixel에는 특정 위치의 색상만 저장하게 될 것이다. 하나의 pixel에 하나의 색상이 정해지면서 다음과 같이 상이 맺히게 될 것이다.

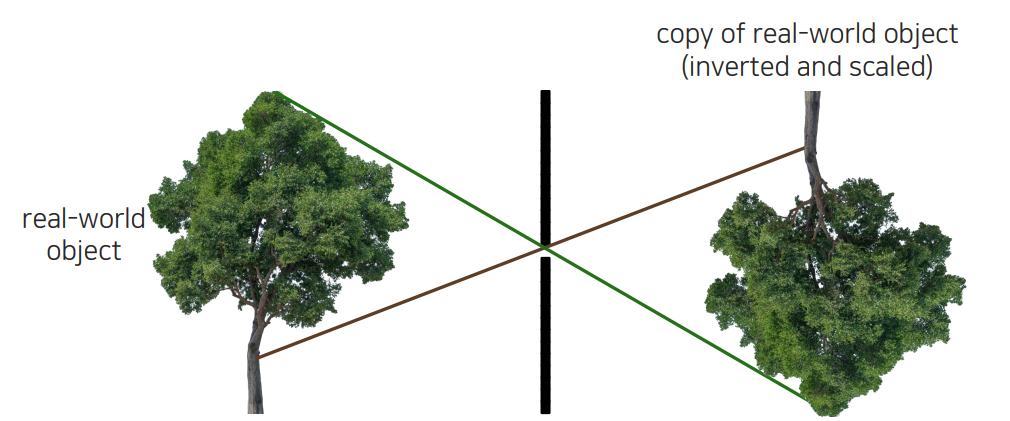

하지만 실제로 맺히는 상은 거꾸로 뒤집히고 거리에 따라서 적절하게 scale이 변한 형태일 것이다.

하지만 실제로 맺히는 상은 거꾸로 뒤집히고 거리에 따라서 적절하게 scale이 변한 형태일 것이다.

Pinhole camera terms

Pinhole 카메라 모델에서 용어를 다시 정리해보고자 한다. 카메라의 센서 부분을 image plane이라 부른다. 이 image plane은 나중에 하드웨어와 직접적으로 연관이 있는 센서뿐만 아니라 추상적으로 생각할 수 있는 상이 맺히는 plane을 의미하게 된다. 이는 필름, 디지털 센서, 벽 등 상이 맺히는 plane을 이야기하는 것이다. Pinhole을 보면 빛들이 들어오고 지나가게 되는데, 이는 곧 원점처럼 제약이 걸려 있는 위치가 되고 이를 camera center 혹은 center of projection이라고 한다. 모든 빛은 여기를 통과하게 되는 것이다.

Pinhole 카메라 모델에서 용어를 다시 정리해보고자 한다. 카메라의 센서 부분을 image plane이라 부른다. 이 image plane은 나중에 하드웨어와 직접적으로 연관이 있는 센서뿐만 아니라 추상적으로 생각할 수 있는 상이 맺히는 plane을 의미하게 된다. 이는 필름, 디지털 센서, 벽 등 상이 맺히는 plane을 이야기하는 것이다. Pinhole을 보면 빛들이 들어오고 지나가게 되는데, 이는 곧 원점처럼 제약이 걸려 있는 위치가 되고 이를 camera center 혹은 center of projection이라고 한다. 모든 빛은 여기를 통과하게 되는 것이다.

Focal length

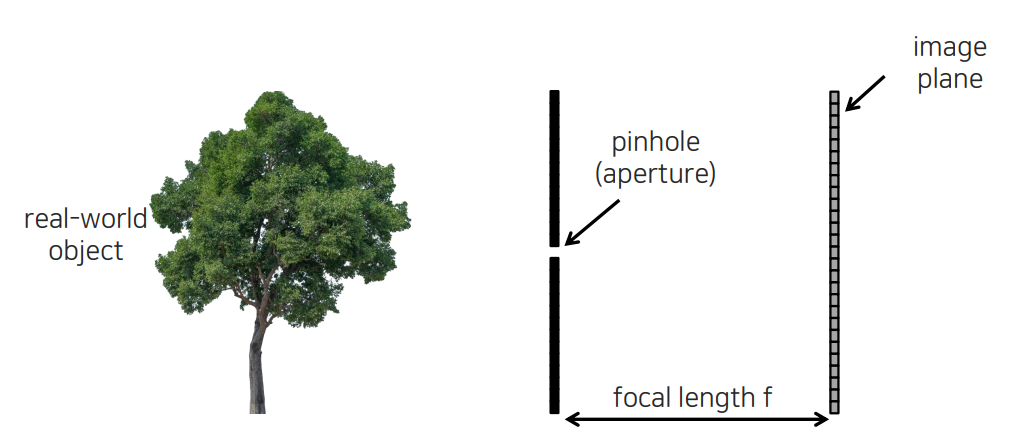

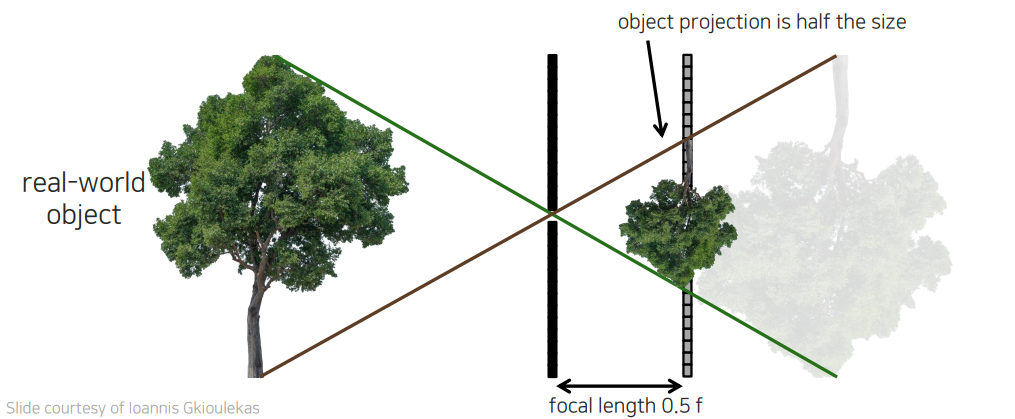

카메라의 중심과 image plane 사이의 거리를 pinhole 모델에서 우리는 focal length라고 부른다. 이 개념은 매우 중요하다. Focal length가 조금 짧아지면 image plane이 pinhole과 가까워지게 된다. 그렇게 되면 발생하는 현상으로는 상이 맺히는 scale이 작아지게 될 것이다.

카메라의 중심과 image plane 사이의 거리를 pinhole 모델에서 우리는 focal length라고 부른다. 이 개념은 매우 중요하다. Focal length가 조금 짧아지면 image plane이 pinhole과 가까워지게 된다. 그렇게 되면 발생하는 현상으로는 상이 맺히는 scale이 작아지게 될 것이다.

즉, focal length와 object의 크기는 비례 관계를 가지게 된다.

즉, focal length와 object의 크기는 비례 관계를 가지게 된다.

Pinhole size

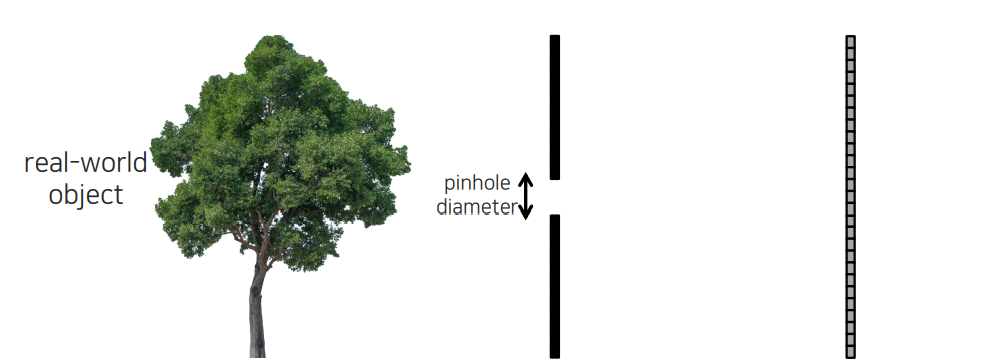

이번에는 pinhole diameter의 크기에 따라서 어떻게 상이 맺히는지 알아보고자 한다. 가장 이상적인 pinhole은 정말로 작은 구멍을 하나 뚫어놓고 빛이 하나 정도 지나가게 하는 것이다. 하지만 광자가 얼마나 떨어져야 intensity가 1이 올라가는 그 민감도가 그렇게 높지 않다. 전자기기가 광자에 민감하지 않기 때문에 pinhole 크기를 너무 작게하면 상이 맺히지 않아 어느정도 벌려줘야 한다. 여기서 약간의 trade-off가 발생하게 된다.

이번에는 pinhole diameter의 크기에 따라서 어떻게 상이 맺히는지 알아보고자 한다. 가장 이상적인 pinhole은 정말로 작은 구멍을 하나 뚫어놓고 빛이 하나 정도 지나가게 하는 것이다. 하지만 광자가 얼마나 떨어져야 intensity가 1이 올라가는 그 민감도가 그렇게 높지 않다. 전자기기가 광자에 민감하지 않기 때문에 pinhole 크기를 너무 작게하면 상이 맺히지 않아 어느정도 벌려줘야 한다. 여기서 약간의 trade-off가 발생하게 된다.

Pinhole diameter를 조금 키우면 하나의 pixel에 들어오는 빛이 많아지게 된다. 특정 point 근처에 있는 빛의 광자들이 한 곳에 떨어지게 된다. 그래서 하나의 pixel은 해당 영역에 있는 빛의 양을 고려해서 색상을 결정하게 된다. 기본적으로 pixel 값이 결정될 때 exposure 시간만큼 integral을 통해서 측정하게 된다. 시간의 변화량 만큼 축적해서 결정이 되기 때문에 평균을 내거나 합쳐지게 될 것이다. 그래서 diameter가 커지면 커질수록 그 값들이 뭉쳐져서 blur된 결과를 보여줄 것이다.

Pinhole diameter를 조금 키우면 하나의 pixel에 들어오는 빛이 많아지게 된다. 특정 point 근처에 있는 빛의 광자들이 한 곳에 떨어지게 된다. 그래서 하나의 pixel은 해당 영역에 있는 빛의 양을 고려해서 색상을 결정하게 된다. 기본적으로 pixel 값이 결정될 때 exposure 시간만큼 integral을 통해서 측정하게 된다. 시간의 변화량 만큼 축적해서 결정이 되기 때문에 평균을 내거나 합쳐지게 될 것이다. 그래서 diameter가 커지면 커질수록 그 값들이 뭉쳐져서 blur된 결과를 보여줄 것이다.

Exposure time

또 하나 중요한 개념은 바로 exposure time이다. 실내의 경우에는 20분을 넘게 찍어도 대부분의 빛을 막기 때문에 exposure time을 길게해야 겨우 명암 정도를 보게되는 결과를 만들어낸다. 실내에서는 빛의 양이 굉장히 적기 때문이다. 실외에서는 빛의 양이 많기 때문에 exposure time이 짧아도 괜찮은 결과를 만들어낼 수 있다. 하지만 2초마저도 굉장히 긴 시간에 해당된다. 실제로는 이러한 exposure를 2초 동안 열어놓고 손으로 잡고 있으면 손이 떨리게 되어 blur가 발생할 것이다. 그래서 pinhole 카메라로 단시간에 고화질의 사진을 찍는 것은 굉장히 어려운 부분이다.

또 하나 중요한 개념은 바로 exposure time이다. 실내의 경우에는 20분을 넘게 찍어도 대부분의 빛을 막기 때문에 exposure time을 길게해야 겨우 명암 정도를 보게되는 결과를 만들어낸다. 실내에서는 빛의 양이 굉장히 적기 때문이다. 실외에서는 빛의 양이 많기 때문에 exposure time이 짧아도 괜찮은 결과를 만들어낼 수 있다. 하지만 2초마저도 굉장히 긴 시간에 해당된다. 실제로는 이러한 exposure를 2초 동안 열어놓고 손으로 잡고 있으면 손이 떨리게 되어 blur가 발생할 것이다. 그래서 pinhole 카메라로 단시간에 고화질의 사진을 찍는 것은 굉장히 어려운 부분이다.

Light efficiency

그렇다면 이제는 light efficiency에 대해서 살펴볼 필요가 있다. 방금 전에 보았듯이 pinhole 카메라의 경우 exposure time이 불리한 면이 존재한다. 그래서 지금부터는 각각의 변화에 따른 light efficiency를 확인해보고자 한다. Pinhole diameter를 크게 만들거나 focal length를 키우면 light efficiency는 어떻게 변할까?

Pinhole diameter를 2배를 키우게 되면 빛의 효율이 4배가 높아지게 된다. 그리고 focal length를 2배 키우게 되면 빛의 효율이 4분의 1배가 될 것이다. 왜 이렇게 될까? Pinhole diameter를 키우는 만큼 그 면적은 제곱만큼 증가하게 된다. 그래서 diameter를 2배를 키우면 그 제곱인 4배의 효율이 생기는 것이다. Focal length의 경우에는 커지면 커질수록 맺히는 object의 크기가 커지게 되는데, 이는 image plane에 도달하는 빛의 양이 적어지게 될 것이다. 이 또한 면적과 관련이 있기 때문에 빛의 효율이 그 제곱만큼 반대로 되게 되는 것이다. 이를 종합해보면 pinhole diameter를 2배 키우고 focal length를 2배 줄이면 비슷한 선명도의 결과를 만들어낼 수 있다.

The lens camera

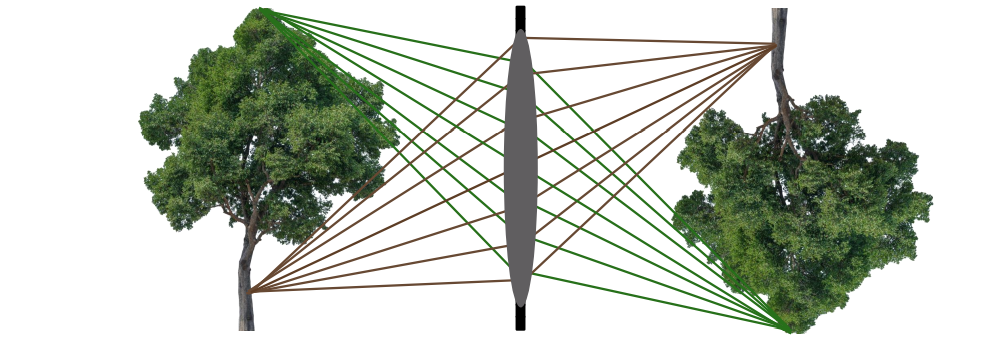

Pinhole의 크기를 키우게 되면 blurry해지고, focal length를 바꾸게 되면 영상의 크기가 달라지게 된다. 이러한 것들을 다 유지하면서 빛의 효율성을 어떻게하면 높일 수가 있을까? 바로 렌즈를 사용하는 것이다. 렌즈를 사용하게 되면 빛 광선들의 묶음이 하나의 point로 수렴하게 만들어준다. 즉, 빛을 모아주는 역할을 렌즈가 하는 것이다. 빛이 사방으로 퍼지게 되는데 렌즈는 하나의 pixel로 다시 모아주는 역할을 한다. 이는 빛의 효율 측면에서 굉장히 좋은 장치가 된다. 그래서 이러한 부분이 pinhole 카메라 대신에 lens 카메라를 사용하는 이유이다.

Pinhole의 크기를 키우게 되면 blurry해지고, focal length를 바꾸게 되면 영상의 크기가 달라지게 된다. 이러한 것들을 다 유지하면서 빛의 효율성을 어떻게하면 높일 수가 있을까? 바로 렌즈를 사용하는 것이다. 렌즈를 사용하게 되면 빛 광선들의 묶음이 하나의 point로 수렴하게 만들어준다. 즉, 빛을 모아주는 역할을 렌즈가 하는 것이다. 빛이 사방으로 퍼지게 되는데 렌즈는 하나의 pixel로 다시 모아주는 역할을 한다. 이는 빛의 효율 측면에서 굉장히 좋은 장치가 된다. 그래서 이러한 부분이 pinhole 카메라 대신에 lens 카메라를 사용하는 이유이다.

Pinhole camera

이번에는 pinhole 카메라와 lens의 관계에 대해서 알아보고자 한다. Pinhole 카메라의 경우 image plane까지 빛이 직선으로 pinhole을 지나가게 된다. Pinhole 카메라의 경우 직선 하나만 plane에 닿기 때문에 빛의 양이 제한적이다. 빛의 효율성이 낮기 때문에 이를 높이려고 고안한 것이 바로 lens 카메라이다. Pinhole 카메라와 lens 카메라는 빛을 다루는 특성이 서로 다르다. 두 카메라 모델 중에서 유사한 공통점이 있는 것이 바로 central ray의 행동이다. Lens나 pinhole 가운데를 지나가는 ray는 동일한 물리적인 특성을 가지기 때문에 central ray를 분석함으로써 object가 어떻게 상이 맺히는지를 파악할 수 있다.

Lens와 pinhole 카메라의 특성이나 상이 맺히는지에 대한 설명은 central ray로부터 가능하고, 우리는 앞으로 여러 성질에 대해서 이야기하기 위해서 lens 카메라가 focus가 맞춰져 있다고 가정할 것이다.

Lens와 pinhole 카메라의 특성이나 상이 맺히는지에 대한 설명은 central ray로부터 가능하고, 우리는 앞으로 여러 성질에 대해서 이야기하기 위해서 lens 카메라가 focus가 맞춰져 있다고 가정할 것이다.

Thin lens optics

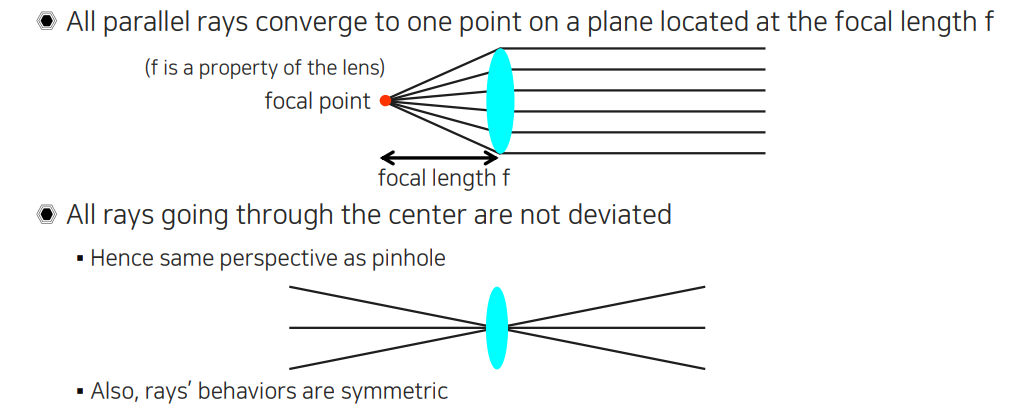

Lens의 종류에 따라 두꺼운 것도 있고 얇은 것도 있다. 이중에서 좀 더 얇은 lens들이 빛이 투과하는 특성 등을 모델링하기 더 수월하다. Pinhole 카메라에서 lens 카메라로 이동하면서 이해하기 위해서 먼저 thin lens부터 이해해보고자 한다. Thin lens 모델은 기하학적으로 간단한 관계에 있어서 이해하고 따져보기 쉬운 특성을 가지고 있다.

Thin lens를 정의하는 2가지 특성이 존재한다. 모든 빛들이 카메라 lens의 중심을 지나가는 경우에는 굴절되지 않아 투과성을 지니는 것이 첫번째 특성이다. Lens의 중심의 경우 pinhole과 같은 관점을 제공하는 것이고, 추가적으로 중심을 지나는 빛들의 경우 대칭성을 가지게 된다. 이러한 특성은 pinhole 카메라에서도 마찬가지이다. 실제로 존재하는 object하고 image plane에 맺혀진 상은 항상 대칭성을 가지고 있었다. 두번째 성질은 직선으로 lens에 들어오는 모든 빛은 하나의 점으로 모이게 된다. 이렇게 모이는 점을 focal point라고 한다. Pinhole같은 경우에는 직선 하나만 존재하기 때문에 focus가 맞을 필요가 없기에 image sensor에 부딪히는 부분이 바로 focal point가 된다. 그래서 pinhole 카메라는 focal length가 달라진다고 해서 focus가 안맞는 문제가 발생하지 않는다. 하지만 lens 카메라의 경우에는 focal point의 존재 때문에 focus가 맞지 않아 blurry하게 보이는 문제가 발생할 수 있다. 그래서 lens 카메라의 경우에는 lens와 focal point 사이의 거리를 focal length라고 정의하게 된다.

Thin lens를 정의하는 2가지 특성이 존재한다. 모든 빛들이 카메라 lens의 중심을 지나가는 경우에는 굴절되지 않아 투과성을 지니는 것이 첫번째 특성이다. Lens의 중심의 경우 pinhole과 같은 관점을 제공하는 것이고, 추가적으로 중심을 지나는 빛들의 경우 대칭성을 가지게 된다. 이러한 특성은 pinhole 카메라에서도 마찬가지이다. 실제로 존재하는 object하고 image plane에 맺혀진 상은 항상 대칭성을 가지고 있었다. 두번째 성질은 직선으로 lens에 들어오는 모든 빛은 하나의 점으로 모이게 된다. 이렇게 모이는 점을 focal point라고 한다. Pinhole같은 경우에는 직선 하나만 존재하기 때문에 focus가 맞을 필요가 없기에 image sensor에 부딪히는 부분이 바로 focal point가 된다. 그래서 pinhole 카메라는 focal length가 달라진다고 해서 focus가 안맞는 문제가 발생하지 않는다. 하지만 lens 카메라의 경우에는 focal point의 존재 때문에 focus가 맞지 않아 blurry하게 보이는 문제가 발생할 수 있다. 그래서 lens 카메라의 경우에는 lens와 focal point 사이의 거리를 focal length라고 정의하게 된다.

Thin lens optics - Lens focus

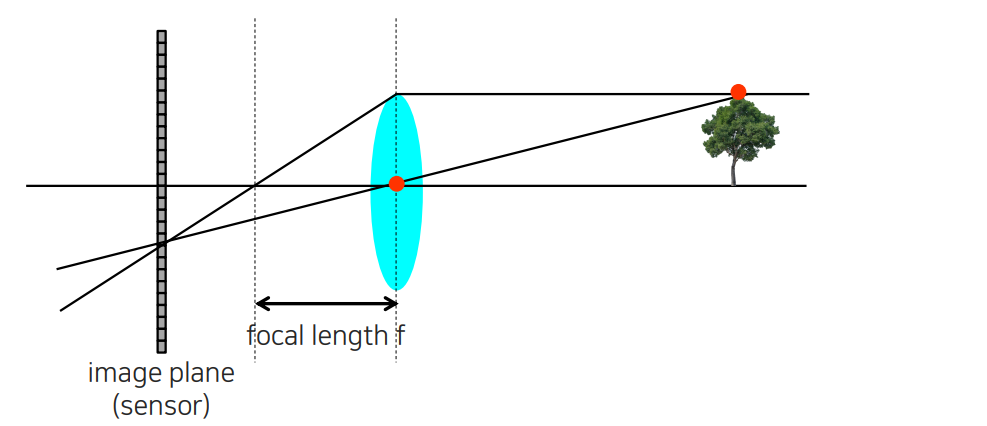

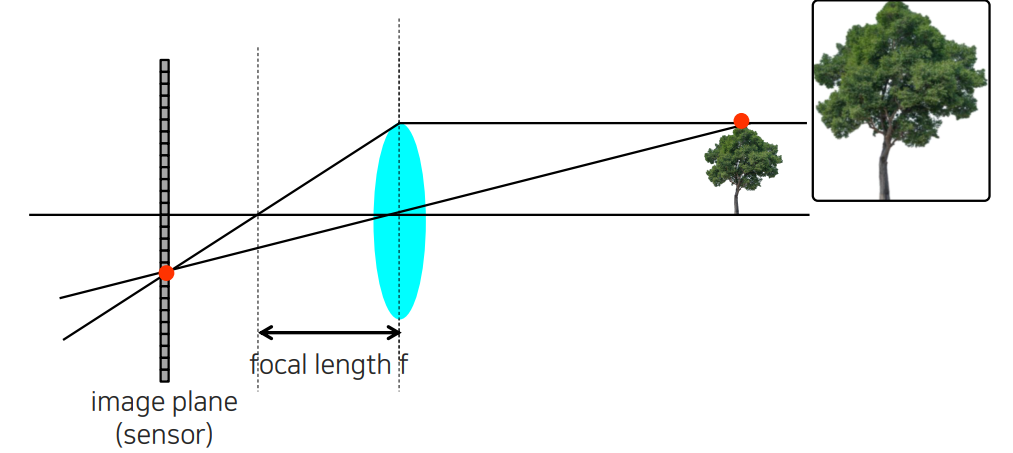

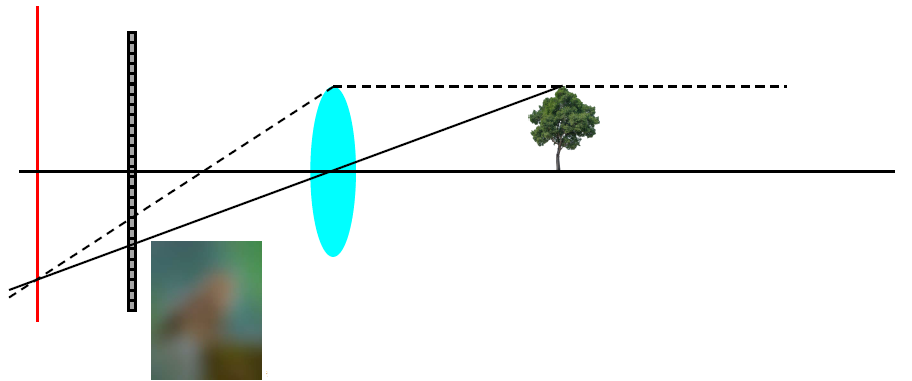

이번에는 thin lens optics의 예시를 보면서 어떠한 식으로 상이 맺혀지는지 원리를 보려고 한다. 카메라의 image plane인 sensor와 lens가 있을 때 물체가 멀리 떨어져 있는 상황을 볼 것이다. 이때 빛이 object에 부딪히게 되면 사방으로 퍼져나가게 될 것이다. Thin lens optics에서 상이 어떻게 맺히는지 따져보기 위해서 2개의 중요한 선을 그려볼 것이다. 2개의 방향으로 오는 빛만 고려할 것이다. Lens를 기준으로 하나는 central ray이고 다른 하나는 parallel ray이다. Parallel ray는 lens에 의해서 굴절되어 focal point에 수렴하게 되고 focal length 가 정해질 것이다. 이러한 경우에 image plane이 focal point 앞에 있는지 뒤에 있는지에 따라서 그 특성이 달라지게 된다.

이번에는 thin lens optics의 예시를 보면서 어떠한 식으로 상이 맺혀지는지 원리를 보려고 한다. 카메라의 image plane인 sensor와 lens가 있을 때 물체가 멀리 떨어져 있는 상황을 볼 것이다. 이때 빛이 object에 부딪히게 되면 사방으로 퍼져나가게 될 것이다. Thin lens optics에서 상이 어떻게 맺히는지 따져보기 위해서 2개의 중요한 선을 그려볼 것이다. 2개의 방향으로 오는 빛만 고려할 것이다. Lens를 기준으로 하나는 central ray이고 다른 하나는 parallel ray이다. Parallel ray는 lens에 의해서 굴절되어 focal point에 수렴하게 되고 focal length 가 정해질 것이다. 이러한 경우에 image plane이 focal point 앞에 있는지 뒤에 있는지에 따라서 그 특성이 달라지게 된다.

이렇게 2개의 직선을 작도해보면 해당 지점은 image plane에서 교점에 맺히게 될 것이다. 우리는 2개의 직선만을 고려하고 있지만 사실 이 두 직선 사이의 빛들도 또한 빛이 lens로 들어오게 되고 이는 image plane의 동일한 지점으로 수렴하게 될 것이다. 그렇기 때문에 우리는 parallel ray와 central ray만으로도 상이 어떻게 맺히는지 예상할 수 있는 것이다. 사실 이렇게 image plane 위에서 한 지점에 빛이 모이게 되면 선명하게 상이 맺히는 것을 확인할 수 있다.

이렇게 2개의 직선을 작도해보면 해당 지점은 image plane에서 교점에 맺히게 될 것이다. 우리는 2개의 직선만을 고려하고 있지만 사실 이 두 직선 사이의 빛들도 또한 빛이 lens로 들어오게 되고 이는 image plane의 동일한 지점으로 수렴하게 될 것이다. 그렇기 때문에 우리는 parallel ray와 central ray만으로도 상이 어떻게 맺히는지 예상할 수 있는 것이다. 사실 이렇게 image plane 위에서 한 지점에 빛이 모이게 되면 선명하게 상이 맺히는 것을 확인할 수 있다.

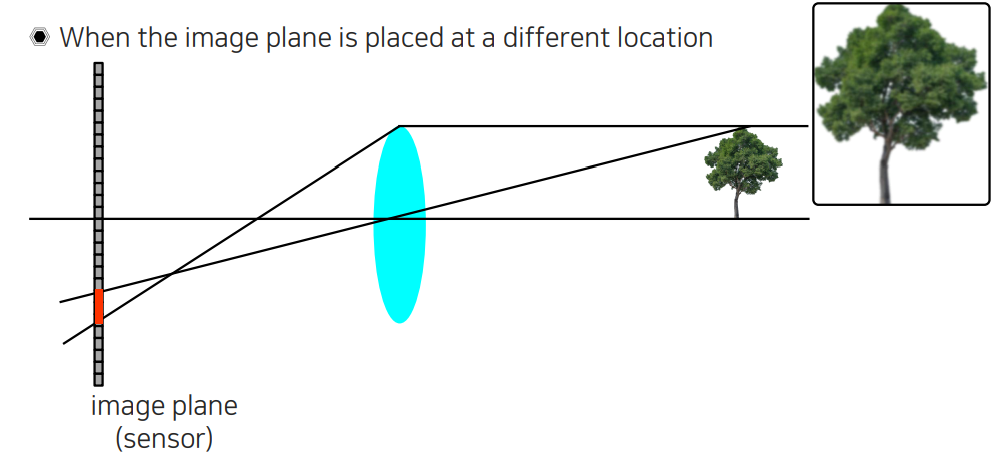

만약 우리가 focal length를 바꿔서 lens를 조금 더 앞으로 밀거나 image plane을 뒤로 이동시켜 위치를 바꾸게 되면 두 직선의 교점이 image plane에 형성되지 않기 때문에 실제로 image plane에서 상이 명료하게 맺히지 않을 것이다. 아무래도 빛이 퍼져서 image plane에 들어오기 때문에 우리가 focus가 맞지 않은 흐린 결과를 보게 될 것이다.

만약 우리가 focal length를 바꿔서 lens를 조금 더 앞으로 밀거나 image plane을 뒤로 이동시켜 위치를 바꾸게 되면 두 직선의 교점이 image plane에 형성되지 않기 때문에 실제로 image plane에서 상이 명료하게 맺히지 않을 것이다. 아무래도 빛이 퍼져서 image plane에 들어오기 때문에 우리가 focus가 맞지 않은 흐린 결과를 보게 될 것이다.

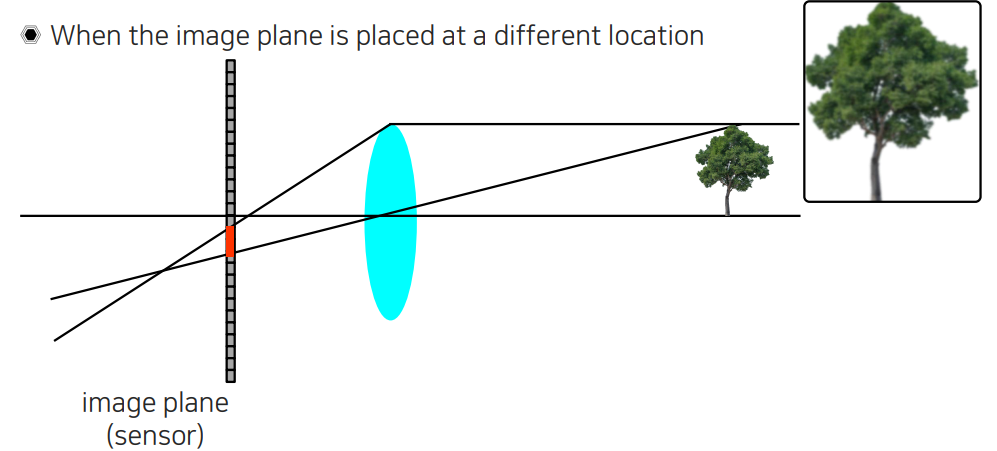

이번에는 반대로 두 직선의 교점이 image plane 뒤에 생기게 되면 마찬가지로 들어온 빛들이 여러 pixel들에 영향을 주기 때문에 그 값들이 또다시 합쳐지게 되어 흐린 영상이 맺혀지게 될 것이다.

이번에는 반대로 두 직선의 교점이 image plane 뒤에 생기게 되면 마찬가지로 들어온 빛들이 여러 pixel들에 영향을 주기 때문에 그 값들이 또다시 합쳐지게 되어 흐린 영상이 맺혀지게 될 것이다.

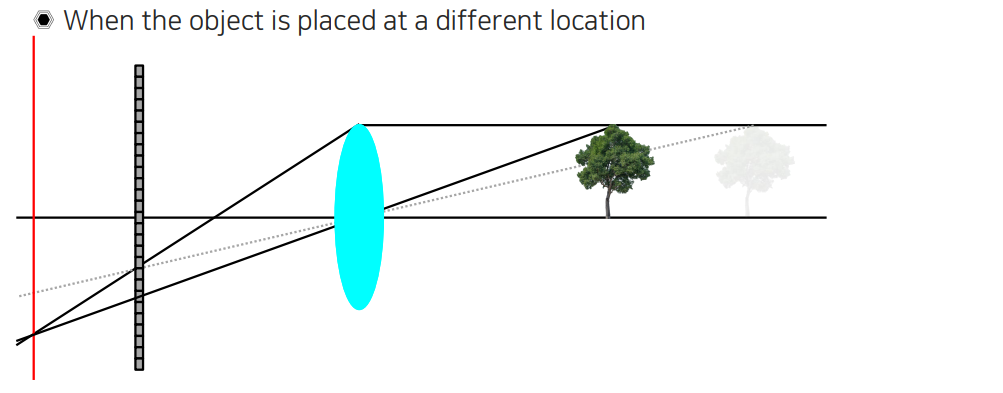

지금까지 lens와 image plane 사이의 거리가 focus에 굉장히 중요한 영향을 끼치는 것을 볼 수 있었다. 이번에는 object 자체가 움직인 상황에 대해서 생각해보려고 한다.

지금까지 lens와 image plane 사이의 거리가 focus에 굉장히 중요한 영향을 끼치는 것을 볼 수 있었다. 이번에는 object 자체가 움직인 상황에 대해서 생각해보려고 한다.

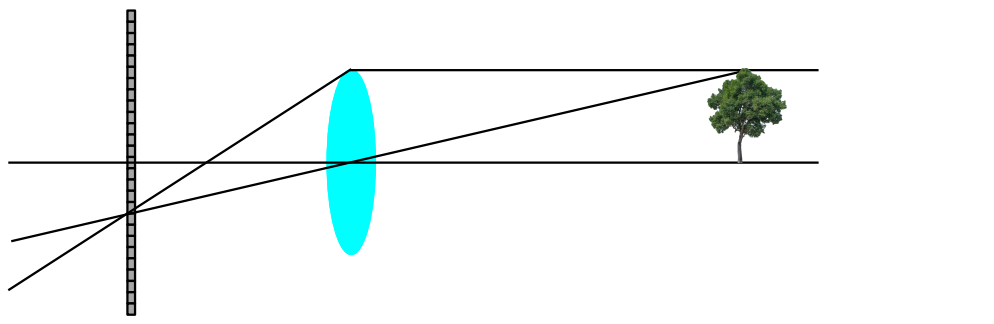

Object가 기존의 위치에 있을 때는 focus가 맞는 상황이었는데, object를 lens에 가깝게 이동시켰더니 focus가 맞지 않게 되었다. Parallel ray는 그대로이지만 central ray가 바뀌게 되었다. 그 결과 기존 image plane 위가 아닌 그 뒤에 두 직선의 교점이 생기게 되었다. 결과적으로 image plane과 lens 사이의 거리를 유지하더라도 object와 lens 사이의 거리를 바꿈으로써 흐릿한 결과를 얻게된 것이다.

Object가 기존의 위치에 있을 때는 focus가 맞는 상황이었는데, object를 lens에 가깝게 이동시켰더니 focus가 맞지 않게 되었다. Parallel ray는 그대로이지만 central ray가 바뀌게 되었다. 그 결과 기존 image plane 위가 아닌 그 뒤에 두 직선의 교점이 생기게 되었다. 결과적으로 image plane과 lens 사이의 거리를 유지하더라도 object와 lens 사이의 거리를 바꿈으로써 흐릿한 결과를 얻게된 것이다.

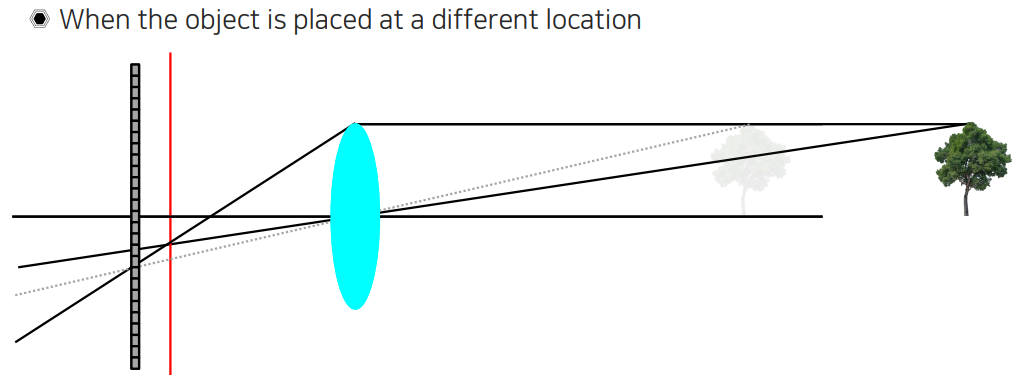

반대로 object가 멀어지는 경우에 대해서는 central ray가 또다시 다르게 지나가기 때문에 교점이 이번에는 image plane과 lens 사이에 형성되는 것을 볼 수 있다.

반대로 object가 멀어지는 경우에 대해서는 central ray가 또다시 다르게 지나가기 때문에 교점이 이번에는 image plane과 lens 사이에 형성되는 것을 볼 수 있다.

Thin lens optics - Focus tolerance

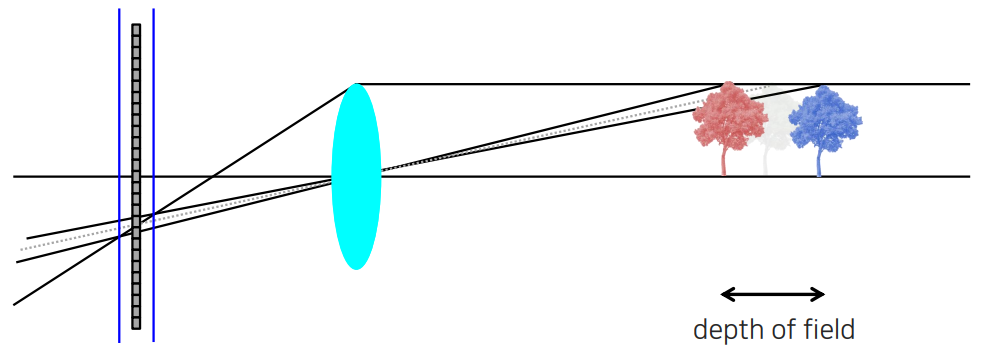

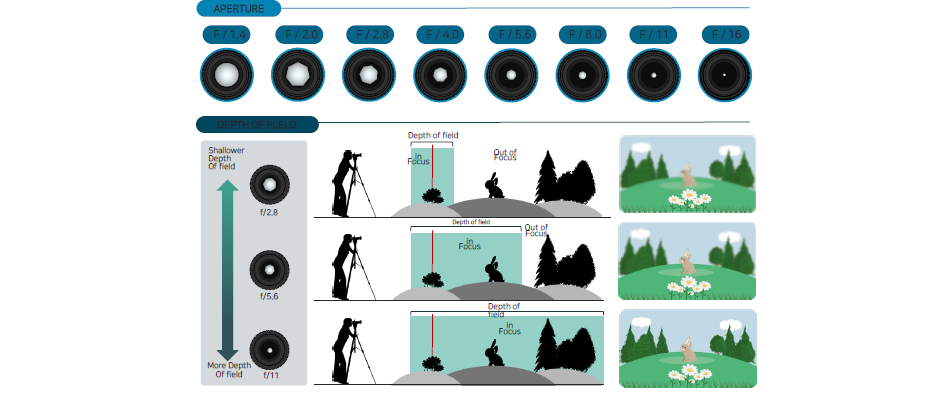

사실 object가 앞뒤로 약간만 움직이게 되면 교점 사이의 거리가 크게 이동하지 않는 경우가 존재할 것이다. 그래서 image plane에서 빛이 흩어지더라도 그 흩어진 정도가 image sensor 하나의 물리적인 크기를 벗어나지 않는 경우를 우리는 focus tolerance라고 부른다. Image sensor 하나 안에서 빛이 모이게 된다면 object의 위치나 sensor plane의 위치가 조금은 움직이더라도 그렇게 큰 영향을 미치지 않을 것이다. 위에서 파란선 사이의 범위를 focus tolerance라고 했을 때 이에 대응되는 만큼 object가 움직여도 되는 거리가 존재할 것이다. 우리는 이렇게 focus가 잘 맞는 영역을 depth of field라고 부른다.

사실 object가 앞뒤로 약간만 움직이게 되면 교점 사이의 거리가 크게 이동하지 않는 경우가 존재할 것이다. 그래서 image plane에서 빛이 흩어지더라도 그 흩어진 정도가 image sensor 하나의 물리적인 크기를 벗어나지 않는 경우를 우리는 focus tolerance라고 부른다. Image sensor 하나 안에서 빛이 모이게 된다면 object의 위치나 sensor plane의 위치가 조금은 움직이더라도 그렇게 큰 영향을 미치지 않을 것이다. 위에서 파란선 사이의 범위를 focus tolerance라고 했을 때 이에 대응되는 만큼 object가 움직여도 되는 거리가 존재할 것이다. 우리는 이렇게 focus가 잘 맞는 영역을 depth of field라고 부른다.

Thin lens optics - Aperture

Sensor 자체의 plane 위치와 lens 사이의 거리를 물리적으로 조정을 못하는 경우가 존재할 것이다. 가령 찍으려고 하는 물체가 너무 가까이 있거나 너무 멀리 있을 수가 있다. 이때 sensor plane과 lens 사이의 물리적인 거리를 현실적으로 만들 수 없는 카메라 크기가 나올 수 있다. 그래서 이러한 것을 조절하기 위해서 등장한 것이 바로 aperture이다.

Sensor 자체의 plane 위치와 lens 사이의 거리를 물리적으로 조정을 못하는 경우가 존재할 것이다. 가령 찍으려고 하는 물체가 너무 가까이 있거나 너무 멀리 있을 수가 있다. 이때 sensor plane과 lens 사이의 물리적인 거리를 현실적으로 만들 수 없는 카메라 크기가 나올 수 있다. 그래서 이러한 것을 조절하기 위해서 등장한 것이 바로 aperture이다.

Aperture는 pinhole 카메라에서 pinhole을 만드는 것과 비슷한 원리를 lens 카메라에 적용시킨 것이다. 우리는 물체로부터 반사된 parallel ray와 central ray로 어떻게 물체가 비치는지 예상할 수 있었다. 위와 같은 경우는 focus가 sensor plane의 위치보다 뒤에서 맞을 것이다. 그래서 sensor plane을 뒤로 이동시켜야 하는데 이러한 경우에 카메라의 물리적인 크기 때문에 더 이동시킬 수 없을 것이다. 그렇다면 기존의 ray들을 조작해서 원래 위치에 있는 sensor plane으로도 focus를 맞춰야 한다.

Lens 뒤에 aperture를 위와 같이 두었다고 생각해보자. Aperture의 역할은 parallel ray와 central ray 사이의 빛 일부와 나머지 빛들을 차단해주는 역할을 한다. Aperture의 크기를 조절함에 따라 빛의 양을 조절하게 되고, 이에 따라 sensor plane에서 focus를 맞출 수가 있는 것이다. 하지만 빛을 일부 차단시켰기 때문에 전체적인 빛의 양이 줄어들었을 것이고, 이는 trade-off가 될 것이다. 빛의 양을 줄이더라도 focus를 맞춰 선명한 결과를 얻을 수 있는 것이다.

Lens 뒤에 aperture를 위와 같이 두었다고 생각해보자. Aperture의 역할은 parallel ray와 central ray 사이의 빛 일부와 나머지 빛들을 차단해주는 역할을 한다. Aperture의 크기를 조절함에 따라 빛의 양을 조절하게 되고, 이에 따라 sensor plane에서 focus를 맞출 수가 있는 것이다. 하지만 빛을 일부 차단시켰기 때문에 전체적인 빛의 양이 줄어들었을 것이고, 이는 trade-off가 될 것이다. 빛의 양을 줄이더라도 focus를 맞춰 선명한 결과를 얻을 수 있는 것이다.

Pinhole 카메라에서는 aperture 부분이 pinhole로 굉장히 좁아서 빛의 효율성이 굉장히 떨어졌었다. 그래서 광량이 굉장히 많고 일정 단위 시간당 센서에 닿는 빛의 굉장히 커야했다. 하지만 lens를 사용함에 따라 빛을 압축하는 것이 가능해졌다. 하나의 ray에 들어있는 빛의 양을 많이 합쳐줘서 빛의 효율성을 높여주었다. 하지만 이에 따라 sensor plane 위치가 영향을 받고 focus가 바뀌게 된다. Pinhole 카메라의 경우 focus가 바뀌지 않지만 lens 카메라는 focus가 유동적이다. 결국 aperture는 빛의 효율성을 줄여도 focus를 맞춰주도록 만드는 일종의 parameter인 셈이다. Lens나 aperture와 같은 장치들은 기존의 pinhole 카메라에서는 하지 못했던 것들을 할 수 있게 만들어준다.

Aperture vs depth of field

Aperture는 depth of field와 어떠한 관계성이 존재한다. Aperture를 사용하게 되면 depth of field를 더 넓게 가져갈 수 있다. Sensor 하나의 크기는 굉장히 작은데 object와 카메라 사이의 거리가 조금이라도 변하게 되면 sensor의 물리적인 크기를 금방 넘어가기 때문에 focus를 맞추지 못한 out of focus image를 얻게 될 것이다. 하지만 aperture를 사용하게되면 depth of field 영역이 굉장히 넓어지게 된다. 사실 aperture가 pinhole 카메라와 lens 카메라의 중간 정도를 맞춰주는 것이기에 depth of field가 늘어날 수 밖에 없는 것이다.

Aperture는 depth of field와 어떠한 관계성이 존재한다. Aperture를 사용하게 되면 depth of field를 더 넓게 가져갈 수 있다. Sensor 하나의 크기는 굉장히 작은데 object와 카메라 사이의 거리가 조금이라도 변하게 되면 sensor의 물리적인 크기를 금방 넘어가기 때문에 focus를 맞추지 못한 out of focus image를 얻게 될 것이다. 하지만 aperture를 사용하게되면 depth of field 영역이 굉장히 넓어지게 된다. 사실 aperture가 pinhole 카메라와 lens 카메라의 중간 정도를 맞춰주는 것이기에 depth of field가 늘어날 수 밖에 없는 것이다.

그래서 만약 aperture 크기가 큰 경우에는 lens 카메라의 특성이 잘 드러나게 될 것이다. Aperture가 크면 depth of field의 크기가 줄어들게 될 것이다. 여기서 이제 aperture의 크기를 줄이게 되면 pinhole 카메라의 특성이 드러나 depth of field의 크기가 반대로 늘어나게 될 것이다. 우리가 취득하려는 사진의 특성에 따라 aperture를 조절하면 된다.

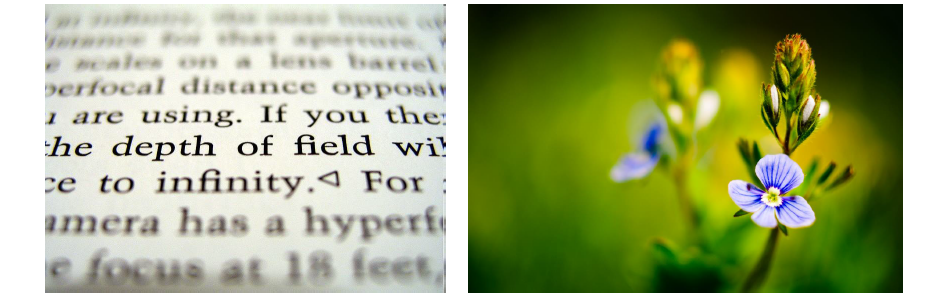

Depth of field

실제로 depth of field는 주변에서 많이 사용되는 개념이다. Depth of field는 ray들이 sensor plane에 어떠한 영향을 미치는지에 따라서 focus가 모이는 곳이 존재하고 그렇지 않은 곳이 존재하게 된다. 이때 위의 사진들처럼 가까운 곳은 focus가 잘 맞고 멀리있는 것은 focus를 날리는 식으로 해서 초점을 특정 부분을 맞출 수가 있다.

실제로 depth of field는 주변에서 많이 사용되는 개념이다. Depth of field는 ray들이 sensor plane에 어떠한 영향을 미치는지에 따라서 focus가 모이는 곳이 존재하고 그렇지 않은 곳이 존재하게 된다. 이때 위의 사진들처럼 가까운 곳은 focus가 잘 맞고 멀리있는 것은 focus를 날리는 식으로 해서 초점을 특정 부분을 맞출 수가 있다.

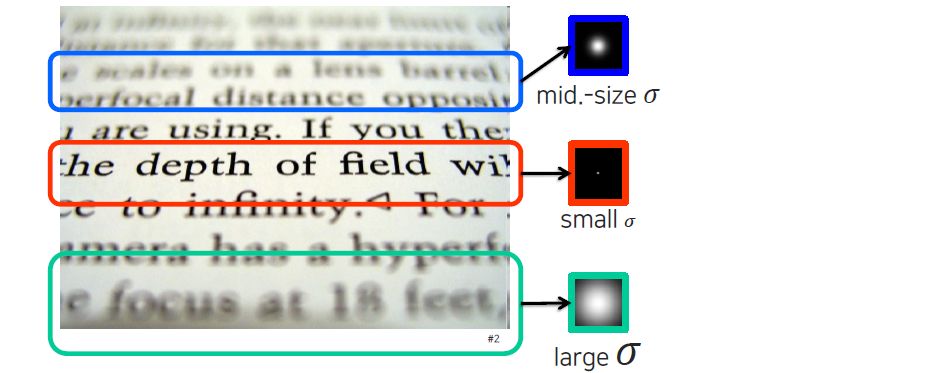

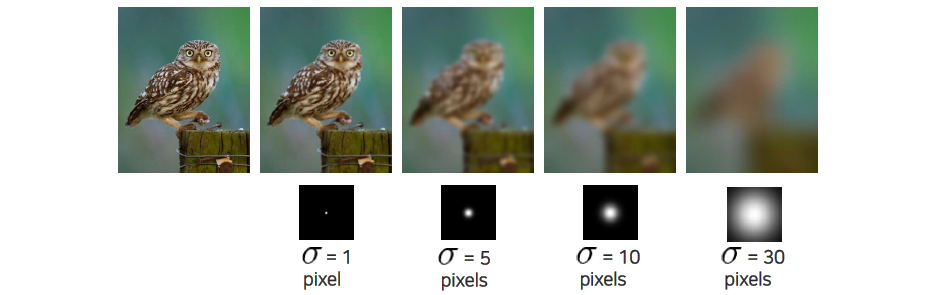

여기서 focus가 맞지 않는 부분에 image processing에서 다루었던 Gaussian filter를 적용해서 얻는다고 생각해보려고 한다. 원래 focus가 다 맞았다고 생각한 상태에서 Gaussian kernel을 이용하여 blurry한 결과를 얻었다고 생각할 것이다. 더 blurry하게 만들고 싶은 영역에서는 큰 Gaussian blur를 kernel을 통해서 입히면 된다. Kernel 관점에서 point spread function이라고 해서 ray가 얼마만큼 주변 sensor에 영향을 주느냐를 function 형태로 만든 것을 사용하는 것이다.

Blur의 정도에 따라 Guassian filter의 크기를 설정함으로써 원하는 정도의 kernel을 만들 수가 있다. 이렇게 Gaussian filter를 적용하게 되면 depth of field와 같은 효과를 만들어낼 수 있다.

Blur의 정도에 따라 Guassian filter의 크기를 설정함으로써 원하는 정도의 kernel을 만들 수가 있다. 이렇게 Gaussian filter를 적용하게 되면 depth of field와 같은 효과를 만들어낼 수 있다.

Gaussian filers

Gaussian filter의 경우 선명한 image에 대해서 크기를 조절함에 따라 blur 정도가 달라지는 것을 확인할 수 있다. Blur kernel 크기를 조절하면서 blur의 정도를 조절하게 되고 이때 depth of field 효과와 비슷하게 out of focus와 in focus를 post processing으로 조정하는 것이 가능하다. 만약 처음부터 blurry한 결과를 얻었다면 이를 선명하게 만드는 것은 굉장히 어려운 task이다. 그렇지만 어느정도 추정이 가능하기 때문에 시각 지능에서는 중요하게 다뤄지는 분야 중 하나이기도 하다.

Gaussian filter의 경우 선명한 image에 대해서 크기를 조절함에 따라 blur 정도가 달라지는 것을 확인할 수 있다. Blur kernel 크기를 조절하면서 blur의 정도를 조절하게 되고 이때 depth of field 효과와 비슷하게 out of focus와 in focus를 post processing으로 조정하는 것이 가능하다. 만약 처음부터 blurry한 결과를 얻었다면 이를 선명하게 만드는 것은 굉장히 어려운 task이다. 그렇지만 어느정도 추정이 가능하기 때문에 시각 지능에서는 중요하게 다뤄지는 분야 중 하나이기도 하다.

Depth from focus

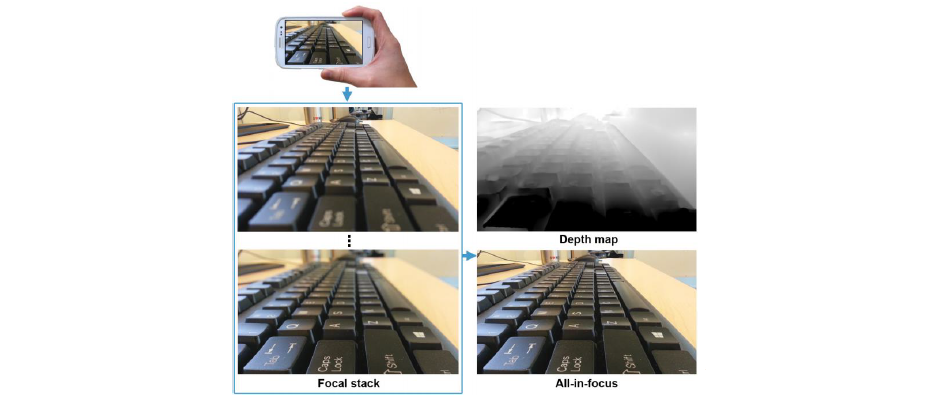

Depth of field는 사실 object와 카메라 사이의 거리를 나타내는데 이는 3D 위치를 의미하게 된다. 그래서 우리는 depth of field와 optical blur를 이용해서 depth를 역으로 추정하는 것도 가능하다.

Depth of field는 사실 object와 카메라 사이의 거리를 나타내는데 이는 3D 위치를 의미하게 된다. 그래서 우리는 depth of field와 optical blur를 이용해서 depth를 역으로 추정하는 것도 가능하다.

예를 들어서 aperture를 조절하든지 해서 거리에 상관없이 focus가 모두 맞는 all-in-focus image를 만들었다고 해보자. 여기서 image plane을 이동시키든지 해서 특정 범위만 focus가 맞는 image를 여러개 만들 수가 있다. 이렇게 여러 장을 쌓아 놓은 것을 focal stack이라고 한다. 우리는 이러한 focal stack을 전부 분석해서 all-in-focus image를 만들어낼 수도 있고, 서로의 blur 정도를 비교해서 depth map도 또한 형성할 수 있을 것이다. 만약 all-in-focus image와 focal stack이 동시에 존재한다면 depth map을 더 수월하게 얻을 수 있다.

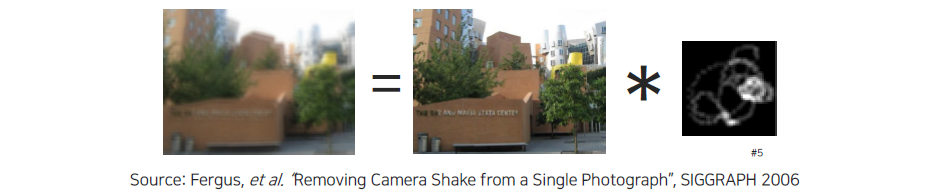

"Optical" convolution

지금까지 Gaussian 형태의 동그란 blur kernel에 대해서 image의 optical blur와 비교를 통해서 어떠한 차이점과 공통점이 존재하는지 확인해보았다. 사실 Gaussian kernel은 convolution을 위한 kernel의 특수한 경우에 해당한다. 하지만 convolution의 형태는 동그란 형태만으로 제한되지 않는다.

예를 들어 위와 같이 복잡한 형태도 존재할 것이다. 그래서 convolution operation은 lens와 image sensor에 매칭된 상과의 관계를 modeling하는데 사용이 되고, 이를 우리는 optical convolution이라고 부르게 된다. 선명한 image와 blurry한 image 사이의 관계가 하나의 간단한 convolution kernel 형태로 표현될 수 있다. 이러한 kernel만 있으면 선명한 image와 blur image를 자유자재로 표현할 수가 있는 것이다. 하지만 사실 이러한 관계식 하나만으로 완전히 선명한 image를 얻을 수는 없을 것이다. 추가적인 정보를 통해서 완전히 선명한 결과를 만들어내야 한다.

예를 들어 위와 같이 복잡한 형태도 존재할 것이다. 그래서 convolution operation은 lens와 image sensor에 매칭된 상과의 관계를 modeling하는데 사용이 되고, 이를 우리는 optical convolution이라고 부르게 된다. 선명한 image와 blurry한 image 사이의 관계가 하나의 간단한 convolution kernel 형태로 표현될 수 있다. 이러한 kernel만 있으면 선명한 image와 blur image를 자유자재로 표현할 수가 있는 것이다. 하지만 사실 이러한 관계식 하나만으로 완전히 선명한 image를 얻을 수는 없을 것이다. 추가적인 정보를 통해서 완전히 선명한 결과를 만들어내야 한다.

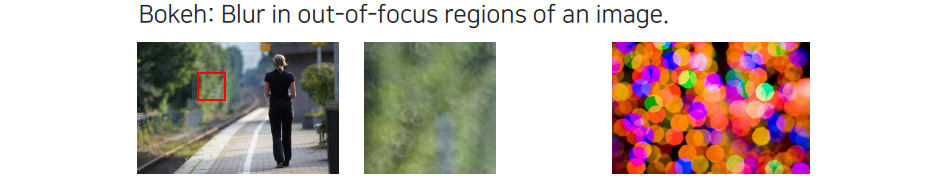

Bokeh라는 개념은 out-of-focus 영역에서 blur된 부분이다. 자세히 보면 빛같은 것들은 어떠한 패턴이 존재하게 된다. 이렇게 생기는 패턴은 aperture의 모양에서 묻어나오는 것이다. Aperture 자체를 구현하게 되면 쉽게 조정하기 위해서 구멍을 열고 닫기 용이한 다면체 형태로 만들게 된다.

Bokeh라는 개념은 out-of-focus 영역에서 blur된 부분이다. 자세히 보면 빛같은 것들은 어떠한 패턴이 존재하게 된다. 이렇게 생기는 패턴은 aperture의 모양에서 묻어나오는 것이다. Aperture 자체를 구현하게 되면 쉽게 조정하기 위해서 구멍을 열고 닫기 용이한 다면체 형태로 만들게 된다.

Field of view

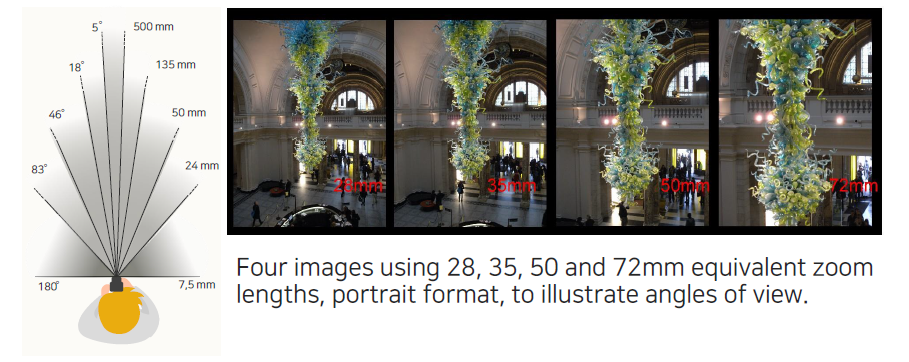

이번에는 field of view (FoV)와 focal length 사이의 관계에 대해서 알아보고자 한다. FoV는 우리가 측정 가능한 각도를 의미하다. 180도를 wide Fov라고 하고 점점 그 각도가 작아지게 되면 narrow FoV라고 한다. 이 각도가 의미하는 것은 해당 각도 사이의 내용물만 보겠다는 의미로 해당 부분만 결과로 볼 수 있게 된다.

이번에는 field of view (FoV)와 focal length 사이의 관계에 대해서 알아보고자 한다. FoV는 우리가 측정 가능한 각도를 의미하다. 180도를 wide Fov라고 하고 점점 그 각도가 작아지게 되면 narrow FoV라고 한다. 이 각도가 의미하는 것은 해당 각도 사이의 내용물만 보겠다는 의미로 해당 부분만 결과로 볼 수 있게 된다.

이러한 FoV는 기본적으로 카메라의 focal length와 굉장히 밀접한 관계를 형성하고 있다. 위의 예시는 focal length가 각각 28, 35, 50, 72mm일 때를 보여주고 있다. Focal length가 길어짐에 따라 FoV가 굉장히 좁아진 것을 볼 수 있다. 물리적으로 FoV와 focal length 사이의 관계가 반비례한 것이다.

Other lens effects

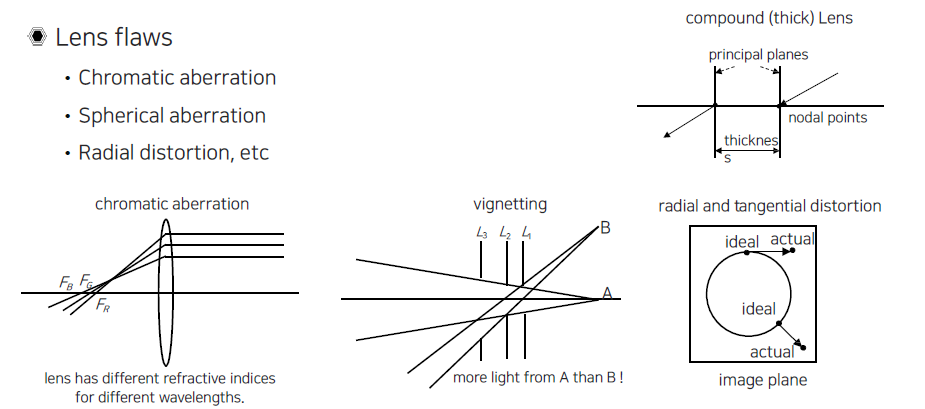

지금까지 카메라, aperture, lens 등 thin lens optics를 구성하고 있는 기본적인 component들에 대해서 알아보았고, 이들 사이에서 focus, depth of field 등의 개념까지 알아보았다. 이번에는 다른 lens들에 대해서 알아보려고 한다. Thin lens optics는 우리가 생각했던 수학적인 모형에 가깝다. 그래서 실제 세계에서 유리로 만든 lens가 포함하고 있는 artifact나 효과 등을 전혀 고려하지 않은 이상적인 모형에 불과하다.

실제로 존재하는 real lens effect는 흔히 색수차라고 불리는 chromatic aberration, vignetting effect, 그리고 radial distortion, tangential distortion 등이 존재한다. 우리는 이러한 것들을 살펴보면서 실제 lens에는 어떠한 issue들이 존재하는지 알아보려고 한다.

실제로 존재하는 real lens effect는 흔히 색수차라고 불리는 chromatic aberration, vignetting effect, 그리고 radial distortion, tangential distortion 등이 존재한다. 우리는 이러한 것들을 살펴보면서 실제 lens에는 어떠한 issue들이 존재하는지 알아보려고 한다.

Lens glare

가장 먼저 lens glare이다. Lens glare는 aperture나 image plane, 그리고 lens로 구성된 system들의 불안정성에서 기인한 개념이다. 빛이 굉장히 강할 때 얻은 사진들을 보면 원형의 신기한 패턴들이 순간적으로 생기게 된다. 이러한 효과는 빛이 너무 강해서 image sensor plane이 흡수하지 못하고 반사된 빛들이 다시 apeture 뒷면이나 lens에 부딪혀 다시 들어온 경우이다. 그래서 image plnae 다른 부분에 이러한 빛들이 닿아서 생기는 현상이 바로 lens glare이다.

가장 먼저 lens glare이다. Lens glare는 aperture나 image plane, 그리고 lens로 구성된 system들의 불안정성에서 기인한 개념이다. 빛이 굉장히 강할 때 얻은 사진들을 보면 원형의 신기한 패턴들이 순간적으로 생기게 된다. 이러한 효과는 빛이 너무 강해서 image sensor plane이 흡수하지 못하고 반사된 빛들이 다시 apeture 뒷면이나 lens에 부딪혀 다시 들어온 경우이다. 그래서 image plnae 다른 부분에 이러한 빛들이 닿아서 생기는 현상이 바로 lens glare이다.

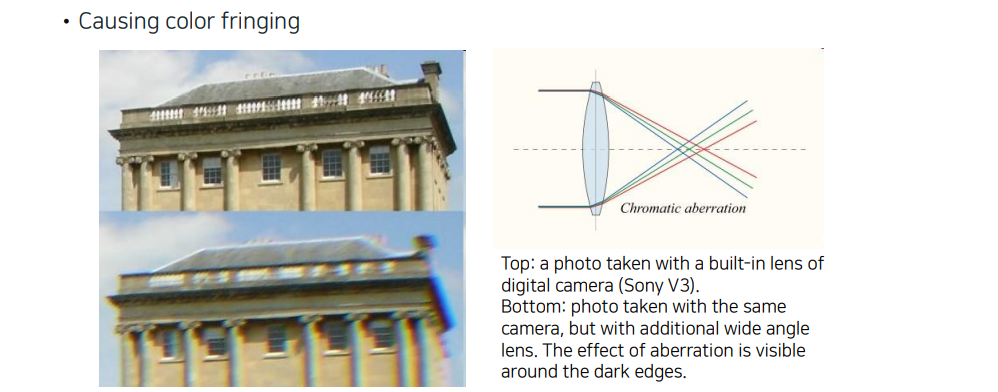

Chromatic aberration

Chromatic aberration은 또 다른 말로 color finging effect라고 부른다. 모든 빛이 모여있게 되면 흰색 빛이 발생하게 되는데, 이 빛이 들어오는 순간에 공기와 lens의 밀도 차이로 인하여 굴절이 발생하게 된다. 그래서 spectrum의 wave length에 따른 서로 다른 굴절계수가 발생하게 된다. Spectrum에 따라 굴절의 차이가 생기기 때문에 동일한 빛이 들어와도 어떠한 색의 빛은 많이 굴절되게 되는 것이다. 이러한 현상이 발생하게 되면 color의 색수 차이가 발생하게 되어 사진을 찍었을 때 위와 같이 보이게 되는 것이다.

Chromatic aberration은 또 다른 말로 color finging effect라고 부른다. 모든 빛이 모여있게 되면 흰색 빛이 발생하게 되는데, 이 빛이 들어오는 순간에 공기와 lens의 밀도 차이로 인하여 굴절이 발생하게 된다. 그래서 spectrum의 wave length에 따른 서로 다른 굴절계수가 발생하게 된다. Spectrum에 따라 굴절의 차이가 생기기 때문에 동일한 빛이 들어와도 어떠한 색의 빛은 많이 굴절되게 되는 것이다. 이러한 현상이 발생하게 되면 color의 색수 차이가 발생하게 되어 사진을 찍었을 때 위와 같이 보이게 되는 것이다.

Vignetting

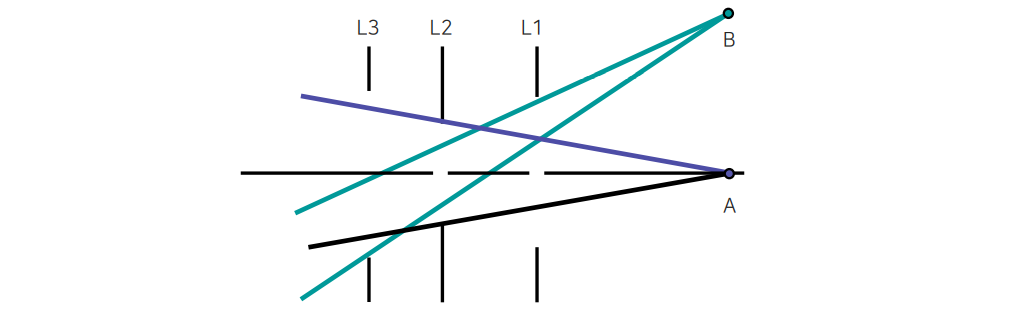

Vignetting effect같은 경우에는 lens의 aperture나 외곽에서 빛의 들어오는 정도가 다르기 때문에 외곽이 어두워지는 현상이 발생하게 된다. 특히 이러한 현상들이 있을 때 panorama stitching과 같은 task를 할 때 경계선에서 차이가 두드러지게 보일 수가 있다. 그래서 이러한 task는 vignetting effect를 없애고 사진들을 붙여야 한다.

Vignetting effect같은 경우에는 lens의 aperture나 외곽에서 빛의 들어오는 정도가 다르기 때문에 외곽이 어두워지는 현상이 발생하게 된다. 특히 이러한 현상들이 있을 때 panorama stitching과 같은 task를 할 때 경계선에서 차이가 두드러지게 보일 수가 있다. 그래서 이러한 task는 vignetting effect를 없애고 사진들을 붙여야 한다.

그렇다면 이러한 effect가 발생하는 이유는 무엇일까? Object의 위치에 따라서 빛이 들어오는 범위가 다르기 때문이다. 위에서 A 지점에 있는 물체의 경우 빛이 들어오는 범위가 상대적으로 B 지점보다 많게 된다. 이러한 경우에 주변의 외곽 부분일수록 빛의 양이 적기 때문에 vignetting effect가 발생하는 것이다.

그렇다면 이러한 effect가 발생하는 이유는 무엇일까? Object의 위치에 따라서 빛이 들어오는 범위가 다르기 때문이다. 위에서 A 지점에 있는 물체의 경우 빛이 들어오는 범위가 상대적으로 B 지점보다 많게 된다. 이러한 경우에 주변의 외곽 부분일수록 빛의 양이 적기 때문에 vignetting effect가 발생하는 것이다.

Spherical aberration

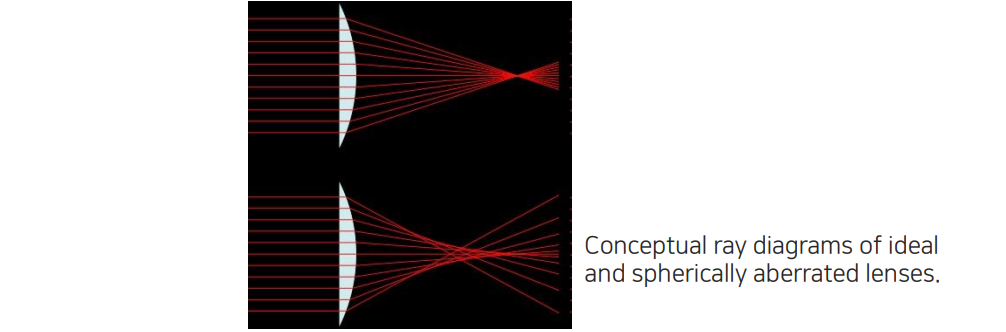

Lens 자체가 곡면이 정말 완벽하게 만들어져 있으면 focus point가 잘 맞는다. 하지만 곡면 자체가 완벽하지 않기 때문에 focus point가 잘 맞지 않아서 spherical aberration이 발생하게 된다.

Lens 자체가 곡면이 정말 완벽하게 만들어져 있으면 focus point가 잘 맞는다. 하지만 곡면 자체가 완벽하지 않기 때문에 focus point가 잘 맞지 않아서 spherical aberration이 발생하게 된다.

Radial distortion

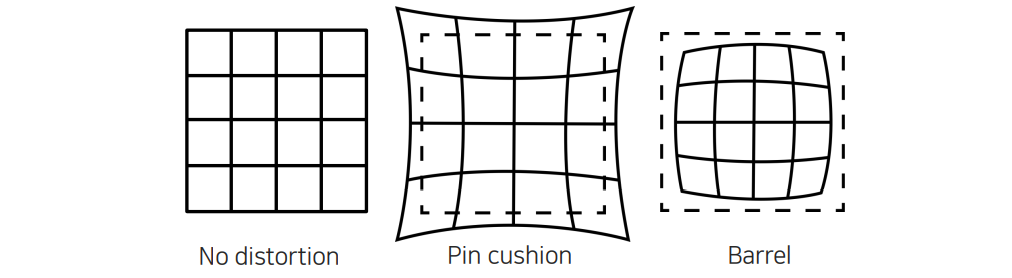

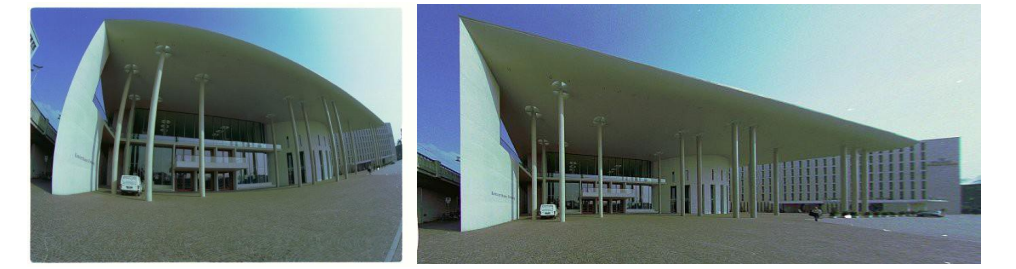

Radial distortion은 lens에 따른 distortion effect가 없다면 좌측과 같이 체크보드로 잘 나올 것이다. 하지만 실제로 찍어보게 되면 pin cushion이나 barrel과 같이 보이게 된다. 이렇게 되면 이상적인 edge를 잘 보존하지 못하게 되는데, 이렇게 lens에 의해서 발생하는 현상을 radial distortion이라고 한다. 이 현상은 사물의 기하학적인 특성을 잘 보존하지 못해서 3D 관련 분야에서는 이러한 현상이 정말 큰 문제를 야기하게 된다. 우리는 radial undistortion 혹은 rectification을 통해서 똑바른 영상을 다시 만들어주면 된다.

Radial distortion은 lens에 따른 distortion effect가 없다면 좌측과 같이 체크보드로 잘 나올 것이다. 하지만 실제로 찍어보게 되면 pin cushion이나 barrel과 같이 보이게 된다. 이렇게 되면 이상적인 edge를 잘 보존하지 못하게 되는데, 이렇게 lens에 의해서 발생하는 현상을 radial distortion이라고 한다. 이 현상은 사물의 기하학적인 특성을 잘 보존하지 못해서 3D 관련 분야에서는 이러한 현상이 정말 큰 문제를 야기하게 된다. 우리는 radial undistortion 혹은 rectification을 통해서 똑바른 영상을 다시 만들어주면 된다.

Radial distortion으로 인하여 직선이 곡선이 되었을 때 이를 펴주고 사용하면 된다.

Radial distortion으로 인하여 직선이 곡선이 되었을 때 이를 펴주고 사용하면 된다.

Other types of cameras

지금까지 우리는 디지털 카메라 기반의 pinhole 카메라부터 유도가 된 lens 카메라들에 대해서 살펴보았는데 이번에는 다른 종류의 카메라를 알아보려고 한다.

360 cameras

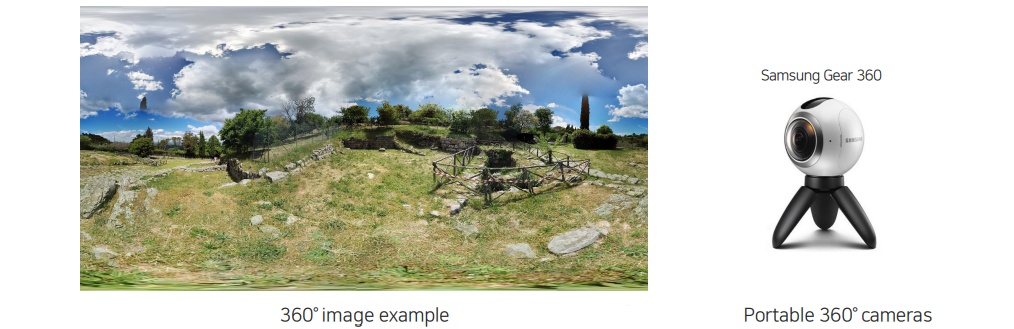

360도 카메라는 주변의 환경을 넓게 촬영할 수 있는 카메라이다. 위아래 180도, 좌우로 360도까지 촬영이 가능한 이 카메라는 카메라 2대를 앞뒤로 합쳐서 만들게 된다. 이러한 카메라의 경우 thin lens optics를 어느정도 따르기는 하지만 radial distortion 등의 여러 effect가 있어 해결해야하는 효과들이 많이 존재한다.

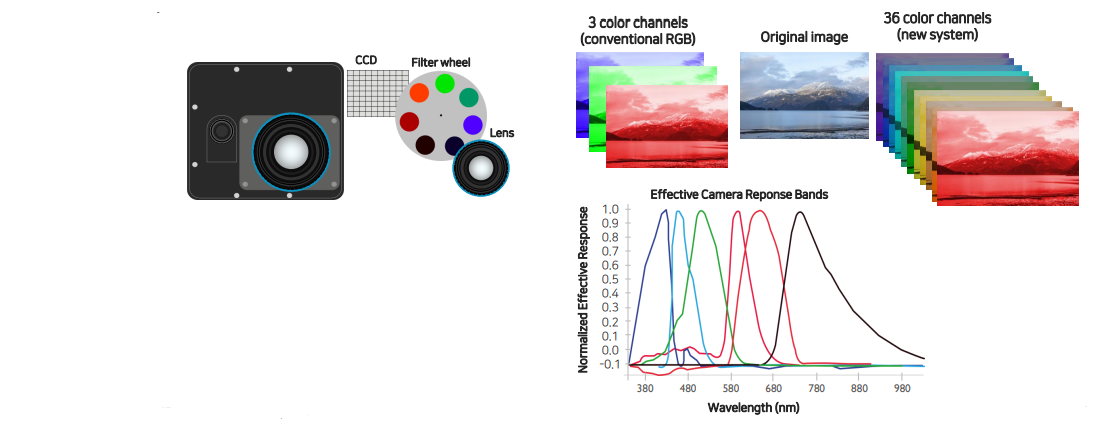

Multi-spectral cameras

기존의 카메라처럼 R, G, B 3개 채널의 spectrum만 사용하는 것이 아니라 다양한 wave length를 모두 포함하여 사용하는 카메라가 존재한다. 이 카메라는 간단하게 lens 뒤쪽에 color wheel이 있어서 filter를 적용하여 원하는 영역의 spectrum 구간만 취득을 하는 식으로 조절하여 사용한다. Filter가 완벽하게 모든 spectrum을 취득하는 것은 아니다. 위와 같이 일정 영역에 focus를 맞춰서 response를 구하게 된다.

기존의 카메라처럼 R, G, B 3개 채널의 spectrum만 사용하는 것이 아니라 다양한 wave length를 모두 포함하여 사용하는 카메라가 존재한다. 이 카메라는 간단하게 lens 뒤쪽에 color wheel이 있어서 filter를 적용하여 원하는 영역의 spectrum 구간만 취득을 하는 식으로 조절하여 사용한다. Filter가 완벽하게 모든 spectrum을 취득하는 것은 아니다. 위와 같이 일정 영역에 focus를 맞춰서 response를 구하게 된다.

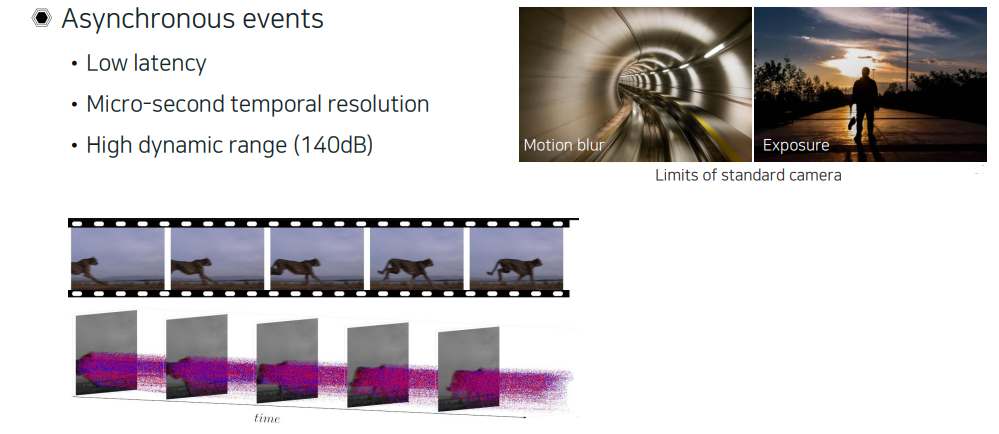

Event camera

최근에 event 카메라라는 것이 새로 발명이 되었다. 기존의 카메라는 모든 영역의 빛을 전부 받아들이지 못한다. 너무 밝거나 너무 어두운 부분은 보통 제대로 받아들이기 어렵다. 그래서 기존의 카메라를 우리는 low dynamic range (LDR) 카메라라고 부른다. 반면 event 카메라는 HDR 카메라이다. 기존의 LDR image 여러개를 합쳐서 만들게 된다. Event 카메라는 보통 시간을 축으로 해서 변화하는 부분을 포착하는 식으로 사용한다. 이 카메라는 time resolution이 짧기 때문에 motion blur가 거의 없다.

최근에 event 카메라라는 것이 새로 발명이 되었다. 기존의 카메라는 모든 영역의 빛을 전부 받아들이지 못한다. 너무 밝거나 너무 어두운 부분은 보통 제대로 받아들이기 어렵다. 그래서 기존의 카메라를 우리는 low dynamic range (LDR) 카메라라고 부른다. 반면 event 카메라는 HDR 카메라이다. 기존의 LDR image 여러개를 합쳐서 만들게 된다. Event 카메라는 보통 시간을 축으로 해서 변화하는 부분을 포착하는 식으로 사용한다. 이 카메라는 time resolution이 짧기 때문에 motion blur가 거의 없다.

Stereo camera

Stereo 카메라는 lens를 2개 사용하고 이에 따라 image plane도 2개를 사용하게 된다. 한번에 시간축으로 싱크가 맞는 영상을 양안으로 얻는 카메라이다. 사람의 눈처럼 양쪽에서 서로 다른 지점에서 같은 장면을 촬영하게 되고, 시간축으로 동시에 싱크를 맞추게 된다. Stereo 카메라는 기본적으로 3D 영상 미디어에 많이 사용하기 때문에 시차가 나지 않게 촬영하는 것이 중요한 점이다.

Stereo 카메라는 lens를 2개 사용하고 이에 따라 image plane도 2개를 사용하게 된다. 한번에 시간축으로 싱크가 맞는 영상을 양안으로 얻는 카메라이다. 사람의 눈처럼 양쪽에서 서로 다른 지점에서 같은 장면을 촬영하게 되고, 시간축으로 동시에 싱크를 맞추게 된다. Stereo 카메라는 기본적으로 3D 영상 미디어에 많이 사용하기 때문에 시차가 나지 않게 촬영하는 것이 중요한 점이다.

Telescope

광학적인 매체를 기록하는 것들을 모두 카메라라고 부를 수 있고, aperture, lens, image plane으로 구성되어 있기 때문에 비슷한 모델링으로 접근이 가능하다.

광학적인 매체를 기록하는 것들을 모두 카메라라고 부를 수 있고, aperture, lens, image plane으로 구성되어 있기 때문에 비슷한 모델링으로 접근이 가능하다.