#INTRO

오늘도 화이팅.

#코드카타

#스파크 (강의)

-

차근차근 해보자..

#데이터 수집 - API 연동 (라이브 세션)

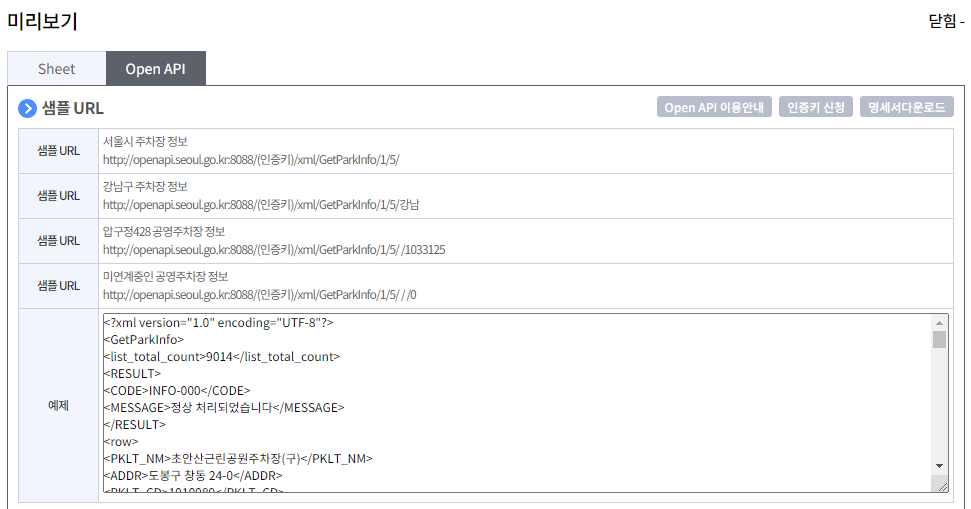

- 데이터 URL 입력 :

(인증키)부분에는 개인 KEY 값을 넣으면 된다.

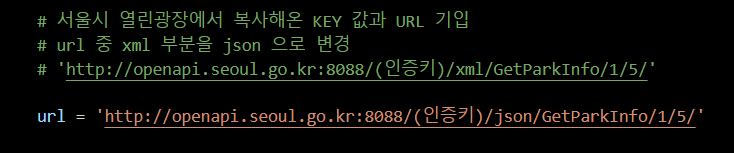

# 서울시 열린광장에서 복사해온 KEY 값과 URL 기입 # url 중 xml 부분을 json 으로 변경 # 'http://openapi.seoul.go.kr:8088/(인증키)/xml/GetParkInfo/1/5/' url = 'http://openapi.seoul.go.kr:8088/(인증키)/json/GetParkInfo/1/5/'

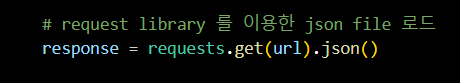

JSON FILE불러오기

# request library 를 이용한 json file 로드 response = requests.get(url).json()

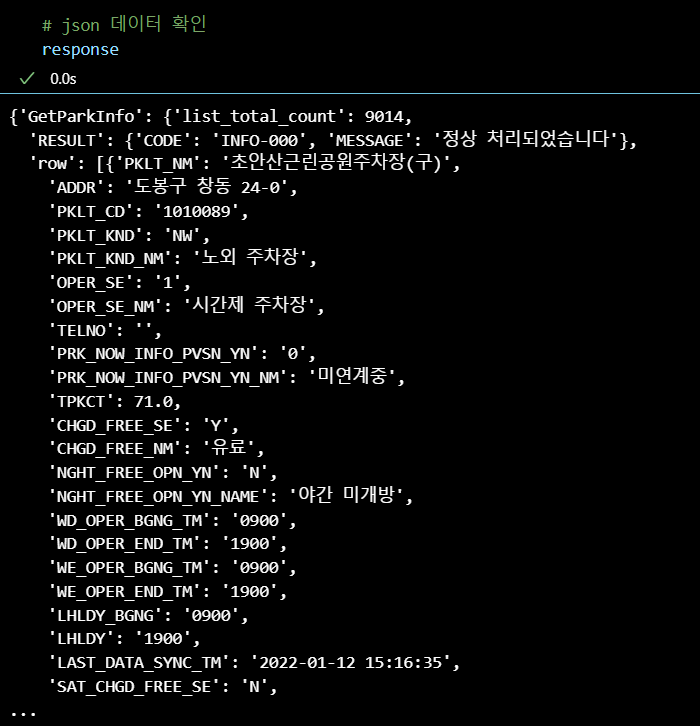

JSON데이터 확인

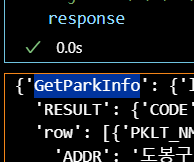

# json 데이터 확인 response

JSON FILE데이터의 KEY 값 확인

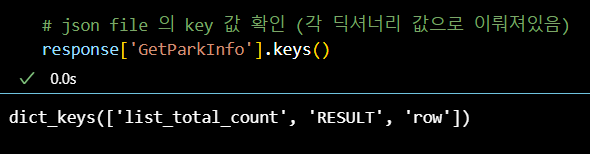

# json file 의 key 값 확인 (각 딕셔너리 값으로 이뤄져있음) response['GetParkInfo'].keys()

JSON FILE데이터의 ROW 데이터 불러오기

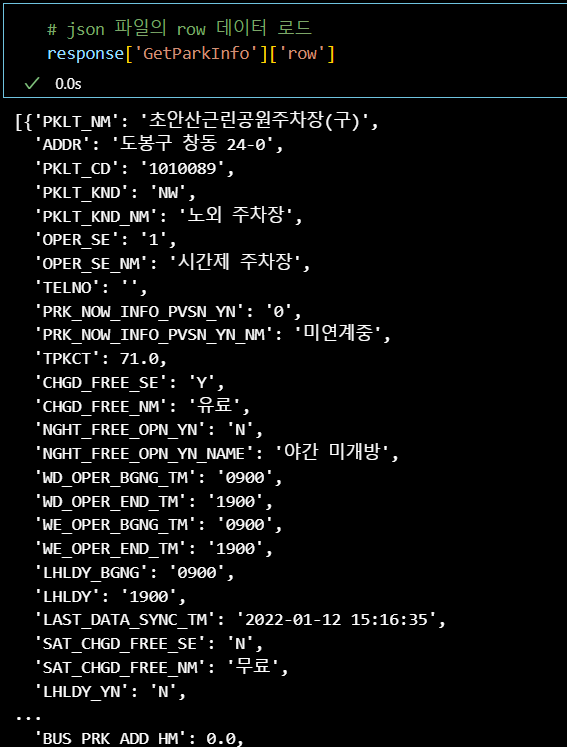

# json 파일의 row 데이터 로드 response['GetParkInfo']['row']

JSON FILE형식을 DATAFRAME 으로 받기

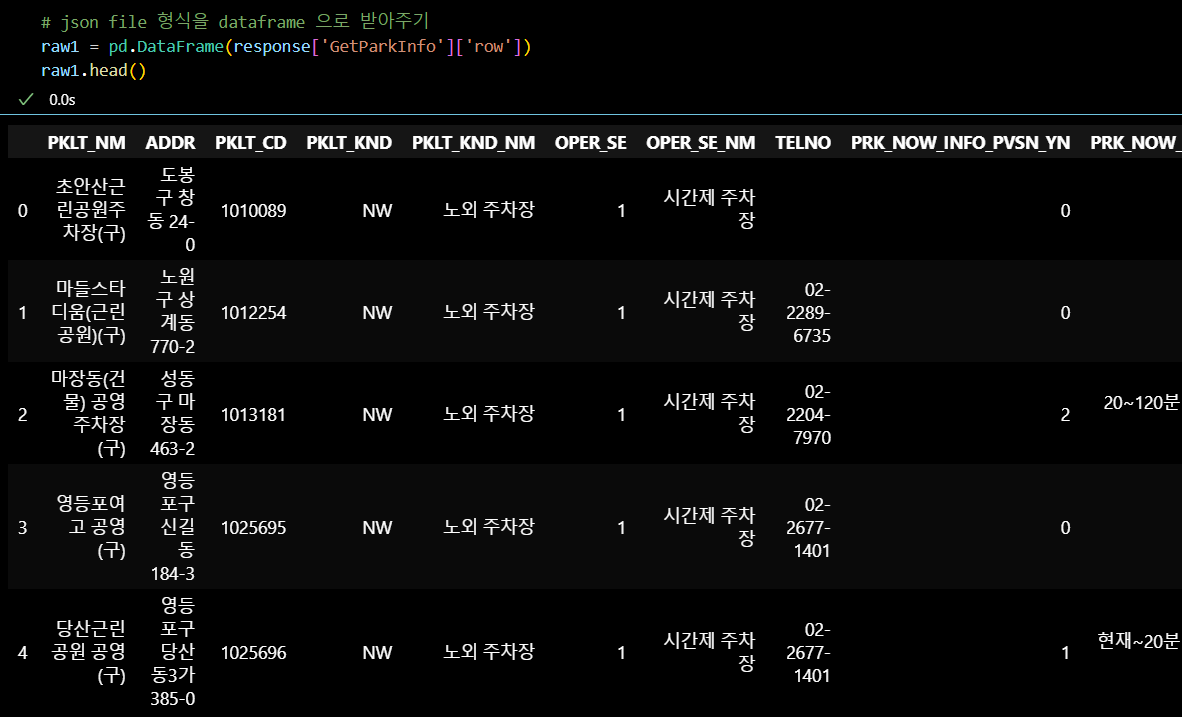

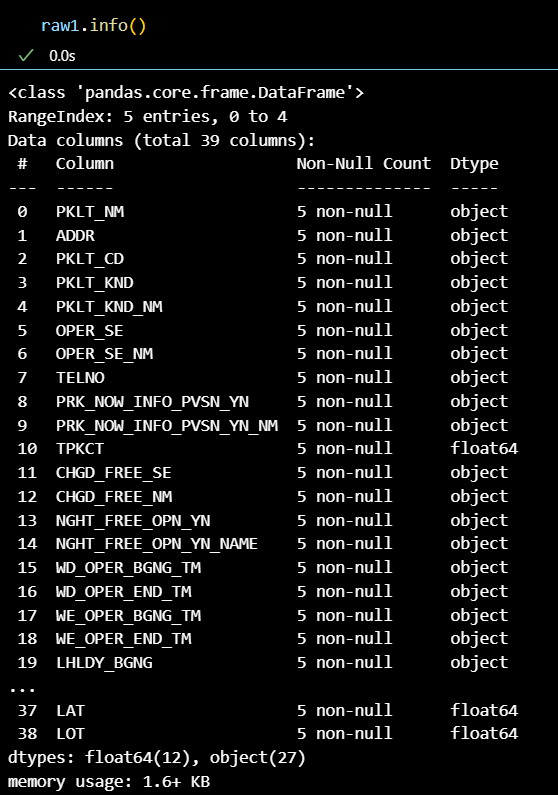

# json file 형식을 dataframe 으로 받아주기 raw1 = pd.DataFrame(response['GetParkInfo']['row']) raw1.head()

- 데이터 확인

말로만 듣고 검색만 해보고 그렇구나 하고 말았던 API 연동을

쉽게 이해할 수 있게 가르쳐 주신 튜터님께 감사 !

OPEN API만 보이면 다 연결해서 가져오고 싶어질 것 같다 : )

#최종 프로젝트 관련

-

도메인과 관심 주제가 비슷한 팀원 구성을 끝냈다!

-

공통 희망 도메인 :

이커머스

프로젝트 기획 초안

<프로젝트 목표>

이커머스 데이터를 활용하여 고객 이탈 방지 및 재고(수요/공급) 관리와 같은

문제를 해결하는 시스템이나 대시보드 등의 도구 구축

<사용 도구>

데이터 수집 및 전처리: SQL, 웹 크롤링, API

데이터 시각화: 태블로(Tableau)

분석 및 모델링: Python

<프로젝트 주요 단계>

1. 데이터 수집 및 전처리

- 웹 크롤링 및 API: 데이터 수집

- SQL: 데이터베이스에서 필요 데이터를 정제 및 추출

- 전처리: 데이터 정제 및 변환, 결측치 처리 등

2. 데이터 탐색적 분석(EDA)

- SQL/Python: 기본 통계량 확인, 데이터 분포 및 특징 파악, 인사이트 도출

- 카테고리 분류 및 데이터 특징 파악 (예: 이탈 여부 기준, 재고 확립 필요 여부 기준 등)

<프로젝트 세부 내용 예시>

1. 리뷰 분석

- 이커머스(패션 쇼핑몰) 데이터 분석: 리뷰 텍스트 분석을 통해 고객 피드백 파악

- 목적: 고객 이탈 방지 및 서비스 개선

2. 모델링: 머신러닝(ML) 모델링을 통해 예측 시스템 구현

고객 이탈 방지 모델

재고(수요/공급) 관리 모델

- 모델 성능 평가: 모델 적용 전후의 손익 비교 및 효율 차이 제시

<프로젝트 결과물 예시>

1. 태블로 대시보드 및 PPT: 분석 결과 시각화 및 프레젠테이션 자료

2. 핵심 마케팅 전략 수치화: 마케팅 전략의 효과를 수치화하여 제시

3. 명확한 결과 제시: 프로젝트 결과를 수치화하여 명확하게 제시

고객 이탈 감소율

재고 관리 효율성 향상

<기대 효과 예시>

1. 고객 이탈 방지: 고객 유지율 향상

2. 재고 관리 최적화: 재고 비용 절감 및 효율성 증대

3. 마케팅 전략 개선: 효과적인 마케팅 캠페인 수립#OUTRO

오늘의 한 줄.

시간이 너무 빨리 가 !