음악 감정 생성 및 인식을 위한 트랜스포머 기반의 지능형 시스템

Abstract

- 주제 기반 조건화 접근법을 도입하여 트랜스포머가 조건 시퀀스를 생성된 결과에서 여러 번 나타나는 주제적 자료로 나타내도록 훈련

- 감정 벡터 + LSTM 모델 통합

-> 일관되고 감정적으로 공감할 수 있는 상징적 음악 시퀀스 생성 - 트랜스포머 기반 접근 방식은 감정을 기반으로 음악을 만드는 신선하고 독창적인 방법 제공하게 함

기존 접근 방식과의 트랜스포머 기반 모델 비교

- 트랜스포머 기반 모델이 전통적인 음악 생성 및 인식 작업 방법보다 우수한 성능을 보여주고 있음

- 트랜스포머 기반 모델은 주의 메커니즘 기반의 방법을 사용하여 음악 시퀀스의 다양한 부분 간의 종속성을 효과적으로 포착함

- 시퀀스 투 시퀀스 학습 패러다임은 장거리 종속성을 포착하는 데 중요함

음악 제작에서 딥러닝을 직접 사용하는 것과 관련된 특정 제한을 해결하고, 이러한 장애물 뒤에 있는 이유를 조사하며, 가능한 해결책을 제안

개방형 문제를 해결하기 위한 흥미로운 방향을 강조하는 현재 음악 생성 시스템의 예를 들어 관점을 설명

방법론

감정 벡터를 트랜스포머 기반 모델에 통합하여 새로운 음악 생성 및 인식 접근 방식을 제공

모델을 훈련시켜 감정적으로 공감되는 음악을 생성하고, 생성된 음악에 표현된 감정을 인식하도록 함

이중 목적 모델은 생성된 음악의 음악적 일관성과 감정적 공감을 최적화함으로써 기존 접근 방식을 개선

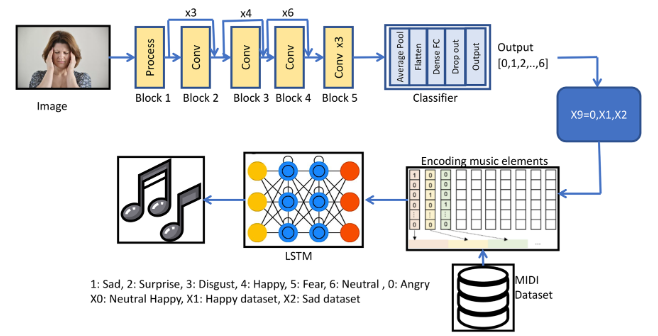

감정 기반 음악 생성 시스템의 두 부분

1. 얼굴 이미지를 통해 감정을 추출

2. 추출된 감정을 기반으로 음악을 생성

초기 단계에서는 ResNet50V2모델을 사용, FER-2013 얼굴 이미지 데이터셋에서 감정 특징 추출

LSTM 모델을 사용하여 MIDI 데이터에 필수적인 음악적 특성을 추출

음악 작곡 모델에서는 트리플 스택 LSTM 아키텍처 사용

하나의 LSTM 레이어가 다른 LSTM 레이어 위에 층층이 쌓이는 아키텍처

감정 추출 과정 후에는 7개의 크기로된 원-핫 인코딩된 벡터가 얻어지며, 각 값은 다른 감정 클래스로 나타남

얼굴 표정을 기반으로 개별 얼굴을 일곱 가지 감정 범주 중 하나로 분류

음악 생성 모델의 훈련을 위해, 각 세 가지 감정 클래스(행복, 슬픔, 중립)에 대해 200개의 MIDI파일로 구성된 자체 준비된 데이터셋이 사용

가우시안 혼합 모델을 사용한 특징 향상

음악의 감정 특징과 입력 이미지의 얼굴 표정 사이의 높은 클래스 간 분산과 낮은 클래스 내 분산은 다양한 분류기의 성능을 저하시켜 낮은 감정 인식률을 초래

추출된 특징들 사이의 클래스 간 분산을 줄이고 클래스 내 분산을 높이기 위해, 가우시안 혼합 모델(GMM) 기반 클러스터링 방법을 사용하여 선택 기준과 다양한 얼굴 표정을 통한 음악 감정 인식의 잠재적 편향을 고려한 특징을 선택

상대적인 웨이블릿 패킷 에너지와 엔트로피 측정을 풍부하게 하여 변별력 있는 특징을 선택

이 모델 구조는 얼굴 이미지에서 세밀한 디테일을 효율적이고 정확하게 추출하여 사진에 나타난 감정을 예측하도록 설계