문제의식

1) RNN은 Vanishing gradient 문제가 있음(물론 이건 LSTM으로 개선되긴 했음)

2) 번역에 적용되기 어려움. RNN처럼 순차적으로 output을 내면, 언어별로 어순도 다르고, output 길이가 input 길이와 같다는 보장도 없음.

-> 문장의 전체 구조를 확인 후 생성하는 구조가 필요

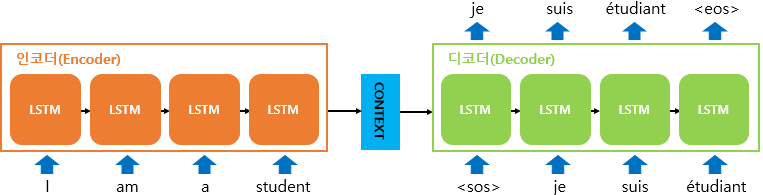

Seq2Seq 개념

- x: Input Sequence

y: Output Sequence

v: 인코더의 입력 x에 대한 고정된 크기의 Representation Vector 아웃풋으로서, 디코더의 입력으로 사용됨

[https://wikidocs.net/24996]