본 Thesis review는 Carnegie Mellon University(CMU) Ph.D student Emillio Parisoto님의 Meta Reinforcement Learning through MemoryThesis를 바탕으로 작성하였습니다.

사람과 동물들은 새로운 환경을 만나더라도 곧 잘 해냅니다.

인간에게 아타리 게임을 하도록 주면, 빠르게 방법을 알아내어 쉽게 마스터 해내곤 합니다.

근데 RL agent는 어떨까요? 수십만의 시도 끝에 인간은 쉽게 해내는 이 task를 완료해냅니다.

이런 비효율이 어디있어요.

우리는 빠르게 generalization하기 위해 적절한 inductive bias를 써야 합니다.

이전 포스트에서 inductive bias에 대해서 설명했지만,

한번 더 설명하자면, seqeunce data에는 LSTM을 사용하고, image data에는 convolution net을 사용합니다.

이를 통해 데이터에 적절한 모델을 통해 특징들을 우리는 쉽게 뽑아낼 수 있습니다.

agent의 학습 프로세스를 데이터 기반으로 agent만의 learning process를 만드는 것입니다.

반대로 RL은 어떤가요? 모든 environment에 대해서 일반화할 수 있나요?

그래서 메타 러닝은 agent에게 exploitable structure를 기반으로 빠르게 적응할 수 있게 해줍니다.

완전한 일반성을 희생하여 빠르게 목표 환경에 적응합니다.

prametric method

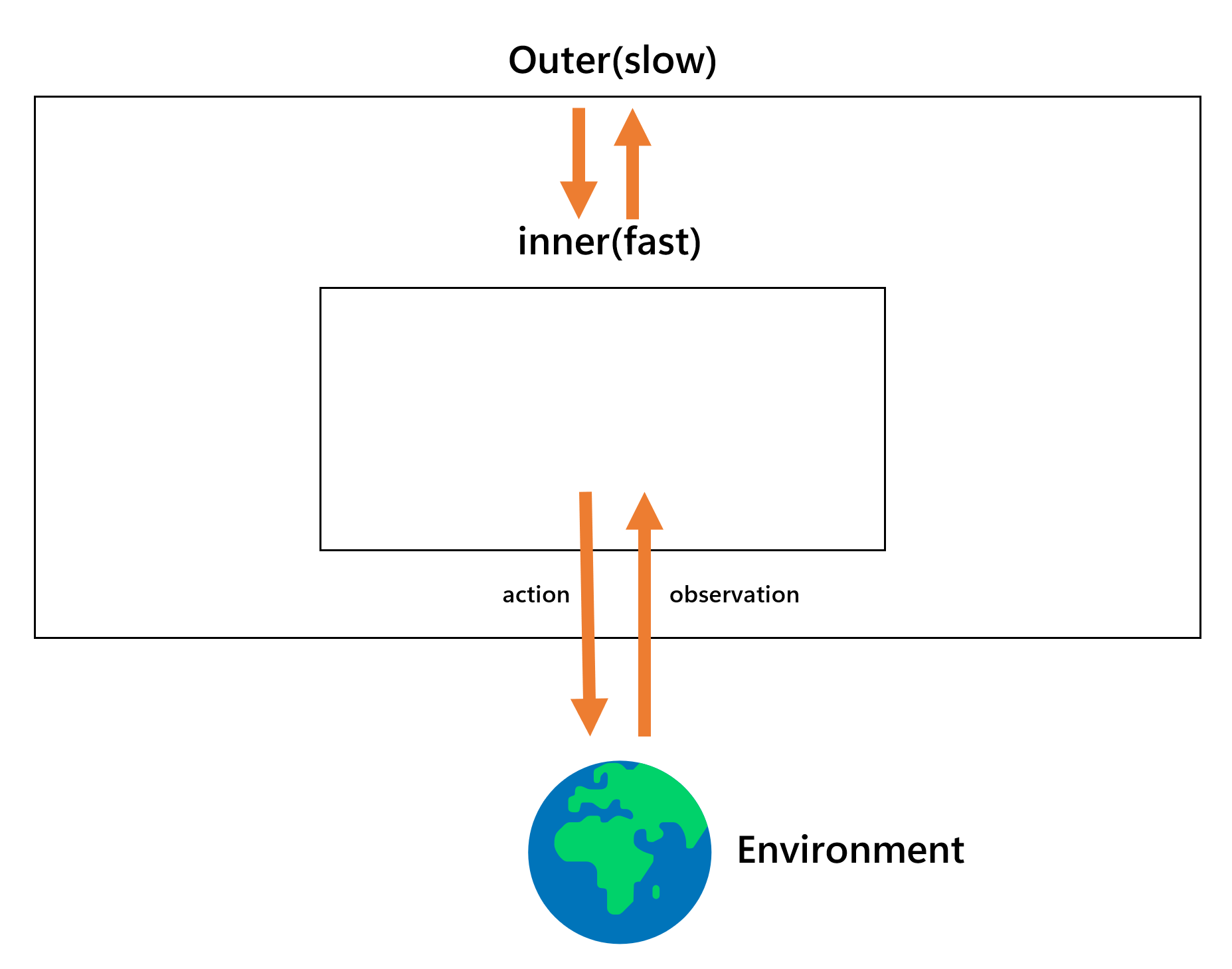

parametric method에서는 Meta-learning 은 outer-loop(slow)와 inner-loop(fast)로 보통 구분되어집니다.

inner(fast) learning은 직접적으로 environment와 상호작용을 거칩니다.

이 시스템은 빠르게 environment에 적응할 수 있도록 해줍니다.

outer(slow) learning은 environment와 직접적으로 상호작용하지 않습니다.

inner learning process에서 수행한 많은 시도를 바탕으로 fast learning의 inductive bias를 변경합니다.

inductive bias는 데이터에 맞게 더 빠르게 더 적합하게 수행할 수 있도록 돕는다고 앞에 서술하였습니다.

정리하자면 fast learning system은 광범위하게 environment와 순차적으로 상호작용 할 수 있는 모델이며,

slow learning system은 이 fast learning system의 RL 자체를 최적화 시키거나,

fast learning system이 다양한 환경에서 빠르게 학습할 수 있도로 parameter를 조정하는 역할을 합니다.

inter-episodic method

추가적으로, 직접적이지만 효과적인 meta-learning 방식은 agent에게 episode간 메모리를 부여하는 것입니다.

많은 meta-learning 테크닉들이 inter-episodic memory를 사용합니다.

episodic control이라고 불리는 이 방식은 새로운 observation이 agent에게 주어졌을 때,

이 observation과 비슷한(closest) 기억들을 그때의 reward와 함께 재기억(recall)해냅니다.

parametric method와 다르게 굉장히 빠릅니다.

이방법은 예전에 deterministic dynamics(쉽다!)에만 적절하다고 생각되었지만,

최근에는 고차원(high-dimensional)에서도 적용이 가능하다고 합니다.

episodic memory는 kNN(k-Nearest-Neighbor model)을 이용해 구현이 가능합니다.

이러한 방식은 심리학적, 인지과학적 관점에서 굉장히 타당하다고 합니다.

최근에는 두 방법(parametric, inter-episodic memory)가 합쳐져서 쓰인다고 하며, 완전히 상호 베타적이지 않습니다.