본 Thesis review는 Carnegie Mellon University(CMU) Ph.D student Emillio Parisoto님의 Meta Reinforcement Learning through MemoryThesis를 바탕으로 작성하였습니다.

118page 분량, 8개의 chapter로 나누어져 있는 만큼, 나누어 review하도록 하겠습니다.

Abstract

Meta Learning을 소개하면서 118페이지 분량의 thesis를 시작합니다.

RL(Reinforcemenet Learning, 강화학습)은 현재 인공지능의 중심에 있습니다.

하지만 현재 RL 알고리즘은 굉장히 많은 트레이닝 샘플(데이터)이 필요합니다.

굉장히 RL 알고리즘은 데이터 비효율적(inefficiency)이라고들 말합니다.

이런 비효율성은 RL agent가 시뮬레이터 없이는 행동을 할 수 없게 만듦니다.

그래서 저자는 Meta-RL이 필요하다고 말합니다.

Meta-RL의 목적은 RL agent를 어느곳에다가 가져다 놓아도 빠르게 학습해, 적응할 수 있도록 하는 것입니다.

그래서 기존 RL과 같이 단 하나의 환경이 아닌, 환경의 분포(distributions of environments)를 학습하고자 합니다.

이 환경의 분포 중에서 환경이 샘플링 되어 빠르게 학습하는게 목표겠죠.

샘플링이 된 후, meta-learner는 빠르게 policy를 업데이트 합니다.

distribution을 잘 학습하기 위해서 공통적인 하위 구조의 중요한 점을 공유해야 하고,

meta-learner가 자신만의 inductive-biases를 가지게 됩니다.

inductive bias(귀납적 편향) 란 머신러닝 알고리즘이 학습할 때 특정 가정이나 선입견으로부터 시작하여 특정 가설이나 모델 구조를 더 우선적으로 고려하도록 하는 것을 말합니다. 예를 들어, 선형 회귀 모델은 데이터의 관측치들이 직선 상에 분포하는 경향이 있다고 가정하므로 비선형 데이터에 대해서는 적합하지 않은 inductive bias를 가지고 있습니다. 이와 유사하게, 신경망은 깊은 층이 복잡한 함수를 모델링할 수 있다는 가정으로부터 시작하여 복잡한 모델을 선호하는 inductive bias를 가지고 있습니다.

이 Thesis에서는 이런 inductive-biases를 memory를 추가하여 새로운 환경에 빠르게 적응하는 Meta-RL을 소개합니다.

똑같은 말을 또 반복하지만, 전체 환경에 영향을 받은 memory로 policy를 제공하는 것이죠.

공통의 하위 구조를 memory로 저장을 한 다음, 이를 이용해 좋은 policy를 제공한다는 말입니다.

이 Thesis는 굉장히 방대한 만큼 memory를 사용하는 여러가지 techniques를 설명할 예정입니다.

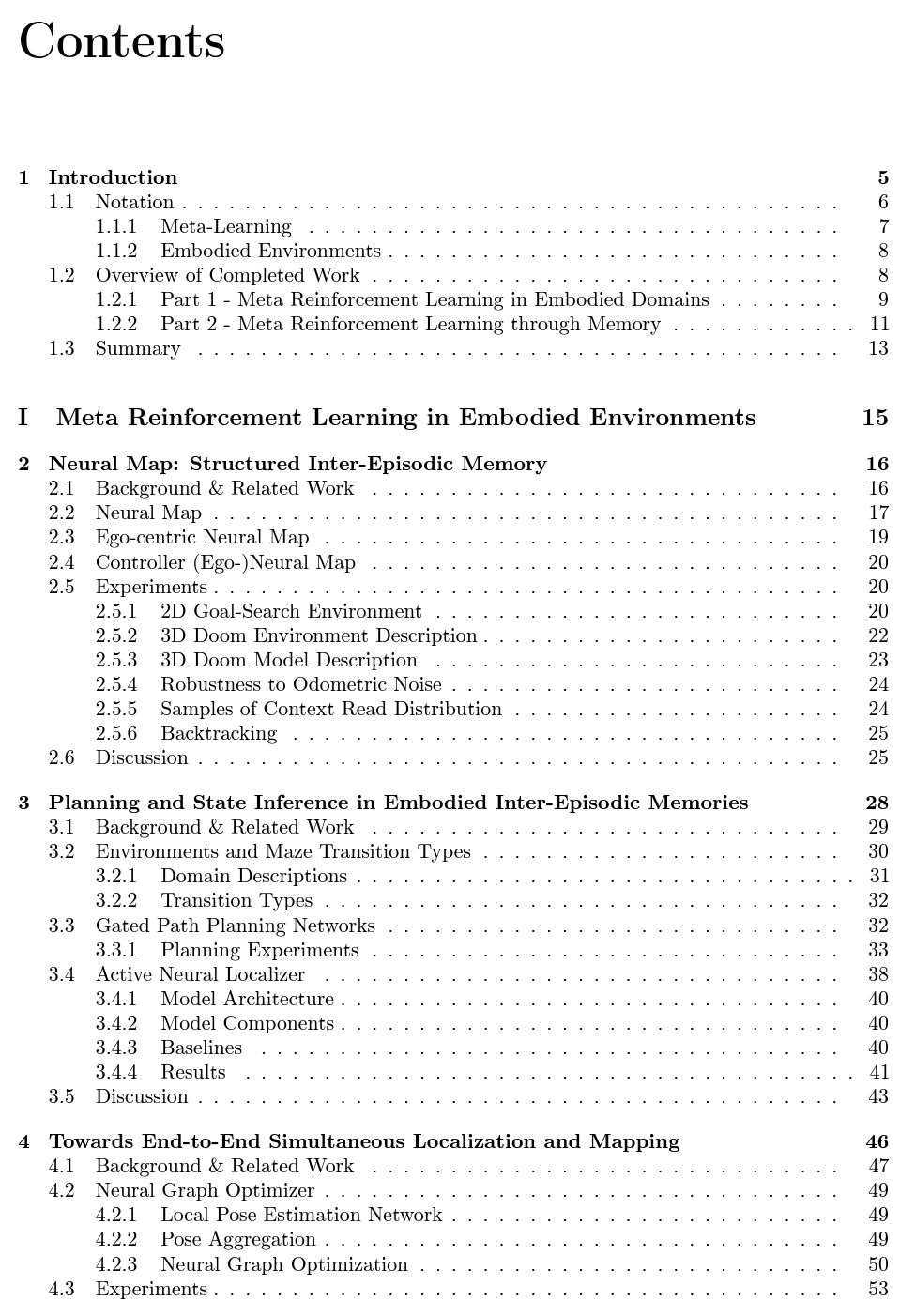

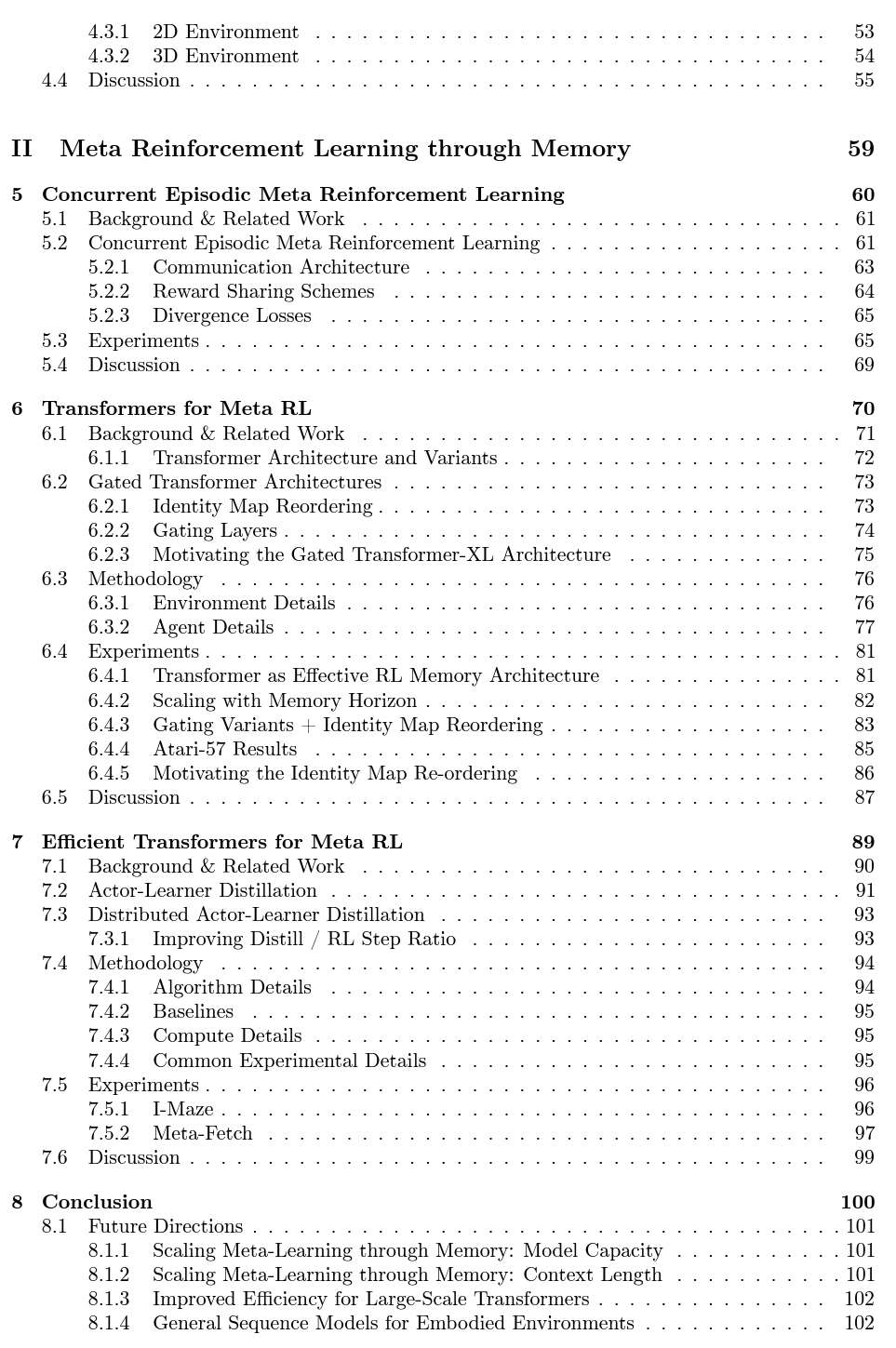

목차로 처음을 마무리하도록 하겠습니다.