💡본 게시글은 패스트캠퍼스 [혁펜하임의 AI DEEP DIVE] 체험단 활동을 위해 작성되었습니다

💡강의 링크 : https://bit.ly/3GV73FN

안녕하세요. 이 글은 혁펜하임 강사님과 강사님이 이번에 오픈하신 AIDEEPDIVE Course에 대해 소개해드리고자 합니다.

저는 인공지능과 딥러닝을 공부하면서 카카오톡 오픈채팅방을 활용하는데요. 거기서 혁펜하임님이 계셨고, 누구신지는 자세히 몰랐지만, 질문에 대한 답을 해주시는 것을 볼 때, 알기 어렵고 추상적인 지식을 되게 알기 쉽게 풀어서 설명해주시는 것에 되게 인상적인 느낌을 받았습니다.

모르는 것이 생겼을 때, 구글링이나 유튜브, 혹은 인터넷 강의를 수강해서 해결하는 방법이 있습니다. 훌륭하신 분들이 설명해주신 많은 소스들이 있는데요.

저는 혁펜하임님이 그 중 하나라고 자신합니다. 왜냐하면 혼자 공부를 하면서 가장 어려운 것이 큰 그림을 그리는 것, 조각조각 단편적으로 있는 지식들을 하나로 연결하는 것입니다.

혁펜하임님은 이러한 어려운 점을 해결하는 데 전문성을 가지고 계신 것 같습니다.

강사 - 혁펜하임

이번 강의 자료를 통해서 알게된 혁펜하임님은 카이스트 박사 출신이시고, 연구원으로 활동하셨습니다. 강의 OT에서 남들이 이해하기 어려운 것을 쉽게 설명하는 것에 흥미를 느낀다고 하셨고, 그것에 몰두하고 싶어서 다니던 직장을 그만두시고 강의에 전념하신다고 합니다.

사진으로 보시는 것처럼 다양한 기관의 직원들을 대상으로 머신러닝, 딥러닝과 관련된 강의를 진행했고, 공부하면서 필수로 알아야하지만 어려워서 접근성(?)이 어려운 부분들에 대해 쉽게 이해가 가능하도록 설명을 해주시는 것이 큰 특징입니다.

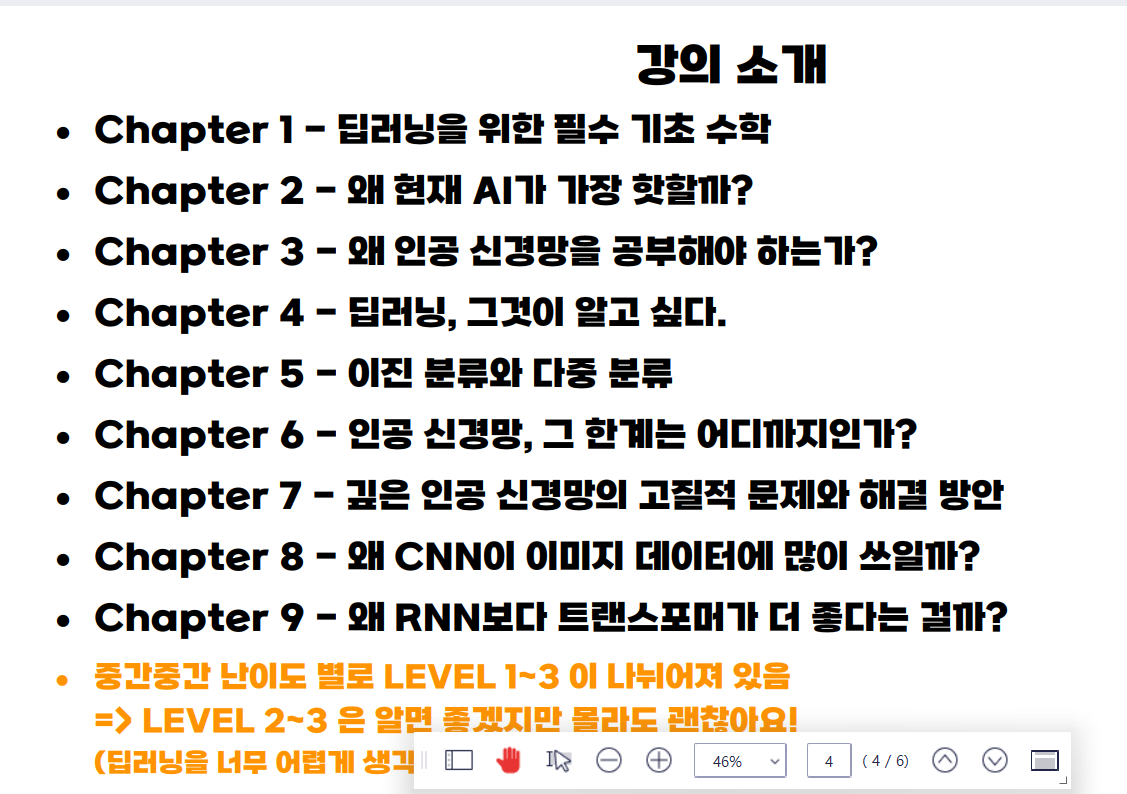

강의 소개

강의는 크게 9가지의 챕터로 이루어져있습니다.

Chaper 1 - 딥러닝을 위한 필수 기초 수학

- 함수와 다변수 함수

- 로그 함수

- 벡터와 행렬

- 전치와 내적

- 극한과 입실론-델타 논법

- 미분과 도함수

- 연쇄 법칙

- 편미분과 그래디언트

- 테일러 급수

- 스칼라를 벡터로 미분하는 법

- 왜 그래디언트는 항상 가파른 방향을 향할까

- 벡터를 벡터로 미분하는 법

- 벡터를 벡터로 미분할 때의 연쇄 법칙

- 스칼라를 행렬로 미분하는 법

- 행렬을 행렬로, 벡터를 행렬로 미분하는 법

- 랜덤 변수와 확률 분포

- 평균과 분산

- 균등 분포와 정규 분포

- 최대 우도 추정 (MLE)

- 최대 사후 확률 (MAP)

- 정보 이론 기초

Chaper 2 - 왜 현재 AI가 가장 핫할까?

- AI vs ML vs DL (Rule-based vs Data-based)

- 딥러닝의 활용 CNN, RNN, GAN

- 머신러닝의 분류 지도 학습과 비지도 학습

- 자기지도 학습

- 강화 학습

Chaper 3 - 왜 우리는 인공신경망을 공부해야 하는가?

- 인공 신경망, weight와 bias의 직관적 이해, 인공 신경망은 함수다!

- 선형 회귀, 개념부터 알고리즘까지 step by step

- Gradient Descent

- 가중치 초기화 기법

- GD vs SGD

- mini-batch SGD

- Moment vs RMSProp

- Adam

- Training vs Test vs Validation

- K-fold Cross Validation

Chaper 4 - 딥러닝, 그것이 알고 싶다

- MLP, 행렬과 벡터로 나타내기 & 왜 non-linear activation이 중요할까

- Backpropagation 깊은 인공신경망의 학습

- 행렬 미분을 이용한 Backpropagation

Chaper 5 - 이진 분류와 다중 분류

- 선형분류와 퍼셉트론

- Sigmoid를 이용한 이진 분류

- MSE vs likelihood

- 인공신경망은 "MLE 기계"다!

- Softmax를 이용한 다중 분류

- Summary

Chaper 6 - 인공 신경망, 그 한계는 어디까지인가?

- Universal Approximation Theorem

- Beautiful insights for ANN

Chaper 7 - 깊은 인공신경망의 고질적 문제와 해결 방안

- Vanishing gradient

- Vanishing Gradient이 해결 방안 ReLU

- BN 직관적으로 이해하기

- Loss landscape 문제와 skip-connection (resnet이 아직도 사랑받는 이유)

- Overfitting 개념과 Data Augmentation

- Overfitting 방지 방안 - Dropout

- Regularization

Chaper 8 - 왜 CNN이 이미지 데이터에 많이 쓰일까?

- CNN은 어떻게 인간이 사고방식을 흉내냈을까? MLP와의 비교 분석

- CNN은 어떻게 특징을 추출할까

- 3D 입력에 대한 Convolution

- Padding & Stride & Pooling

- CNN의 feature map 분석

- VGGnet

- Beautiful insights for CNN

Chaper 8 - 왜 CNN이 이미지 데이터에 많이 쓰일까?

- 연속적인 데이터 예시와 행렬과 벡터 식으로 RNN 이해하기

- RNN의 backpropagation과 구조적 한계를 직관적으로 이해하기

- plain RNN 실습

- seq2seq

- RNN attention의 문제점과 트랜스포머의 self-attention

- 강의 마무리 (딥러닝 연구는 뭘 잘해야 할까)

보시는 것처럼 딥러닝 학습에 있어서 필수적인 요소들과 포인트를 학습하는 게 아니라 선으로 이어지는 것처럼 흐름을 따라서 커리큘럼이 구성돼있는 것을 볼 수 있습니다.

마치며

딥러닝 학습을 시작하신 분이거나, 기초는 학습했지만 좀 더 원론적인 부분으로 들어가고 싶은 분들께 추천드리는 강의입니다.

강의 자료와 PPT도 제공이 되니 학습에 많은 도움이 될 것 같습니다.