📎 회귀 모델의 오류 지표 알아보기

📎 When to choose which? (MAE, RMSE)

📝 모델 성능 평가 지표

1) 회귀모델 평가지표

MSE (Mean Squared Error) =

from sklearn.metrics import mean_squared_error

mse = mean_squared_error(y, y_pred)MAE (Mean absolute error) =

from sklearn.metrics import mean_absolute_error

mae = mean_absolute_error(y, y_pred)RMSE (Root Mean Squared Error) =

rmse = mse ** 0.5R-squared (Coefficient of determination) =

from sklearn.metrics import r2_score

r2 = r2_score(y, y_pred)🔎 자세히 알아보기

R-squared(결정계수)

- 독립변수가 종속변수를 얼마만큼 설명해 주는지를 가리키는 지표

- 0에서 1 사이의 값을 취하며, 1에 가까울수록 설명력이 높다는 것을 의미2) 분류모델 평가지표

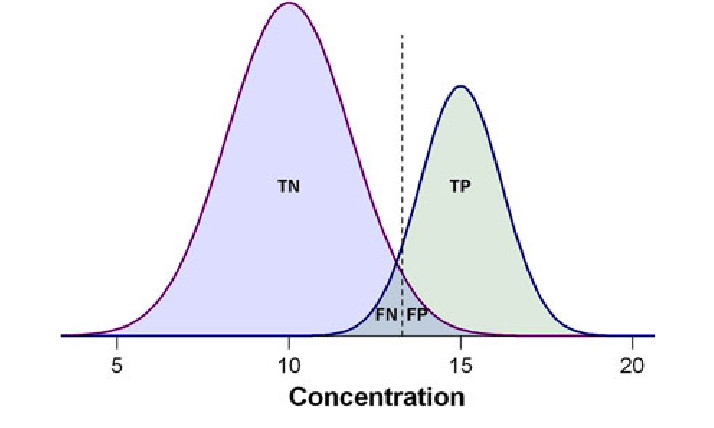

Confusion matrix

Training을 통한 Prediction 성능을 측정하기 위해 예측 value와 실제 value를 비교하기 위한 표

| 예측 positive | 예측 negative | |

|---|---|---|

| 실제 positive | TP | FN(type 1 error) |

| 실제 negative | FP(type 2 error) | TN |

# classification_report

from sklearn.metrics import classification_report

print(classification_report(true_labels, guesses))Accuracy =

from sklearn.metrics import accuracy_score

accuracy = accuracy_score(true_labels, guesses)Recall =

from sklearn.metrics import recall_score

recall = recall_score(true_labels, guesses)

Precision =

from sklearn.metrics import precision_score

precision = precision_score(true_labels, guesses)

F1 Score =

from sklearn.metrics import f1_score

f1 = f1_score(true_labels, guesses)

TP: 약의 효과가 있는데, 효과가 있다고 판단

TN: 약의 효과가 없는데, 효과가 없다고 판단

FP: 약의 효과가 없는데, 효과가 있다고 판단

FN: 약의 효과가 있는데, 효과가 없다고 판단