Reference

Markov model

- 개념:

단순히 이전 시점

but markov chain은 !! 순서를 생각, processing,

근데 이전만 본다는것도 순서를 본다는거 아닌가??

다 똑같은데 그럼 MArkov가 여러개 있다는거구나?

Markov Chain

-

개념:

마코프 성질(Markov Property)을 지닌 이산확률과정(discrete-time stochastic process)러시아 수학자 마코프가 1913년경에 러시아어 문헌에 나오는 글자들 순서에 관한 모델 구축 위해 제안된 개념

-

수식:

qi가 나타날(transition) 확률은 이전 상태 qi−1에만 의존한다!!

그래서 history 필요없이 바로 전 상태만 알면 된다!

-

시간안정성(time-homogeneous, time stationary) 가정:

transition 확률 값이 시점에 관계 없이 상태만 의존

(그럼 100년전 오늘 날씨가 화창했다 = 오늘 날씨가 화창하다?)

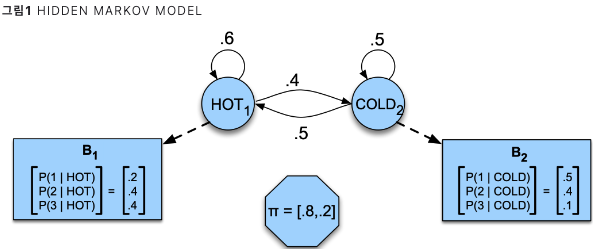

Hidden Markov Models

- 개념:

- 각 상태가 마코프체인을 따르되 은닉(hidden)되어 있다고 가정

(예: 100년 전 정보 아이스크림 소비 기록 뿐일때, 아이스크림 소비 기록을 연쇄적으로 관찰해서 날씨 예측. but 해당 날짜 날씨 직접 관측 불가.) - 관측치(observation) 뒤에 은닉되어 있는 상태(state)를 추정

(observation: 아이스크림 판매, state: 100년 전 날씨)

=> 보유하고 있는 데이터(observation)는 실제 은닉 상태들(true hidden state)이 노이즈가 낀 형태로 실현된 것 (noisy channel)

- 각 상태가 마코프체인을 따르되 은닉(hidden)되어 있다고 가정

- 노드: 은닉상태

- 엣지: 전이

- 엣지 위 숫자: 전이 확률(transition probability)

(노드 기준 전이확률 합 =1)- B: 방출 확률(emission probablity)

- phi: 초기값 (hot, cold)

- 주로 Goal:

observation가지고 전이확률과 방출확률 추정

아! 기존 마코브체인은 input, output이 같은데, 우리 asr은 input output 이 다르다. observation이 다르다. 이걸로 추측을 해야하구나!!!!

우리의 observation은 그럼 vector! 이걸로 추측! 아댑악 대바그~

Likelihood Computation

전방 X 후방

어쨌든 이개념으로 generative랑 나온거구만? 어떻게 이렇게 똑똑할까?

Forward/Backward Algorithm

전방: 현재 상태 나타날 확률

후방: 현재상태로 뒤에 다음에 어떤 확률로 나올지

- evaluation

- decoding

- learning

전체 다 계산해야한다? memorization 하여 반복, 동적프로그래밍 진행해서

예전에 계산한건 가져와서 반복

Decoding

Viterbi Probability

비터비, 가장 효율 좋은 sequence를 뽑느다

확률이 있을 때 가장 큰 확률이 나오는걸로 추출! max

다이내믹 프로그래밍 적용

search 같은거군