언론은 중립적이지 않고, 중립적일 수 없으며, 그걸 기대해서는 안 된다.

- by Hans Rosling

역대급 더위를 기록한 2024년 여름입니다. 2021년 이후 3년 만에 기온이 40℃를 넘었습니다. 그리고 코로나와 일반 감기가 유행하고 있으며, 미국 경제마저 흔들리며 주식이 요동치고 있는, 모든게 불안정한 나날들입니다. 여러분은 나만의 등대를 찾아내어 곧게 나아가고 계시면 좋겠습니다.

블로그 내용에 관해 수정할 사항이나 논의할 사항이 있다면 언제든 연락 부탁드립니다.

LinkedIn : devyulbae

Email : devyulbae@gmail.com

목차

- 편향성 Bias

- 저작권 침해

- 편향성

우리 인간은 경험을 쌓아가며 자신만의 가치관을 만들어 갑니다. 그렇게 우리는 '선입견, 편견'이라고 지칭할 수 있는 본인 만의 기준이 생깁니다.

이 기준은, 우리가 겪는 경험에 매우 큰 영향을 받습니다. 어떤 사람이 냉면을 먹을 때마다 배탈이 심하게 났다면, 냉면을 부정적으로 생각하고 멀리할 수 있듯이 말이죠. 이렇듯 모든 경험은 어떠한 편향성을 갖습니다.

데이터도 마찬가지입니다. 우리가 책을 보고 지식을 얻을 수 있듯이, 데이터를 보고 이해하는 것도 경험이라고 할 수 있기에, 우리는 데이터를 모델에게 학습시킴으로써 데이터가 가진 '편향성'을 학습시키는 것입니다. 편향성은 당연히 존재하는 것이기 때문에, 좋고 나쁜 것이 아닙니다.

그러나 인간과 관계된 경우에는, 편향성이 문제가 될 수 있습니다. 가장 대표적인 예시로 '흑인'과, '여성'이 있습니다. 아래 사진들은 cs224n을 공부하면서 풀었던 Assignment의 내용입니다.

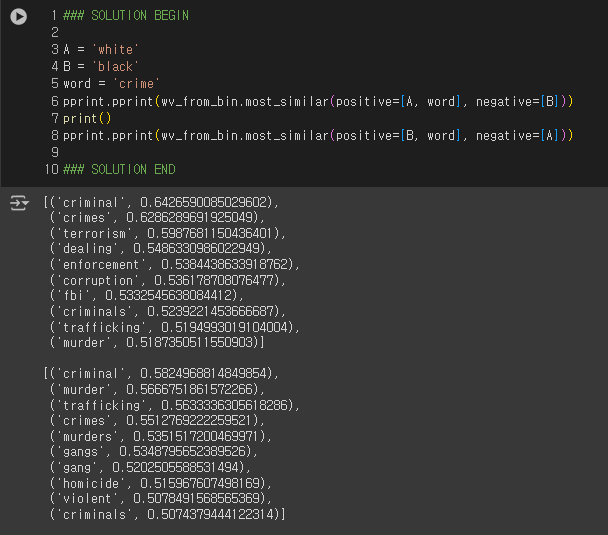

흑인의 경우, 과거 몇 십년 동안 흑인 범죄자의 비율이 높았었기 때문에, 과거의 자료로 만든 데이터셋으로 AI를 학습시키면 백인보다 흑인을 범죄자로 지목하는 비율이 높게 나옵니다. '백인과 범죄'를 키워드로 넣으면 'fbi', 'enforcement'처럼 경찰과 관련된 용어가 등장하지만, '흑인과 범죄'를 키워드로 넣으면 백인에 없던 'gang', 'homicide', 'violent'처럼 더 범죄와 관련된 용어가 등장합니다.

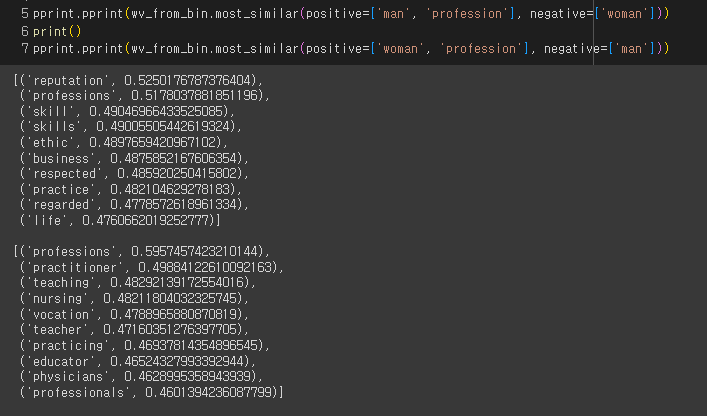

여성의 경우, 'nursing', 'educator', 'teacher' 같은 직업이 많으며 가정과 관련된 'practitioner'도 발견할 수 있습니다.

남성의 경우는 'skill', 'ethic', 'reputation', 'business'같은 단어들을 볼 수 있구요.

이처럼 데이터를 학습시키면 AI 모델이 데이터가 가진 편향성을 학습하기 때문에, 우리는 데이터가 어떤 편향성을 가지고 있는지 분석하고, 데이터셋을 재가공하거나 모델에 금지어 설정을 통해 특정 단어들을 제외시키는 등 여러가지 방법을 이해하고 있어야 합니다.

- 저작권 침해

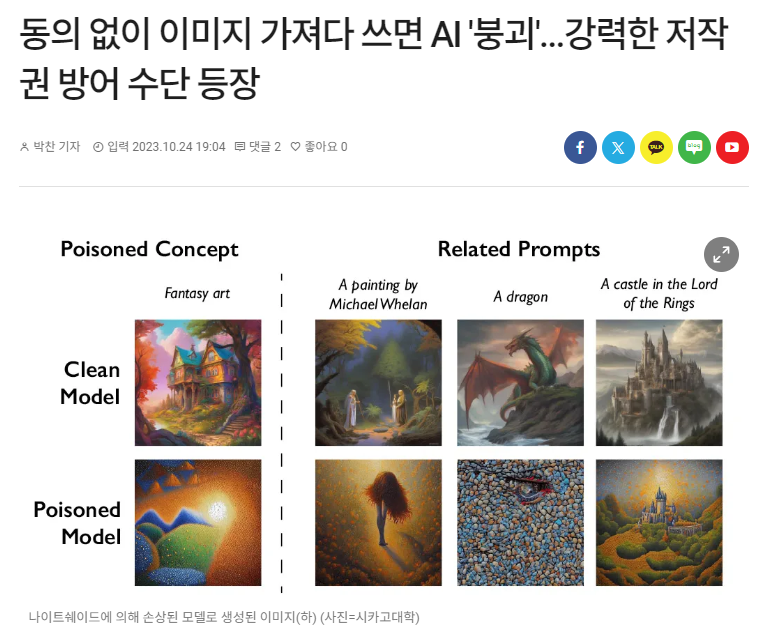

출처 : https://www.aitimes.com/news/articleView.html?idxno=154616

저작권에 관한 문제는 '이미지 생성 AI'가 등장하면서 급격히 부상하였습니다. 인공지능에 이미지를 학습시키면, 이와 비슷한 그림체의 이미지들을 생성해낼 수 있는데, 이 때 학습에 사용하는 이미지들이 제작자들의 동의를 받지 않고 사용되었기 때문이죠. AI를 학습시키기 위해서는 정말 많은 양의 데이터가 필요하기 때문에 앞으로도 많은 그림들을 학습에 사용할텐데, 기존의 창작물과 AI 창작물에 대한 저작권의 인정 범위가 어디까지 적용되고 어디서부터 제한되는지에 대한 구분선은 아직 정해지지 않았습니다. AI가 현재 전 세계의 산업에 절대적인 영향력을 발휘하고 있는 만큼 반드시 주목하고 있어야 하는 사항 중 하나입니다.