[CV_논문리뷰]EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

Abstract

- we systematically study model scaling and identify that carefully balancing network depth, width, and resolution can lead to better performance.

- 기존의 모델은 accuracy 향상을 위해 depth, sidth, resolution(image size)중 한가지만 조정하지만 이 논문에서는 세가지 모두를 균형있게 조정할 것이다.

- Our EfficientNets also transfer well and achieve state-of-the-art accuracy on CIFAR-100 (91.7%), Flowers (98.8%), and 3 other transfer learning datasets

- EfficientNets를 전이학습 시켜도 상당한 정확도를 낼 수 있다.

Introduction

- However, the process of scaling up ConvNets has never been well understood and there are currently many ways to do it.

- In previous work, it is common to scale only one of the three dimensions – depth, width, and image size.

- 위에서 언급했듯 ConvNets의 Accuracy를 높이기 위해 dimension을 변경하는 일은 여러 차례 시도되었다. 하지만 EfficientNets에서는 세가지 변수를 모두 변경한다. 이를 논문에서 compound scaling method 라고 표현할 것이다.

- Our empirical study shows that it is critical to balance all dimensions of network width/depth/resolution, and surprisingly such balance can be achieved by simply scaling each of them with constant ratio

- we are the first to empirically quantify the relationship among all three dimensions of network width, depth, and resolution.

- 세 변수가 일정한 비율을 유지하며 값이 조정된다는 인사이트를 얻음.

Compound Model Scaling

Problem Formulation

Scaling Dimensions

1. Depth

깊이가 너무 깊어지면 기울기 소실 현상 나타남

∴ 경험상 괜찮은 d 추출

2. width

w가 커지면 → fine-grained Feature 추출 가능

너무 커져서 shallow 하면 → higher level Feature 추출 어려움

∴ 경험상 괜찮은 w 추출

3. resolution

해상도 大 → fine-grained Feature 추출 가능

r = 1 : 224x224(기준)

r=2.5 : 560x560

r이 높아지수록 accuracy 증가율은 낮아짐

※ D,W,R 모두 증가할수록 Accuracy 증가율이 낮아진다.

but, 큰 모델에서 D,W,R의 증가가 오히려 정확도 감소를 야기하는 경우도 있음 → we need to coordinate and balance different scaling dimensionsCompound Scaling

- FLOPS(Floating Points Operations per second ≒ 컴퓨팅 파워)

⇒

⇒

Ø : user-specified coefficient that controls how many more resources are available for model scaling

EfficientNet Architecture

having a good baseline network is also critical.

we have also developed a new mobile-size baseline, called EfficientNet.

d,w,r값도 중요하지만 baseline 자체도 중요하다.

최적의 를 찾고 Ø의 증가로 scale up 시킴

Result

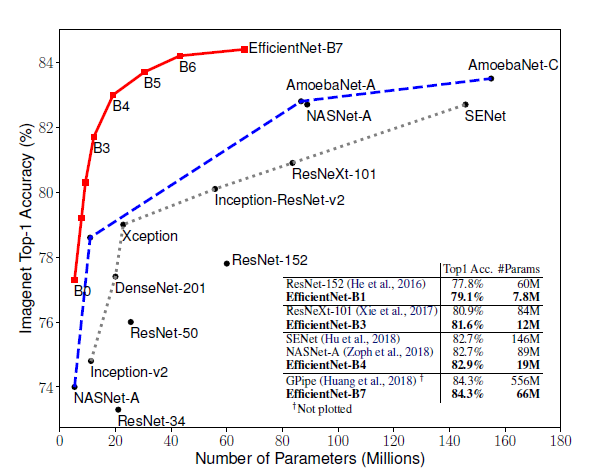

결국 compound scaling을 한 결과가 가장 좋고 성능도 우수하다고 말해주고 있다.

classification 모델 중 EfficientNets는 Layer의 변수는 건드리지 않으면서 d,w,r의 최적값을 찾아 Accuracy를 높이는 역할을 한다.

CV 전문가가 되기 위해 수학적인 센스도 필요하겠지만 여러 기법들을 파악하고 있으면 과제가 주어졌을 때 접근할 수 있는 키가 많아지는 것이기 때문에 최신 논문에 더 관심을 가져야할 필요가 있다고 생각했다.