Error

1.Node.js address already in use

위와 같이 8080을 쓰려는 순간 에러가 발생하였다. 이 전에 8080 port를 사용하다가 비정상적으로 종료시킨거 같다.8080 port를 사용하고 있는 프로세스의 id를 알아내야 한다.sudo lsof -i :8080 를 통해 알 수 있다.이제 이 프로세스를 죽인다

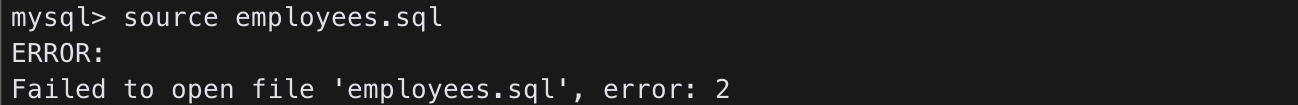

2.Failed to open file

외부 파일 employees.sql 을 불러오려고 했지만 찾을 수 없다고 에러가 나왔다. 현재 경로가 잘못되었다고 판단하여 파일의 절대 경로로 실행해보았다. 처음에 잘 되다가 dump 파일을 못 읽어오는 상태가 되었다.MySQL을 처음에 실행하기 전에 디렉토리를 파

3.Loading class 'com.mysql.jdbc.Driver'. This is deprecated. The new driver class is 'com.mysql.cj.jdbc.Driver'.

의미를 찾아봤더니 사용 되지 않는다는 뜻이다.'com.mysql.jdbc.Driver'가 더 이상 쓰이지 않으니 'com.mysql.cj.jdbc.Driver'를 사용하라는 이야기이다.현재 내가 새용하고 있는 JDBC 커넥터 라이브러리는 mysql-connector-j

4.Mac Launchpad 오류

터미널에 다음과 같이 명령어를 작성한다.

5.Failed to create the Java Virtual Machine

응용 프로그램에 들어가 STS 아이콘을 우 클릭 후 패지지 내용 더보기를 눌러 STS.ini를 찾아 다음과 같이 코드를 -vmargs 위에 추가해줍니다.

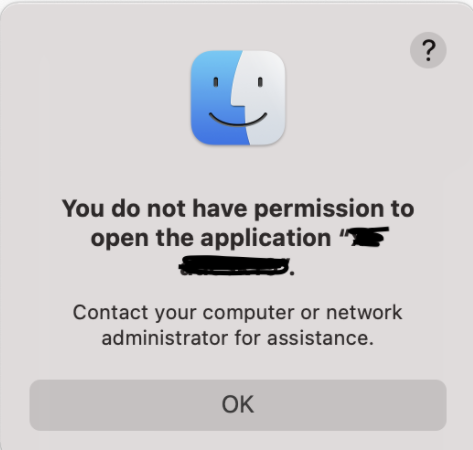

6.You do not have permission to open the application

pkutil --check-signature /Application/앱이름.app 을 터미널에서 실행해보자 invalid 상태라고 뜬다.codesign --force --deep --sign - /Applications/앱이름.app 을 터미널에 실행 시켜 해결한다.

7.datanodes가 보이지 않음

하둡 실행 후 jps 명령어를 통해 실행중인 Java Virtual Machine에 올라간 프로세스를 볼 수 있는데 datanodes가 올라와 있지 않는다.기존 데이터 폴더를 모두 삭제하고 다시 만든 후 dhfs namenode -format 을 하고 ./start-a

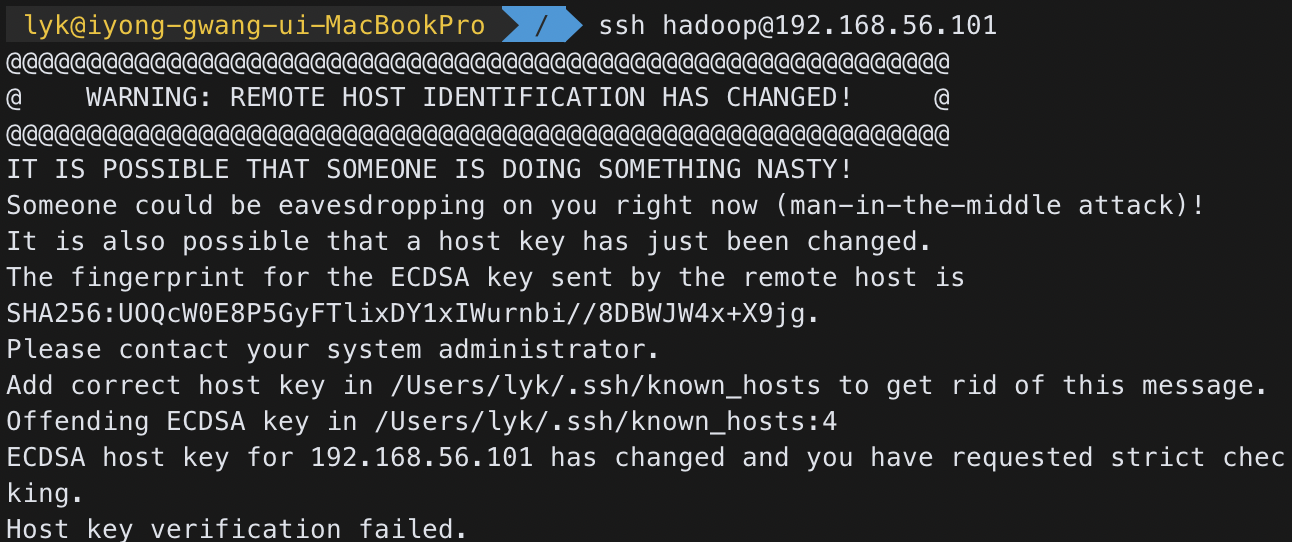

8.IT IS POSSIBLE THAT SOMEONE IS DOING SOMETHING NASTY!

ssh 원격 접속을 하려 했는데 다음과 같은 에러가 발생했다. 문제는 접속 시 man-in-the-middle attack이라고 판단하여 보안상 문제가 발생할 수 있어 막는거 같다.다음과 같은 명령어를 실행하면 문제 없이 원격접속이 가능하다.

9.ssh: connect to host hadoop port 22: No route to host

ssh: connec to host hadoop port 22: No route to host 라는 에러 문구가 뜬다.우선 hostname -I 명령어를 통해 내 ip 주소를 확인한다.확인해본 결과 ip가 내가 원하는 ip로 고정되어 있지 않았다.ip를 고정하기 위해

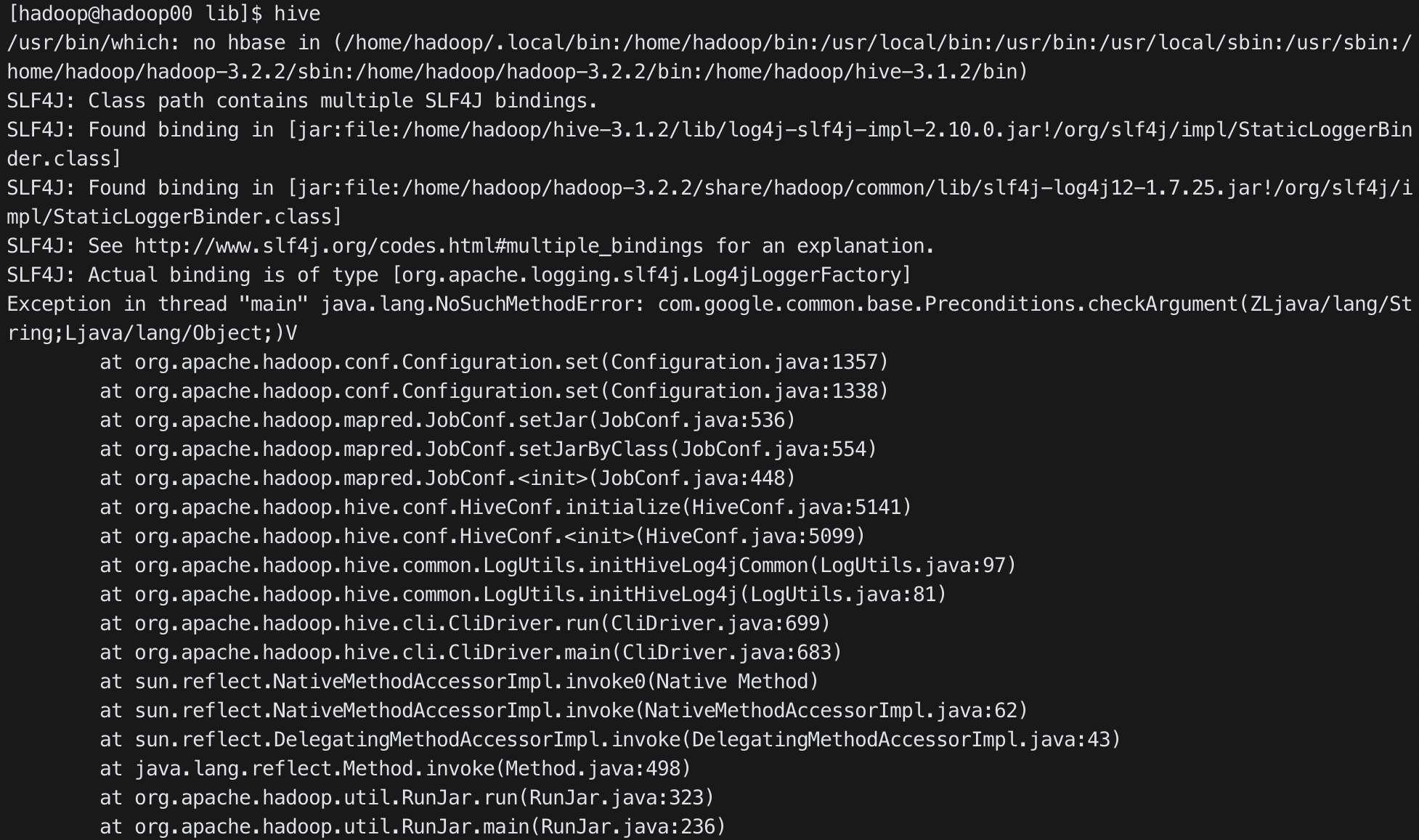

10.Exception in thread "main" java.lang.NoSuchMethodError: com.google.common.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)

hive를 실행시켰더니 다음과 같은 에러가 발생하였다. guava-19.0.jar를 guava-27.0-jre.jar로 바꾸었더니 해결되었다.

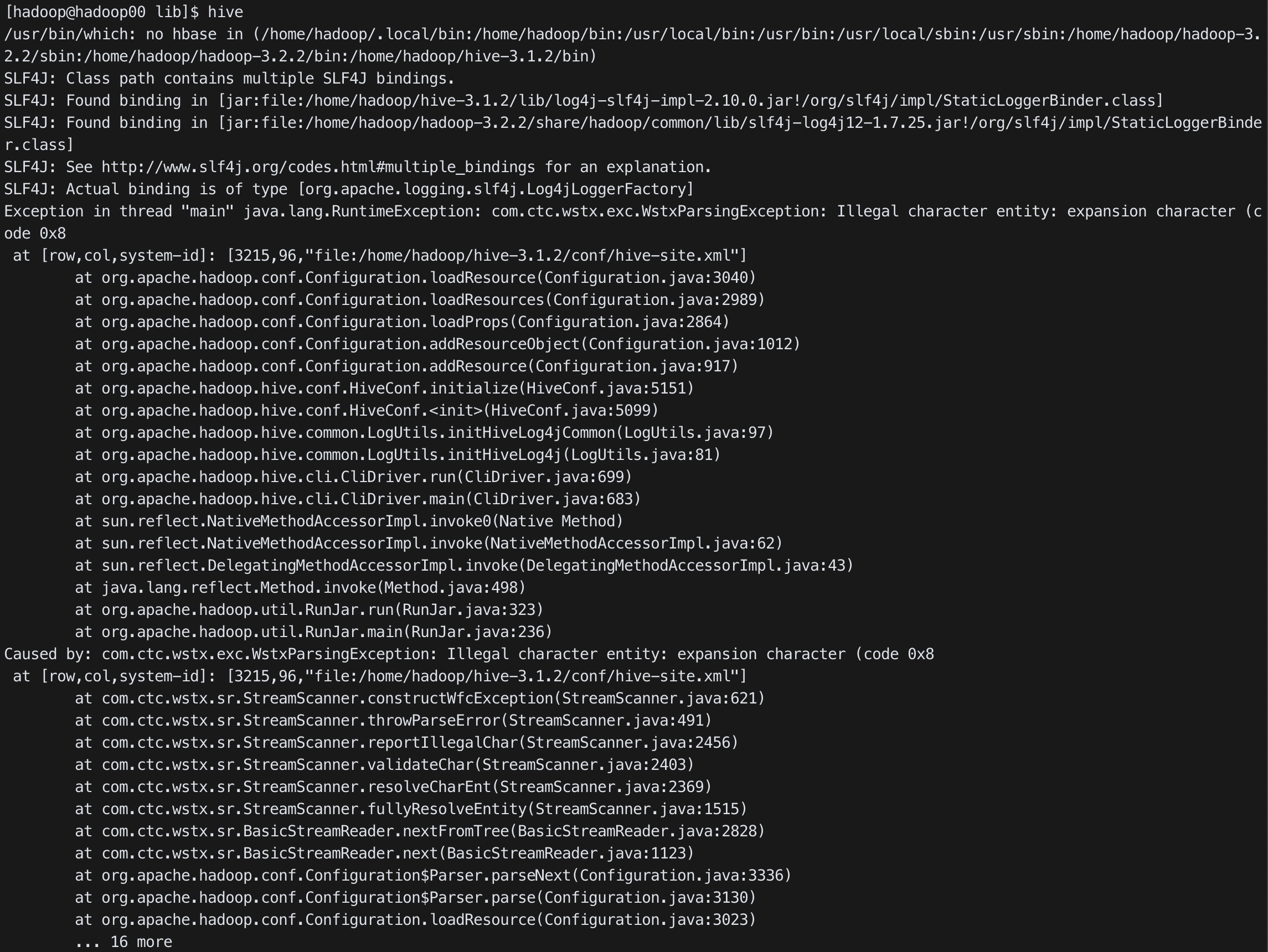

11.com.ctc.wstx.exc.WstxParsingException: Illegal character entity: expansion character (code 0x8 at [row,col,system-id]:[3215,96,"file:/home/hadoop/hive-3.1.2/conf/hive-site.xml"]

hive를 실행하였더니 다음과 같은 에러가 발생하였다.에러에서 나온대로 hive-site.xml의 3215번째 줄을 보았더니 다음과 같이 이상한 문자가 있어 빼주었다.

12.Error: (conn=335) Table 'CTLGS' already exists (state=42S01,code=1050)

mysql에 hive 스키마를 생성하려고 schematool -initSchema -dbType mysql 명령어를 사용하니 다음과 같은 에러가 나왔다. 위 에러는 database의 이름이 중복되었기 때문에 발생한 에러이다.다음과 같이 해결하였다.

13.Error: Failed to download metadata for repo 'appstream': Cannot prepare internal mirrorlist: No URLs in mirrorlist

CentOS8에서 wget을 설치하기 위해 dnf install을 사용했더니 다음과 같은 에러가 났다. CentOS8의 서비스가 22년부터 서비스가 중단되고 CentOS Stream으로 전환된다.CentOS7을 사용하자.기존에 Mirror site를 Vault로 전환

14.Permission denied (publickey,gssapi-keyex,gssapi-with-mic)

Date Created: February 1, 2022 6:10 PMLast Updated: February 1, 2022 7:02 PMTags: hadoop, ssh원격 접속을 하려고 하니 다음과 같은 에러가 발생했다. 에러를 해결하기 위해 여러가지 의심을 해봐

15.Datanode가 브라우저에 하나밖에 안 나옵니다.

hadoop을 실행했고 정상적으로 잘 작동하는거 같으나 브라우저로 접속하여 datanodes를 확인해보면 datanode가 하나밖에 보이지 않는다./etc/hosts에 들어가 ip 등록이 잘 되어 있는지 확인한다. 위와 같이 hadoop00에 대해서 ip가 중복적으로

16.로컬에서 가상환경의 IP로 접근이 불가능합니다.

가상환경의 ip 주소는 192.168.56.100이고 port 번호 9870을 통해 hadoop에 들어가려고 했으나 다음과 같이 실패 가상환경의 방화벽을 내리니 해결할 수 있었다.방화벽 내리는 방법방화벽 다시 올리는 방법RHEL/CentOS 에서 방화벽(firew

17.Execution failed for task ':MemberApp.main()'.

다음과 같은 에러가 발생하였다.설정에 들어가 build를 gradle에서 IntelliJ IDEA로 둘 다 바꿔줬다.

18.FileZilla 500 OOPS: chroot

vsftpd를 설치 후 FileZilla로 연결 요청을 보냈지만 다음과 같은 에러가 발생 SELinux의 방화벽을 닫아준다.SELinux를 임시로 비활성화 시킨다.getenforce 를 하면 permissive 상태로 되어 있는 것을 볼 수 있다.SELinux 완전히

19.python3: can't open file 'python3': [Errno 2] No such file or directory

pyspark를 jupyter notebook으로 사용을 하기 위해 환경변수 설정을 해주었고 다시 되돌리기 위해 환경변수를 제거 했지만 그대로 jupyter notebook으로 돌아감결국 고치려다 다음과 같이 환경변수를 설정해줬지만 에러가 발생 .bashrc에서

20.Attempting to deserialize object on a CUDA device but torch.cuda.is_available() is False. If you are running on a CPU-only machine, please use torch.load with map_location=torch.device('cpu') to map your storages to the CPU.

GPU로 학습하여 저장한 모델 전체를 cpu로 불러오니 에러가 발생하였다. 코드를 다음과 같이 변경하여 불러오니 해결되었다.모델 저장하기 & 불러오기 - PyTorch Tutorials 1.10.2+cu102 documentation

21.unable to open swap file “Filename” for recovery impossible

python 파일을 고치기 위해 vim으로 열었지만 이전과는 다르게 다음과 같이 에러가 나면서 이상해졌다. 메모리 공간이 부족하거나 알 수 없는 이유로 인해서 편집 이력이 있었던 파일의 스왑(SWAP) 파일을 열지 못하여 발생하는 문제이다.아니나 다를까 df -h

22.UsageError: Line magic function %%writefile not found.

위와 같은 코드를 작성하였더니 다음과 같은 에러가 발생하였다. magic command %%writefile은 jupyter notebook cell의 첫번째 줄에 작성해야 한다.다음과 같이 수정하였더니 정상적으로 동작했다.python jupyter magic %

23.NameError: name 'Tagger' is not defined

구글 colab에서 mecab을 설치 후 다음과 같은 명령어를 실행했더니 에러가 발생하였다.에러mecab을 다음 링크를 통해 다운 받는다.구글 코랩(Google Colab)에서 Mecab 형태소 분석기, konlpy 쉽게 설치하기

24.PermissionError: [Errno 13] Permission denied

mac에서 vscode로 flask app.py를 돌릴려고 하니 다음과 같은 에러가 발생하였다. 다음 명령어로 app.py를 실행시킨다.

25.Object of type 'Decimal' is not JSON serializable

title: ""author: name: 이용광 link: https://github.com/dldydrhkddate: 2022-03-11 23:53:00categories: Errortags: json, python3math: truemermaid: tr

26.No module named 'pandas_profiling’

env01이라는 내가 만든 conda 가상환경에서 pip install pandas-profiling 명령어로 pandas-profiling으로 설치 후 jupyter notebook에서 pandas_profiling 을 import 하였지만 다음과 같은 에러가 발생하

27.sh: react-scripts: command not found

github에서 react가 있는 폴더를 pull을 하여 npm start 명령어를 실행하였지만 script가 없어 실행이 불가능하다고 다음과 같은 에러가 나왔다.다음 명령어를 실행하여 node_modules를 만들어줌\[오류] /bin/sh: react-scripts

28.TypeError: 'int' object is not callable

python으로 알고리즘 문제를 풀던 중 len()함수가 도저히 먹히지가 않고 다음과 같은 에러가 계속 나왔다.len이라는 변수를 사용해서 생긴 에러였다.이미 정해져 있는 함수 이름은 변수 이름으로 사용하지 말자.

29.MongoDB 랜섬웨어 감염

aws EC2에 mongoDB를 설치하였고 어느날 들어가니 데이터가 다 날아가고 이상한 말들이 적혀 있었다. 0.026 비트코인을 지불하면 잃어버린 데이터를 복구해주겠다는 것이고 무시할 경우 GDPR에 신고하여 법적인 책임을 물게 하겠다는 것이다.다행히도 DB에는 공

30.The kernel appears to have died. It will restart automatically by using XGBoost

Jupyter notebook에서 XGBoost를 사용하기 위해 python -m pip install xgboost를 하였고 사용하려고 하니 다음과 같은 에러가 났다.OS 차이로 인한 에러인것 같다.conda install -c anaconda py-xgboost 로

31.unable to find index for $geoNear query

mongoDB 데이터coordinates는 경도, 위도 순이다.VOVisitJejuLocationLocation컨트롤러ServiceInterfaceImplementsRepository위와 같이 코드를 작성 후 postman으로 다음과 같이 보냈다.결과는 다음과 같이 에

32.Index build failed :: caused by :: Can’t extract geo keys

mongoDB의 GeoJSON을 사용하기 위해 다음과 같이 mongoDB에 쿼리를 날렸더니 에러가 떴다.Error 무엇때문인지 ObjectId(’624708b37881cf12acabc8cc’) 요놈의 index를 못 만드는거 같아 조회를 해봤더니 다음과 같았다.

33.백준 python RecursionError

백준 문제를 풀던 도중 recursion error가 발생하였다. 백준의 경우 python 재귀함수의 호출 스택이 1000까지로 설정되어 있다.다음을 코드에 추가 시켜 함수 스택 limit을 조절할 수 있다.런타임 에러 (RecursionError)

34.Failed to start bean 'documentationPluginsBootstrapper'; nested exception is java.lang.NullPointerException"

swagger를 적용하기 위해 maven dependency에 다음과 같이 추가하였다.swagger config는 다음과 같이 작성하였다.빌드를 하니 다음과 같은 에러가 나왔다. Spring boot 2.6버전 이후에 spring.mvc.pathmatch.matc

35.Swagger Whitelabel Error Page

swagger dependency를 다음과 같이 설정했다.swagger 설정을 제대로 했음에도 불구하고 다음과 같이 whitelabel page가 떴다. 2.x 버전인 경우 http://localhost:8080/swagger-ui.html3.x 버전인

36.ERROR: Could not install packages due to an OSError: [Errno 2] No such file or directory: '/Users/lyk/opt/anaconda3/envs/env01/lib/python3.6/site-packages/numpy-1.19.5.dist-info/METADATA’

pip install 뭐시기만 하면 다음과 같은 에러가 발생했다. 잘 읽어보면 METADATA가 없다고 한다.직접 들어가보니 정말 METADATA가 없었다.numpy-1.19.5.dist-info에 METADATA가 없어 numpy-1.19.2.dist-info에

37.transformers Installation Error - Failed building wheel for tokenizers

Kobert를 다운 받는 중 다음과 같은 에러가 발생했다.link로 들어가 명령어를 copy 한 후 terminal에 입력해줬다.터미널을 재시작 하고 pip install transformers==2.5.1 후 Kobert를 재설치 했더니 error가 해결 되었다.\[

38.OSError: [Errono 48] Address already in use

Flask를 실행했더니 다음과 같이 이미 사용되고 있다고 에러가 발생하였다. 다음 명령어로 핸재 돌아가고 있는 프로세스를 확인한다.프로세스의 pid를 확인하고 프로세스를 죽인다.

39.The dependencies of some of the beans in the application context form a cycle:

rest template을 다음과 같이 사용했을 때 Error가 발생했다.service 인터페이스service 구현Error 발생 RestTemplate Config를 만들어 RestTemplate을 미리 Bean에 등록하였다.Circular Dependency

40.AttributeError: Can't get attribute 'BERTClassifier' on <module '__main__' from 'path'

Flask에서 model을 불러오려고 하니 다음과 같이 error가 발생하였다. torch.save(model, 'model.pt')로 저장하여 model 전체를 불러오려고 하니 어떤 모델인지 정의 되어 있지 않아 에러가 나는거 같았다.torch.save(mode

41.RuntimeError: CUDA error: device-side assert triggered

kobert를 실행시키던 도중 다음과 같은 에러가 발생하였다. 이런 경우 보통 차원 수가 맞지 않아 발생하는 에러라고 한다.아니나 다를까 9개로 분류를 해야하는데 3으로 되어 있어 고쳤더니 에러가 바로 해결되었다.\[PyTorch 오류 해결] RuntimeErro

42.UNABLE_TO_VERIFY_LEAF_SIGNATURE

react 설치 중 다음과 같은 명령어를 실행했을 때 에러 발생ssl로 인해 설치가 막힌듯 하다.다음 명령어를 사용하여 ssl 사용을 하지 않도록 변경한다.UNABLE_TO_VERIFY_LEAF_SIGNATURE 에러 발생시

43.parameter 전달이 안 되는 에러

https://stackoverflow.com/questions/68900467/postman-returns-null-value-after-a-successful-post-request

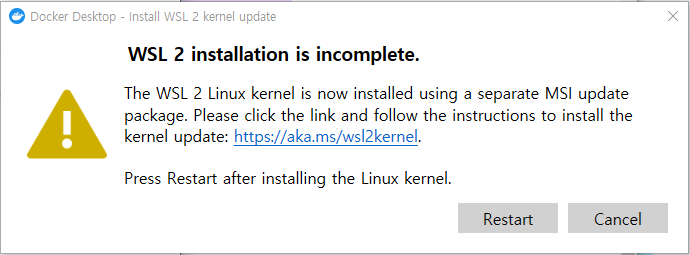

44.docker 설치 시 wsl2 에러

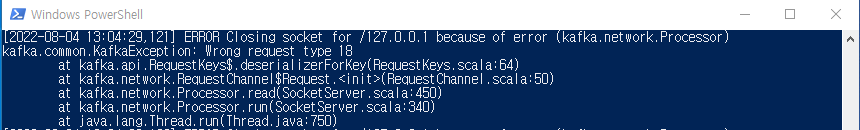

45.Error Closing socket for /127.0.0.1 because of error (kafka.network.Processor)

Spring Boot에서 kafka를 연동시켜 실행시켰더니 다음과 같은 에러가 발생하였다.기존에 kafka version을 2.11-0.8.2.1로 설치를 했는데 version 차이로 인한 에러라고 판단되어 2.12-2.1.1로 설치하였더니 해결되었다.

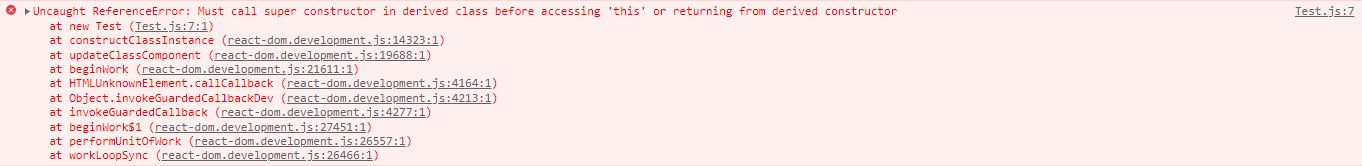

46.Must call super constructor in derived class before accessing 'this' or returning from derived constructor

props에 무엇이 들어있는지 보려고 다음과 같이 class를 짰다.다음과 같은 에러가 발생했다. ES6에서는 class정의 후 안에서 this를 사용하기 위해서는 constructor()에 super()가 있어야 사용할 수 있다고 한다.코드를 다음과 같이 고쳤더니

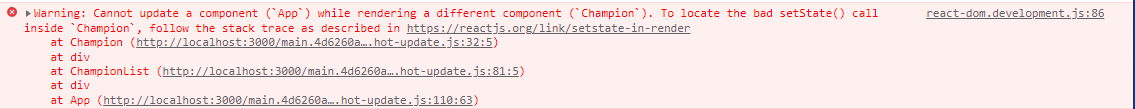

47.Cannot update a component while rendering a different component.

다음과 같이 Champion function에 onRemove를 추가했을 때 에러가 발생하였다.CreateChampion.jsApp.jsErrorChampion function에 있는 button을 다음과 같이 바꾸어주었더니 해결되었다.

48.This version of npm is compatible with lockfileVersion@1, but package-lock.json was generated for lockfileVersion@2 Things I tried

인수인계를 받는 과정에서 로컬에 npm install을 했을 때 다음과 같은 에러가 발생하였다.기존에 설치되있던 버전이 "lockfileVersion": 1을 호환하는데 package-lock.json에는 2버전으로 배포가 되어 호환이 되지 않았다.첫 번째 시도다음 명

49.org/apache/hive/service/cli/thrift/TCLIService$Iface.

hive를 datagrip에서 연결하려고 했는데 다음과 같은 에러가 났다.org/apache/hive/service/cli/thrift/TCLIService$Iface.hive-service.jar가 없어서 그랬던거고 hive-service를 추가해줬더니 다음과 같은

50.Unrecognized Hadoop major version number: 3.3.3

hadoop 3.3.3 ver에 hive 0.13.1 버전을 설치하고 schematool -initSchema -dbType mysql 명령어를 실행 시켰더니 위와 같은 에러가 발생했다.hive version을 올리거나 hadoop version을 낮추는 방법이 있는데

51.java.net.ConnectException: Connection refused: connect.

서버에 hive 0.13 ver과 hadoop 2.7.0 ver을 설치 후 외부에서 datagrip으로 연결을 시도했으나 위와 같은 에러가 발생하였다.우선 서버가 켜져있는지 확인하였다.서버가 켜져 있지 않다면 다음 명령어를 실행한다.서버에서 beeline으로 접속을 해

52.For input string: "5000L"

datagrip으로 hive 0.13 version을 연결하였더니 위와 같은 에러가 발생했다.hive-site.xml 파일에서 다음과 같이 변경하였다.value에 5000 뒤에 L을 지워준다.java.sql.SQLException: For input string: "5

53.ssh: connect to host localhost port 22: Connection refused

ssh: connect to host localhost port 22: Connection refusedssh localhost 로그인 시 위와 같은 error가 발생했다.Mac의 환경 설정에 들어가 원격 접근을 켰더니 해결되었다.

54.scp Permission denied

scp를 통해 파일을 옮기려 했더니 Permission denied가 떴다.sudo scp를 했을 때 다음과 같은 에러 발생ssh: connect to host 10.250.222.64 port 22: Network is unreachablessh localhost을

55.Error saving credentials: error storing credentials - err: exit status 1, out:

도커 실행 시 다음과 같은 Error 발생Error saving credentials: error storing credentials - err: exit status 1, out: error getting credentials - err: exit status 1,

56.Databricks

databricks tutorial 진행 중 다음 명령어를 수행했다.다음과 같은 Error가 발생했다.FileNotFoundError: Errno 2 No such file or directory: '/discover/databricks-datasets/README.m

57.This command is not allowed on an ACID table default.table_name with a non-ACID transaction manager

https://118k.tistory.com/934

58.public key retrieval is not allowed

https://deeplify.dev/database/troubleshoot/public-key-retrieval-is-not-allowed

59.Underlying cause: com.mysql.jdbc.exceptions.jdbc4.CommunicationsException : Communications link failure

useSSL=false;

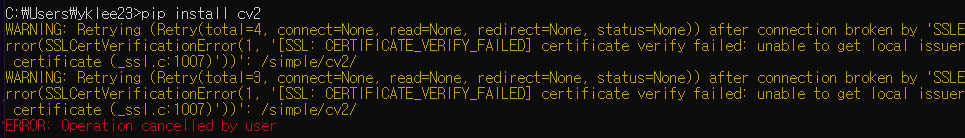

60.SSLError(SSLCertVerificationError(1, '[SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: unable to get local issuer certificate (_ssl.c:1007)'))

pip install 시 다음과 같은 에러가 발생회사 프록시/방화벽에서 해당 url을 허용하지 않는 경우 발생한다.(회사 보안 정책)다음 명렁어를 뒤에 붙여주면 해결된다.\--trusted-host pypi.org --trusted-host files.pythonhos

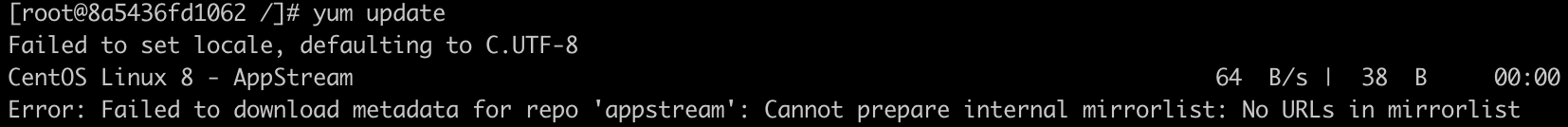

61.Failed to download metadata for repo ‘AppStream’ [CentOS]

docker에서 centos 이미지를 다운 후 yum 패키지를 업데이트 하려는데 다음과 같은 에러가 발생했다.CentOS8이 2021년 12월 31일부로 EOL(End Of Life)가 되었기 때문에 발생한 에러이다.해결하기 위해 다음과 같은 명령어를 입력했다.yum

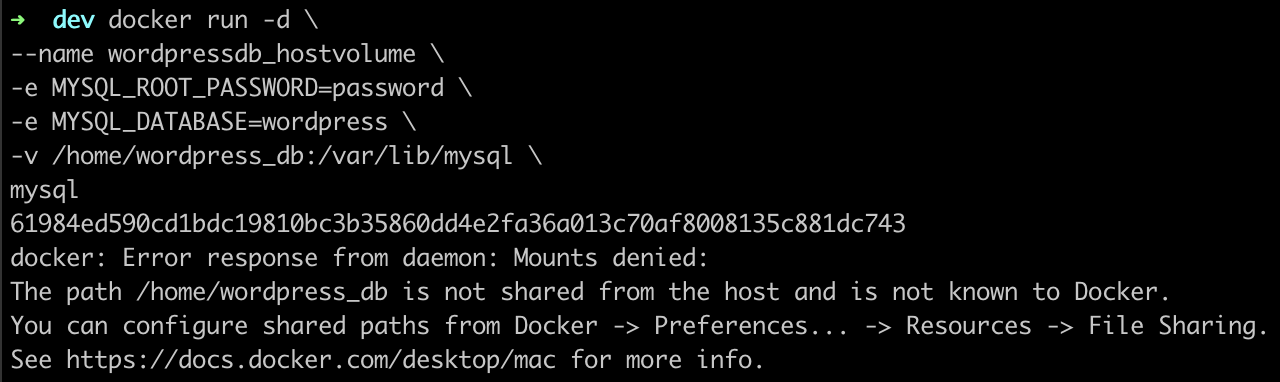

62.docker: Error response from daemon: Mounts denied:

docker mount를 하려고 다음과 같이 명령어를 쳤더니 에러가 났다.볼륨의 위치가 Mount 권한이 없어 실행에 실패한 것이다.docker desktop 설정에 들어간다.Resources에 file sharing에 들어간다./home 을 추가 후 Apply & r

63./bin/sh: node: command not found

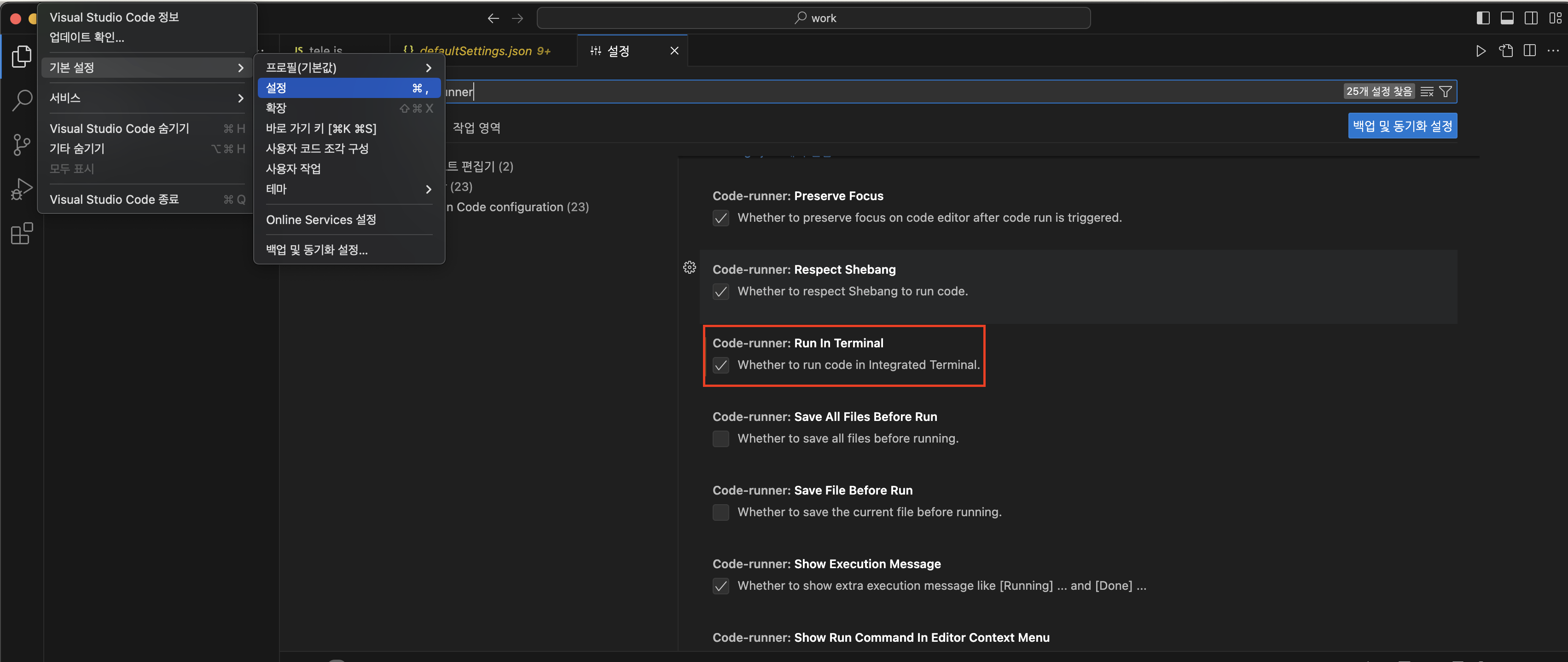

node를 설치했는데도 불구하고 vscode 터미널 환경에서 실행 시 다음과 같은 에러가 발생한다./bin/sh: node: command not found 오류vscode에서 Code Runner를 설치한다.설치 후 환경 설정에 들어가 터미널에서도 돌아갈 수 있도록

64.npm install error

Error express와 redis client를 설치하려고 했더니 다음과 같은 에러가 발생했다. https://afsx5cn032.execute-api.ap-northeast-2.amazonaws.com/stage/dt-score?contractNumber=10

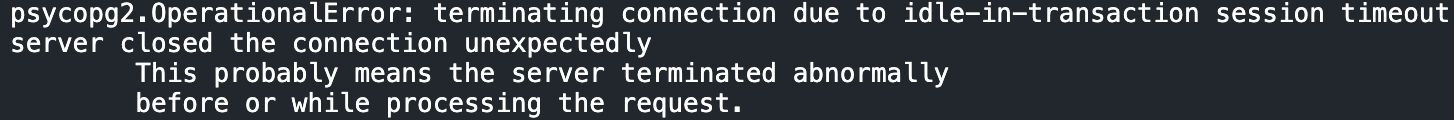

65.terminating connection due to idle-in-transaction session timeout

서버에서 postgresql을 연결하여 insert 쿼리를 날렸으나 다음과 같은 에러가 발생하며 commit()을 실패했다.DB에 idle_in_transaction_session_timeout이라는 설정이 있는데 보안으로 인해 15분으로 설정해두었다. 그러나 쿼리는

66.[SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: unable to get local issuer certificate (_ssl.c:1000)

AWS ECR에 이미지를 올리기 위해 다음 명령어를 수행하면 에러가 발생한다.SSL validation failed for https://api.ecr.ap-northeast-2.amazonaws.com/ SSL: CERTIFICATE_VERIFY_FAILED

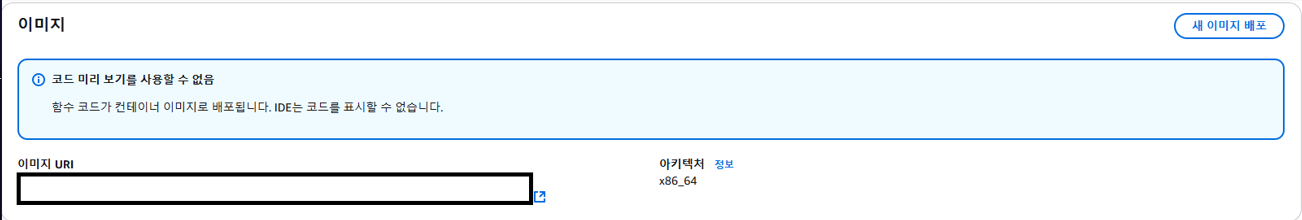

67.Error: fork/exec /lambda-entrypoint.sh: exec format error Runtime.InvalidEntrypoint

aws lambda에서 테스트 데이터를 호출하자 다음과 같은 에러가 발생하였다.Error: fork/exec /lambda-entrypoint.sh: exec format error Runtime.InvalidEntrypointECR에 이미지를 올릴 때 docker로

68.java.nio.file.AccessDeniedException

Error databricks에서 s3 bucket에 csv 형태로 저장하려니 다음과 같은 에러가 발생하였다. 실행 코드 발생 Error > java.nio.file.AccessDeniedException 원인 bucket 정책을 제대로 설정을 하지 않아 발생한

69.fault_poller_user_name_not_found

databricks를 사용하고 있으며 매일 배치가 실행되는데 shared cluster에 paramiko library 등 여러가지가 설치되지 않아 job fail이 떴다. 라이브러리 설치 에러를 보니 다음과 같은 에러였다.databricks library instal

70.error while loading AccessFlag

함수를 실행했더니 다음과 같은 error가 발생했다.scala: error while loading AccessFlag,class file /modules/java.base/java/lang/reflect/AccessFlag.class is broken, reading

71.java.lang.NoClassDefFoundError: Could not initialize class sbt.internal.parser.SbtParser$

쿠세라에서 프로젝트를 받아 intellij에 import 하였더니 다음과 같은 error가 발생했다.java.lang.NoClassDefFoundError: Could not initialize class sbt.internal.parser.SbtParser$내 jdk