Spark

1.Spark Partition

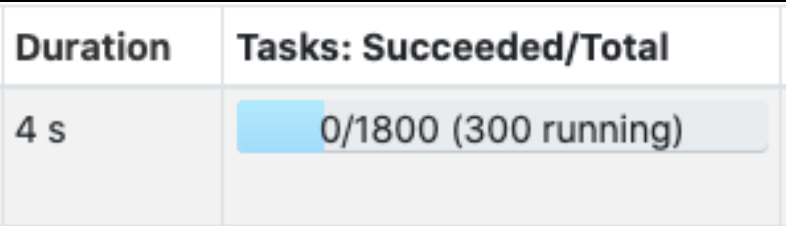

Partition은 RDDs나 Dataset를 구성하고 있는 최소 단위 객체이다. 각 Partition은 서로 다른 노드에서 분산 처리된다.Spark에서는 하나의 최소 연산을 Task라고 표현하는데, 이 하나의 Task에서 하나의 Partition이 처리된다. 또한,

2022년 6월 6일

2.Apache Spark

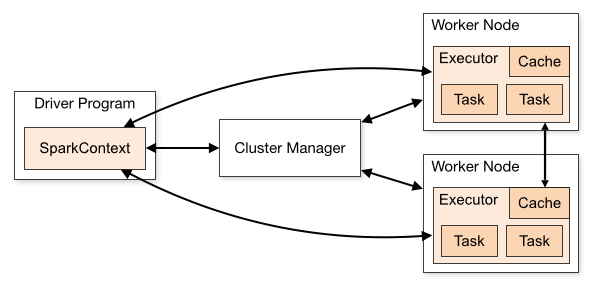

패스트 캠퍼스를 통해 Apache Spark를 이용한 빅데이터 분석 입문 과정 교육을 정리했던걸 옮겨보자 한다.Apache Spark는 대용량 데이터를 다루기 위한 빠르고 범용적인 인메모리 기반 클러스터 컴퓨팅 엔진In-Memory 기반 기술이라는 점 중요!Disk에서

2022년 9월 18일

3.Apache Spark 실습

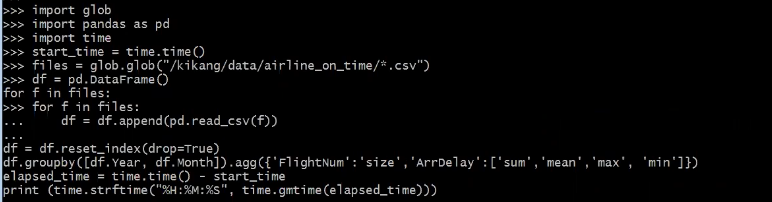

spark 개인적 실습했던 내용을 옮겨보고자 한다. 서버 스펙 : 4대 서버(Mater Node 1대 / Worker Node 3대) 테스트 데이터 : 테스트 데이터 6.5G 작업 내용 : 테스트 데이터 GroupBy/Aggregate 연산 진행실습 Apache Spa

2022년 9월 18일

4.Spark Standalone 구성

회사 내부적으로 Spark을 사용하여 프로세스를 처리할 일이 생김.기존에는 CDP,HDP,CDH 등 빅데이터 클러스터 환경에 구축되어 있는 Spark 사용하여 작업을 했지만 해당 Spark은 Hadoop 환경에 귀속이 되어있기에 해당 종속성을 최대한 제거한 채로 환

2024년 4월 1일