Split learning for health : Distributed deep learning without sharing raw patient data

intro

- raw data 뿐만 아니라 모델 architecture 도 share 하지 않는 진정한 형태의 privacy!

SplitNN configuration

- data, label, network 구조에 따라 세가지 setting 이 가능함

(a) label 이 server에 존재하고 client→server로는 forward propagation이, server→client는 back propagation 이 이뤄진다

(b) label 이 server에 있는 것이 부적절할 경우 network 의 대부분은 아직 server에 존재하면서도 backprop 은 client 단에서 시작하는 방법을 의미한다

(c) 이러한 구조는 각 client 가 multi modal 한 데이터를 들고있을 경우 데이터를 섞지 않고 훈련할 수 있는 framework 이다

Result

- 적은 FLop 안에서 빠르게 높은 accuaracy를 도달할 수 있다

→ 하지만 최종 성능에 대해서는 미지수

- client 수가 많아질수록 per client computation resource 가 감소한다 (FedAvg, Large Batch SGD에 비해)

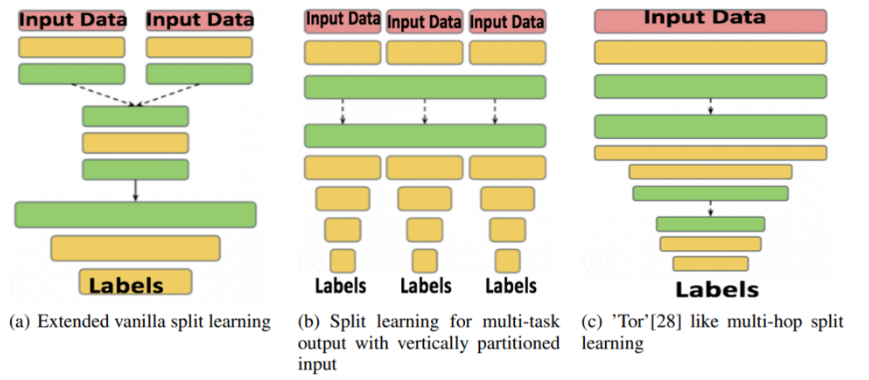

더 많은 architecture

a) 기본 구조에 server로 가기전 추가된 client 에서 process가 이뤄지는 구조

(b) multi-modal 한 data를 받아 하나의 network 로 훈련시키고 multiple server에서는 각각의 task를 풀기위해 이 network 를 이용

(c) client 가 sequential 하게 있는 구조로 cut layer까지 훈련시킨 후 다른 client가 이를 받아 마저 훈련시키는 방식을 택한다

논문을 읽고 든 생각

splitNN의 효과 증진을 위한 vision task의 RL 방식을 통한 해결과정에서 A3C는 많은 client 에서 수렴성이 보장되지 않아 보이므로 피라미드 구조로 각 client들을 묶어 작은 A3C 들이 여러개 있는 것과 같은 구조를 생각해봄

implementation

https://github.com/bt-s/Split-Learning-and-Federated-Learning

Split learning for health enables distributed deep learning while preserving patient privacy by avoiding the need to share raw data. This approach allows multiple institutions to collaboratively train models on sensitive health information without direct data exchange. For instance, researchers can integrate innovative solutions like https://medwholesalesupplies.com/product/juvederm-ultra-3-2x1ml-24mg-ml-and-3mg-ml-2-1ml-prefilled-syringes/ to enhance healthcare outcomes.