머신러닝

오늘 머신러닝 관련 강의가 추가로 열려서 수강한 내용을 정리해보고자 한다.

머신러닝 기초

머신러닝 관련 용어

AI: 인간의 지능을 요구하는 업무를 수행하기 위한 시스템

Machine Learning: 관측된 패턴을 기반으로 의사 결정을 하기 위한 알고리즘

- 데이터 수집과 처리 기술의 발전으로 대용량 데이터의 패턴을 인식하고 이를 바탕으로 예측, 분류하는 방법론

Deep Learning: 인공신경망을 이용한 머신러닝

Data science: AI를 포괄하여 통계학과 컴퓨터공학을 바탕으로 발전한 융합학문

- 과학 → 근거/데이터

Data Analysis: 데이터 집계, 통계 분석, 머신러닝을 포함한 행위

“왜 머신러닝이 발전 했을까?“

- 인간은 데이터를 기반으로 한 의사결정을 내리고 싶기 때문.

- 실수를 줄이기 위해.

- 데이터 처리 기술의 발전

- 저장매체 가격의 하락하여 데이터 수집이 용이해짐.

- 수집 → 처리 → ML/DL → 인사이트

- 저장매체 가격의 하락하여 데이터 수집이 용이해짐.

통계학 vs 머신러닝

- 통계학: 소수에서 다수를 추정

- 제한된 데이터

- 머신러닝: 과거에서 미래를 예측

- 대량의 데이터

머신러닝의 종류

Supervised Leaning(지도 학습)- 문제와 정답을 모두 알려주고 학습시킴.

Unsupervised Learning(비지도 학습)- 정답을 가르쳐주지 않고 학습시킴.

Reinforcement Learning(강화 학습)- 보상을 통해 상은 최대화, 벌은 최소화하는 방향으로 행위를 강화하는 학습.

Jupyter Notebook 단축키

- 단축키

- CTL + Enter: 현재 셀 실행

- Shift + Enter: 현재 셀 실행 후 다음 셀로 커서 옮기기

- 셀 선택모드

A: 현재 셀에서 위쪽에 새로운 셀을 추가한다.B: 현재 셀에서 아래쪽에 새로운 셀을 추가한다.DD: 현재 셀을 삭제한다.M: 현재 셀을 코드에서 마크다운으로 변경한다.Y: 현재 셀을 마크다운에서 코드로 변경한다.C,V,X: 복사, 붙여넣기, 잘라내기

회귀분석 - 선형회귀

선형회귀 용어 정리

공통

- Y는 종속 변수, 결과 변수

- X는 독립 변수, 원인 변수, 설명 변수

통계학에서 사용하는 선형회귀 식

- : 편향(Bias)

- : 회귀 계수

- : 오차(에러), 모델이 설명하지 못하는 Y의 변동성

머신러닝/딥러닝에서 사용하는 선형회귀 식

- : 가중치

- : 편향(Bias)

몸무게와 키 샘플 데이터를 통해 선형회귀 식을 만들어보면

- 샘플

weights = [87,81,82,92,90,61,86,66,69,69] heights = [187,174,179,192,188,160,179,168,168,174]- 회귀식: y = 0.86x + 109.37

- 1kg 증가할때마다 키가 0.86 cm 증가한다는 것으로 해석

- 회귀식: y = 0.86x + 109.37

회귀분석의 평가지표

MSE (Mean Squared Error)

- 에러 정의방법

- 방법1)

에러 = 실제 데이터 - 예측 데이터로 정의하기 - 방법2) 에러를 제곱하여 모두 양수로 만들기, 다 합치기

- 방법3) 데이터만큼 나누기

- 방법1)

- 에러 정의 방법 수식화

- 방법1)

- 방법2)

- 방법3)

기타 평가 지표

RMSE(Root Mean Squared Error): MSE에 Root를 씌워 제곱 된 단위를 다시 맞추기

MAE(Mean Absolute Error): 절대 값을 이용하여 오차 계산하기

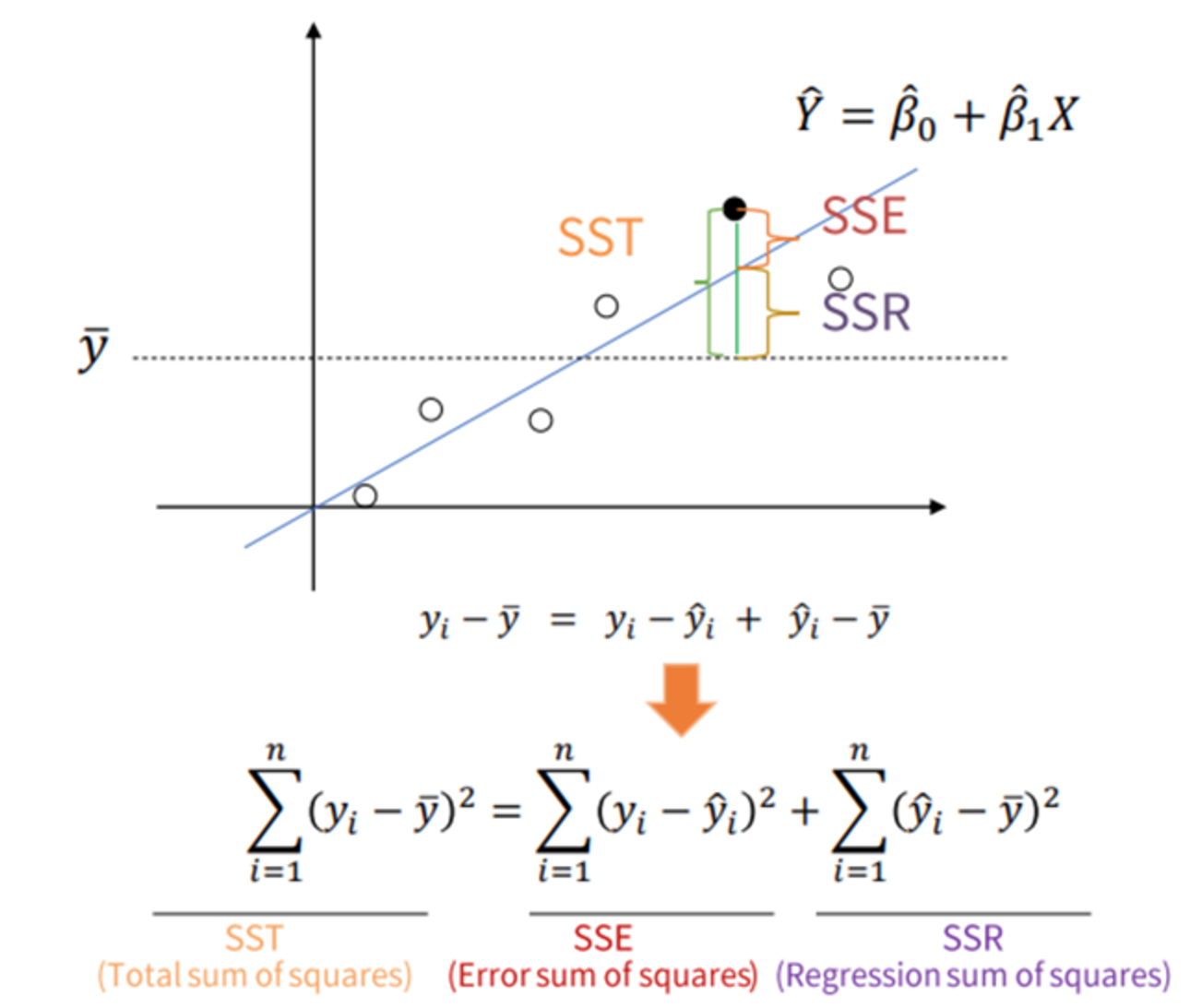

선형회귀만의 평가 지표 - R Square

R Square: 전체 모형에서 회귀선으로 설명할 수 있는 정도를 뜻함

- 어떤 값을 “예측”한다는건 어림짐작으로 평균값보단 예측을 잘해야한다는 것을 의미

기초 용어

- : 특정 데이터의 실제 값

- : 평균 값

- : 예측, 추정한 값

R Square의 정의

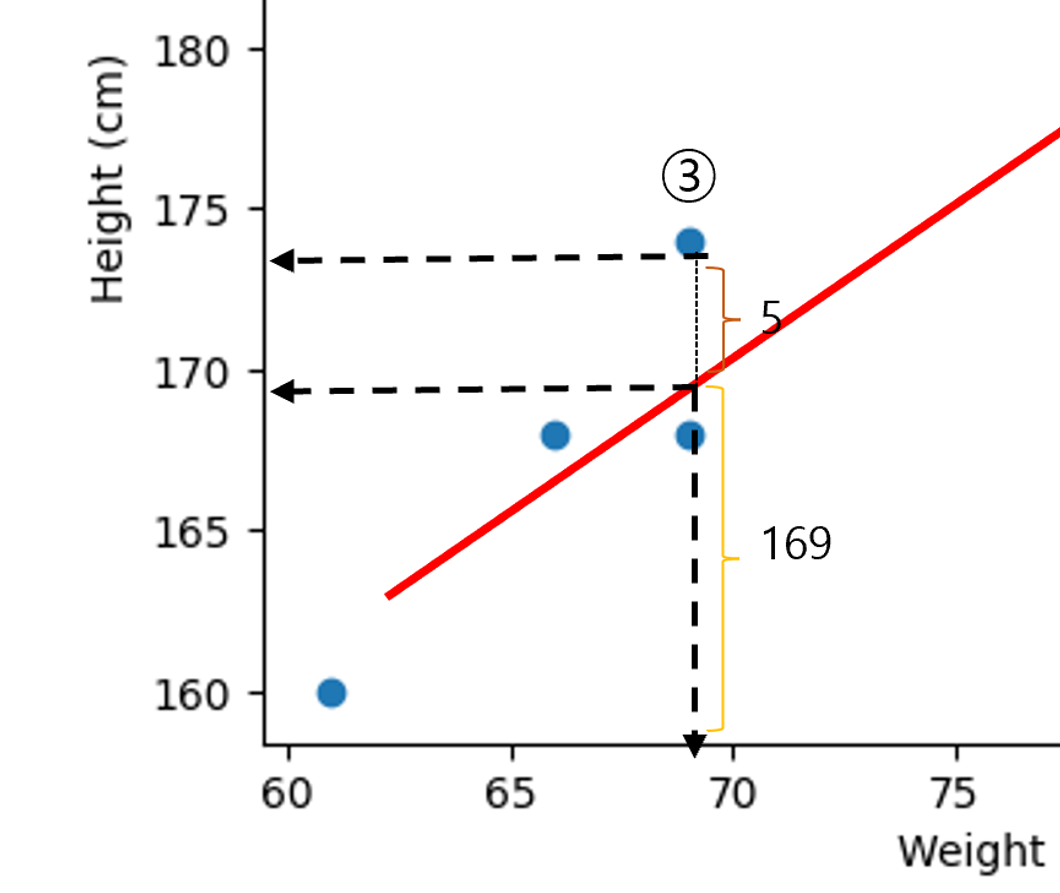

SSR(Sum of Squares Regression)- 설명된 제곱합

- 회귀모델이 설명할 수 있는 데이터의 변동량

SST(Total Sum of Squares)- 전체 제곱합 또는 총 변동

- 데이터의 전체 변동량을 나타내며, 실제 값들이 평균값으로부터 얼마나 떨어져 있는지를 측정.

SSE(Sum of Squares Error)- 잔차 제곱합

- 모델이 설명하지 못한 변동량을 나타냅니다. 즉, 실제 값과 예측 값 사이의 차이로 인한 오차

- 3번의 데이터 값은

- 해당 값에 대한 설명력 = 94%

- 단, 모든 데이터에 대해서 위 계산을 수행

내일 이어서 선형회귀 적용부터 심화까지 수강할 예정!