얼마 전 스터디 팀원들과 함께 공부했던 DenseNet에 대해서 정리를 해볼 시간을 가져볼까 합니다.

논문을 읽는 동안에 드는 생각을 정리하자면 다음과 같습니다.

ResNet을 왜 이렇게까지 구박을 하는 거지?

그래도 여러 방면에서 진보된 모델이어서 그러려니 했습니다.

DenseNet은 다음과 같은 기여를 했습니다.

- 'vanishing-gradient' 문제 줄이기.

- Propagation(순전파)을 좀 더 끈끈하게.

- 파라미터 수 줄이기.

DenseNet도 결국 다른 연구와 비슷하게, 여러 연구를 참고하여 진행했습니다.

ResNet : 훈련 중에 계층 drop

FractalNet : 계층들 병렬적으로 동작, 각 블록들은 짧은 경로 지나나, depth가 너무 깊음.

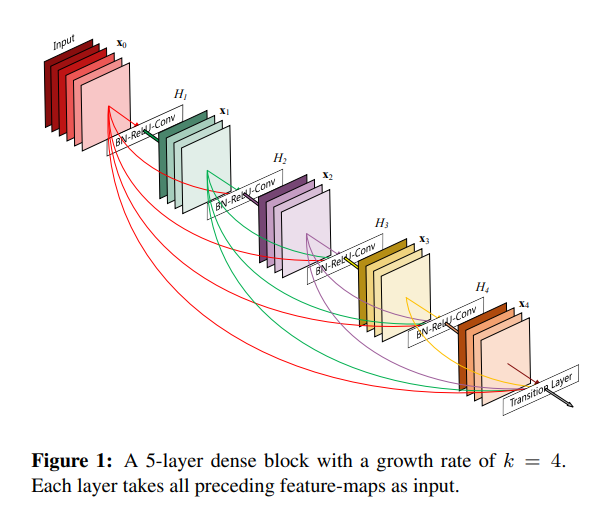

DenseNet은 계층을 거치지 전에, sum해서 가는 느낌이 아닌, 그냥 연결만 해놓고,

L번째 계층은 l개의 input이 있고, 각 계층마다 (l(l+1)) / 2 개의 연결을 갖게 됩니다.

각각의 계층의 가중치 값을 갖고 있어서 파라미터 수가 커질 수도 있는데, 굉장히 좁은(작고, 변하지 않는 특성 맵) 계층을 가져서,

결국엔 마지막 분류기에서는 모든 특성맵을 고려합니다.

그래서 오버피팅을 막고, 정규화 효과, 파라미터 수를 더 smaller하게 할 수 있었습니다.

위의 그림과 같이 DenseNet은 특징을 재사용 하고, 각 계층에서 피쳐맵 연결하는 구조 입니다.

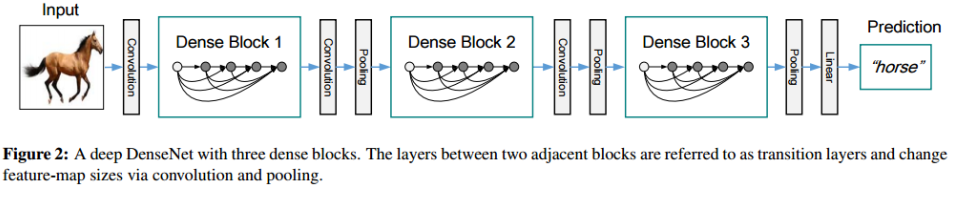

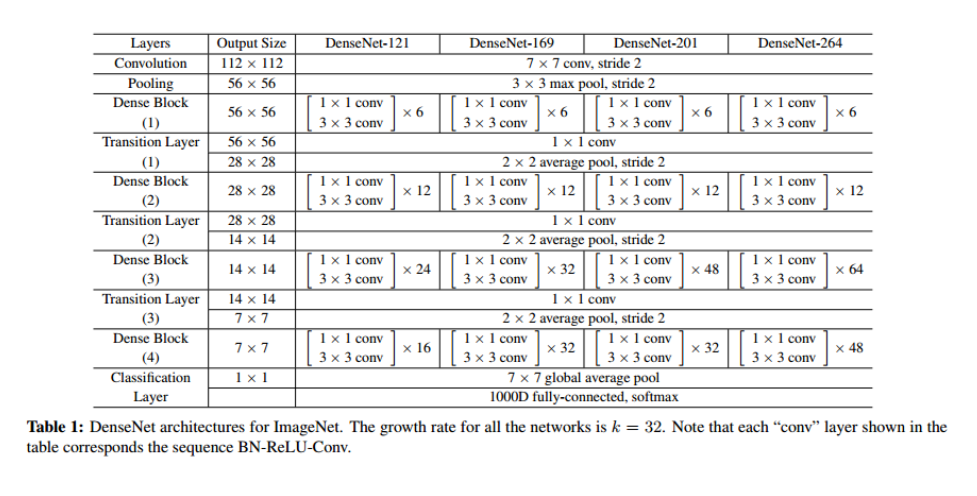

각 계층을 이렇게 구성했습니다.

중간중간 pooling 계층, Bottleneck 계층도 볼 수 있습니다.

어떻게... 이렇게 이런 구조로 일반화 했는지 진짜 볼 때마다 놀랍습니다 ㅎㅎ (진짜 노가다 작업... 아..)

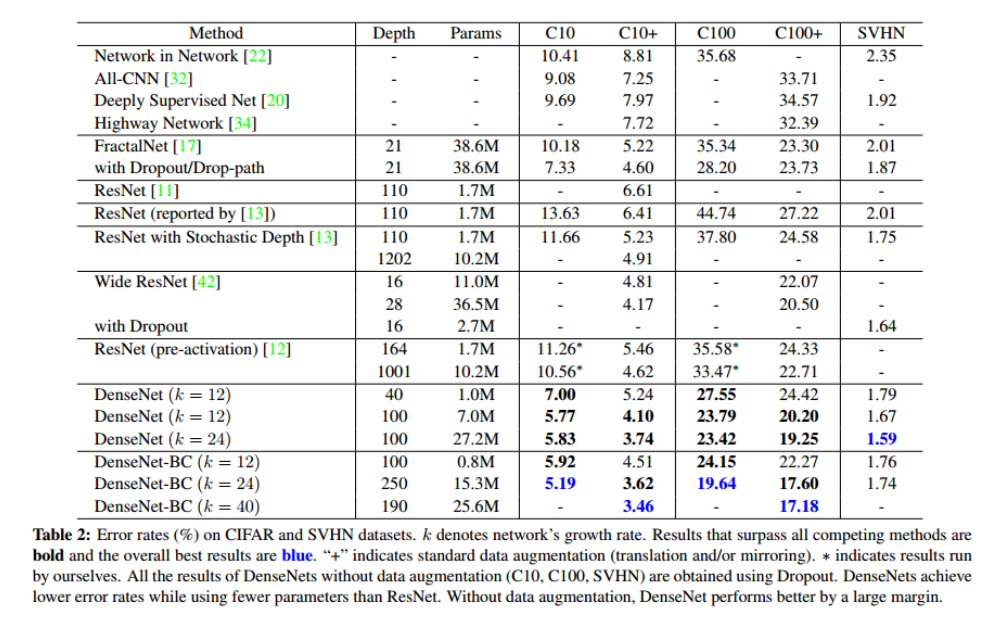

위 표는 어떤 데이터셋을 적용했는지, 전의 방식보다 오류율이 더 좋아졌다는 것을 보여줍니다.

보면 'CIFAR10', 'CIFAR100', 'SVHN', 'ImageNet'데이터 셋을 사용했고, '+'가 데이터 증강을 뜻합니다.

연구도 데이터셋을 직접 수집하지는 않나 봅니다.

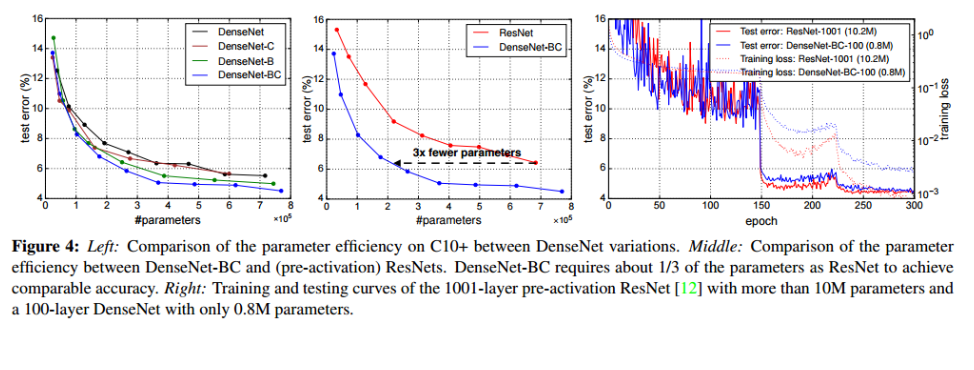

위 그래프가 error값이 확연히 내려갔다는 것을 보여줍니다.

한줄 요약

원래 논문이란게, 이렇게 전에 나온 유명 연구들 갖고 와서 바꿔가면서 하는거구나라는 것을 깨달았다.

근데 진짜 획기적이었다.