machinelearning

1.back propagation

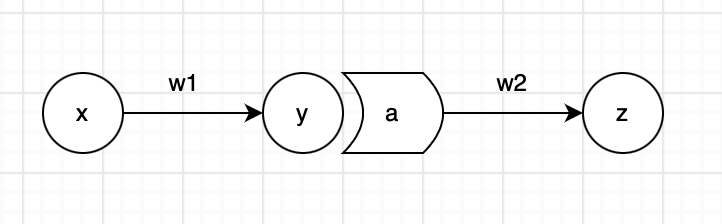

오차 역전파 법은 딥러닝에서 학습을 수행하는데 있어 반 필수적인 방법이다.backpropagation은 가중치 파라미터에 대한 loss function의 기울기를 손쉽게 구할 수 있도록 해준다.여기까지가 일반적으로 알고있는 사항이다.그렇지만 여기서 수식적으로 back

2023년 2월 12일

2.logit과 sigmoid와 softmax

logit과 sigmoid 함수는 서로 역함수의 관계이다.logit은 logist + probit의 합성어로, 오즈에 자연로그를 취한 것이다.여기서 오즈(odds)란, 클래스 $C_1, C_2$가 있을 때 $C_2$로 분류될 확률에 대한 $C_1$으로 분류될 확률을 의

2023년 2월 13일