통계론

-

통계적 모델링

적절한 가정 위레서 확률분포를 추정하는 것이 목표

유한한 개수의 데이터만 관찰해서 모집단의 분포를 정확하게 알아내는 것은 불가능하므로, 근사적으로 확률분포를 추정해야 한다 -

모수란?

모집단의 특성을 나타낸 것으로 모집단을 전수조사해야만 알 수 있고 평균, 분산등이 속한다. -

모수적 방법론

데이터가 특정 확률분포를 따른다고 가정 후 그 분포를 결정하는 것이다. -

비모수 방법론

특정 확률분포를 가정하지 않고 데이터에 따라 모델의 구조 및 모수의 개수가 유연하게 바뀌면서 분포를 정함

확률분포의 종류

- 베르누이 분포 - 데이터가 2개의 값만 가지는 경우

- 카테고리 분포 - 데이터가 n개의 이산적인 값을 가지는 경우

- 베타분포 - 데이터가 [0,1]사이에서 값을 가지는 경우

- 감마분포, 로그정규분포 - 데이터가 0이상의 값을 가지는 경우

- 정규분포, 라플라스분포 - 데이터가 실수 전체에서 값을 가지는 경우

이와는 별도로 데이터의 특성(생성원리)를 파악하여 확률분포를 고려를 먼저 해야 한다.

또한 각 분포마다 검정하는 방법이 있어 모수 추정 후 검정을 반드시 해야한다.

표본평균, 표본분산

-

표본평균 : 모집단에서 임의추출한 데이터들의 평균이다.

.gif)

-

표본분산 : 모집단에서 임의추출한 데이터들의 분산이다.

-

표집분포란?

표본평균, 표준분산의 확률분포를 말한다.(데이터가 아닌 표본집단들에 대한 데이터의 분포이다.) -

표본평균의 표집분포는 N이 커질수록 정규분포를 따른다.N(표본평균, 표본분산/N) -> 중심극한 정리에 의해

(중심극한 정리란 동일한 확률분포를 가진 독립 확률변수 n개의 평균의 분포는 n이 적당히 크다면 정규분포에 가까워진다는 정리이다.)

.gif)

최대가능도 추정법

-

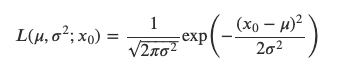

가능도 함수란?

확률밀도함수에서 모수를 변수로 보는 경우 해당 함수를 가능도 함수(likelihood function)라 하고 기호는 L을 쓴다. -

최대가능도란?

이론적으로 가장 가능성이 높은 모수를 추정하는 방법이다.

.gif)

가능도 함수는 위와 같이 표현이 되며 확률밀도함수로 보면 p로 표현, 가능도 함수로 보면 L로 표현한다. -

분포에 따라 모수는 달라질 수 있다.

1, 베르누이 확률분포의 경우

.gif)

2, 이항분포인 경우

3, 정규분포인 경우

-

최대가능도 추적법

-

확률에서는 모수를 이용하여 X에 대한 확률을 구하는 것이였다면 최대가능도 추적법은 모수의 한 변수를 모를 때 임의의 표본 X에 대하여 그 확률이 최대가 되는 모수를 찾는 방법이다.

이를 수식으로 표현해 보면 다음과 같다.

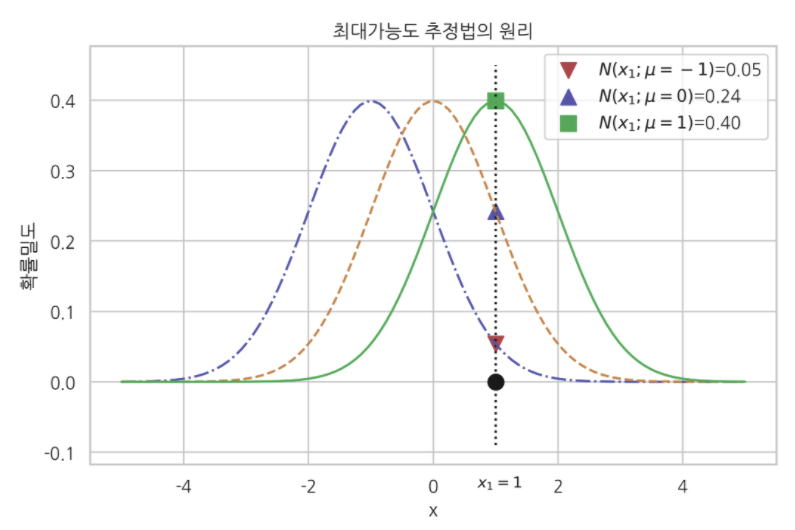

아래의 그림과 같이 평균에 따라 X=1에 대한 확률이 변하게 되는데 이때, X=1에서 최대가 되는 평균을 구하는 것이 최대가능도 추적법이다.

-

복수의 표본 데이터가 있는 경우 표본데이터 x1,x2 ~ xn은 같은 확률분포에서 나온 독립적인 값이므로 수식은 다음과 같이 표현되어 진다.

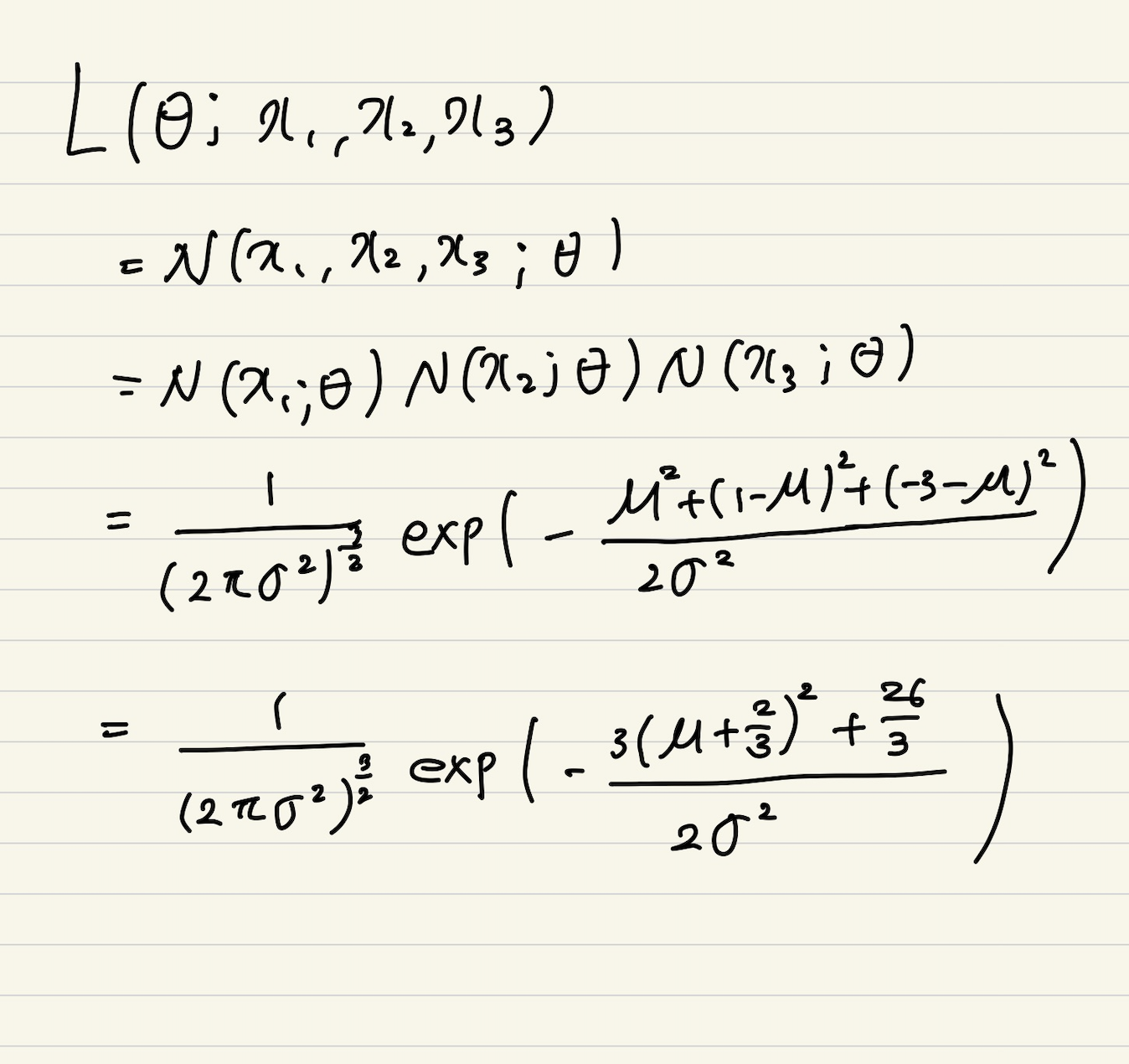

이를 정규분포를 예를 들어 수식을 적어보면 다음과 같다.

1, 정규분포의 확률밀도함수

2, 정규분포의 가능도 함수의 유도 과정(표본이 x1,x2,x3일때)

이때, 평균이 -2/3이면 최대값이 된다. -

로그가능도의 사용

가능도 함수에 로그를 붙혀서 사용

사용이유

1, 데이터의 숫자가 수억 단위가 되면 가능도 계산이 불가

2, 가능도의 곱셈을 로그가능도의 덧셈으로 바꿀 수 있음

3, 경사하강법으로 가능도를 최적화할 때 미분 연산을 사용하게 되는데 연산량을 O(n^2)에서 O(n)으로 줄여줌

4, 대게의 손실함수 경우 경사하강법을 사용하므로 음의 로그가능도를 최적화 -

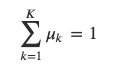

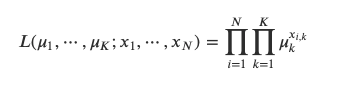

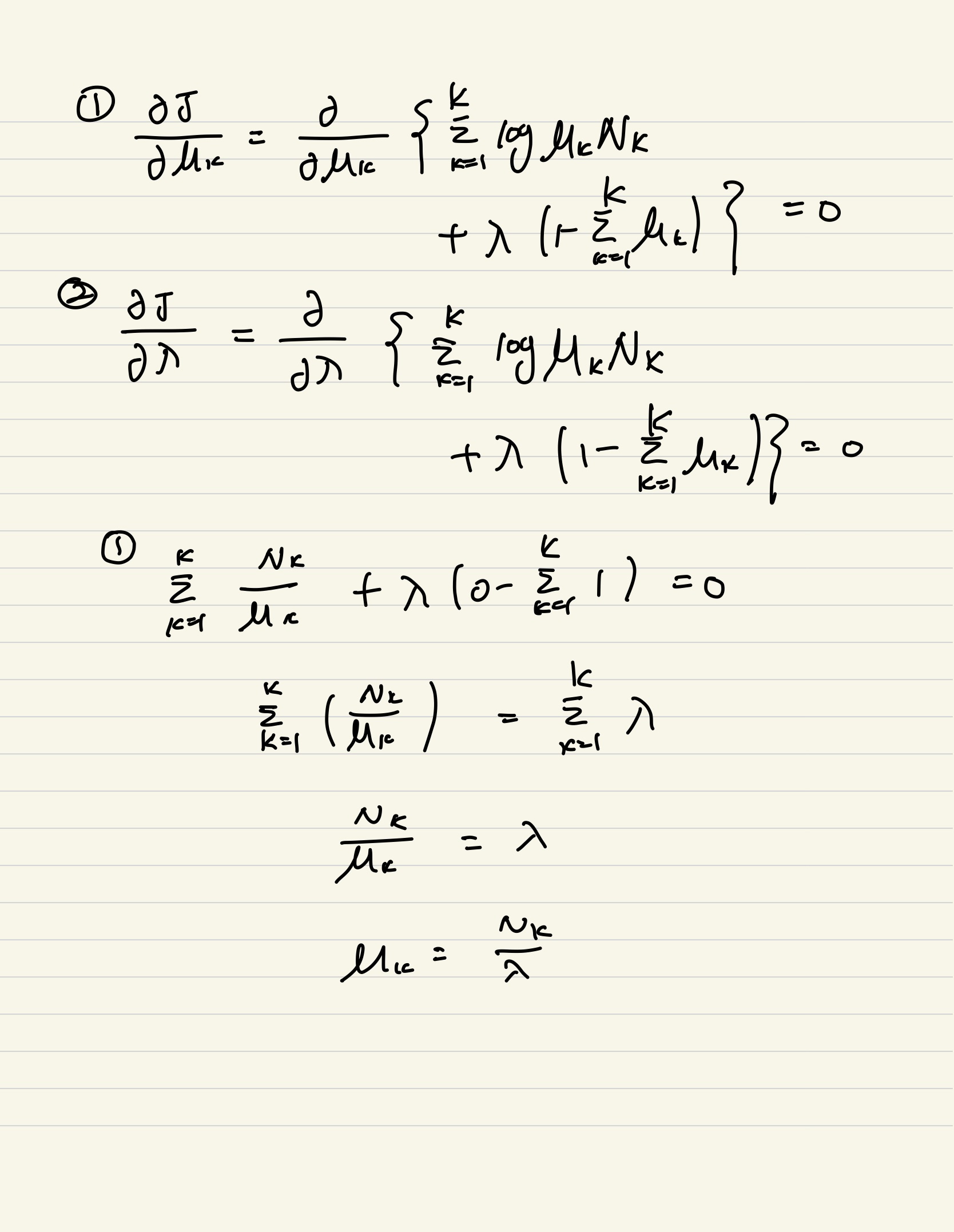

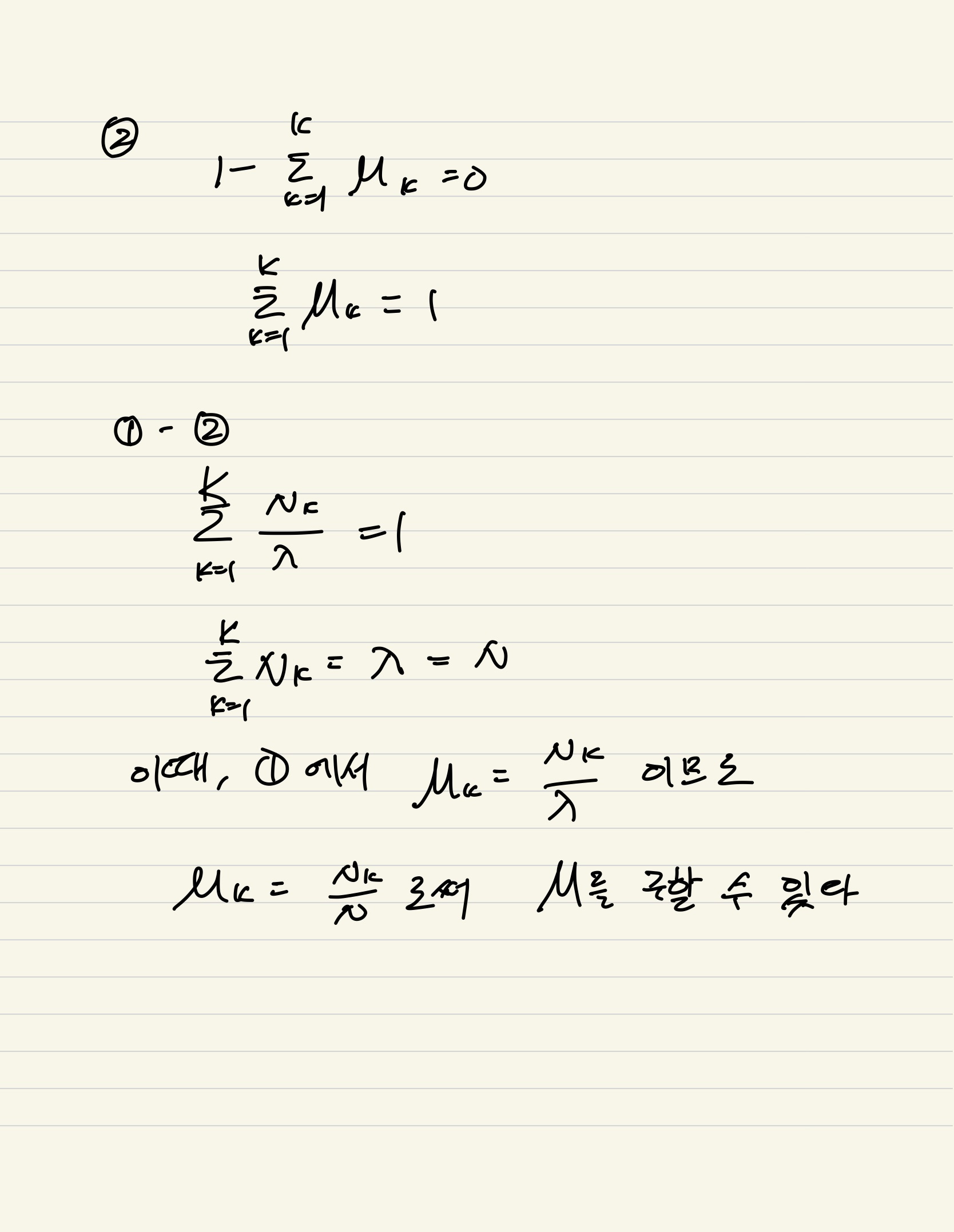

로그 가능도를 이용한 카테고리 분포의 최대가능도 모수추정은 다음과 같다.

이때, μ는 확률들이므로 전체를 더하면 1이 된다. 또한 각각의 x는 k개의 원소를 가지고 해당하는 분류의 one-hot인코딩 방식으로 되어 있다. 확률변수 x는 모두 독립사건이므로 확률밀도함수는 각각의 확률질량함수곱이다.

이를 이용하여 모수 추정식을 계산해보면 다음과 같다.

출처&참고

https://datascienceschool.net/02%20mathematics/09.02%20%EC%B5%9C%EB%8C%80%EA%B0%80%EB%8A%A5%EB%8F%84%20%EC%B6%94%EC%A0%95%EB%B2%95.html#id14

https://namyoungkim.github.io/statistics/2017/09/17/probability/

-

즉 핵심 포인트는 가능도 함수의 식과 모수 및 람다로 미분한 값이 0임을 사용하여 식을 도출 할 수 있고 정규분포도 위와 같은 논리로써 구할 수 있다.

-> 증명과정(참고): https://datascienceschool.net/02%20mathematics/09.02%20%EC%B5%9C%EB%8C%80%EA%B0%80%EB%8A%A5%EB%8F%84%20%EC%B6%94%EC%A0%95%EB%B2%95.html#id14

- 최대가능도 추적법을 이용하여 기게학습 모델을 학습 할 수 있다.

딥러닝 모델 가중치

카테고리분포의 모수

정답 레이블

이때, softmax 벡터의 로그가능도를 다음과 같이 표현해 볼 수 있다.

이때,MLP는 다층 퍼셉트론을 거쳐 나온 결과값

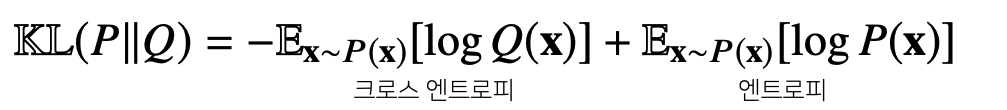

데이터공간에 두 개의 확률분포 P(X),Q(X)가 있을 경우 두 확률분포 사이의 거리를 계산 시 이용하는 함수는 다음과 같다.

- 총변동 거리(TotalVariationDistance,TV)

- 쿨백-라이블러발산(Kullback-LeiblerDivergence,KL)

- 바슈타인거리(WassersteinDistance)

이 중 쿨백-라이브러리 발산 개념을 이용하여 다음과 같이 분해가 가능하다.

이때, 정답레이블을 P, 모델 예측을 Q라 두면 최대가능도 추정법은 쿨백-라이블러 발산을 최소화 하는 움직임으로 간다.출처

Naver BoostCamp AI Tech - edwith 강의

Reference

Naver BoostCamp AI Tech - edwith 강의

https://electronicsdo.tistory.com/entry/%EC%9D%B4%EA%B1%B4%EB%AC%B4%EC%97%87%EC%9D%B8%EA%B0%80-%EB%AA%A8%EC%88%98%EB%9E%80

https://bskyvision.com/454

https://datascienceschool.net/02%20mathematics/09.02%20%EC%B5%9C%EB%8C%80%EA%B0%80%EB%8A%A5%EB%8F%84%20%EC%B6%94%EC%A0%95%EB%B2%95.html#id14

https://ko.wikipedia.org/wiki/%EC%A4%91%EC%8B%AC_%EA%B7%B9%ED%95%9C_%EC%A0%95%EB%A6%AC

https://namyoungkim.github.io/statistics/2017/09/17/probability/