인프런 권철민님 강의 정리

Sectio3: 평가(Evaluation)

분류 성능 평가지표

- 정확도 (Accuracy)

- 오차행렬 (Confusion Matrix)

- 정밀도 (Precision)

- 재현율 (Recall)

- F1 스코어

- ROC AUC

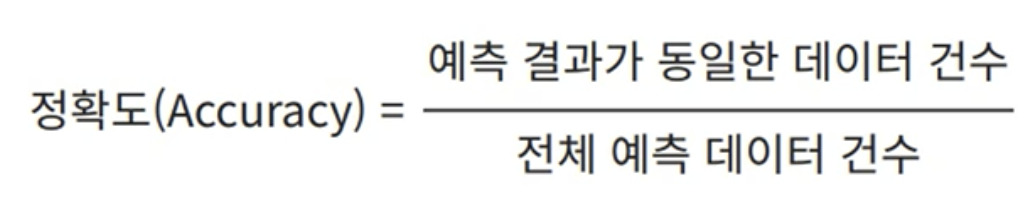

정확도

- 직관적으로 모델 예측 성능을 나타내는 평가 지표

- 불균형한 레이블 값 분포에서는 잘 사용되지 않는다.

오차행렬

- 이진 분류의 예측 오류가 얼마인지, 어떤 유형의 예측 오류가 발생하고 있는지 함께 나타내는 지표

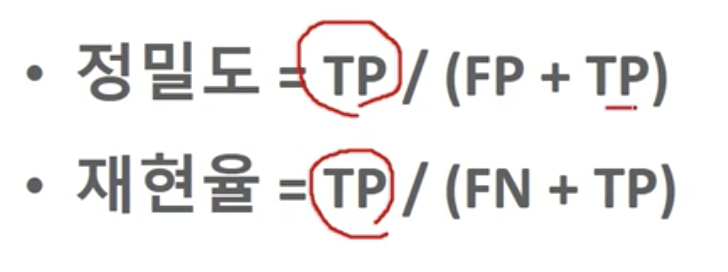

Precision, Recall

- 정밀도: 예측을 Positive로 한 대상 중에 TP 비율

- 재현율: 실제가 Positive인 대상 중에 TP 비율

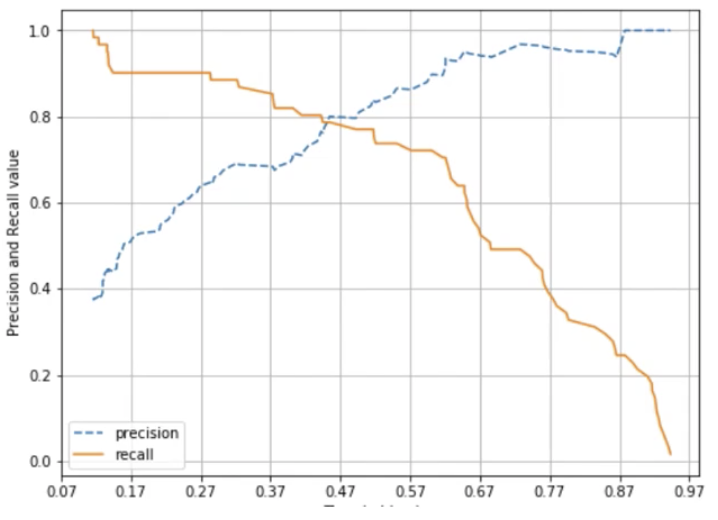

Precision, Recall Trade-Off

- 재현율이 상대적으로 더 중요한 경우:

- 실제 Positive 데이터를 Negative로 판단하면 큰 영향이 발생하는 case

- ex. 암 진단, 금융사기 판별

- 정밀도가 상대적으로 더 중요한 경우:

- 실제 Negative 데이터를 Positive 판단하면 큰 영향이 발생하는 case

- ex. 스팸 메일

- 정밀도, 재현율은 상호 보완적인 평가 지표이기 때문에, 임계값(Threshold)을 조정하여 더 중요한 수치를 조정할 수 있음

- 분류 결정 입계값이 낮아질수록 Positive로 예측할 확률이 높아짐

--> 재현율 증가 (FN은 낮아지고, FP는 올라가기 때문)

- 분류 결정 입계값이 낮아질수록 Positive로 예측할 확률이 높아짐

Precision, Recall 맹점

- 정밀도를 100%로 만드는 법: 확실한 기준이 되는 경우만 Positive로 예측, 나머지는 모두 Negative로 예측 (FP=0)

- 재현율을 100%로 만드는 법: 모든 경우를 Positive로 예측, 나머지는 모두 Negative로 예측 (FN=0)

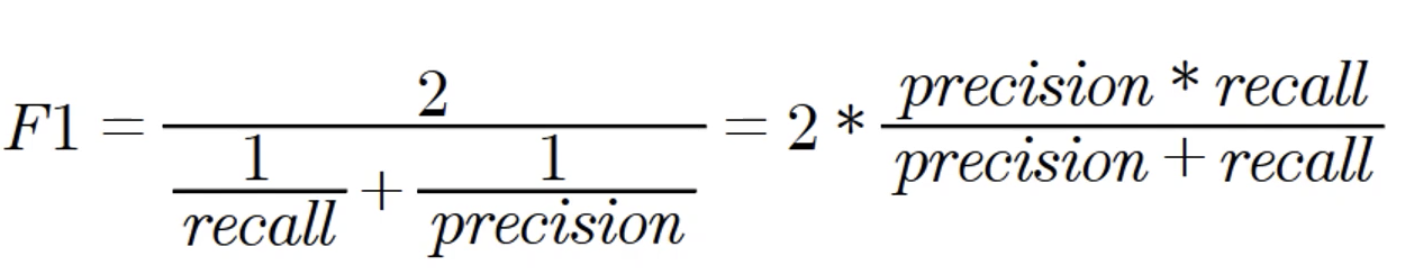

F1 Score

- 정밀도와 재현율을 결합한 지표

- 두 지표가 한쪽으로 치우치지 않을 때 상대적으로 높은 값을 가짐

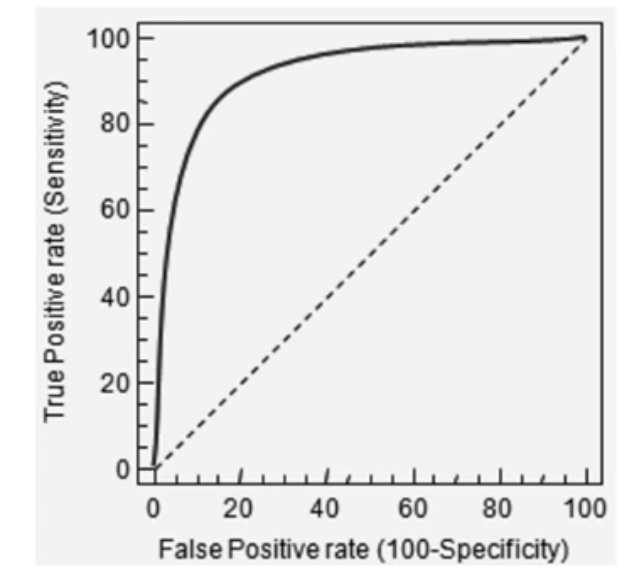

ROC곡선, AUC

- ROC (Receiver Operation Characteristic Curve)

- 머신러닝의 이진 분류 모델의 예측 성능을 판단하는 지표

- FPR이 변할 때, TPR이 어떻게 변하는지를 나타내는 곡선

- AUC(Area Under Curve): ROC 곡선 밑의 면적

- 일반적으로 1에 가까울수록 좋은 수치

- TPR: True Positive Rate로 재현율을 의미

- FPR: False Positive Rate로 실제 Negative를 잘못 예측한 비율

- FPR = FP / (FP + TN)