Recursive deep models for semantic compositionality over a sentiment treebank(2013) 논문 읽기②

5. Experiments

실험에는 2가지 유형이 있다.

첫 번째는 Testset에 대한 대규모 정량적 평가이며, 두 번째는 정서적으로 중요한 두 가지 언어적 형상에 초점을 둔다.

모델의 최적의 성능은 Word Vector Dimension은 25 ~ 35 / Batch Size는 20 ~ 30 사이에서 나타났으며 Vector 및 Batch 크기가 작을 때 성능이 감소하였다.

이는 곧 RNTN이 더 많은 매개변수를 가지고 있다고 해서 RNN을 뛰어넘는 성능을 가지는 것은 아니라는 것은 반증한다.

초기 비선형성을 사용하지 않은 경우(실험에서는 tanh사용)에는 정확도가 5%이상 감소하는 등 재귀 모델이 잘 작동하지 않았다.

데이터셋은 Train(8544), Dev(1101), Test(2210)으로 나눠서 실험했다.

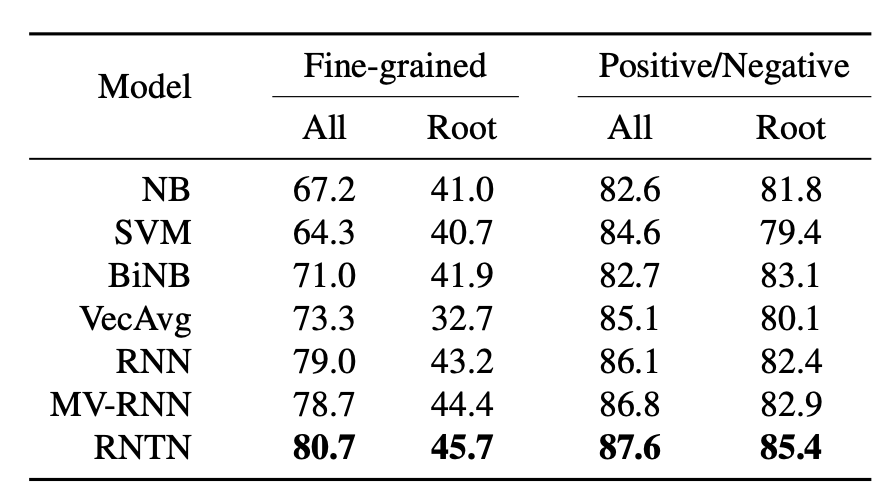

5-1. Fine-grained Sentiment For All Phrases

주요 실험의 평가 Matirx은 세분화된 감정 분류에서의 정확도를 측정하는 것이다.

재귀 모델은 부정과 구성이 중요한 짧은 구문에서 매우 잘 작동하는 반면, bag of feature baselines(=NB, SVM, BiNB, VecAvg)는 더 긴 문장에서만 잘 작동한다.

5-2. Full Sentence Binary Sentiment

기존의 전체 문장 labels과 긍부정의 이진 분류만 사용한 rotten tomatoes dataset의 이전 작업은 80% 수준이었다.

하지만 새로운 Setiment Treebank와 RNTN의 결합은 짧은 문구에 대해 85.4%의 SOTA 성능을 보여준다.

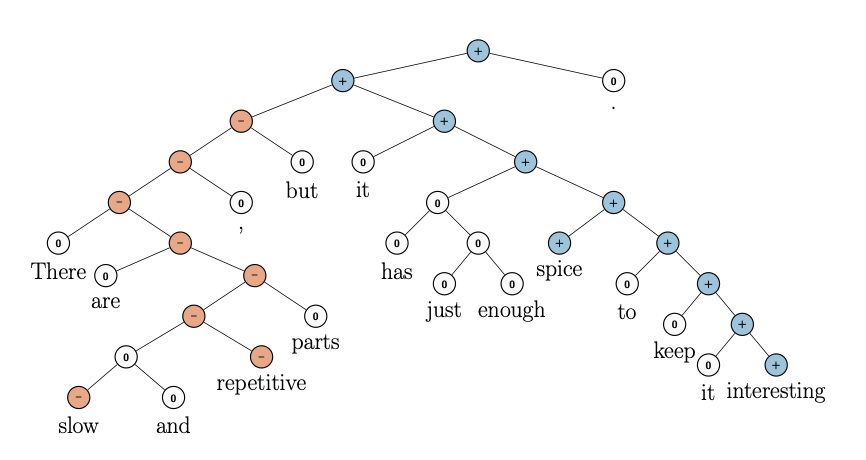

5-3. Model Analysis: Contrastive Conjunction

이 섹션에서는 'X but Y'의 구조를 띄는 문장만 포함하여 테스트를 진행하였다.

여기서 X와 Y는 서로 다른 감정의 구문(중립 포함)이다.

131건의 경우, RNTN은 MV-RNN(37), RNN(36) 및 biNB(27)에 비해 41%의 정확도를 얻는다.

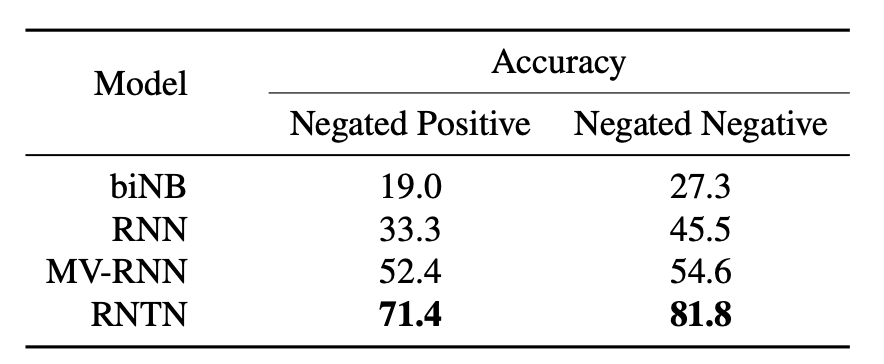

5-4. Model Analysis: High Level Negation

이번에는 2가지 유형의 부정을 테스트 한다.

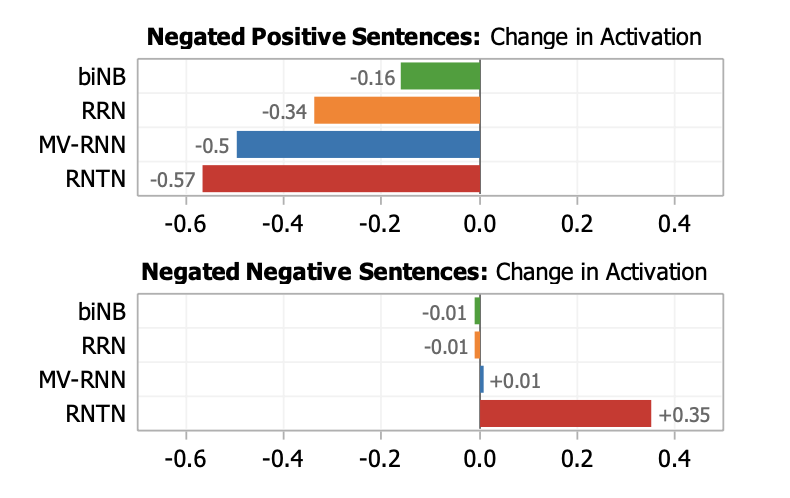

첫 번째: Negating Positive Sentences

긍정과 부정을 포함하는 이 문구에서 '부정'은 문장의 전반적인 정서를 '긍정'에서 '부정'으로 변화시킨다.

따라서 우리는 긍정에서 부정으로 감정의 역전 관점에서 정확도를 계산하였다.

RNTN(표의 왼쪽)이 가장 높은 반전 정확도를 가지고 있으며, 긍정적인 문장의 부정을 구조적으로 학습할 수 있는 능력을 보여준다.

두 번째: Negating Negative Sentences.

'부정'적인 문장에 '부정'이 포함된 경우이다.

부정적인 문장이 부정이 될 때, Sentiment Treebank는 전반적인 감정이 부정이 되는 것은 옳지만 반드시 긍정적은 아니라는 것을 보여준다.

예를 들자면 '이 영화는 끔찍해'라는 문장에서 '이 영화는 끔찍하지 않았다'라는 문장으로 변화가 될 경우에 문장을 해석해 보면 전반적으로 부정적이라는 뜻이지 끔찍하지 않았다 라는 뜻은 아니다.

부정 + 부정 = 긍정으로 해석될 여지가 있기 때문에

위 표의 오른쪽을 보면 RNTN이 정확하게 분류한다는 것을 보여준다.

Negative values는 positive activation를 감소시키며, positive value는 평균적인 positive activation를 증가시킨다.

따라서 RNTN이 긍정적인 감정 문장과 부정적인 감정 문장 모두에 대한 부정의 영향을 가장 잘 식별할 수 있다고 결론을 내릴 수 있다.

5-5. Model Analysis: Most Positive and Negative Phrases

우리는 가장 부정적인 클래스와 가장 긍정적인 클래스 중 가장 높은 활성화로 측정된 가장 긍정적인 n-gram이 무엇인지에 대한 예측 문장을 추출했다.

RNTN이 다른 모델에 비해 대부분의 n-gram 길이에서 더 긍정적인 문구를 선택한다는 것을 보여준다.

6. Conclusion

본 논문에서는 RNTN과 Stanford Sentiment Treebank를 소개하였고, 모델과 데이터의 조합으로 단일 문장 감정 감지에 있어서 긍부정 문장 분류를 5.4% 증가시킬 수 있었다.