모두를 위한 딥러닝 강좌 시즌 1

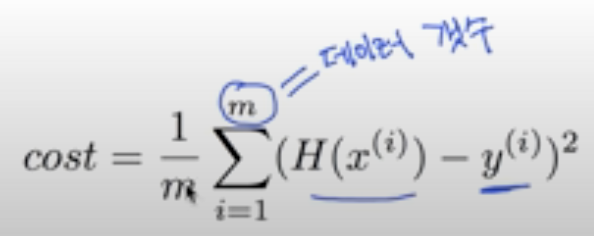

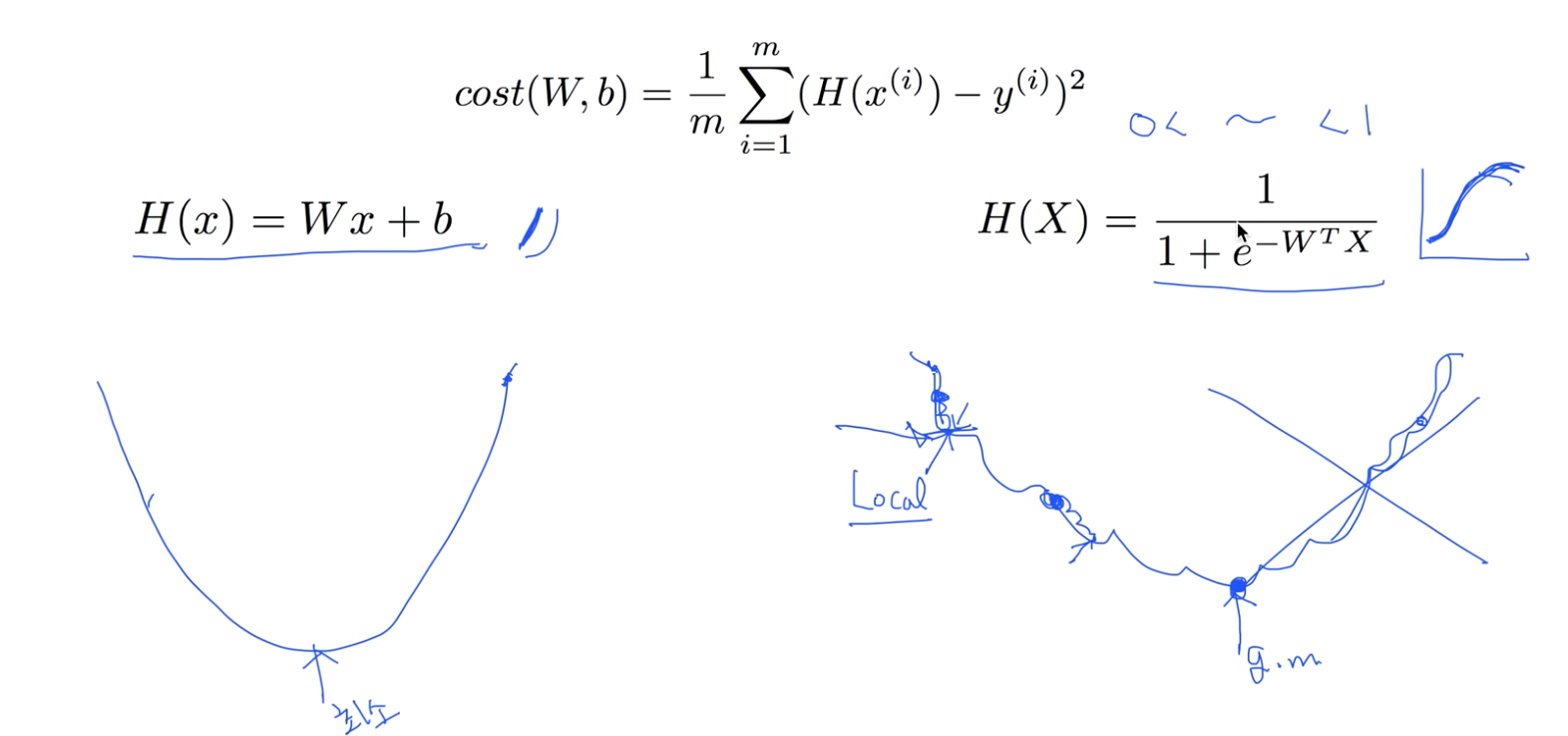

1.ML lec(이론) 2 - 선형회귀의 Hypothesis와 cost

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sug Kim

2020년 12월 1일

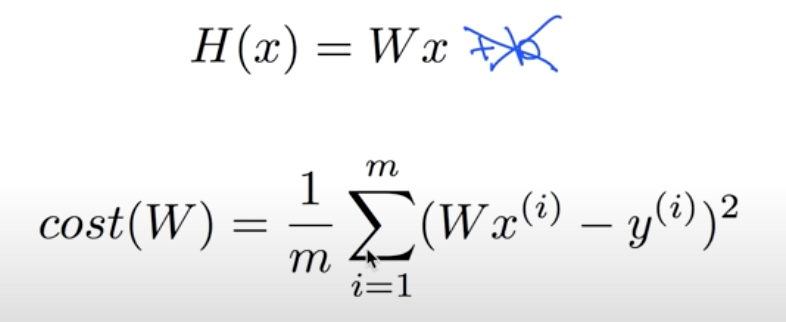

2.ML lec(이론) 3 - Linear Regression의 cost 최소화 알고리즘 원리

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 3일

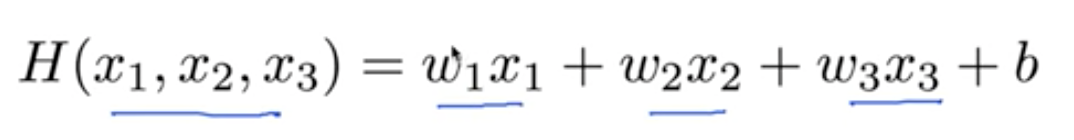

3.ML lec(이론) 4 - Multi-variable Linear Regression

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 4일

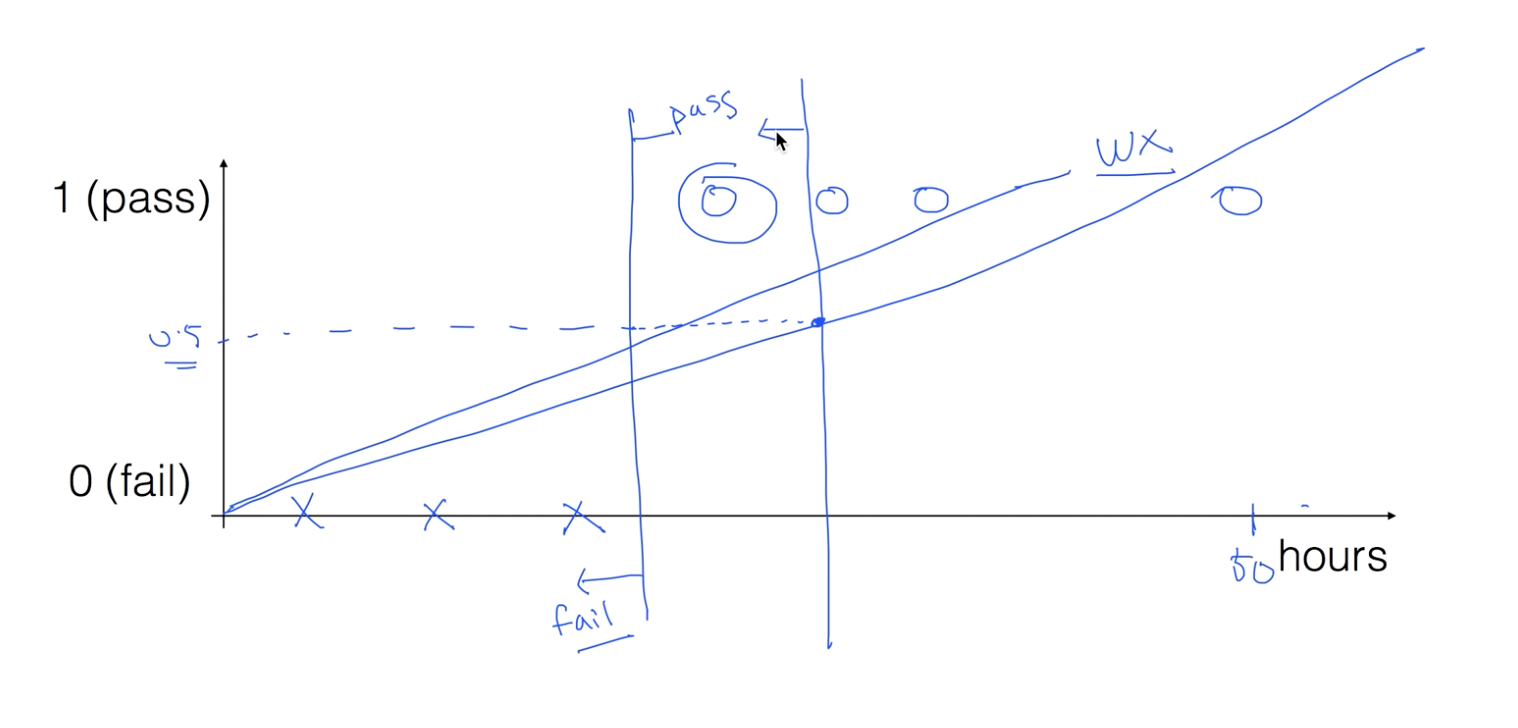

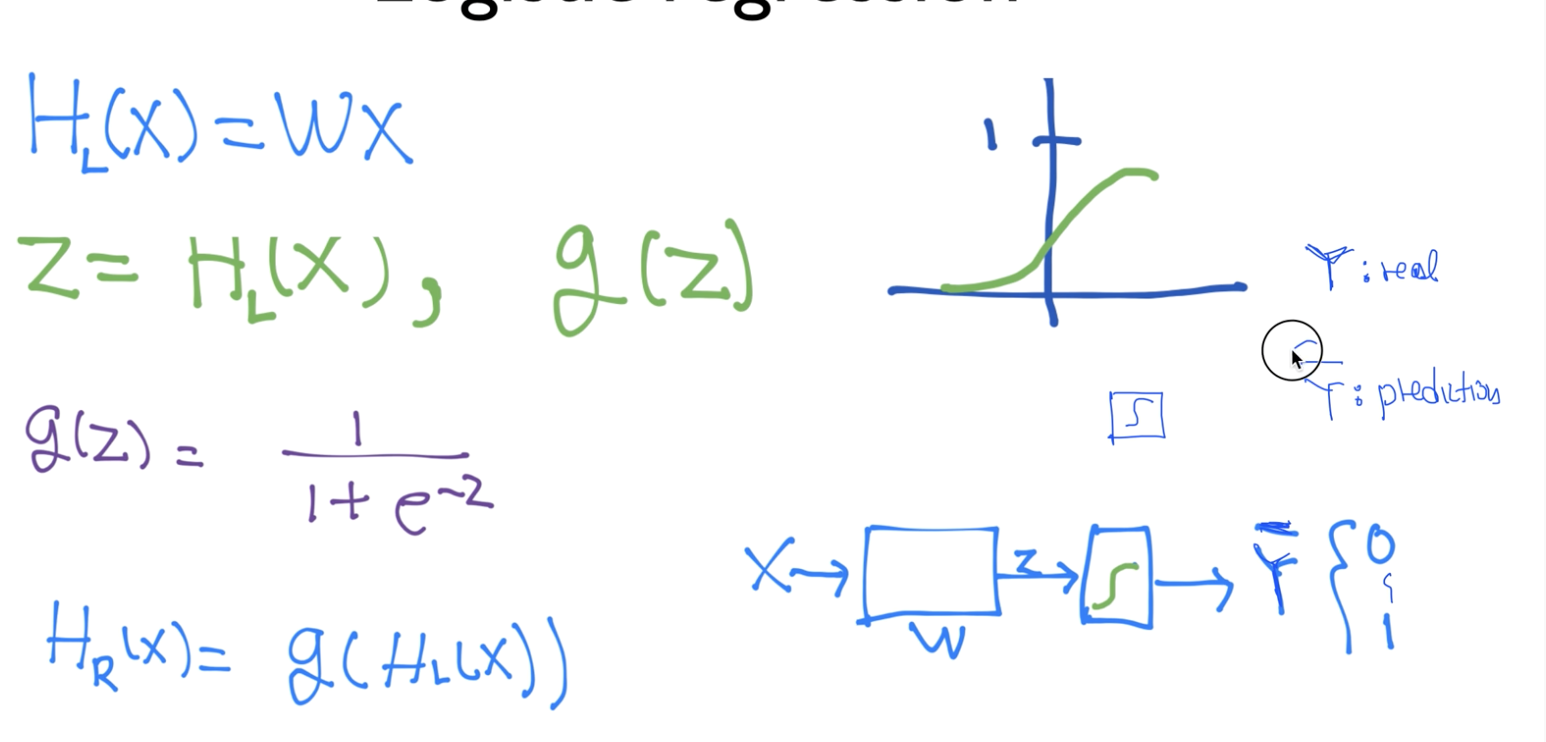

4.ML lec(이론) 5-1 Logistic Classification 가설 함수

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 5일

5.ML lec(이론) 5-2 Logistic Regression의 Cost Function & Gradient Descent

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 5일

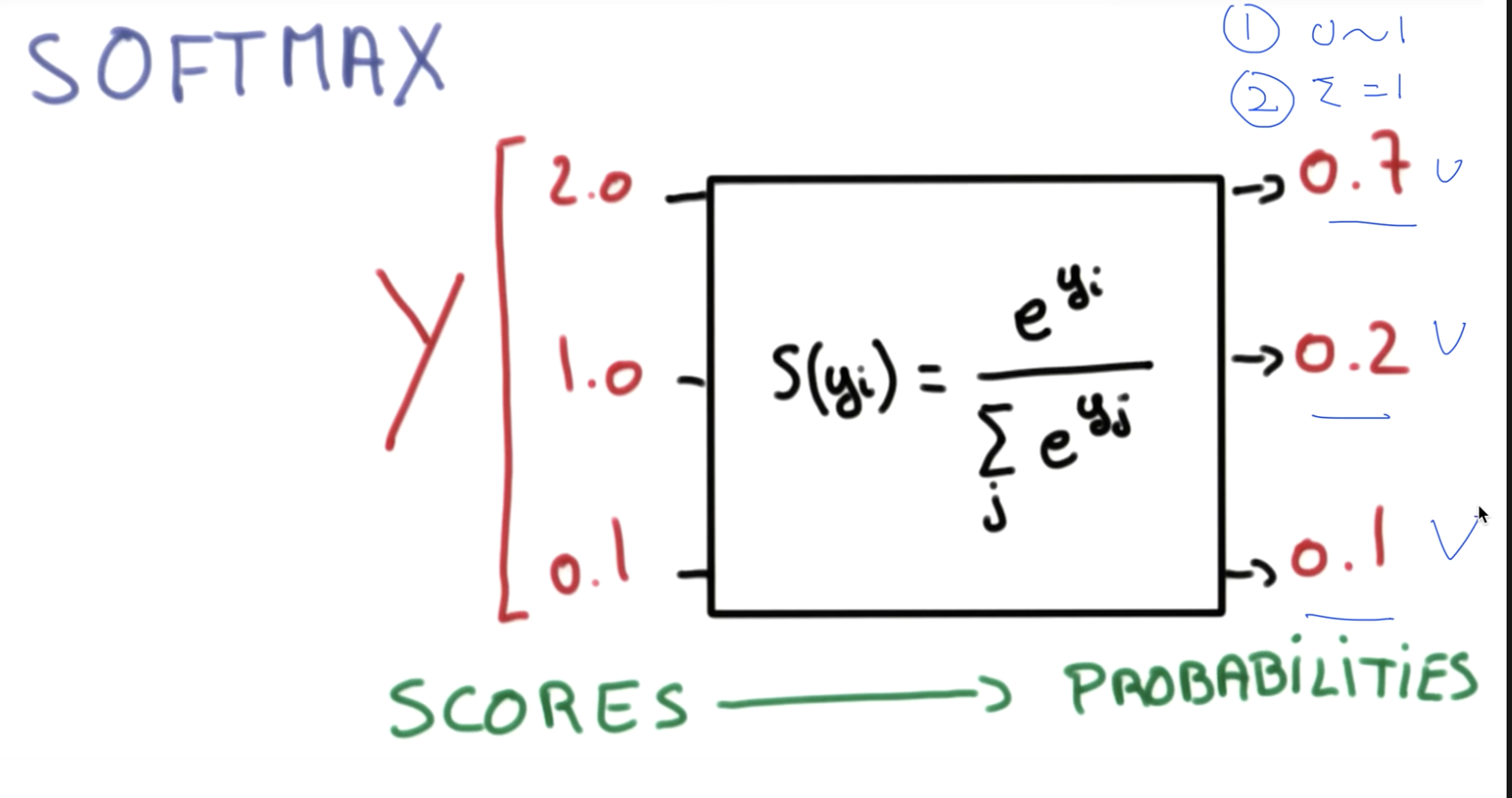

6.ML lec(이론) 6-1 - Softmax Regression 기본 개념

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 6일

7.ML lec(이론) 6-2 - Softmax Classifier의 Cost Function

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 6일

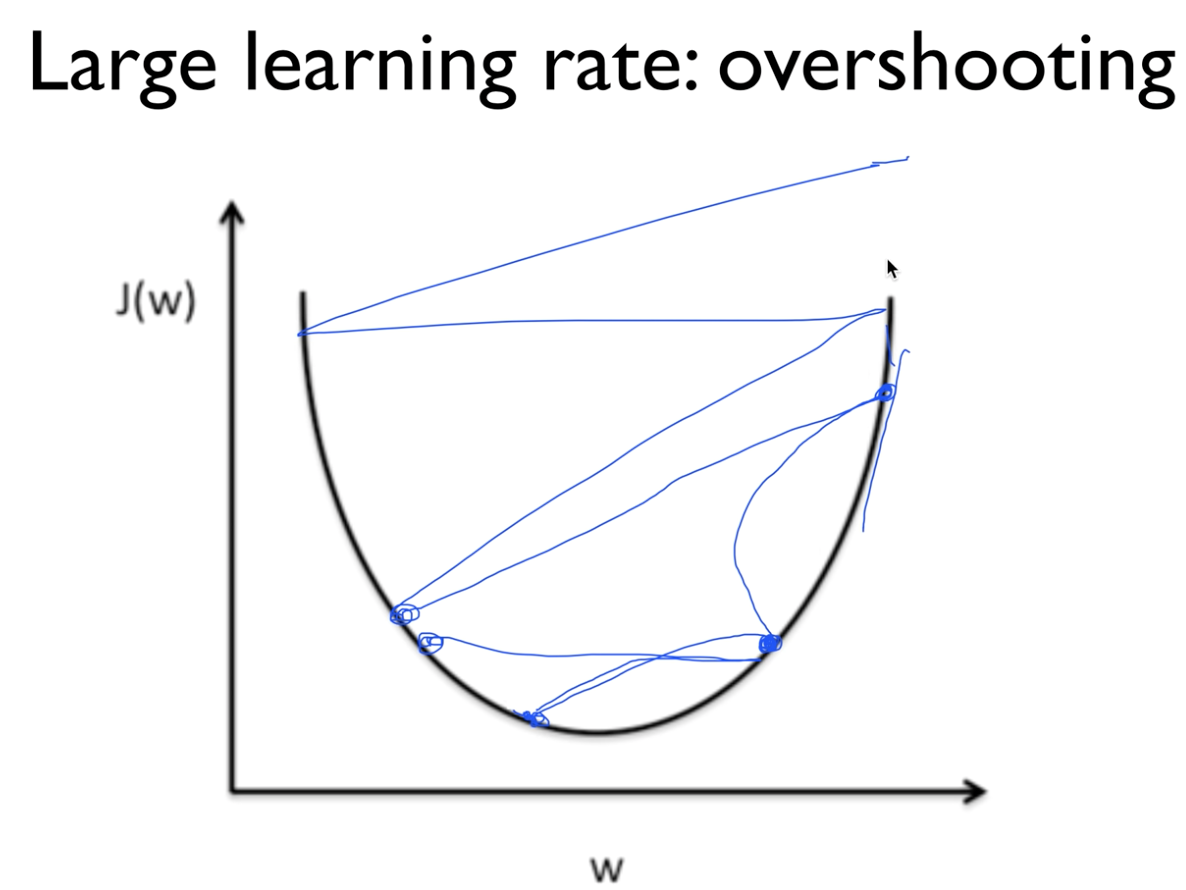

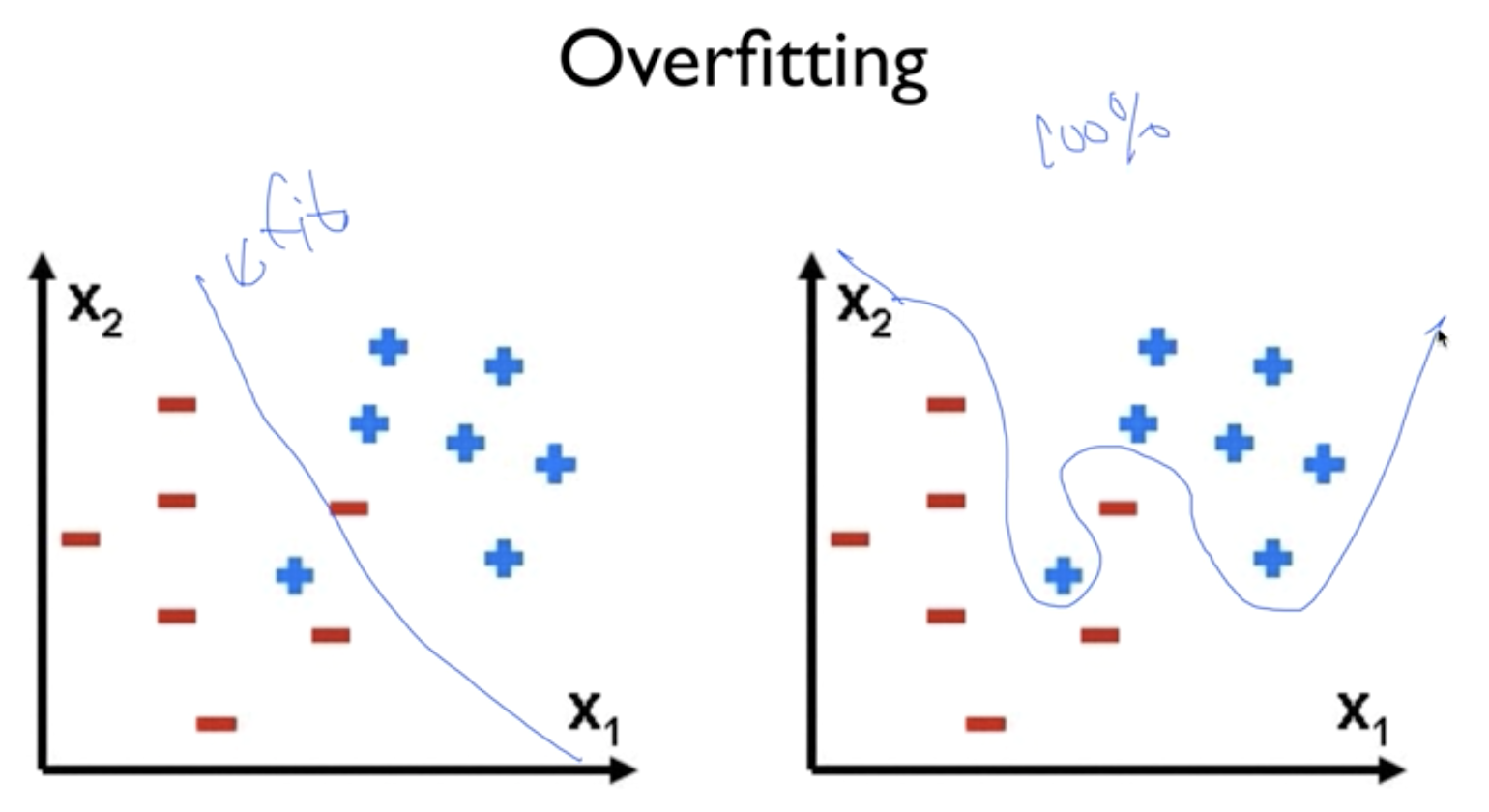

8.ML lec(이론) 7-1 - Learning Rate, Overfitting, 그리고 일반화(Regularization)

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

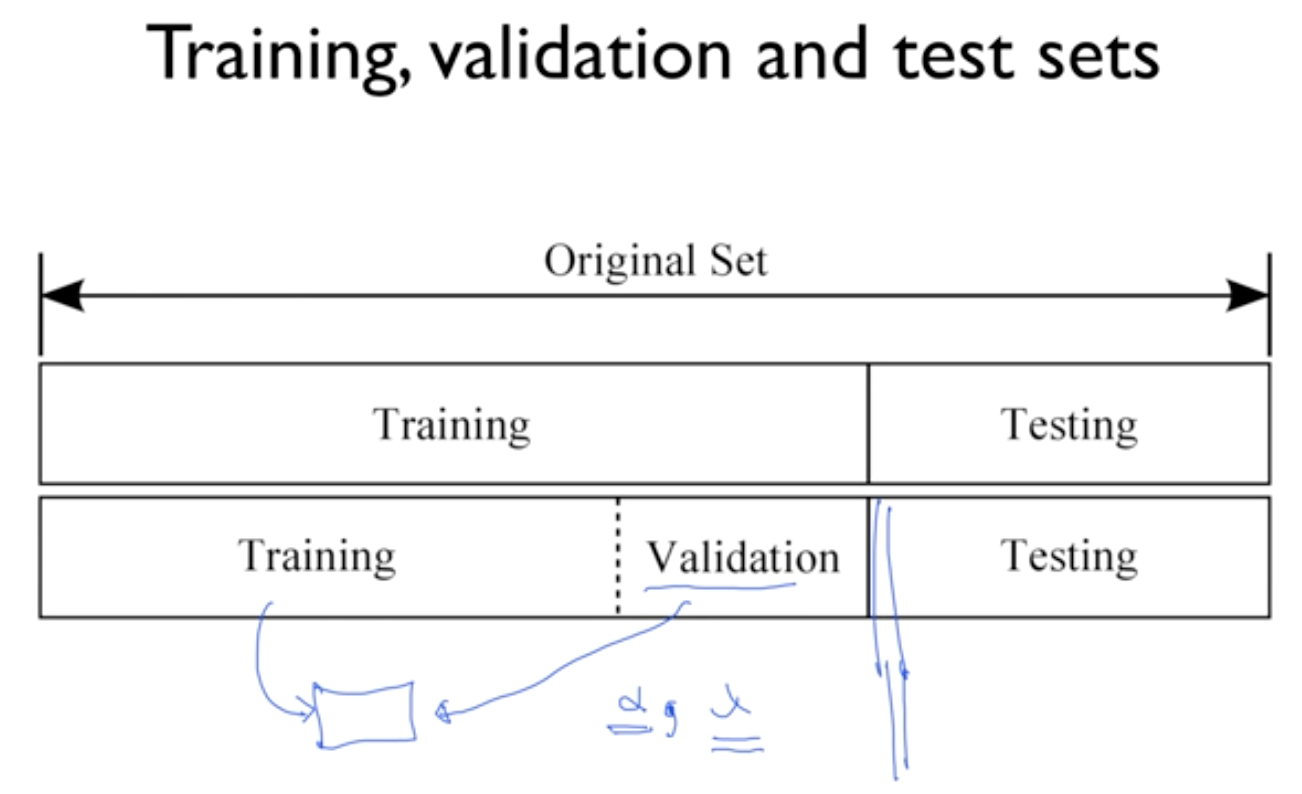

9.ML lec(이론) 7-2 - Training/Testing Datasets

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

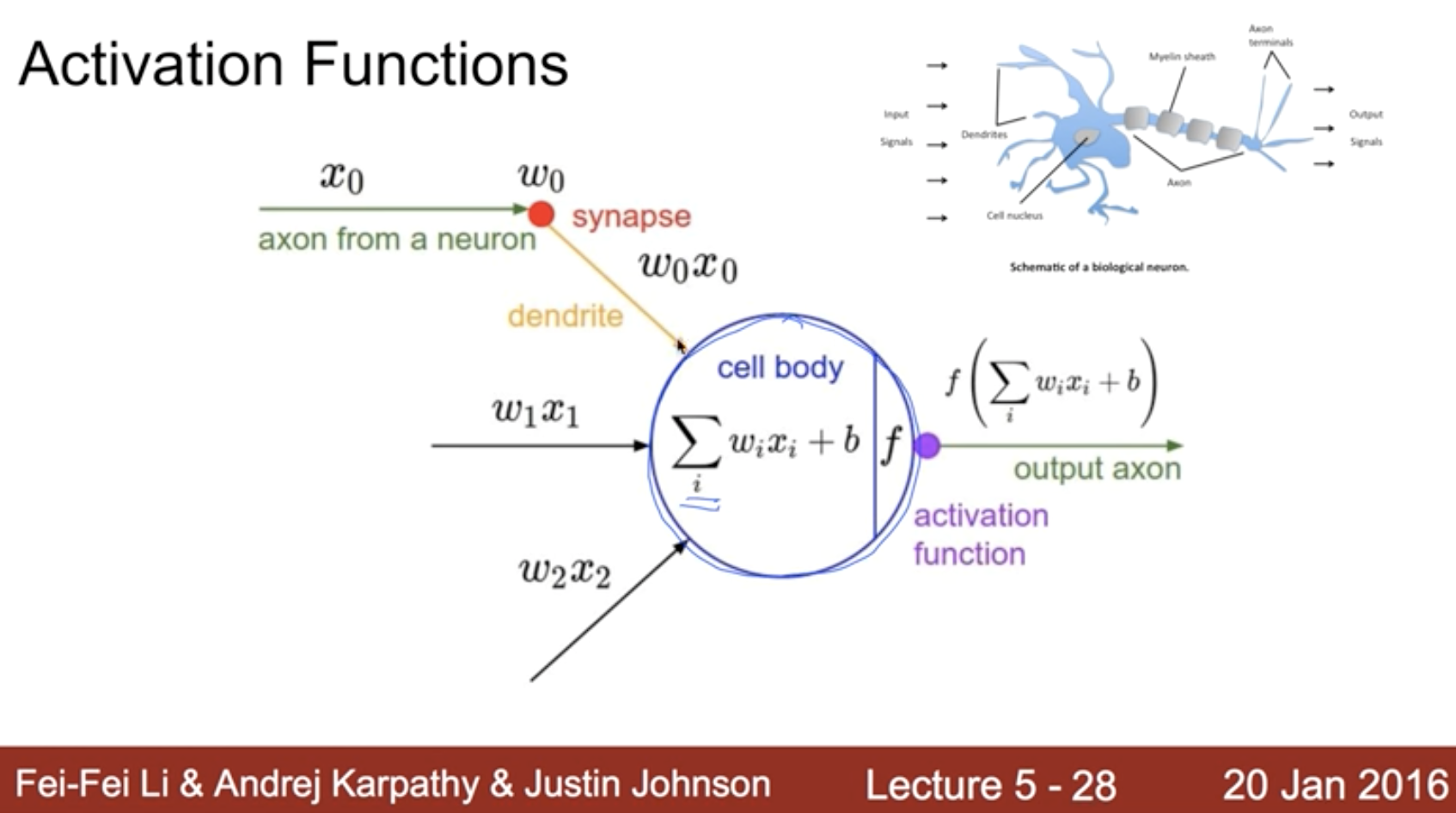

10.ML lec(이론) 8-1 - 딥러닝의 기본 개념: 시작과 XOR 문제

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

11.ML lec(이론) 8-2 - Back Propagation과 2006/2007 '딥'의 출현

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

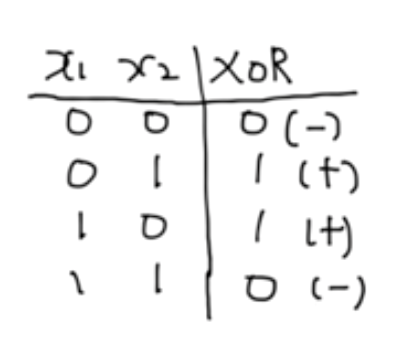

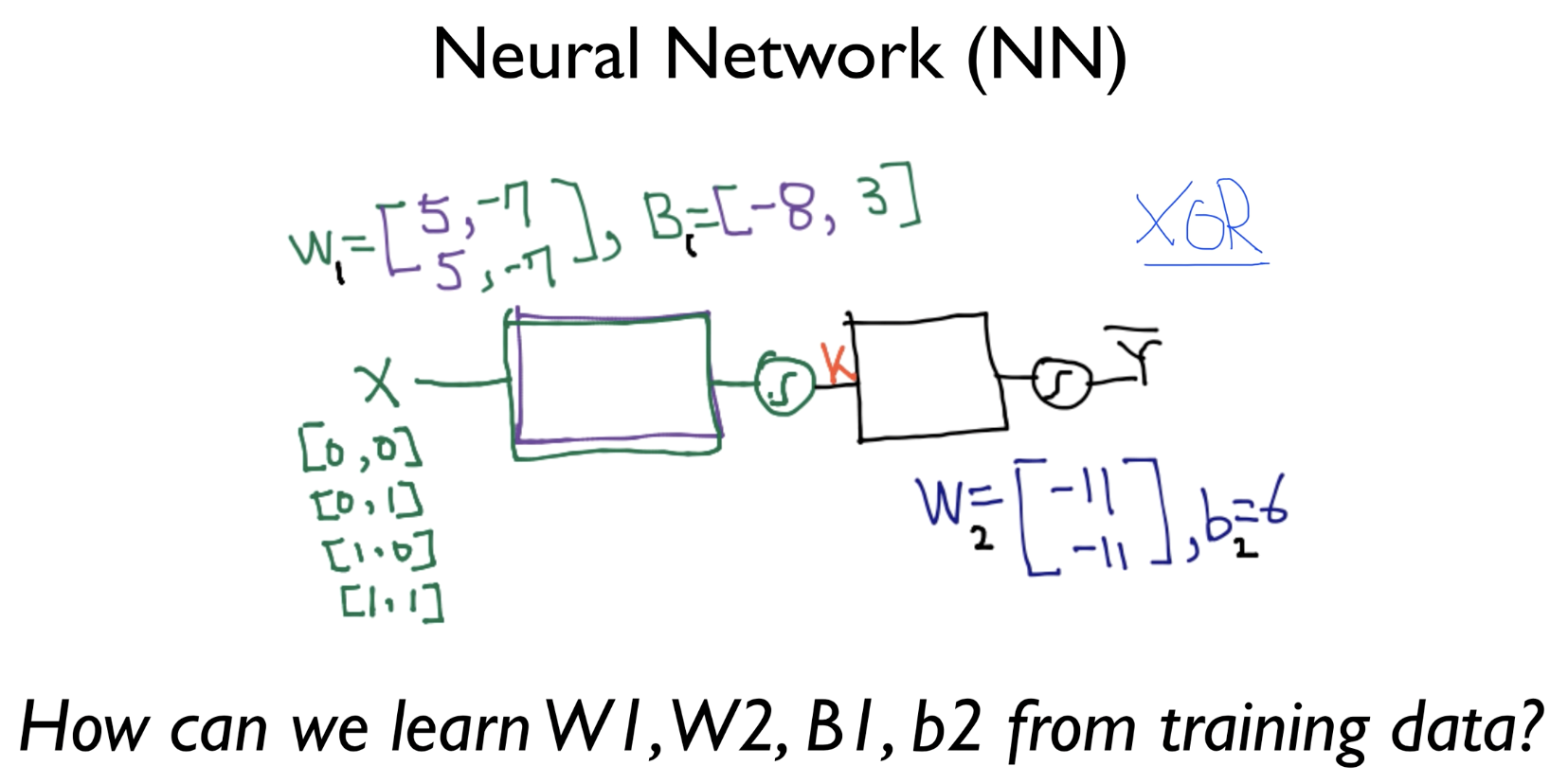

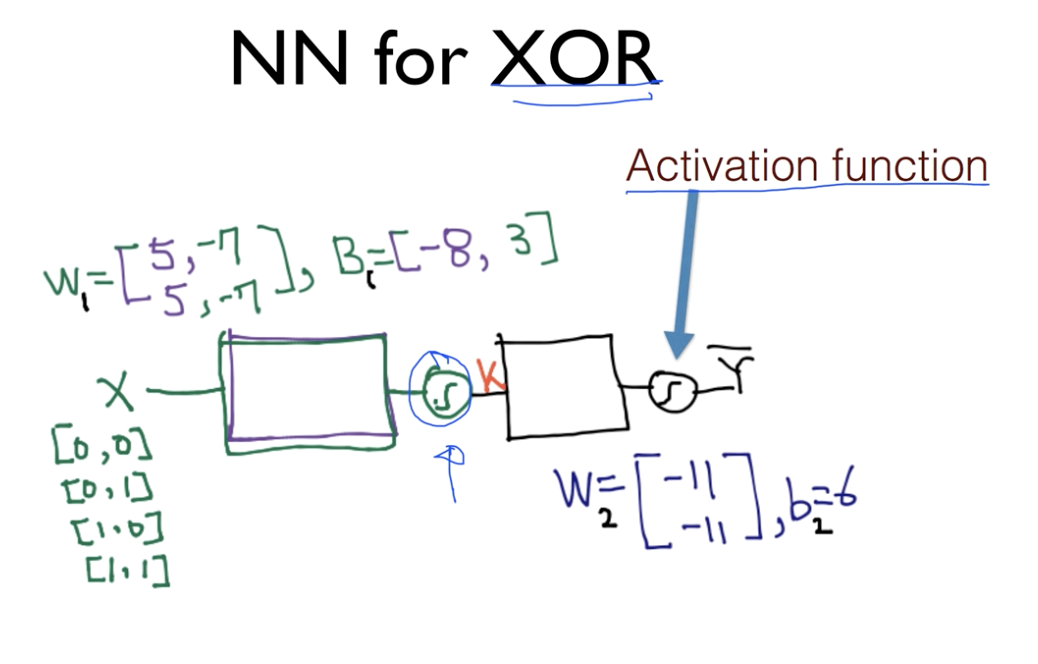

12.ML lec(이론) 9-1 - Neural Nets(NN) for XOR

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

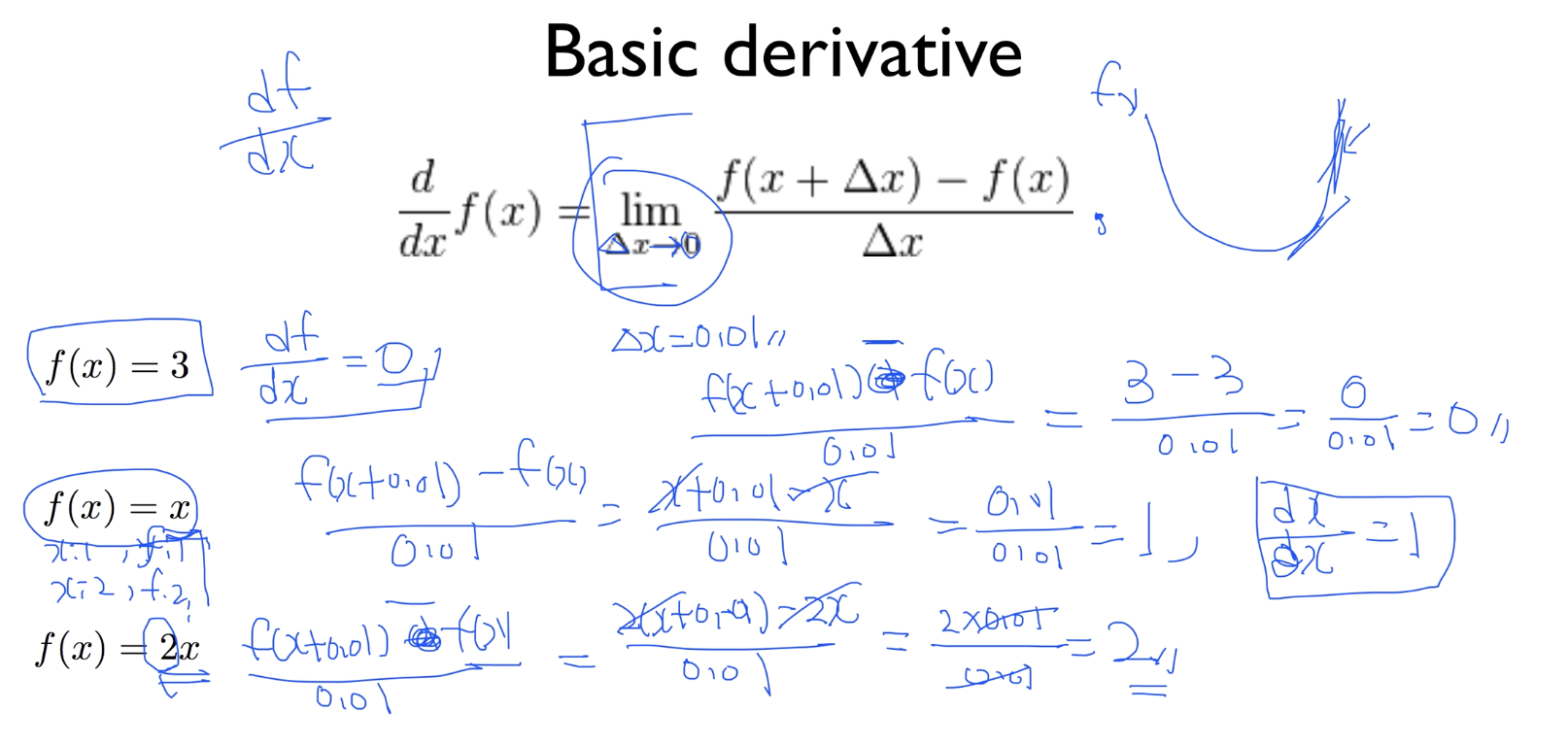

13.ML lec(이론) 9-x - 10분 안에 미분 정리하기

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

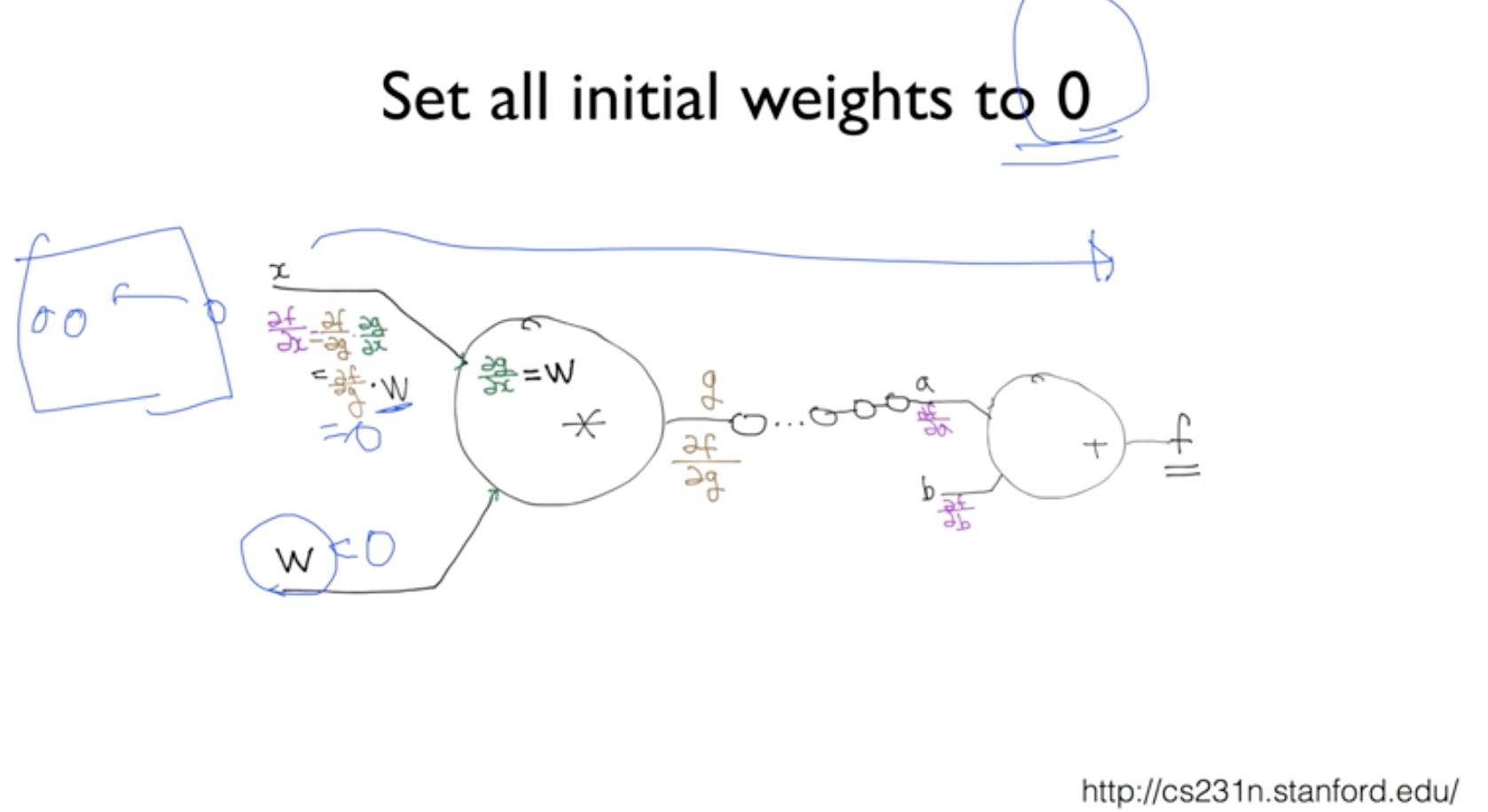

14.ML lec(이론) 9-2 - 딥 네트워크 학습 시키기(back propagation)

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 7일

15.ML lec(이론) 10-1 - Sigmoid 보다 ReLU 가 더 좋아

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 10일

16.ML lec(이론) 10-2 - Weight 초기화 잘 해보자

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 15일

17.ML lec(이론) 10-3 - NN dropout and model ensemble

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 16일

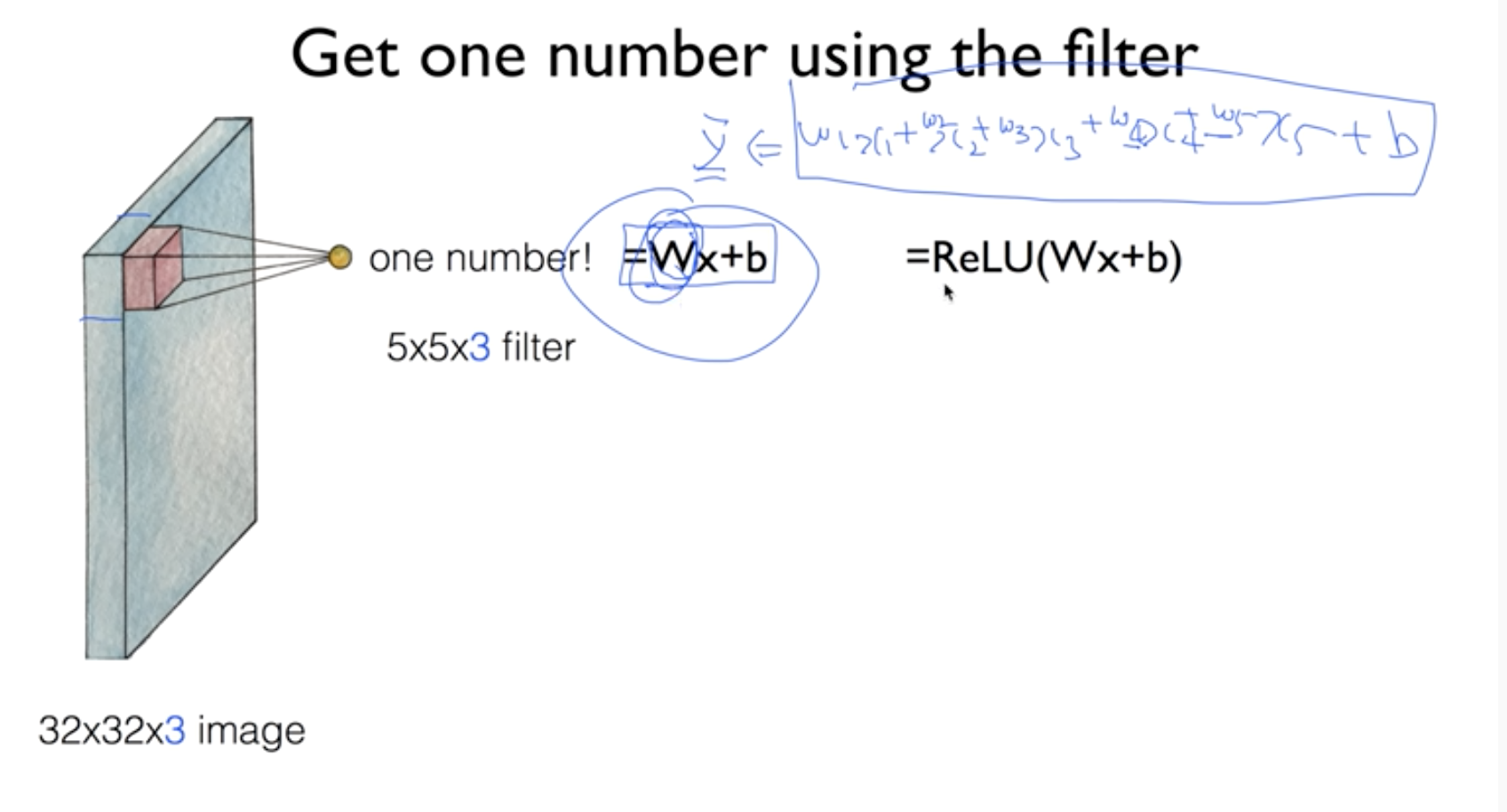

18.ML lec(이론) 11-1 - CNN introduction

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 16일

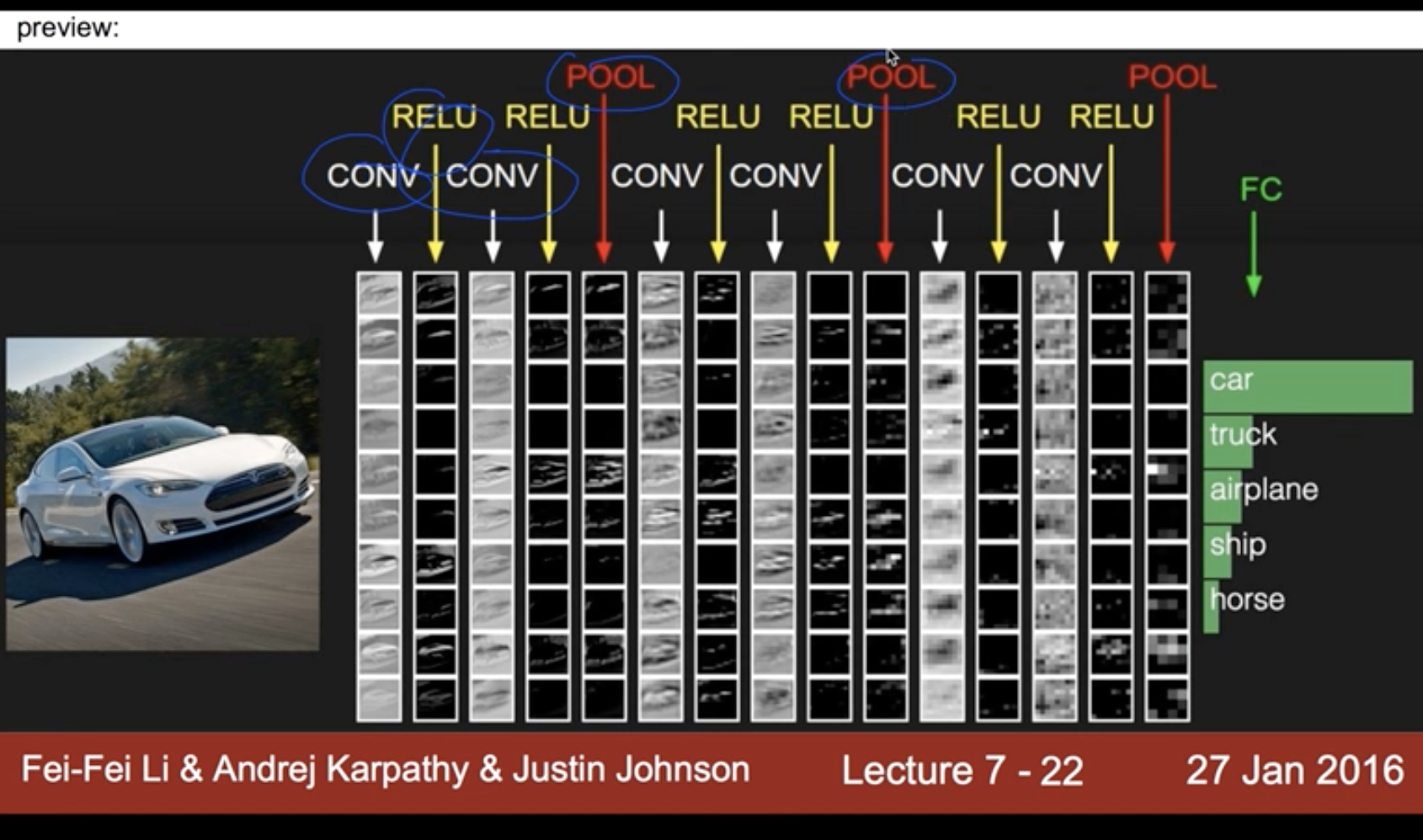

19.ML lec 11-2 - ConvNet Max pooling과 Full Network

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 16일

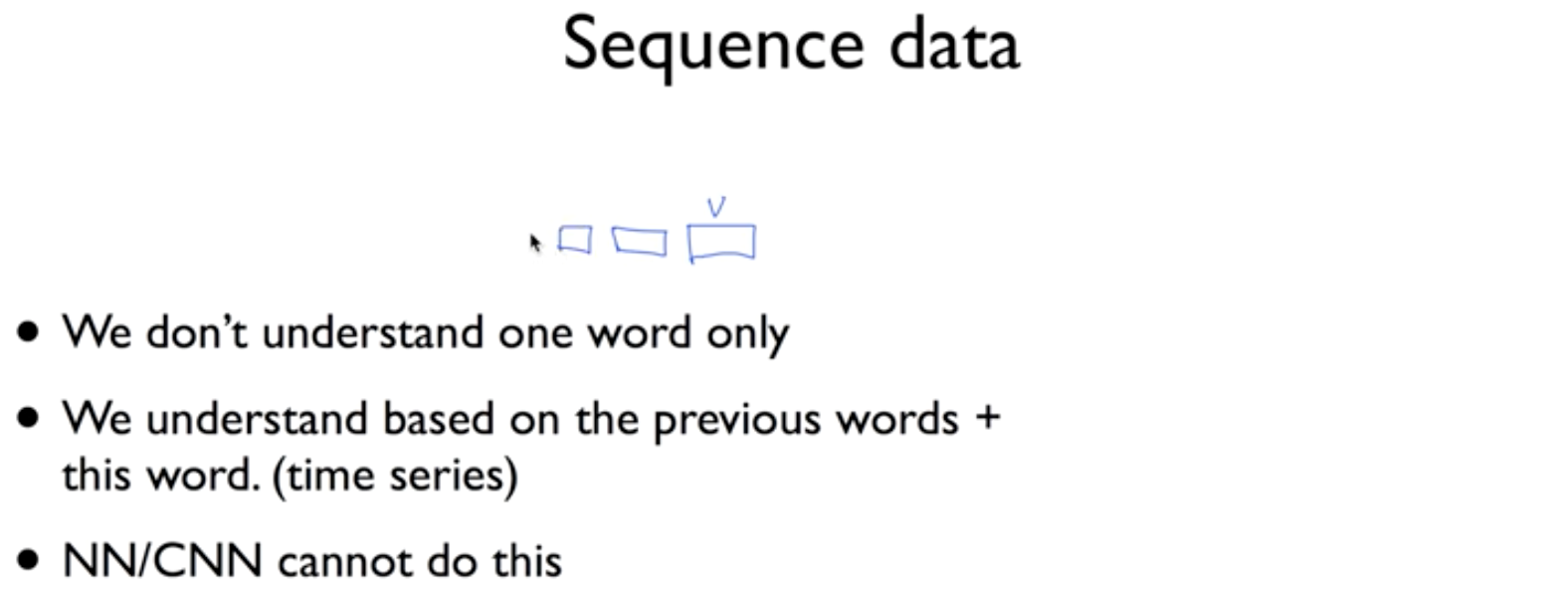

20.ML lec(이론) 12 - NN의 꽃 RNN 이야기

출처: 모두를 위한 딥러닝 강좌 시즌 1 by Sung Kim

2020년 12월 16일