1. 딥러닝 개념 정리

1) 레이어

- 여러 개의 논리적인 객체가 하나의 물체를 구성할 때, 각각의 객체를 가리켜 하나의 레이어라고 칭함.

- 신경망 weight == 레이어 weight

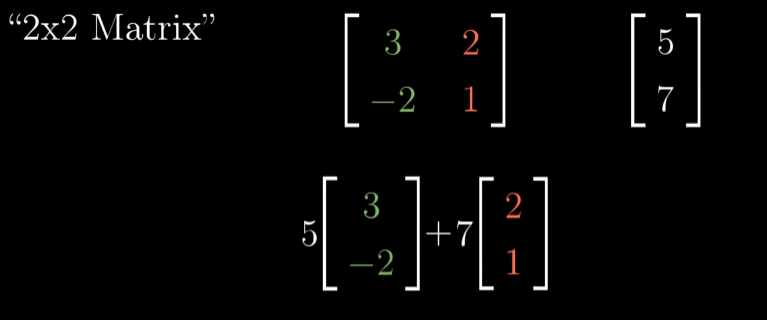

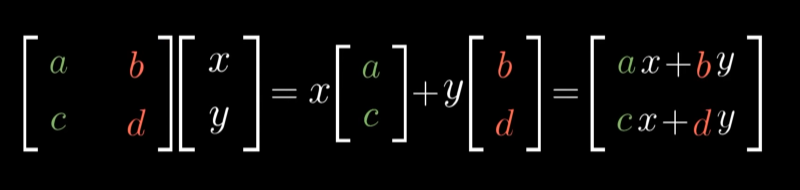

2) Linear transformation

Linear transformations and matrices | Chapter 3, Essence of linear algebra

- 공간을 이동시키는 방법

- 벡터를 입력해 다른 형태의 벡터로 변형하는 것 (입력벡터 ⇒ 출력벡터)

- 2차원 좌표평면 상에서 한 점이 다른 한 점의 위치로 이동하는 것이라고 생각해도 됨

linear transformation의 조건

1. lines remain lines (including diagonal lines)

- grid lines remain paralled and evenly spaced

- origin remains fixed

-

기저벡터가 어떻게 변하는지에 주목: 변환 후에도 같은 선형결합을 유지함

= i-hat, j-hat의 변형 위치를 알면 벡터 v를 추론할 수 있다. -

기본 원리

-

Shear: i-hat은 고정됨

-

n차원에서 k차원으로 변환: (n,k) 행렬 필요

-

지나치게 많은 parameter는 과적합을 야기함

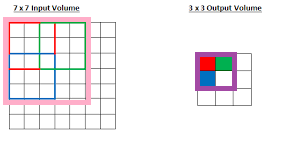

2) Convolution layer

- stride: 이미지를 필터로 훑을 때 이동할 칸의 수

- padding: 계산 시 가운데 데이터에 편중되는 것을 막기 위해 가장자리에 숫자를 넣어주는 것. same padding을 주로 사용함

- convolution layer

- 목적에 맞는 정보를 선별할 수 있도록 해줌

- 입력된 정보를 집약시키는 효과가 뛰어남

- linear에 비해 적은 parameter를 이용해 중요한 이미지 특성을 뽑을 수 있음.

3) Max pooling

receptive field

- output volume에서 2*2 max pooling을 사용할 경우 output volume의 보라색 테두리로 둘러싸인 부분을 이용해 계산함.

- 보라색 테두리로 둘러싸인 부분은 input volume에서의 분홍색 테두리에 해당함.

- 따라서 output layer에서의 receptive field의 크기는 5*5에 해당한다.

- 이는 33 필터로 convolution 했을 시 receptive field의 크기가 33에 해당하는 것보다 커진 결과를 도출한다!

- max pooling의 장점

- translational invariance의 효과

- 시프트 효과가 적용되어도 동일한 특징을 안정적으로 추출 가능

- object 위치에 대한 overfitting 방지

- non-linear 함수와 동일한 feature 추출 효과

- relu와 동일하게, 수많은 하위 레이어의 연산 결과를 무시해 중요한 feature만을 상위 레이어로 추출하여 분류기의 성능을 증진시킴

- translational invariance의 효과

딥러닝에서 사용되는 다양한 Convolution 기법들

딥러닝(하용호)

2. 회고

여러 번 사용해본 합성곱 신경망에 대해 다시 정리해본 시간을 가졌다. 혼공머에서도 같은 내용을 다뤄서 더 자세하게 정리할 수 있었다. 특히 이미지의 특성을 추출하는 원리를 알 수 있어 좋았다.