[Paper Review] Plant growth information measurement based on object detection and image fusion using a smart farm robot

Paper Review

Abstract

그동안 작물의 관리 및 수확은 농부의 경험적인 감각에 의존해 왔다. 이를 정량화하기 위해 스마트팜 로봇이 연구되었지만 주변 배경과의 유사성으로 인해 큰 성과를 거두지 못했다. 본 논문은 object detection, image fusion, data augmentation등의 기법을 활용하여 좋은 성능을 지니는 end to end, real time model을 제안한다.

Introduction

Growth 정보는 식물의 생장을 측정하는 것에서 중요하다. numerical indicator로서 cell divion등을 알 수 있는 중요한 요소이다.

기존의 방식들은 인간의 노동력에 의지하고 있다.

Ultrasonic sensor를 사용한 시도가 있었지만 texture에 영향을 받는다.

- 파형을 흡수하지 않고

- 계산량이 많이 필요하다

다른 연구는 regrssion analysis에 초점을 맞추었기에 numericla data를 수동으로 얻어야 한다.

본 논문은 ROI에 집중하고 YOLOR을 통해 real time을 가능하게 했다. data augmentation과 fusion, blurred, 배경 제거 등의 여러 방법을 활용하였다. 이는 RGB image만 사용하거나 point cloud base 방법들보다 효과적이다.

Materials and method

장비

- intel realsense camera(L515)로 depth와 rgb image를 구한다

- 로봇이 자동으로 이미지를 촬영

(본 포스트에서 세부 로봇 이동 방식에 대해서는 생략)

Object detection in High plant density environments

Image Fusion

fusion에는 early, middle, late 3가지 방법이 있는데 본 논문에는 middle 방식이 쓰였다.

detection을 위한 backbone으로 YOLOR이 사용 되었는데 RGB image로 학습되었기에 depth 정보를 바로 활요할 수는 없었다. 이러한 이유로 middle fusion을 화룡ㅇ하는데 불필요한 배경을 날리는 과정이 된다.

- 첫째, 일정 threshold를 넘는 값은 rgb 값을 0으로 만든다.(black)

- 둘째, 가 0이면 avg filter를 활용해 blurring을 한다. 결국 전경은 본 이미지로 배경은 blurred 값을 사용한다.

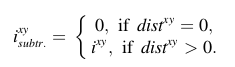

수식은 아래와 같다.

data augmentation

RGB, Blur-21, Subtr 데이터셋을 활용했다.

input size의 경우 320x320이다.

햇빛 등 여러 요인에 영향을 많이 받기 때문에 최대한 많은 데이터를 반영하고자 노력하였다..

Real time object detection

Measurement of tomato growth information

측정 기준

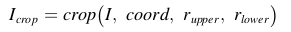

- stem diameter

- distance between a branch point and growth point

pixel counting 기법을 활용해 계산을 진행한다.

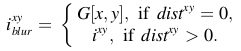

Cropping the depth image based on detection results

위와 같이 ROI를 중심으로 Crop을 진행한다.

Operating morphological transformation

pixel based이기 때문에 검은 점 등이 나타나면 안 된다. 이를 해결하기 위해 dilation과 erosion을 사용한다.(opencv 참고)

maximum value가 uint8보다 크므로 에서 뺀 invert 값을 활용한다.

Binarizing depth image based on depth information

는 roi depth 값의 중간값을 사용하고 buffer 안에 들어오면 255 아니면 0으로 처리하여 이진화를 진행한다.

Measuring stem diameter of the target plant

Higher accuracy with reconstruction by mean and standard deviation of RGB values

더 높은 성능을 위해 pixel의 mean value와 deviation을 연산한다. deviaiton을 벗어나면 0으로 처리한다.

Measuring distance from branch point to top plant height

피타고라스의 원리를 활용해 depth를 이용해 계산한다.

Application to other crop

오이 역시 좋은 성능을 보임. 대신 생장점까지를 branch point에서 branch point로 바꾸어 계산한다.

Experiments and results

YOLO mark를 활용해 annotation을 진행함

한계

- poor depth image(빛 번짐 등)에서는 본 논문에서 제안된 depth 보정 방법으로도 효과적이 않음